Robots txt dist что это

«Вкалывают роботы»: что такое robots.txt и как его настроить

Знание о том, что такое robots.txt, и умение с ним работать больше относится к профессии вебмастера. Однако SEO-специалист — это универсальный мастер, который должен обладать знаниями из разных профессий в сфере IT. Поэтому сегодня разбираемся в предназначении и настройке файла robots.txt.

По факту robots.txt — это текстовый файл, который управляет доступом к содержимому сайтов. Редактировать его можно на своем компьютере в программе Notepad++ или непосредственно на хостинге.

Что такое robots.txt

Представим robots.txt в виде настоящего робота. Когда в гости к вашему сайту приходят поисковые роботы, они общаются именно с robots.txt. Он их встречает и рассказывает, куда можно заходить, а куда нельзя. Если вы дадите команду, чтобы он никого не пускал, так и произойдет, т.е. сайт не будет допущен к индексации.

Если на сайте нет этого файла, создаем его и загружаем на сервер. Его несложно найти, ведь его место в корне сайта. Допишите к адресу сайта /robots.txt и вы увидите его.

Зачем нам нужен этот файл

Если на сайте нет robots.txt, то роботы из поисковых систем блуждают по сайту как им вздумается. Роботы могут залезть в корзину с мусором, после чего у них создастся впечатление, что на вашем сайте очень грязно. robots.txt скрывает от индексации:

Правильно заполненный файл robots.txt создает иллюзию, что на сайте всегда чисто и убрано.

Настройка директивов robots.txt

Директивы — это правила для роботов. И эти правила пишем мы.

User-agent

Пример:

Данное правило смогут понять только те роботы, которые работают в Яндексе. В последнее время эту строчку я заполняю так:

Правило понимает Яндекс и Гугл. Доля трафика с других поисковиков очень мала, и продвигаться в них не стоит затраченных усилий.

Disallow и Allow

С помощью Disallow мы скрываем каталоги от индексации, а, прописывая правило с директивой Allow, даем разрешение на индексацию.

Пример:

Даем рекомендацию, чтобы индексировались категории.

А вот так от индексации будет закрыт весь сайт.

Также существуют операторы, которые помогают уточнить наши правила.

Sitemap

Пример:

Директива host уже устарела, поэтому о ней говорить не будем.

Crawl-delay

Если сайт небольшой, то директиву Crawl-delay заполнять нет необходимости. Эта директива нужна, чтобы задать периодичность скачивания документов с сайта.

Пример:

Это правило означает, что документы с сайта будут скачиваться с интервалом в 10 секунд.

Clean-param

Директива Clean-param закрывает от индексации дубли страниц с разными адресами. Например, если вы продвигаетесь через контекстную рекламу, на сайте будут появляться страницы с utm-метками. Чтобы подобные страницы не плодили дубли, мы можем закрыть их с помощью данной директивы.

Пример:

Как закрыть сайт от индексации

Чтобы полностью закрыть сайт от индексации, достаточно прописать в файле следующее:

Если требуется закрыть от поисковиков поддомен, то нужно помнить, что каждому поддомену требуется свой robots.txt. Добавляем файл, если он отсутствует, и прописываем магические символы.

Проверка файла robots

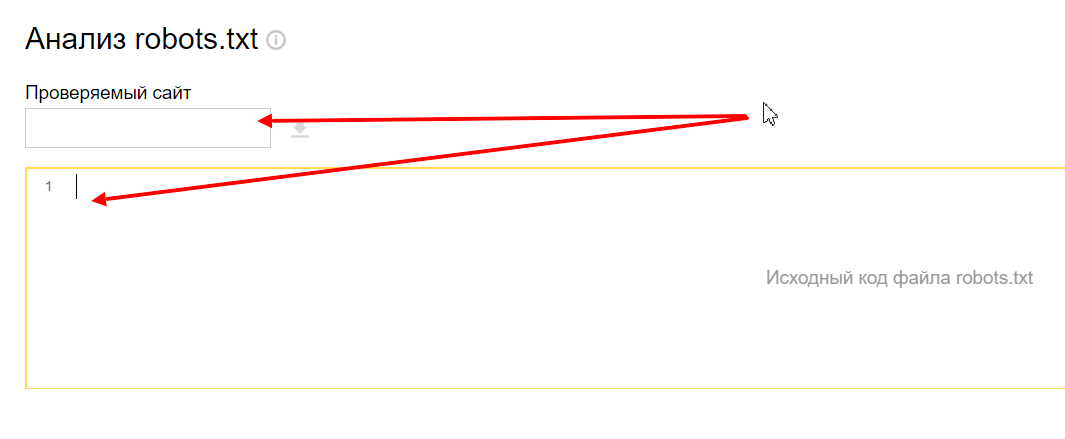

Переходим в инструмент, вводим домен и содержимое вашего файла.

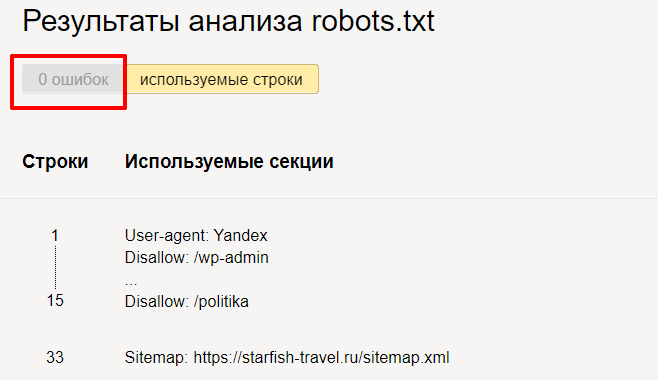

Нажимаем « Проверить » и получаем результаты анализа. Здесь мы можем увидеть, есть ли ошибки в нашем robots.txt.

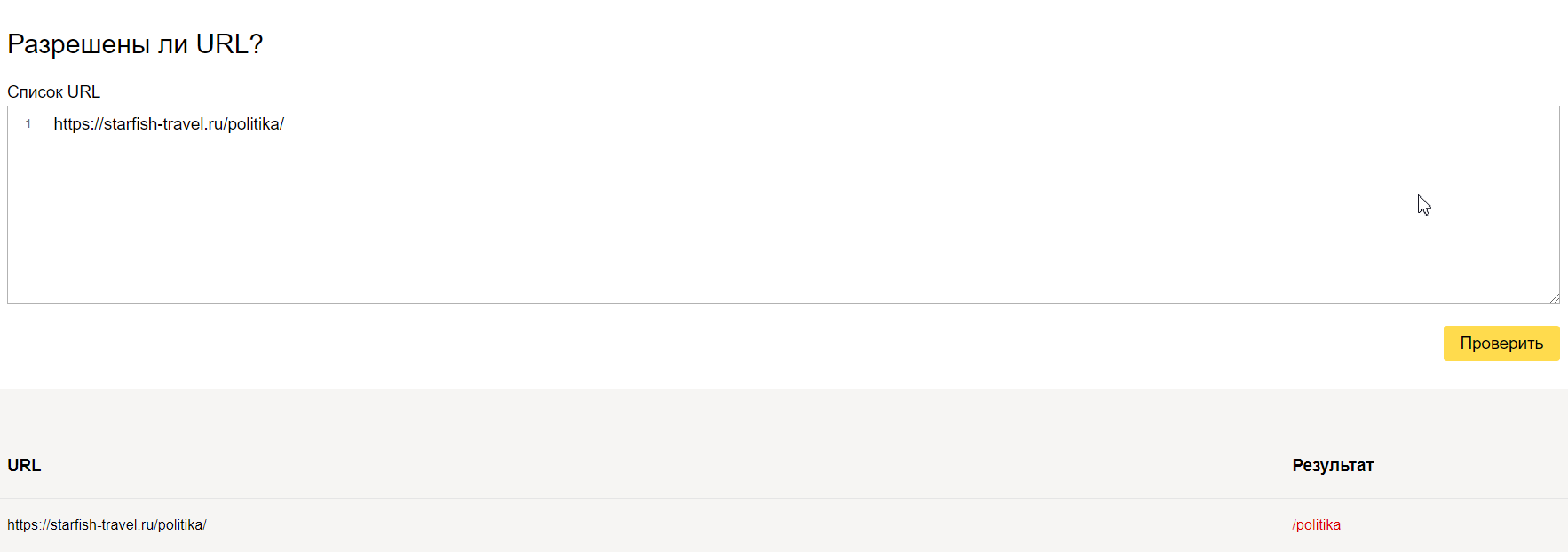

Но на этом функции инструмента не заканчиваются. Вы можете проверить, разрешены ли определенные страницы сайта для индексации или нет.

Здесь вас ждет простор для творчества. Пользуйтесь звездочкой или знаком доллара и закрывайте от индексации страницы, которые не несут пользы для посетителей. Будьте внимательны – проверяйте, не закрыли ли вы от индексации важные страницы.

Правильный robots.txt для WordPress

Кстати, если вы поставите #, то сможете оставлять комментарии, которые не будут учитываться роботами.

Правильный robots.txt для Joomla

Здесь указаны другие названия директорий, но суть одна: закрыть мусорные и служебные страницы, чтобы показать поисковиками только то, что они хотят увидеть.

Что такое robots.txt [Основы для новичков]

Подробно о правилах составления файла в полном руководстве «Как составить robots.txt самостоятельно».

А в этом материале основы для начинающих, которые хотят быть в курсе профессиональных терминов.

Что такое robots.txt

Поисковый робот, придя к вам на сайт, первым делом пытается отыскать robots.txt. Если робот не нашел файл или он составлен неправильно, бот будет изучать сайт по своему собственному усмотрению. Далеко не факт, что он начнет с тех страниц, которые нужно вводить в поиск в первую очередь (новые статьи, обзоры, фотоотчеты и так далее). Индексация нового сайта может затянуться. Поэтому веб-мастеру нужно вовремя позаботиться о создании правильного файла robots.txt.

На некоторых конструкторах сайтов файл формируется сам. Например, Wix автоматически создает robots.txt. Чтобы посмотреть файл, добавьте к домену «/robots.txt». Если вы увидите там странные элементы типа «noflashhtml» и «backhtml», не пугайтесь: они относятся к структуре сайтов на платформе и не влияют на отношение поисковых систем.

Зачем нужен robots.txt

Казалось бы, зачем запрещать индексировать какое-то содержимое сайта? Далеко не весь контент, из которого состоит сайт, нужен поисковым роботам. Есть системные файлы, есть дубликаты страниц, есть рубрики ключевых слов и много чего еще есть, что вовсе не обязательно индексировать. Есть одно но:

Содержимое файла robots.txt — это рекомендации для ботов, а не жесткие правила. Рекомендации боты могут проигнорировать.

Google предупреждает, что через robots.txt нельзя заблокировать страницы для показа в Google. Даже если вы закроете доступ к странице в robots.txt, если на какой-то другой странице будет ссылка на эту, она может попасть в индекс. Лучше использовать и ограничения в robots, и другие методы запрета:

Тем не менее, без robots.txt больше вероятность, что информация, которая должна быть скрыта, попадет в выдачу, а это бывает чревато раскрытием персональных данных и другими проблемами.

Из чего состоит robots.txt

Файл должен называться только «robots.txt» строчными буквами и никак иначе. Его размещают в корневом каталоге — https://site.com/robots.txt в единственном экземпляре. В ответ на запрос он должен отдавать HTTP-код со статусом 200 ОК. Вес файла не должен превышать 32 КБ. Это максимум, который будет воспринимать Яндекс, для Google robots может весить до 500 КБ.

Внутри все должно быть на латинице, все русские названия нужно перевести с помощью любого Punycode-конвертера. Каждый префикс URL нужно писать на отдельной строке.

В robots.txt с помощью специальных терминов прописываются директивы (команды или инструкции). Кратко о директивах для поисковых ботах:

«Us-agent:» — основная директива robots.txt

Используется для конкретизации поискового робота, которому будут давать указания. Например, User-agent: Googlebot или User-agent: Yandex.

В файле robots.txt можно обратиться ко всем остальным поисковым системам сразу. Команда в этом случае будет выглядеть так: User-agent: *. Под специальным символом «*» принято понимать «любой текст».

После основной директивы «User-agent:» следуют конкретные команды.

Команда «Disallow:» — запрет индексации в robots.txt

При помощи этой команды поисковому роботу можно запретить индексировать веб-ресурс целиком или какую-то его часть. Все зависит от того, какое расширение у нее будет.

Такого рода запись в файле robots.txt означает, что поисковому роботу Яндекса вообще не позволено индексировать данный сайт, так как запрещающий знак «/» не сопровождается какими-то уточнениями.

На этот раз уточнения имеются и касаются они системной папки wp-admin в CMS WordPress. То есть индексирующему роботу рекомендовано отказаться от индексации всей этой папки.

Команда «Allow:» — разрешение индексации в robots.txt

Антипод предыдущей директивы. При помощи тех же самых уточняющих элементов, но используя данную команду в файле robots.txt, можно разрешить индексирующему роботу вносить нужные вам элементы сайта в поисковую базу.

Разрешено сканировать все, что начинается с «/catalog», а все остальное запрещено.

На практике «Allow:» используется не так уж и часто. В ней нет надобности, поскольку она применяется автоматически. В robots «разрешено все, что не запрещено». Владельцу сайта достаточно воспользоваться директивой «Disallow:», запретив к индексации какое-то содержимое, а весь остальной контент ресурса воспринимается поисковым роботом как доступный для индексации.

Директива «Sitemap:» — указание на карту сайта

« Sitemap:» указывает индексирующему роботу правильный путь к так Карте сайта — файлам sitemap.xml и sitemap.xml.gz в случае с CMS WordPress.

Прописывание команды в файле robots.txt поможет поисковому роботу быстрее проиндексировать Карту сайта. Это ускорит процесс попадания страниц ресурса в выдачу.

Файл robots.txt готов — что дальше

Итак, вы создали текстовый документ robots.txt с учетом особенностей вашего сайта. Его можно сделать автоматически, к примеру, с помощью нашего инструмента.

Файл robots.txt

06 июня 2021 года, 20:30

robots.txt — это текстовый файл, который содержит инструкции для поисковых роботов. Содержимое файла представлено одной или более групп директив, которые позволяют управлять индексацией сайта. Помимо индексации, существует возможность добавления служебной информации, которая помогает поисковым системам. Грамотно составленный файл robots.txt позволяет ускорить индексацию сайта, уменьшить нагрузку на сервер и улучшить поведенческие факторы. В данной статье рассматриваются: создание и редактирования файла robots.txt, синтаксис директив, расположение на хостинге, расположение в панелях управления популярных CMS, генерация.

Файл robots.txt является файлом исключений и правил для поисковых роботов. Данный стандарт принят консорциумом всемирной паутины World Wide Web Consortium (W3C) 30 июня 1994 года. Следование стандарту является полностью добровольным, однако некоторые поисковые системы указывают на возможную некритическую проблему при отсутствии файла robots.txt.

Создание файла robots.txt

Чтобы создать файл robots.txt открыть блокнот и ввести следующие директивы:

сохранить файл с именем:

Имя файла обязательно должно быть написано прописными (маленькими) буквами.

Указанные директивы буквально расшифровываются так:

Данный файл загружается в корень сайта и номинально решает проблему валидации, которая связана с отсутсвием robots.txt.

Зачем нужен файл robots.txt

Файл robots.txt содержит правила-исключения, а также служебные директивы для поисковых роботов. Правильная настройка позволяет решать основные задачи для корректной индексации сайта:

Полное закрытие веб-проекта чаще всего реализуется в случаях:

Закрытие страниц и файлов сайта реализуется в случаях, когда они:

Указание служебной информации

Ранее, для ПС Яндекс можно было указывать адрес основного хоста (директива host — неактуально), задержку между обращениями бота к сайту (crawl-delay — неактуально). Сегодня достаточно указывать адрес sitemap.xml, директиву host вытеснили канонические адреса.

Где находится файл robots.txt

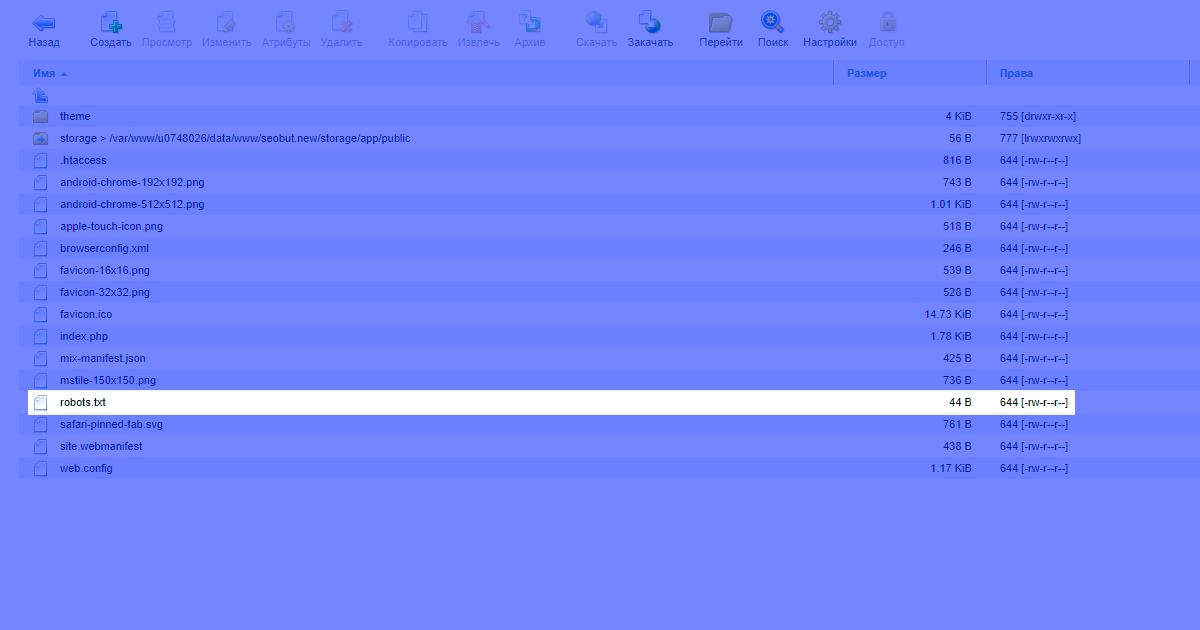

Файл всегда должен располагаться на хостинге, в корне сайта. Например, у нас это выглядит так:

Чтобы проверить текущее содержимое файла на сайте, в адресной строке следует ввести:

где mysite.ru — доменное имя проверяемого сайта

Расположение robots в CMS

Расположение robots в wordpress

Например, в панели управления wordpress нет отдельного пункта меню для создания и редактирования файла. Поэтому его модификацию можно осуществлять 2 способами:

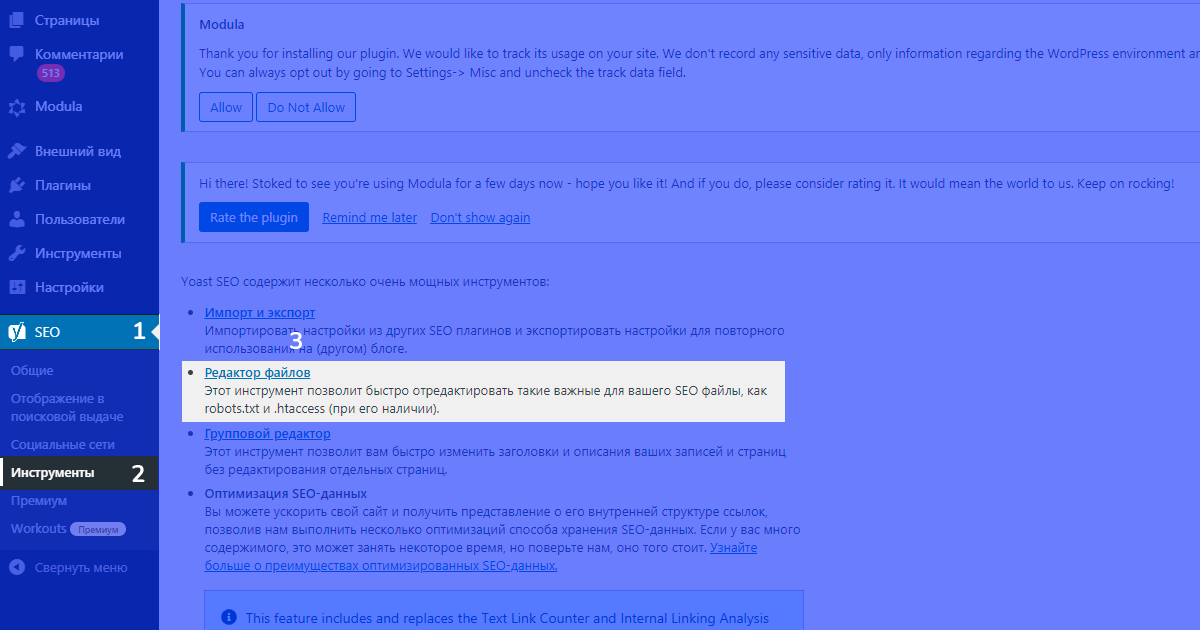

Редактирование robots.txt через плагин yoast

Рассмотрим создание и редактирование файла robots.txt в wordpress с помощью плагина yoast. Для того, чтобы создать или редактировать файл в данном плагине необходимо:

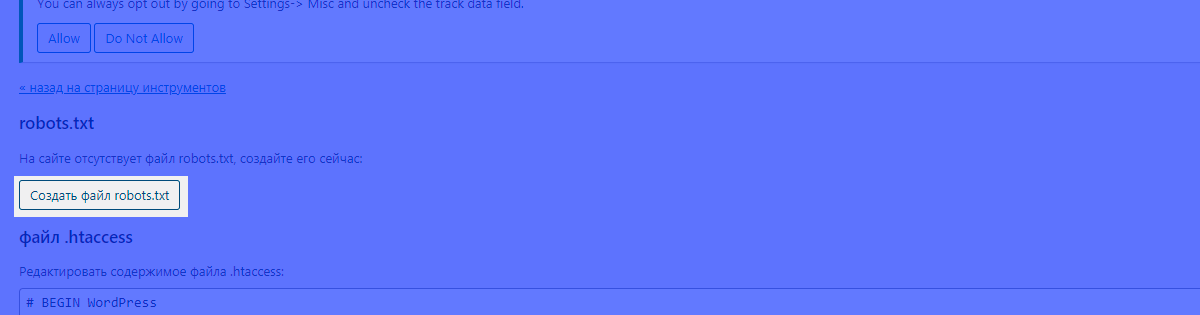

В случае, если файл робот создается через плагин впервые, yoast сообщит, что файл отсутсвует, несмотря на то, что файл может существовать. Тем не менее, если планируется редактирование файла robots из административной панели wordpress, следует нажать на кнопку создания:

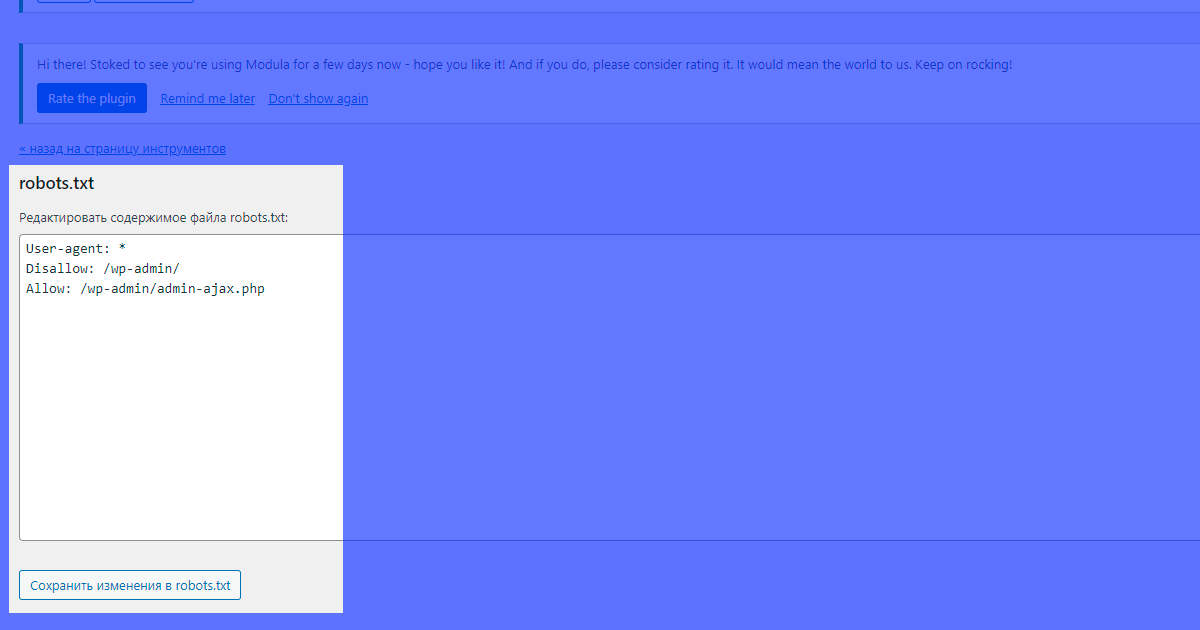

После нажатия кнопки можно увидеть базовое содержимое файла, которое можно редактировать:

После редактирования следует сохранить изменения.

Расположение robots.txt в tilda

Tilda самостоятельно генерирует файл робота и при этом не дает возможности редактирования, о чем поддержка сообщает в своей вопросно-ответной системе. Сегодня единственным решение в области редактирования файла robots.txt — экспорт проекта на собственный хостинг. После экспорта появится возможность управления файлом робота.

Расположение robots.txt в 1С-Битрикс

В 1С-Битрикс доступ к файлу robots из админ-панели существует. Для того, чтобы управлять файлом робота следует пройти по пути:

Маркетинг > Поисковая оптимизация > Настройка robots.txt

Проверка файла роботс

Для проверки файлов робота у поисковика Яндекс есть валидаторы:

Синтаксис

Общий синтаксис для записей файла роботс:

#комментарий

[Имя директивы]: [выражение]

Правила для файла и синтаксиса

Правила для синтаксиса

Данные для роботов могут отменяться последним изменением, а так как robots.txt проверяется первым, то если в файле robots.txt указано:

#для всех роботов закрыть весь сайт

User-Agent: *

Disallow: /

но при этом на всех страницах сайта будет указано:

тогда сайт может быть проиндексирован.

Директивы robots.txt

Директивы определяют задачи, которые требуется решать с помощью файла robots.txt.

| Директива | Функция |

|---|---|

| User-Agent | Указание имени поискового робота |

| Allow | Открыть для индексации |

| Disallow | Закрыть для индексации |

| Sitemap | Указание адреса для карты сайта (sitemap.xml) |

| Clean-param | Указание роботу, что страницы имеют параметры: GET, utm (ТОЛЬКО ДЛЯ ЯНДЕКС) |

| Crawl-delay | Указание в секундах скорость загрузки одной страницы до начала загрузки следующей (неактуально) |

| Host | Указывает основную версию сайта (может встречаться, однако сегодня неактуально) |

Стоит обратить внимание на директивы Host, Crawl-delay — не поддерживаются с 2018 года, а директива Clean-param используется только ПС Яндекс.

Директива User-Agent

Директива User-Agent служит указателем правил для конкретного поискового агента. Примеры использования директивы User-Agent для различных поисковых роботов:

#Для всех поисковых роботов

User-Agent: *

#Основной робот Яндекса

User-Agent: YandexBot

#Основной робот Google

User-Agent: Googlebot

#Основной робот Google новостей

User-agent: Googlebot-News

Поисковых агентов существует большое множество. Некоторые поисковые роботы могут игнорировать инструкции, которые указаны в файле роботс. Список имен ботов для поисковых систем Yandex и Google, которые не игнорируют правила файла robots.txt позволит производить более тонкую настройку правил индексации.

Директива Allow

Директива Allow задает правила для открытия страниц и(или) их содержимого для индексации. Примеры использования директивы Allow:

#для всех роботов открыть весь сайт

User-Agent: *

Allow: /

#для робота Яндекс открыть страницу catalog

User-Agent: YandexBot

Allow: /catalog

#для всех роботов открыть страницу каталог и все вложенные адреса

User-Agent: YandexBot

Allow: /catalog/

Директива Disallow

Одна из самых частоиспользуемых директив, которая запрещает индексацию поисковыми роботами.

#для всех роботов открыть весь сайт

User-Agent: *

Allow: /

#запретить индексацию для основного бота Яндекс

User-Agent: YandexBot

Disallow: /

Зачем закрывать определенного бота

Закрытие определенного бота может быть использовано в различных ситуациях. Рассмотрим пример на гипотетическом проекте с региональной привязкой к поддоменам.

Дано: основной сайт с доменным адресом:

Который имеет поддомены со соответствующей привязкой городов:

Для Яндекса, в вебмастере можно указать каждому поддомену свой город, и добавить возможность индексации (для каждого поддомена свой файл robots.txt):

Для Google подобное решение может оказаться не всегда понятным, что может приводить к выбрасыванию поддоменов из выдачи. Это связано с городами России, которые Гугл не всегда корректно разбирает. Поэтому для каждого поддомена и Googlebot (основного индексирующего бота Google), можно добавить запись:

В результате для каждого поддомена (для каждого свой файл робота) получится подобный robots.txt:

При этом, для основного домена запись robots.txt будет выглядеть так:

Таким образом, поисковик Яндекс будет индексировать только поддомены, а Google только основной домен и не будет создавать проблем.

Директива Sitemap

Директива sitemap необходима для указания карты сайта и используется в таком формате:

#Пример с одной картой

User-Agent: *

Allow: /

Sitemap: https://seobut.com/sitemap.xml

Обычно для современных проектов создаются составные карты, для которых достаточно указать основную. Но для понимания допустим вариант указания нескольких карт, например:

#пример указания нескольких карт

User-Agent: *

Allow: /

Sitemap: https://seobut.com/sitemap.xml

Sitemap: https://seobut.com/stitemap-blog.xml

Для показа контента сайта в ленте Google news генерируется и указывается отдельная карта сайта со своими правилами, тогда файл robots может выглядеть так:

#обычная карта

User-Agent: *

Sitemap: https://seobut.com/sitemap.xml

#карта для google новостей

User-Agent: Googlebot-News

Allow: /

Sitemap: https://seobut.com/sitemap-news.xml

Директива Clean-param

Только для поисковой системы яндекс

Директива Clean-param необходима для снижения нагрузки на сайт, ускорения индексации полезного контента с помощью исключения страниц-дублей с одинаковым и(или) бесполезным контетом. Чаще всего исключаемые страницы на сайте возникают из-за наличия: страниц результатов поиска, utm меток, страниц с GET-параметрами. Данная директива работает только ботами Яндекс, для Google используются канонические адреса и(или) директива Disallow.

Синтаксис директивы Clean-param:

Clean-param: [p][&p1&p2&pN] [path]

Например, необходимо на каждом разделе закрыть все страницы с umt-метками:

User-Agent: Yandex

Clean-param: utmstat

Таким образом будут закрыты все страницы, которые содержат параметр utmstat, например:

seobut.com/?utmstat=.

seobut.com/publications/?utmstat=.

seobut.com/publications/fail-robots/?utmstat=.

Рассмотрим пример закрытия поисковых страниц сайта через Clean-param. Имеется страница поиска с запросом seo:

https://seobut.com/search/search_do/?search_string=seo&search_types=56

Как можно увидеть, запрос состоит из двух параметров. Именно эти 2 параметра станут маркерами закрытия индексации, которую можно реализовать так:

User-Agent: Yandex

Clean-param: search_string&search_types /search/search_do/

Важно понимать, что амперсант (&), в контексте данной инструкции, означает «и». То есть, чтобы поисковая система исключила подобные страницы из индекса, робот должен встретить оба параметра в строке URL.

Правильный файл robots.txt

Правильный файл robots.txt определяется архитектурой адресации на сайте, а также наличием или отсутствием различных параметров: get, utm. Самый правильный файл должен содержать минимум директив. Например, в нашем случае, правильный файл robots выглядит так:

User-Agent: *

Allow: /

Disallow: /?

Disallow: /*?

Disallow: /policy

Sitemap: seobut.com/sitemap.xml

Здесь для всех поисковых роботов сайт полностью открывается для индексации, указывается карта сайта, при этом закрываются страницы с параметрами и политика.

В зависимости от организации архитектуры веб-сайта, robots.txt могут отличаться. Сайты могут работать на готовой cms, либо на фреймворке, следовательно способы регулирования выдачи могут отличаться.

Правильный robots.txt wordpress

В базовом представлении плагин yoast генерирует такой файл:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Но вебмастера обычно используют расширенный вариант:

User-agent: * # для всех поисковиков

Disallow: /wp-admin # админка

Disallow: /wp-includes # базовая папка wp

Disallow: /wp-content/plugins # плагины wp

Disallow: /wp-content/cache # кеш wp

Disallow: /wp-json/ # файлы конфигурации

Disallow: /xmlrpc.php # XML-RPC старьё

Disallow: /readme.html # можно удалить

Disallow: /*? # GET-параметры

Disallow: /?s= # поиск

Allow: /wp-includes/*.css # открыть скрипты и стили

Allow: /wp-includes/*.js

Allow: /wp-content/plugins/*.css

Allow: /wp-content/plugins/*.js

Allow: /*.css

Allow: /*.js

Sitemap: https://seobut.com/sitemap.xml

Открытие файлов стилей и скриптов необходимо например для google. Гугл утверждает что умеет индексировать скрипты и стили, чем улучшает выдачу для пользователей.

Правильный robots.txt 1С битрикс

Внимательно отнеситесь к данным директивам, несмотря на то, что большее количество директив описано, если на 1С битриксе вносились правки в логику модулей, то некоторых директив может не хватать.

User-agent: * # правила для всех роботов

Disallow: /cgi-bin # папка на хостинге

Disallow: /bitrix/ # системные файлы битрикса

Disallow: *bitrix_*= # GET-запросы битрикса

Disallow: /local/ # папка с системными файлами битрикса

Disallow: /*index.php$ # дубли всех index.php

Disallow: /auth/ # авторизация

Disallow: *auth= # авторизация с любого раздела

Disallow: /personal/ # личный кабинет

Disallow: *register= # регистрация

Disallow: *forgot_password= # забыли пароль

Disallow: *change_password= # изменить пароль

Disallow: *login= # логин

Disallow: *logout= # выход

Disallow: */search/ # базовая страница поиска

Disallow: *action= # действия

Disallow: *print= # печать

Disallow: *?new=Y # новая страница

Disallow: *?edit= # редактирование страницы

Disallow: *?preview= # предпросмотр страницы

Disallow: *backurl= # страницы при переходе из админки

Disallow: *back_url= # страницы при переходе из админки

Disallow: *back_url_admin= # страницы при переходе из админки

Disallow: *captcha # все каптчи

Disallow: */feed # все фиды

Disallow: */rss # конкретный rss фид

Disallow: *?FILTER*= # здесь и ниже различные популярные параметры фильтров

Disallow: *?ei=

Disallow: *?p= #базовые страницы пагинации

Disallow: *?q= #базовые страницы поиска

Disallow: *?tags= #базовые страницы с тегами

Disallow: *B_ORDER=

Disallow: *BRAND= #опции фильтрации здесь и ниже

Disallow: *CLEAR_CACHE=

Disallow: *ELEMENT_ID=

Disallow: *price_from=

Disallow: *price_to=

Disallow: *PROPERTY_TYPE=

Disallow: *PROPERTY_WIDTH=

Disallow: *PROPERTY_HEIGHT=

Disallow: *PROPERTY_DIA=

Disallow: *PROPERTY_OPENING_COUNT=

Disallow: *PROPERTY_SELL_TYPE=

Disallow: *PROPERTY_MAIN_TYPE=

Disallow: *PROPERTY_PRICE[*]=

Disallow: *S_LAST=

Disallow: *SECTION_ID=

Disallow: *SECTION[*]=

Disallow: *SHOWALL=

Disallow: *SHOW_ALL=

Disallow: *SHOWBY=

Disallow: *SORT=

Disallow: *SPHRASE_ID=

Disallow: *TYPE=

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Disallow: *from= # ссылки с метками from

Allow: */upload/ # открываем папку с файлами

Allow: /bitrix/*.js # открываем скрипты и изображения

Allow: /bitrix/*.css

Allow: /local/*.js

Allow: /local/*.css

Allow: /local/*.jpg

Allow: /local/*.jpeg

Allow: /local/*.png

Allow: /local/*.gif

Sitemap: https://seobut.com/sitemap.xml

Последняя директива Sitemap, содержит адрес нашей карты, не забудьте заменить путь.

Генераторы robots.txt

Генераторы файла robots.txt — инструменты, которые позволяют ввести вводные данные и получить готовый список директив, например:

Однако, стоит понимать, что необходим понимать что и каким образом закрывается на сайте.

Например, логичное с одной стороны закрытие GET-параметров, может привести к потери качественных страниц, которые уже занимают хорошие позиции в индексе. Другой пример — закрытие страниц пагинации, которые тоже хорошо могут отдаваться в поиске. Поэтому, до внесения изменений в robots с помощью генераторов, следует детально изучить выдачу, а также способы формирования контента на рабочем проекте.