Rtl видеокарта что это

Обозначение в описании Retail у видеокарт и что оно означает?

Всем привет! Сегодня я расскажу, что значит Retail видеокарта, чем отличается от OEM такой тип упаковки и какая комплектация допускается в обоих случаях. Что такое приставка Ti в названии видеокарты от Nvidia, можно узнать в этом посте.

Что означает OEM в наименовании товара

Обозначение ОЕМ в названии комплектующих — аббревиатура от Original Equipment Manufacturer, что переводится как «Производитель оригинального оборудования». Это простейшая упаковка — антистатический полиэтиленовый пакет.

Как правило, там упакованы только сама GPU и гарантийный талон, безо всяких дополнительных аксессуаров и инструкций.

Чаще всего такие детали поставляются оптом специализированным компаниям, которые занимаются сборкой компьютеров. Они стоят дешевле, чем RTL.

Что это такое RTL

Этот термин — анаграмма от Retail, что переводится «Розничный». Такой тип товара ориентирован на реализацию через магазины, включая торговые площадки в интернете.

Стоит дороже чем ОЕМ, прежде всего из-за яркой красивой тары.

Обе аббревиатуры, OEM и RTL, обычно указываются в описании товара, если вы собираетесь купить деталь через интернет. В техническом плане это равнозначные комплектующие, которые не отличаются своими характеристиками.

Разница между OEM-поставкой и Retail-поставкой

Изучая прайсы магазинов, преимущественно торгующих компьютерными комплектующими и программным обеспечением, все мы сталкиваемся с приписочкой после полностью идентичных названий — OEM или RTL (Retail). И цены в этих строчках могут существенно различаться. За что приходится платить или чем жертвовать? Попробуем разобраться.

OEM (Original equipment manufacturer) в официальном варианте — обозначение производителем факта сборки продукта на основе сторонних проектов и созданных другими компаниями комплектующих. Фактически же для российского рынка аббревиатура OEM символизирует минимальную комплектацию, предназначенную в теории для сборщиков продуктов и дальнейшей реализации. Как правило, в российских торговых сетях OEM-продукты лежат на витринах рядом с RTL.

Retail — в переводе с английского именно “розничная торговля”. Аббревиатура RTL обозначает, что продукт полностью готов к эксплуатации конечным потребителем. Во многих странах только такая форма и допускается к продаже в розничных торговых точках.

Раз наш рынок не столь щепетилен, посмотрим на оба эти варианта ради оценки выгод покупателя, то есть нас с вами. OEM-поставка очень скромна: антистатический пакет, если речь идет о комплектующих или электронике (максимум — добавлен диск с драйверами), или же, в случае с программным обеспечением, бумажный конверт с носителем (тот же оптический диск, чаще всего). RTL-поставка щедрее, хотя щедрость — понятие относительное. Но, как минимум, имеется коробка, инструкция, минимальный набор аксессуаров вроде кабелей, болтиков и переходников, в зависимости от вида продукции. Если товар в коробке — уже не OEM, так что отсутствие в комплекте чего-то нужного и важного — на совести производителя.

Цена производителем на OEM и RTL устанавливается разная, так что и мы на витринах видим ценники, иной раз значительно отличающиеся друг от друга. Таким образом, платим мы за коробку и определенного рода удобство эксплуатации. RTL по умолчанию дороже.

Как правило, на OEM-поставки производитель не дает своей гарантии или дает ее на особых условиях. Эти обязательства перекладываются на плечи сборщиков и торговых организаций. Что касается программного обеспечения, то техподдержка разработчиком оказывается, но лицензионные соглашения часто действительны лишь для единственного варианта установки. Переносить OEM-лицензии в большинстве случаев запрещено. Retail-поставки в этом отношении гораздо лояльнее к потребителю.

Также существенным для конечного потребителя может оказаться факт, что OEM-поставка ввиду отсутствия прочной упаковки может чаще оказаться поврежденной по вине перевозчика. К тому же стоит учитывать российские реалии, где за OEM очень часто выдают отбраковку или отремонтированное в сервисе.

NVIDIA RTX vs GTX: в чем разница?

Если вы не в курсе последних новостей в мире аппаратного оборудования или только недавно заинтересовались сборкой своего ПК и думаете о приобретении видеокарты от Nvidia, то, несомненно, заметили, что упомянутая компания предлагает два разных на первый взгляд типа графических процессоров: GTX и RTX.

Итак, что же это все означает, в чем разница между моделями GTX и RTX, и какую из них стоит выбрать? Мы ответим на все эти вопросы, так что рекомендуем прочитать статью до конца!

Основы

Все игровые графические процессоры Nvidia принадлежат их собственному бренду GeForce, который появился в 1999 году с выпуском GeForce 256. С тех пор компания выпустила сотни различных видеокарт, а кульминацией стали три последних модельных ряда: серия GeForce 20, выпущенная в 2018 году, серия GeForce 16, выпущенная в 2019 году, и серия GeForce 30, выпущенная в 2020 году.

На сегодняшний день серии GeForce 20 и GeForce 30 состоят исключительно из графических процессоров RTX, а серия GeForce 16 – из видеокарт GTX. Итак, что же означают все эти буквы? На самом деле ни GTX, ни RTX, не являются аббревиатурами и не имеют конкретного значения как такового. Они существуют просто ради маркетинговых целей.

Nvidia использовала несколько похожих двух- и трехбуквенных обозначений, чтобы предоставить пользователям общее представление о том, какую производительность может предложить каждый графический процессор. Например, производители использовали такие обозначения, как GT, GTS, GTX, а также многие другие на протяжении многих лет, однако лишь GTX и новая RTX «выжили» до наших дней.

GeForce 20 / 30 против GeForce 16

Прежде всего мы должны отметить, что серии 20 и 16, то есть последние графические процессоры RTX и GTX, основаны на одной и той же микроархитектуре видеокарты Turing, которую Nvidia впервые представила в 2018 году. В свою очередь, серия 30 основана на новейшей архитектуре Ampere.

Однако, несмотря на то, что GeForce 20 и 16 основаны на одной архитектуре, 20-я вышла первой. После запуска в 2018 году, производители хотели сосредоточиться на расширенных функциях, которые могла предложить новая архитектура. Линейка состояла из графических процессоров верхней части среднего сегмента и high-end видеокарт, которые и могли продемонстрировать указанные функции, и это были первые модели под обозначением RTX.

Между тем, серия 16 появилась годом позже, потому что Nvidia нужно было предложить несколько более экономичных решений для тех, кто не мог позволить себе потратить больше 400 долларов на видеокарту. Эти графические процессоры, однако, не имели вышеупомянутых расширенных функций, поэтому сохранили старое обозначение GTX.

Тем не менее в настоящее время графические процессоры GTX действительно слабее, чем RTX, но так и было задумано самими разработчиками. Название RTX было введено в основном ради маркетинга, чтобы новые графические процессоры воспринимались как большой шаг вперед, как нечто действительно новое, а само обозначение было вдохновлено главной новой функцией, представленной в серии 20: трассировка лучей в реальном времени.

Сейчас трассировка лучей в реальном времени стала возможной благодаря RT-ядрам, которые встречаются только в сериях 20 и 30 и отсутствуют в моделях серии 16. Вдобавок ко всему существуют тензорные ядра, которые обеспечивают ускорение ИИ, а также повышают производительность трассировки лучей и обеспечивают суперсэмплинг глубокого обучения в играх.

Если убрать эти две ключевые характеристики из общей картины, видеокарты GTX 16 серии и графические процессоры RTX серий 20 и 30 не так уж сильно отличаются. Очевидно, что более дорогие модели RTX имеют больше транзисторов, больше ядер, лучшую память и многое другое, из-за чего они способны предложить лучшую общую производительность, чем более дешевые аналоги в лице GTX. Однако они не обязательно обеспечивают лучшее соотношение цены и качества.

Итак, что это за новые функции и стоит ли покупать графический процессор RTX?

Что такое RT ядра?

Как упоминалось выше, RT ядра представляют собой ядра графического процессора, предназначенные исключительно для трассировки лучей в реальном времени.

Так что же делает трассировка лучей с графикой видеоиграх? Технология позволяет добиться более реалистичного освещения и отражений. Это достигается путем отслеживания обратной траектории распространения луча, что позволяет графическому процессору выдавать гораздо более реалистичное моделирование взаимодействия света с окружающей средой. Рейтрейсинг по-прежнему возможен даже на графических процессорах без RT ядер, но в таком случае производительность просто ужасная, даже на флагманских моделях типа GTX 1080 Ti.

Говоря о производительности, трассировка лучей в реальном времени на самом деле сильно влияет на производительность даже при использовании с графическими процессорами RTX, что неизбежно приводит к вопросу — стоит ли вообще использовать данную технологию?

По состоянию на 2020 год чуть множество игр поддерживают трассировку лучей.

Видео выше показывает, как трассировка лучей выглядит в игре Control (2019): графические улучшения, обеспечиваемые трассировкой лучей, значительны. Однако функция сокращает показатель FPS вдвое, со стабильных 60 до 30, и это с высокопроизводительной видеокартой RTX 2070 Super!

Трассировка лучей в реальном времени — это важное достижение в области гейминга, которое в ближайшие годы значительно улучшит графику видеоигр. Тем не менее, на прямо сейчас аппаратное обеспечение недостаточно мощное, и разработчики еще не в полной мере используют потенциал функции.

Что такое тензорные ядра?

Несмотря на то, что трассировка лучей является наиболее «продаваемой» функцией графических процессоров RTX серий 20 и 30, архитектура Turing также представила еще одну важную новую функцию в основной линейке GeForce — расширенные возможности глубокого обучения, которые стали возможны с помощью специальных тензорных ядер.

Эти ядра были представлены в 2017 году в графических процессорах Nvidia Volta, однако игровые видеокарты не были основаны на этой архитектуре. Таким образом, тензорные ядра, присутствующие в моделях Turing, на самом деле являются тензорными ядрами второго поколения. Касаемо игр, то у глубокого обучения есть одно основное применение: суперсэмплинг глубокого обучения, сокращенно DLSS, который представляет собой совершенно новый метод сглаживания. Итак, как именно работает DLSS и лучше ли он, чем обычные методы сглаживания?

DLSS использует модели глубокого обучения для генерации деталей и масштабирования изображения до более высокого разрешения, тем самым делая его более резким и уменьшая искажения. Вышеупомянутые модели глубокого обучения создаются на суперкомпьютерах Nvidia, а затем приводятся в действие тензорными ядрами видеокарты.

Суперсэмплинг обеспечивает более четкое изображение, но при этом требует меньших затрат на оборудование, чем большинство других методов сглаживания. Более того, технология может заметно улучшить производительность при включенной трассировке лучей, что хорошо, учитывая, насколько высока производительность данной функции.

Однако, как и в случае с трассировкой лучей, список игр, которые в настоящее время поддерживают DLSS, к сожалению, довольно мал. Впрочем, это наверняка изменится в будущем.

Заключение

Что ж, пришло время подвести итоги: обозначение RTX было введено Nvidia в основном ради маркетинговых целей, из-за чего графические процессоры на архитектуре Turing 20-й серии выглядели как более крупное обновление, чем они есть на самом деле.

Конечно, RTX-модели оснащены крутыми новыми элементами, которые полностью раскроют свой потенциал в обозримом будущем, а что касается чистой производительности, новейшие видеокарты на архитектуре Ampere достаточно сильно опережают старые графические процессоры GTX на базе Pascal, которые продавались по примерно той же цене.

Принимая во внимание все вышесказанное, мы бы не сказали, что графические процессоры RTX стоит покупать только ради трассировки лучей и DLSS, поскольку производительность всегда должна быть на первом месте, особенно если вы хотите получить максимальную отдачу от своих денег. С другой стороны, эти технологии будут развиваться в ближайшем будущем, и через пару лет графические чипы GTX окажутся откровенно устаревшими. Если вы собираетесь приобрести новую видеокарту, то, возможно, стоит ознакомиться с данной статьей, где мы перечислили лучшие видеокарты, доступные на рынке прямо сейчас.

Считаю что трассировка лучей является не столь революционной функцией ради которой стоит обновляться на новое поколение, сколько её метод оптимизации под названием DLSS. Уже который год в сети плавают слухи что у NVIDIA в рукаве был припасён ход, позволяющий сделать реальный прогресс в плане оптимизации — но зная насколько сильно компания погрязла в маркетинге, ждать от них такого подарка «бесплатно» было бы максимально глупо, и по факту так и получилось.

Трассировка же стала тем самым триггером, который заставил их применить этот козырь, и как мы видим по тестам 2.0 версии — результаты действительно впечатляющие, а уж если и вовсе отключить Трассировку, то мы как раз и получаем тот самый долгожданный буст фпс в 2 раза, который к тому же ещё и умудряется «улучшать» картинку из натива… Просто фантастика.

У них в планах сейчас вообще стоит задача добиться включения поддержки DLSS по умолчанию на уровне настройки видеоадаптера через панель нвидии, но это ориентировочно должно быть в версии 3.0, а пока что только вчера вышло обновление под номером 2.1 которое добавляет режим «Ультра производительности» для Death Stranding — кстати есть ли по этому поводу тесты?)

Чего ждать в будущем? Первое время конечно всё будет сказочно — буст фпс в 2 раза это действительно круто, и только совсем глупые люди не будут таким пользоваться, особенно на самых бюджетных версиях RTX серии в виде 2060, которые были слегка быстрее и чутка дороже тех же 1660 версий, но по факту дадут двойной разрыв в производительности с ними.

Но почему же это чисто маркетинговая технология, которая по факту может работать на всех видеокартах, но нвидиа заботливо двигает её только под новые серии? Да потому что у неё есть аналог, и точно так же как и Crytek сделали свой софтовый вариант трассировки, AMD сделали на уровне софта аналог под названием FidelityFX. Естественно она получилась хуже, но тот факт что это всё базируется чисто на программном уровне — а не с фейковым использованием каких то там специальных ядер, намекает нам на то что кое кого сильно обманывают, но если всё таки довести до ума данную функцию и включить её поддержку на программном уровне — то AMD будет иметь серьёзный ответ на прорывные технологии предлагаемые Хуангом в 3 тысячной серии.

Rtl видеокарта что это

Q: Какой программой можно посмотреть температуру графического процессора?

A: Можно воспользоваться программами RivaTuner и/или EVEREST.

Q: Как можно регулировать скорость вращения вентилятора на видеокарте?

A: RivaTuner для видеокарт NVIDIA GeForce и ATI Tray Tools для видеокарт ATI Radeon.

Q: Частота обновления на моем CRT мониторе в разрешении YYYxZZZ равна xxГц, хотя я точно знаю что для моего монитора в этом разрешении частота должна быть выше. Как это можно исправить?

A: Есть несколько способов для решения этой проблемы. Самый эффективный и простой это при помощи программы RivaTuner создать альтернативный драйвер для монитора, в котором указать нужные значения. Как это сделать можно прочитать вот тут.

Q: Поставил новую видеокарту, а после загрузки Windows пишет о нехватке питания и/или виснет в 3D приложениях. Блок питания у меня хороший. Что это может быть?

A: Скорее всего не подключён разъём дополнительного питания на видеокарте. Его нужно обязательно подключить.

Обычно у PCI-E карт 6-штырьковый разъём (на фото выделено красным):

В современных блоках питания есть специальный 6-штырьковый разъём (иногда и не один). Если на вашем блоке питания его нет, то в комплекте должен быть переходник 2xМолекс на 6-штырьковый разъём:

Иногда такие переходники можно найти в магазинах.

А в видеокартах под AGP-разъем обычно можно увидеть обычный молекс:

Молекс это обычный 4-штырьковый разъем, которым подключают жёсткие диски и CD/DVD приводы. В зависимости от класса видеокарты потребуется один или два кабеля.

Иногда бывает производители ставят 6-штырьковый разъём на AGP карты. Или наоборот, молексы на PCI-E карты.

Есть и не совсем обычные модели видеокарт с разъёмом дополнительного питания от 3,5″ дисковода. Из современных видеокарт, например, у HIS есть модели серии Radeon X1650 с таким разъемом:

Q: Что означает RTL или Retail, Light Retail, OEM в названиях карт? И что из них лучше?

A: Это комплект поставки видеокарты.

Трудно сказать, что лучше из этого выбрать. Зачастую продукты OEM комплектации стоят дешевле, аналогичных продуктов Retail комплектации. И тем самым можно немного сэкономить. Однако каждый покупатель должен сам решить что для него удобнее.

Директива вступила в силу 1 июля 2006 года. Данная директива ограничивает использование в производстве шести опасных веществ:

1. свинец

2. ртуть

3. кадмий

4. шестивалентный хром (chromium VI или Cr6+)

5. полибромированные бифенолы (PBB)

6. полибромированный дифенол-эфир (PBDE)

Q: Появились артефакты, кто виноват и что делать?

Если никакого разгона нет, а артефакты есть, методом последовательных исключений нужно вычислить виновника.

1. Исключить драйвера, ОС и DirectX. ОС установить с нуля или параллельную, попробовать разные версии драйверов, DirectX переустановить.

2. Исключить перегрев. Отмониторить температуру, поменять термопасту, СО и т.д. С этим Вам помогут в разделе Охлаждение

3. Исключить питание. Для этого нужен другой блок питания, качественный, достаточной мощности и заведомо исправный. Какой блок питания достаточен для Вашей конфигурации подскажут в разделе Корпуса, блоки питания, моддинг

4. Исключить слот и всё, что с ним связано. То есть, проверить на другой материнской плате.

В случае, когда артефакты есть во время прохождения POST, пункты 1 и 2 неактуальны, ось/драйвера/перегрев исключаем сразу.

Если четверо этих подозреваемых оказались невиновны, значит неисправна сама видеокарта.

Типы неисправностей хорошо изложены в статье на rom.by «Самоучитель по ремонту видеокарт. Артефакты»

Цитата оттуда:

Точки и полосы на изображении обычно также являются следствием нарушения БГАмонтажа.

Возможна неисправность самого ГПУ, подгорел конвеер. Замена ГПУ довольно сложна, поэтому иногда для оживления имеет смысл воспользоваться какой-нибудь прогой, типа «RivaTuner» или «ATI Tray Tool», сначала снижать частоты, затем поочередно пеpеключать пpоцессоpные конвееpы: там всякие шейдеpные, веpтексные, пиксельные, веpшинные, какие там еще есть, авось повезет и они выгорели не все. После чего останется взять редактор биоса, внести в родной биос

Шумящие неисправные DC-DC конвертеры (в первую очередь памяти, но и питатель гпу так же никто не исключает) могут вызывать подобные симптомы, проверять осцилом. Обычно гадят ключи (мосфеты) иногда ШИМы.

Добавлю, что ещё возможны неисправности БИОСа видеокарты, приводящие к артефактам.

Q: Слышал про ускорение физики средствами видеокарт. Хотелось бы узнать про это поподробнее. И какие видеокарты умеют ускорять физику?

Тем временем NVIDIA, которая тоже говорила о возможности ускорения физики на своих видеокартах, сидела молча до определенного момента. В начале 2008 года NVIDIA заявила о покупке компании AGEIA, которая разработала собственный ускоритель физики PhysX и специальный физический движок PhysX. Дела у компании AGEIA шли не очень хорошо, игр с использованием их физического движка было не много, поэтому и физические ускорители продавались очень плохо. После своего приобретения NVIDIA сразу же принялась переводить API PhysX на свои видеокарты при помощи CUDA.

Итак на данный момент аппаратное ускорение физики средствами видеокарт поддерживают только с игры физическим движком PhysX*и только на видеокартах NVIDIA GeForce 8-й, 9-й, 200-й, 400-й и 500-й сериях.

Видеокарты AMD Radeon пока не умеют ускорять физику.

*Q: Что такое PhysX?

A: PhysX это физический движок с возможностью аппаратного ускорения. Для того что лучше понять, PhysX можно разделить на две части: CPU PhysX и GPU PhysX.

CPU PhysX это многоплатформенный физический движок в котором работает только процессор. Т.е. никакие ускорители физики (Ageia PhysX) или видеокарты тут ничего не дают. Этот физический движок существует практически под все современные игровые платформы: PC, PlayStation 3, XBox 360, Wii.

GPU PhysX это расширенные возможности физического движка в котором для расчета эффектов может использоваться видеокарта с поддержкой CUDA, т.е. NVIDIA GeForce.

В большинстве игр где есть физический движок PhysX используется только CPU PhysX. Всего таких игр насчитывается более 200.

Игр где есть GPU PhysX значительно меньше, немногим более 20. Причем большая часть из них третье сортный трэш. Качественных игр с GPU PhysX можно посчитать по пальцам: Unreal Tournament 3 (со спец дополнением), Mirror’s Edge, Batman: Arkham Asylum, Анабиоз: Сон Разума (Cryostasis: Sleep of Reason), Metro 2033, Mafia II.

Q: Могу я использовать видеокарты ATI Radeon для GPU PhysX?

A: Нет. Т.к. ATI Radeon не поддерживают CUDA. Возможно позже если NVIDIA перенесет PhysX под OpenCL или DirectCompute, тогда и на ATI Radeon будет возможность работать с GPU PhysX.

Q: Какую видеокарту выбрать для отдельного ускорения GPU PhysX?

A: На данный момент больше чем GeForce GT240 нет смысла брать.

FAQ по видеокартам GeForce: что следует знать о графических картах?

Страница 4: GPU

Что скрывается за потоковым процессором, блоком шейдеров или ядром CUDA?

Потоковый процессор обрабатывает непрерывный поток данных, которых насчитываются многие сотни, причем они выполняются параллельно на множестве потоковых процессоров. Современные GPU оснащаются несколькими тысячами потоковых процессоров, они отлично подходят для задач с высокой степенью параллельности. Это и рендеринг графики, и научные расчеты. Что, кстати, позволило GPU закрепиться в серверном сегменте в качестве вычислительных ускорителей.

Еще одним шагом дальше можно назвать интеграцию ядер Tensor в архитектуру NVIDIA Ampere, которые способны эффективно вычислять менее сложные числа INT8 и INT4, но об этом мы поговорим чуть позже.

В составе GPU GA102 имеются семь кластеров Graphics Processing Clusters (GPC) с 12 потоковыми мультипроцессорами Streaming Multiprocessors (SM) каждый. Но на видеокартах GeForce RTX 3090 и GeForce RTX 3080 активны не все SM. GA102 GPU теоретически содержит 10.752 блоков FP32 (7 GPC x 12 SM x 128 блоков FP32). Но у GeForce RTX 3090 два SM отключены, поэтому видеокарта предлагает «всего» 10.496 блоков FP32. Такой подход повышает выход годных чипов NVIDIA, поскольку наличие одного-двух дефектных SM не приводит к отбраковке кристалла.

В случае GeForce RTX 3080 один кластер GPC полностью отключен, поэтому на GA102 GPU остаются шесть GPC, но только четыре из них содержат полные 12 SM, два ограничены десятью SM. Что дает в сумме 8.704 блока FP32 в составе 68 SM.

NVIDIA масштабирует архитектуру Ampere с видеокарты GeForce RTX 3060 вплоть до GeForce RTX 3090. Ниже представлен обзор видеокарт GeForce RTX 30:

| GeForce RTX 3090 | GeForce RTX 3080 Ti | GeForce RTX 3080 | GeForce RTX 3070 Ti | |

| GPU | Ampere (GA102) | Ampere (GA102) | Ampere (GA102) | Ampere (GA104) |

| Число транзисторов | 28 млрд. | 28 млрд. | 28 млрд. | 17,4 млрд. |

| Техпроцесс | 8 нм | 8 нм | 8 нм | 8 нм |

| Площадь кристалла | 628,4 мм² | 628,4 мм² | 628,4 мм² | 392,5 мм² |

| Число FP32 ALU | 10.496 | 10.240 | 8.704 | 6.144 |

| Число INT32 ALU | 5.248 | 5.120 | 4.352 | 3.072 |

| Число SM | 82 | 80 | 68 | 48 |

| Ядра Tensor | 328 | 320 | 272 | 192 |

| Ядра RT | 82 | 80 | 68 | 48 |

| Базовая частота | 1.400 МГц | 1.365 МГц | 1.440 МГц | 1.580 МГц |

| Частота Boost | 1.700 МГц | 1.665 МГц | 1.710 МГц | 1.770 МГц |

| Емкость памяти | 24 GB | 12 GB | 10 GB | 8 GB |

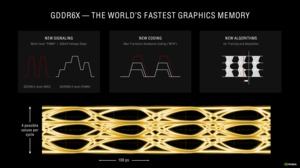

| Тип памяти | GDDR6X | GDDR6X | GDDR6X | GDDR6X |

| Частота памяти | 1.219 МГц | 1.188 МГц | 1.188 МГц | 1.188 МГц |

| Ширина шины памяти | 384 бит | 384 бит | 320 бит | 256 бит |

| Пропускная способность памяти | 936 Гбайт/с | 912 Гбайт/с | 760 Гбайт/с | 608 Гбайт/с |

| TDP | 350 Вт | 350 Вт | 320 Вт | 290 Вт |

| GeForce RTX 3070 | GeForce RTX 3060 Ti | GeForce RTX 3060 | |

| GPU | Ampere (GA104) | Ampere (GA104) | Ampere (GA106) |

| Число транзисторов | 17,4 млрд. | 17,4 млрд. | 12 млрд. |

| Техпроцесс | 8 нм | 8 нм | 8 нм |

| Площадь кристалла | 392,5 мм² | 392,5 мм² | 276 мм² |

| Число FP32 ALU | 5.888 | 4.864 | 3.584 |

| Число INT32 ALU | 2.944 | 2.432 | 1.792 |

| Число SM | 46 | 38 | 28 |

| Ядра Tensor | 184 | 152 | 112 |

| Ядра RT | 46 | 38 | 28 |

| Базовая частота | 1.500 МГц | 1.410 МГц | 1.320 МГц |

| Частота Boost | 1.730 МГц | 1.665 МГц | 1.780 МГц |

| Емкость памяти | 8 GB | 8 GB | 12 GB |

| Тип памяти | GDDR6 | GDDR6 | GDDR6 |

| Частота памяти | 1.725 МГц | 1.750 МГц | 1.875 МГц |

| Ширина шины памяти | 256 бит | 256 бит | 192 бит |

| Пропускная способность памяти | 448 Гбайт/с | 448 Гбайт/с | 360 Гбайт/с |

| TDP | 220 Вт | 200 Вт | 170 Вт |

Одновременное выполнение операций с целыми числами и числами с плавающей запятой

Как мы уже упоминали, вычислительные блоки FP32 могут работать в режиме 2x FP16, то же самое касается INT16. Чтобы увеличить вычислительную производительность и сделать ее более гибкой, в архитектуре NVIDIA Turing появилась возможность одновременного расчета чисел с плавающей запятой и целых чисел. Конечно, подобная возможность сохранилась и в архитектуре Ampere. NVIDIA проанализировала данные вычисления в конвейере рендеринга в десятках игр, обнаружив, что на каждые 100 расчетов FP выполняется примерно треть вычислений INT. Впрочем, значение среднее, на практике оно меняется от 20% до 50%. Конечно, если вычисления FP и INT будут выполняться одновременно, то конвейеру придется иногда «подтормаживать» в случае взаимных связей.

Соотношение 1/3 INT32 и 2/3 FP32 отражено в структуре Ampere Streaming Multiprocessor (SM), составляющем элементе архитектуры Ampere. NVIDIA удвоила число вычислительных блоков FP32 на каждый SM. Вместо 64 блоков FP32 на SM, их теперь насчитывается 128. Плюс 64 блока INT32. Теперь на квадрант SM насчитывается два пути данных, некоторые могут работать параллельно. Один из путей данных содержит 16 блоков FP32, то есть может выполнять 16 вычислений FP32 за такт. Второй путь данных содержит по 16 блоков FP32 и INT32. Каждый из квадрантов SM может выполнять либо 32 операции FP32, либо по 16 операций FP32 и INT32 за такт. Если же брать SM целиком, то возможно выполнение 128 операций FP32 или по 64 операции FP32 и INT32 за такт.

Параллельное выполнение продолжается и на других блоках. Например, ядра RT и Tensor могут работать параллельно в конвейере рендеринга, что снижает время, требующееся на рендеринг кадра.

Под термином «потоковые процессоры» сегодня подразумевают количество вычислительных блоков GPU, хотя следует помнить, что сложность вычислений бывает разной. Поэтому термин используется гибко, но обычно все равно описывает вычислительные блоки.

Текстурные блоки

Действительно, для рендеринга объекта простых текстур уже недостаточно, использование нескольких слоев позволяет, например, получить 3D-эффект вместо плоской текстуры. Раньше объекты приходилось рассчитывать на конвейере несколько раз, и каждый проход текстурный блок накладывал текстуру, сегодня достаточно одного процесса рендеринга, текстурный блок может получать данные объекта для многократной обработки из буфера.

Контроллер памяти

Помимо изменений в SM, новая архитектура NVIDIA получила оптимизированную структуру конвейеров растровых операций (ROP), а также соединения ROP и контроллера памяти. До поколения Turing ROP всегда подключались к интерфейсу памяти. И на каждый 32-битный контроллер памяти приходилось восемь ROP. Если число контроллеров памяти и ширина шины менялись, то же самое касалось и ROP. В архитектуре Ampere ROP перенесены в GPC. Используются два раздела ROP на GPC, каждый раздел содержит восемь ROP.

Что дает иную формулу вычисления ROP на GeForce RTX 3080. Шесть GPC с 2x 8 ROP на каждом дают 96 ROP. У GeForce RTX 3090 работают семь GPC с 2x 8 ROP, что дает 112 ROP. NVIDIA намеренно интегрировала ROP глубже, чтобы задняя часть конвейера рендеринга меньше зависела от интерфейса памяти. Например, видеокарта GeForce RTX 3080 использует 320-битный интерфейс памяти, но содержит 96 ROP, а не 80 ROP.

Интерфейс памяти разделен на 32-битные блоки. В зависимости от желаемой ширины интерфейса памяти или емкости, их можно набирать в произвольном количестве.

Ядра Tensor и RT

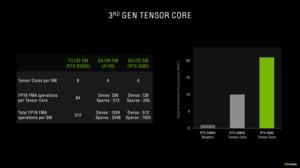

Ядра Tensor третьего поколения

С архитектурой Turing NVIDIA представила два новых вычислительных блока, ранее на GPU не использовавшихся. Конечно, ядра Tensor знакомы нам по архитектуре Volta, но там они использовались для научных расчетов. В случае GPU Ampere ядра Tensor перешли уже на третье поколение.

Ядра Tensor ранее использовались только для вычислений INT16 и FP16, но в третьем поколении они могут работать с FP32 и FP64. Что особенно важно для сегмента HPC с высокой точностью. Для игровых GPU GeForce намного важнее меньшая точность.

Ядра Tensor архитектуры Turing могут выполнять 64 операции FP16 Fused Multiply-Add (FMA) каждое. В случае Ampere число операций увеличено до 128 у GA102 GPU и до 256 у GA100 GPU с плотными матрицами. Если же используются разреженные матрицы, число операций FMA FP16 увеличивается до 256 у GA102 GPU и до 512 у GA100 GPU. Ядра Tensor архитектуры Turing разреженные матрицы не поддерживают.

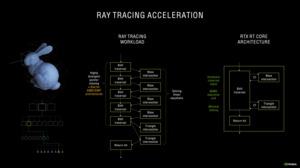

Ядра RT второго поколения

Все они опираются на тот принцип, что удаленные от луча примитивы не могут с ним пересекаться. Следовательно, и смысла их просчитывать нет. Число лучей на сценах растет экспоненциально, поэтому на каждый луч следует обрабатывать как можно меньшее число примитивов, чтобы не увеличивать вычислительную нагрузку.

Поскольку NVIDIA не изменила число ядер RT на SM в архитектуре Ampere, количество блоков SM на GPU по-прежнему определяет производительность RT. Но в ядрах RT есть другие оптимизации.

Одна из проблем с расчетом пересечений при трассировке лучей связана с движущимися объектами, особенно если используется эффект размытия движения (motion blur). Для ядер RT в архитектуре Turing такой сценарий является «узким местом». Но второе поколение ядер RT уже лучше справляется с интерполяцией эффекта размытия движения. Пересечения просчитываются с упреждением, в итоге трассировка лучей рассчитываются только для тех областей, где она необходима.

Кэши L1 и L2

Между функциональными блоками (потоковые процессоры, ядра RT и Tensor) и видеопамятью располагаются еще два уровня хранения данных, без которых GPU не смог бы выдавать высокий уровень производительности. Цель этих кэшей заключается в том, чтобы хранить информацию как можно ближе к функциональным блокам. Данные передаются из видеопамяти сначала в кэш L2, а затем и в кэш L1.

NVIDIA с архитектурой Ampere вновь увеличила кэш L1 с 96 до 128 кбайт. Скорость работы L1 была вновь удвоена. NVIDIA реализовала такую же меру ранее при переходе с Pascal на Turing. Число 32-битных регистров не изменилось и осталось на уровне 16.384. То же самое касается числа блоков чтения/записи.