San switch что это

Сеть хранения данных

Storage Area Network, SAN

Сеть хранения данных (SAN) — представляет собой архитектурное решение для подключения внешних устройств хранения данных, таких как дисковые массивы, ленточные библиотеки, оптические накопители к серверам таким образом, чтобы операционная система распознала подключённые ресурсы, как локальные. Построение сети SAN решает проблемы снижения совокупной стоимости владения системой хранения данных, а также предоставляет инструменты для организации надежного хранения информации.

Содержание

В простейшем случае SAN состоит из СХД, коммутаторов и серверов, объединённых оптическими каналами связи. Помимо непосредственно дисковых СХД в SAN можно подключить дисковые библиотеки, ленточные библиотеки (стримеры), устройства для хранения данных на оптических дисках (CD/DVD и прочие) и др.

Пример высоконадёжной инфраструктуры, в которой серверы включены одновременно в локальную сеть (слева) и в сеть хранения данных (справа). Такая схема обеспечивает доступ к данным, находящимся на СХД, при выходе из строя любого процессорного модуля, коммутатора или пути доступа.

Использование SAN позволяет обеспечить:

История

Развитие сетевых технологий привело к появлению двух сетевых решений для СХД – сетей хранения Storage Area Network (SAN) для обмена данными на уровне блоков, поддерживаемых клиентскими файловыми системами, и серверов для хранения данных на файловом уровне Network Attached Storage (NAS). Чтобы отличать традиционные СХД от сетевых был предложен еще один ретроним – Direct Attached Storage (DAS).

Появлявшиеся на рынке последовательно DAS, SAN и NAS отражают эволюционирующие цепочки связей между приложениями, использующими данные, и байтами на носителе, содержащим эти данные. Когда-то сами программы-приложения читали и писали блоки, затем появились драйверы как часть операционной системы. В современных DAS, SAN и NAS цепочка состоит из трех звеньев: первое звено – создание RAID-массивов, второе – обработка метаданных, позволяющих интерпретировать двоичные данные в виде файлов и записей, и третье – сервисы по предоставлению данных приложению. Они различаются по тому, где и как реализованы эти звенья. В случае с DAS СХД является «голой», она только лишь предоставляет возможность хранения и доступа к данным, а все остальное делается на стороне сервера, начиная с интерфейсов и драйвера. С появлением SAN обеспечение RAID переносится на сторону СХД, все остальное остается так же, как в случае с DAS. А NAS отличается тем, что в СХД переносятся к тому же и метаданные для обеспечения файлового доступа, здесь клиенту остается только лишь поддерживать сервисы данных.

Появление SAN стало возможным после того, как в 1988 году был разработан протокол Fibre Channel (FC) и в 1994 утвержден ANSI как стандарт. Термин Storage Area Network датируется 1999 годом. Со временем FC уступил место Ethernet, и получили распространение сети IP-SAN с подключением по iSCSI.

Идея сетевого сервера хранения NAS принадлежит Брайану Рэнделлу из Университета Ньюкэстла и реализована в машинах на UNIX-сервере в 1983 году. Эта идея оказалась настолько удачной, что была подхвачена множеством компаний, в том числе Novell, IBM, и Sun, но в конечном итоге сменили лидеров NetApp и EMC.

В 1995 Гарт Гибсон развил принципы NAS и создал объектные СХД (Object Storage, OBS). Он начал с того, что разделил все дисковые операции на две группы, в одну вошли выполняемые более часто, такие как чтение и запись, в другую более редкие, такие как операции с именами. Затем он предложил в дополнение к блокам и файлам еще один контейнер, он назвал его объектом.

OBS отличается новым типом интерфейса, его называют объектным. Клиентские сервисы данных взаимодействуют с метаданными по объектному API (Object API). В OBS хранятся не только данные, но еще и поддерживается RAID, хранятся метаданные, относящиеся к объектам и поддерживается объектный интерфейс. DAS, и SAN, и NAS, и OBS сосуществуют во времени, но каждый из типов доступа в большей мере соответствует определенному типу данных и приложений.

Подробнее об эволюции СХД читайте здесь.

Архитектура SAN

Топология сети

SAN является высокоскоростной сетью передачи данных, предназначенной для подключения серверов к устройствам хранения данных. Разнообразные топологии SAN (точка-точка, петля с арбитражной логикой (Arbitrated Loop) и коммутация) замещают традиционные шинные соединения «сервер — устройства хранения» и предоставляют по сравнению с ними большую гибкость, производительность и надежность. В основе концепции SAN лежит возможность соединения любого из серверов с любым устройством хранения данных, работающим по протоколу Fibre Channel. Принцип взаимодействия узлов в SAN c топологиями точка-точка или коммутацией показан на рисунках. В SAN с топологией Arbitrated Loop передача данных осуществляется последовательно от узла к узлу. Для того, чтобы начать передачу данных передающее устройство инициализирует арбитраж за право использования среды передачи данных (отсюда и название топологии – Arbitrated Loop).

О сетях хранения данных

Решил написать небольшую статейку о сетях хранения данных (СХД), тема эта достаточно интересная, но на Хабре почему-то не раскрыта. Постараюсь поделиться личным опытом по построению и поддержке SAN.

Что это?

Сеть хранения данных, или Storage Area Network — это система, состоящая из собственно устройств хранения данных — дисковых, или RAID — массивов, ленточных библиотек и прочего, среды передачи данных и подключенных к ней серверов. Обычно используется достаточно крупными компаниями, имеющими развитую IT инфраструктуру, для надежного хранения данных и скоростного доступа к ним.

Упрощенно, СХД — это система, позволяющая раздавать серверам надежные быстрые диски изменяемой емкости с разных устройств хранения данных.

Немного теории.

Сервер к хранилищу данных можно подключить несколькими способами.

Первый и самый простой — DAS, Direct Attached Storage (прямое подключение), без затей ставим диски в сервер, или массив в адаптер сервера — и получаем много гигабайт дискового пространства со сравнительно быстрым доступом, и при использовании RAID-массива — достаточную надежность, хотя копья на тему надежности ломают уже давно.

Однако такое использование дискового пространства не оптимально — на одном сервере место кончается, на другом его еще много. Решение этой проблемы — NAS, Network Attached Storage (хранилище, подключенное по сети). Однако при всех преимуществах этого решения — гибкости и централизованного управления — есть один существенный недостаток — скорость доступа, еще не во всех организациях внедрена сеть 10 гигабит. И мы подходим к сети хранения данных.

Главное отличие SAN от NAS (помимо порядка букв в аббревиатурах) — это то, каким образом видятся подключаемые ресурсы на сервере. Если в NAS ресурсы подключаются протоколам NFS или SMB, в SAN мы получаем подключение к диску, с которым можем работать на уровне операций блочного ввода-вывода, что гораздо быстрее сетевого подключения (плюс контроллер массива с большим кэшем добавляет скорости на многих операциях).

Используя SAN, мы сочетаем преимущества DAS — скорость и простоту, и NAS — гибкость и управляемость. Плюс получаем возможность масштабирования систем хранения до тех пор, пока хватает денег, параллельно убивая одним выстрелом еще несколько зайцев, которых сразу не видно:

* снимаем ограничения на дальность подключения SCSI-устройств, которые обычно ограничены проводом в 12 метров,

* уменьшаем время резервного копирования,

* можем грузиться с SAN,

* в случае отказа от NAS разгружаем сеть,

* получаем большую скорость ввода-вывода за счет оптимизации на стороне системы хранения,

* получаем возможность подключать несколько серверов к одному ресурсу, то нам дает следующих двух зайцев:

o на полную используем возможности VMWare — например VMotion (миграцию виртуальной машины между физическими) и иже с ними,

o можем строить отказоустойчивые кластеры и организовывать территориально распределенные сети.

Что это дает?

Помимо освоения бюджета оптимизации системы хранения данных, мы получаем, вдобавок к тому что я написал выше:

* увеличение производительности, балансировку нагрузки и высокую доступность систем хранения за счет нескольких путей доступа к массивам;

* экономию на дисках за счет оптимизации расположения информации;

* ускоренное восстановление после сбоев — можно создать временные ресурсы, развернуть на них backup и подключить к ним сервера, а самим без спешки восстанавливать информацию, или перекинуть ресурсы на другие сервера и спокойно разбираться с умершим железом;

* уменьшение время резервного копирования — благодаря высокой скорости передачи можно бэкапиться на ленточную библиотеку быстрее, или вообще сделать snapshot (мгновенный снимок) с файловой системы и спокойно архивировать его;

* дисковое место по требованию — когда нам нужно — всегда можно добавить пару полок в систему хранения данных.

* уменьшаем стоимость хранения мегабайта информации — естественно, есть определенный порог, с которого эти системы рентабельны.

* надежное место для хранения mission critical и business critical данных (без которых организация не может существовать и нормально работать).

* отдельно хочу упомянуть VMWare — полностью все фишки вроде миграции виртуальных машин с сервера на сервер и прочих вкусностей доступны только на SAN.

Из чего это состоит?

Как я писал выше — СХД состоит из устройств хранения, среды передачи и подключенных серверов. Рассмотрим по порядку:

Системы хранения данных обычно состоят из жестких дисков и контроллеров, в уважающей себя системе как правило всего по 2 — по 2 контроллера, по 2 пути к каждому диску, по 2 интерфейса, по 2 блока питания, по 2 администратора. Из наиболее уважаемых производителей систем следует упомянуть HP, IBM, EMC и Hitachi. Тут процитирую одного представителя EMC на семинаре — «Компания HP делает отличные принтеры. Вот пусть она их и делает!» Подозреваю, что в HP тоже очень любят EMC. Конкуренция между производителями нешуточная, впрочем, как и везде. Последствия конкуренции — иногда вменяемые цены за мегабайт системы хранения и проблемы с совместимостью и поддержкой стандартов конкурентов, особенно у старого оборудования.

Среда передачи данных. Обычно SAN строят на оптике, это дает на текущий момент скорость в 4, местами в 8 гигабит на канал. При построении раньше использовались специализированные хабы, сейчас больше свитчи, в основном от Qlogic, Brocade, McData и Cisco (последние два на площадках не видел ни разу). Кабели используются традиционные для оптических сетей — одномодовые и многомодовые, одномодовые более дальнобойные.

Внутри используется FCP — Fibre Channel Protocol, транспортный протокол. Как правило внутри него бегает классический SCSI, а FCP обеспечивает адресацию и доставку. Есть вариант с подключением по обычной сети и iSCSI, но он обычно использует (и сильно грузит) локальную, а не выделенную под передачу данных сеть, и требует адаптеров с поддержкой iSCSI, ну и скорость помедленнее, чем по оптике.

Есть еще умное слово топология, которое встречается во всех учебниках по SAN. Топологий несколько, простейший вариант — точка-точка (point to point), соединяем между собой 2 системы. Это не DAS, а сферический конь в вакууме простейший вариант SAN. Дальше идет управляемая петля (FC-AL), она работает по принципу «передай дальше» — передатчик каждого устройства соединен с приемником последующего, устройства замкнуты в кольцо. Длинные цепочки имеют свойство долго инициализироваться.

Ну и заключительный вариант — коммутируемая структура (Fabric), она создается с помощью свитчей. Структура подключений строится в зависимости от количества подключаемых портов, как и при построении локальной сети. Основной принцип построения — все пути и связи дублируются. Это значит, что до каждого устройства в сети есть минимум 2 разных пути. Здесь тоже употребимо слово топология, в смысле организации схемы подключений устройств и соединения свитчей. При этом как правило свитчи настраиваются так, что сервера не видят ничего, кроме предназначенных им ресурсов. Это достигается за счет создания виртуальных сетей и называется зонированием, ближайшая аналогия — VLAN. Каждому устройству в сети присваивается аналог MAC-адреса в сети Ethernet, он называется WWN — World Wide Name. Он присваивается каждому интерфейсу и каждому ресурсу (LUN) систем хранения данных. Массивы и свитчи умеют разграничивать доступ по WWN для серверов.

А дальше на системах хранения нарезаются ресурсы, они же диски (LUN) для каждого сервера и оставляется место в запас, все включается, установщики системы прописывают топологию, ловят глюки в настройке свитчей и доступа, все запускается и все живут долго и счастливо*.

Я специально не касаюсь разных типов портов в оптической сети, кому надо — тот и так знает или прочитает, кому не надо — только голову забивать. Но как обычно, при неверно установленном типе порта ничего работать не будет.

Из опыта.

Обычно при создании SAN заказывают массивы с несколькими типами дисков: FC для скоростных приложений, и SATA или SAS для не очень быстрых. Таким образом получаются 2 дисковые группы с различной стоимостью мегабайта — дорогая и быстрая, и медленная и печальная дешевая. На быструю вешаются обычно все базы данных и прочие приложения с активным и быстрым вводом-выводом, на медленную — файловые ресурсы и все остальное.

Если SAN создается с нуля — имеет смысл строить ее на основе решений от одного производителя. Дело в том, что, несмотря на заявленное соответствие стандартам, существуют подводные грабли проблемы совместимости оборудования, и не факт, что часть оборудования будет работать друг с другом без плясок с бубном и консультаций с производителями. Обычно для утряски таких проблем проще позвать интегратора и дать ему денег, чем общаться с переводящими друг на друга стрелки производителями.

Если SAN создается на базе существующей инфраструктуры — все может быть сложно, особенно если есть старые SCSI массивы и зоопарк старой техники от разных производителей. В этом случае имеет смысл звать на помощь страшного зверя интегратора, который будет распутывать проблемы совместимости и наживать третью виллу на Канарах.

Часто при создании СХД фирмы не заказывают поддержку системы производителем. Обычно это оправдано, если у фирмы есть штат грамотных компетентных админов (которые уже 100 раз назвали меня чайником) и изрядный капитал, позволяющий закупить запасные комплектующие в потребных количествах. Однако компетентных админов обычно переманивают интеграторы (сам видел), а денег на закупку не выделяют, и после сбоев начинается цирк с криками «Всех уволю!» вместо звонка в саппорт и приезда инженера с запасной деталью.

Поддержка обычно сводится к замене умерших дисков и контроллеров, ну и к добавлению в систему полок с дисками и новых серверов. Много хлопот бывает после внезапной профилактики системы силами местных специалистов, особенно после полного останова и разборки-сборки системы (и такое бывает).

Про VMWare. Насколько я знаю (спецы по виртуализации поправьте меня), только у VMWare и Hyper-V есть функционал, позволяющий «на лету» перекидывать виртуальные машины между физическими серверами. И для его реализации требуется, чтобы все сервера, между которыми перемещается виртуальная машина, были подсоединены к одному диску.

Про кластеры. Аналогично случаю с VMWare, известные мне системы построения отказоустойчивых кластеров (Sun Cluster, Veritas Cluster Server) — требуют подключенного ко всем системам хранилища.

Пока писал статью — у меня спросили — в какие RAIDы обычно объединяют диски?

В моей практике обычно делали или по RAID 1+0 на каждую дисковую полку с FC дисками, оставляя 1 запасной диск (Hot Spare) и нарезали из этого куска LUN-ы под задачи, или делали RAID5 из медленных дисков, опять же оставляя 1 диск на замену. Но тут вопрос сложный, и обычно способ организации дисков в массиве выбирается под каждую ситуацию и обосновывается. Та же EMC например идет еще дальше, и у них есть дополнительная настройка массива под приложения, работающие с ним (например под OLTP, OLAP). С остальными вендорами я так глубоко не копал, но догадываюсь, что тонкая настройка есть у каждого.

* до первого серьезного сбоя, после него обычно покупается поддержка у производителя или поставщика системы.

Поскольку в песочнице комментариев нет, закину в личный блог.

Коммутация SAN

SAN Коммутаторы (SAN switches)

SAN коммутаторы используются в качестве центрального коммутирующего устройства для узлов сети SAN. Вы вставляете один конец оптического кабеля в разъем на адаптере вашего сервера или контроллере дискового массива, а другой в порт на коммутаторе. Коммутатор можно сравнить с набором проводов, которые скроссированы таким образом, чтобы позволить каждому устройству сети «говорить» по одному проводу с любым другим устройством сети одновременно. Т.е, иными словами все абоненты могут разговаривать одновременно.

Один или несколько коммутаторов, соединенных между собой образуют фабрику. Одна фабрика может состоять из одного или нескольких коммутаторов (до 239 в настоящее время). Поэтому, фабрику можно определить как сеть, состоящую из соединенных между собой коммутаторов. SAN может состоять из нескольких фабрик. Большинство SAN состоит по крайне мере из двух фабрик, одна из которых является резервной.

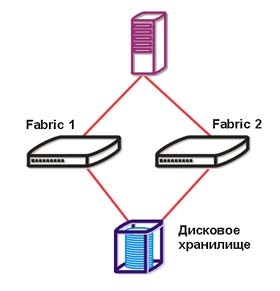

Вы можете подключить серверы и хранилища к SAN используя один коммутатор, но правилом хорошего тона является использование двух коммутаторов, дабы избежать потерю данных и простои при выходе из строя одного из них. На рисунке 1 показана обычная фабрика, использующая два коммутатора для соединения серверов с дисковым массивом.

Рис 1. Простейшая фабрика с использованием 2-х коммутаторов.

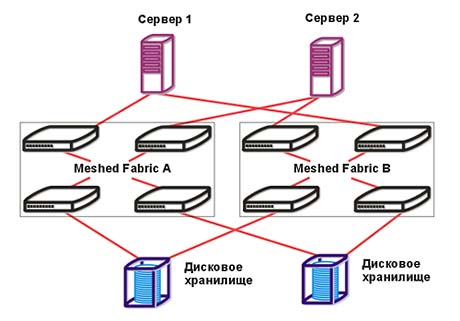

С увеличением количества серверов и хранилищ в вашей SAN вы просто добавляете коммутаторы.

Рис 2. Расширение SAN Fabric

Модульные или обычные коммутаторы (modular switches)

SAN коммутаторы бывают на любой вкус от 8 до сотен портов. Большинство модульных коммутаторов поставляется с 8 или 16 портами. Последним веянием является возможность наращивать количество портов на приобретенном коммутаторе с инкрементом 4. Типичным примером такого коммутатора может служить Qlogic SANbox 5200 (рис. 3). Этот продукт вы можете приобрести с 8-ю портами в базе, и наращивать затем до 16 в одном модуле и до 64 портов (!) в четырех модулях, соединяемых между собой 10 гигабитным FC.

Директоры или коммутаторы класса предприятия (director switches)

Директоры на много дороже модульных коммутаторов и обычно содержат сотни портов (рис. 4). Директоры можно увидеть в центре очень больших коммутированных фабрик в качестве ядра сети. Директоры обладают исключительной отказоустойчивостью и поддерживают работоспособность всей инфраструктуры 24 часа в сутки, 7 дней в неделю. Они позволяют осуществлять регламентные работы и замену модулей «на лету».

Рис. 4. SilkWorm 1200 128 port и McData InterPid 6140

Директор состоит из платформы, модулей портов горячей замены (обычно 12 или 16 портов) и процессорных модулей горячей замены (обычно двухпроцессорных). Директор можно приобрести с 32 портами и наращивать его до 128 – 140 портов.

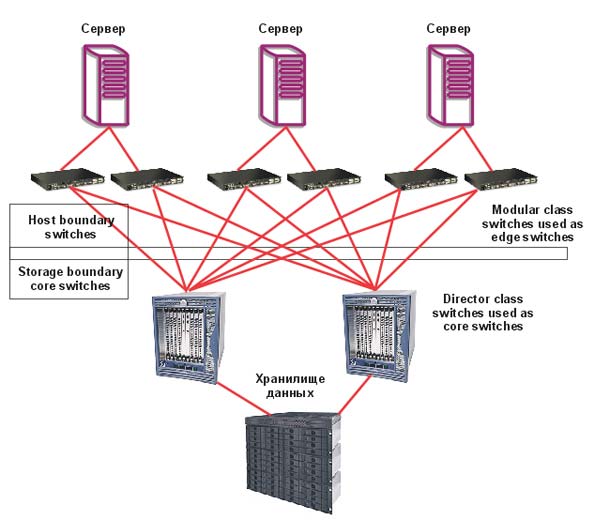

В корпоративных сетях SAN обычно используют директоры в качестве ядра сети. К ним подключают модульные коммутаторы в качестве оконечных (граничных) коммутаторов. К тем, в свою очередь подключают серверы и хранилища. Такая топология называется ядро-граница (core-to-edge topology) и позволяет масштабировать сеть до тысяч портов (рис. 5).

Рис. 5. Топология ядро-граница с использованием директоров.

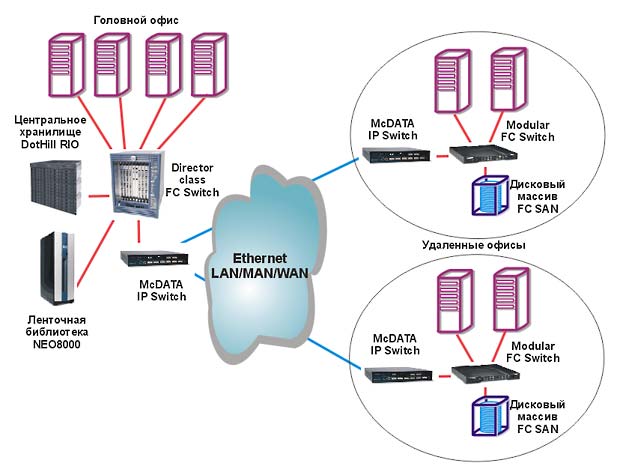

SAN маршрутизаторы или мультипротокльные коммутаторы (multiprotocol switches)

SAN маршрутизаторы служат для соединения удаленных островков SAN в единую сеть для решения задач защиты от катастроф, консолидации ресурсов хранения, организации процедур back-up данных удаленных подразделений на ленточные и дисковые ресурсы головного центра данных и т.д (рис 6.). Объединение удаленных сетей SAN в единый ресурс это следующий шаг в эволюции сетей хранения данных после внедрения SAN в головной структуре и подразделениях предприятий (рис. 7).

|  |  |

Рис. 6: McDATA Eclipse 1620, 3300 и 4300

Рис. 7: Объединение удаленных сетей SAN в единый ресурс

Островки SAN можно соединить, используя протокол FC и обычные модульные коммутаторы или директоры, через одномодовый оптический кабель (single mode cable или dark fiber) или же используя оборудование мультиплексирования (DWDM). Однако такой метод не позволит вам выйти за рамки города (радиус 70 км.). Для большего удаления понадобится протокол Fiber Channel over IP (FCIP, http://www.iscsistorage.com/ipstorage.htm), реализованный в маршрутизаторах Eclipse компании McData (рис. 6). FCIP «заворачивает» каждый кадр FC в пакет IP для транспорта через сеть IP. Принимающая сторона распаковывает пакет IP и достает оттуда оригинальный кадр FC для дальнейшей передачи уже по локальной сети FC. Здесь расстояния не ограничены. Все дело лишь в скорости вашего канала IP.

Типы FC кабелей

В качестве физической среды передачи данных в сетях FC используют оптоволоконный или медный кабель. Медный кабель представляет собой витую пару в оболочке и использовался в основном для местных подключений в сетях FC 1Gbit/s. В современных сетях FC 2Gbit/s в основном используется оптоволоконный кабель.

Существует два вида оптоволоконного кабеля: одномодовый и многомодовый.

Одномодовый кабель (long wave)

В одномодовом кабеле (SM) существует единственный путь распространения световой волны. Размер сердцевины (core size) обычно составляет 8.3 мк. Одномодовые кабели используются в устройствах, в которых требуется низкий уровень исчезновения (потери) сигнала и высокая скорость передачи данных, например на больших интервалах между двумя системами или сетевыми устройствами. Например, между сервером и хранилищем, расстояние между которыми, несколько десятков километров.

Максимальное расстояние между двумя узлами сети FC 2Gbit, соединенных одномодовым кабелем 80км без повторителей.

Многомодовый кабель (short wave)

Многомодовый кабель (MM) способен передавать по одному волокну несколько световых волн, так как относительно большой размер сердцевины позволяет свету распространяться под различными углами (рефракция). Типичными размерами сердцевины для MM являются 50 мк и 62.5 мк. Многомодовые волоконные соединения лучше всего подходят для устройств, работающих на небольших расстояниях. Внутри офиса, здания.

Максимальное расстояние на которое многомодовый кабель поддерживает скорость 2 Gbit/s – 300 (50um) и 150м (62,5 um).

Типы разъемов FC кабелей (Cable connector types)

Разъемы FC кабелей бывают:

Типы трансиверов (GBIC types)

| |

| SFP-LC | HSSDC2 |

HSSDC2: для 1/2Gbit FC для медного кабеля

SFP-LC: (Small Form Factor Pluggable LC) 1/2Gbit FC Short/Long wave для оптоволоконного кабеля с LC коннектором

SFP-SC: (Small Form Factor Pluggable SC) 1/2Gbit FC Short/Long wave для оптоволоконного кабеля с SC коннектором

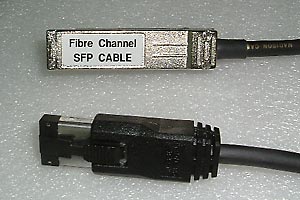

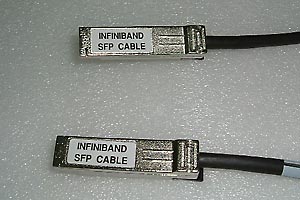

Кабели с трансиверами

Ряд производителей поставляют кабели уже с трансивером на конце

|  |

| Кабель HSSDC2-SFP | Кабель SFP-SFP |

Типы портов в SAN

Все FC порты на хосте или хранилище называются N_Ports, что означает Node Ports. Несколько сложнее обстоит дело с портами на коммутаторе. Режим работы порта коммутатора меняется в зависимости от того, какое устройство к нему подключено. Он бывает G_Port (Global Port) если к нему ничего не подключено. F_Port (Fabric Port), если к нему подключен хост или хранилище. E_Port (Expansion Port), если к нему подключен порт другого коммутатора (рис 10.)