Screaming frog seo spider что это

Screaming Frog SEO Spider

Очень часто я сталкивалась с тем, что несмотря на наличие огромного количества статей и пособий по использованию Screaming Frog SEO Spider, все равно остается очень много вопросов по парсингу этим инструментом.

Поэтому я решила написать короткую инструкцию, рассказывающую как пользоваться данной программой. И, как и раньше, я не буду рассказывать голую теорию. Сразу поясню, это не полный и раскрытый обзор инструмента. В видео и этой статье будет описано только самое базовое и основное. Также в конце будет небольшой подарочек от меня.

Инструкция по использованию Скримин Фрог

Итак, чтобы начать проводить анализ по Screaming Frog, нам необходимо зайти в него и добавить туда сайт.

Инструмент условно делится на 3 поля. У каждого из них своя задача:

После того как мы разбили на условных три поля наш экран, пора приступать к выявлению ошибок, на которые указывает SF (Screaming Frog). Я подробно рассмотрю все три поля на одном примере, который разобью на 3 шага, и дальше их надо будет применять каждый раз.

ШАГ 1: ОПРЕДЕЛЕНИЕ ОШИБКИ

Приведу пример на одном пункте. И аналогично его можно будет применять на другие.

Ищем в первом поле блок «External». В нем нас интересует строка «HTML». Данная строка показывает количество ресурсов (сторонних сайтов), на которые ссылается наш сайт и тем самым отдает свой вес. Исходящие ссылки необходимо удалять или закрывать (не бездумно. Есть ситуации, когда этого делать не стоит). В случае скрина, мы видим, что на сайте есть 9 исходящих ссылок.

ШАГ 2: ПОИСК МЕСТА ОШИБКИ

Итак, мы нашли, что у нас 9 исходящих ссылок. Теперь нам нужно определить что это за ссылки. Для этого нажимаем на саму строку «HTML» и начинаем смотреть во второе поле. По изображению видим, что у нас 9 ссылок:

ШАГ 3: СБОР ИНФОРМАЦИИ

В поле 2 видим 9 ссылок, которые есть на нашем сайте. Чтобы подробнее понять, где именно они находятся, нажимаем в поле два на каждую из них по очереди. В поле 3 появляется информация о данной ссылке. Нажимаем вкладку «Inlinks». В данной вкладке можно увидеть список страниц, на которых находится данная ссылка. После обнаружения нужно перейти на эти страницы и закрыть ссылку nofollow или удалить ее.

Какие ошибки смотреть в Скриминг Фрог СЕО Спайдер?

Теперь вы знаете как находить ошибки и их расположение. Осталось узнать какие ошибки в принципе выявлять на сайте с помощью Screaming Frog:

Конечно, это далеко не все, что можно и нужно смотреть при работе со Скримин Фрогом. Но это база, которая, надеюсь, разложит по полочкам основы использования программы. И, как и обещала, маленький подарочек — username и ключ от cкримин фрога на год.

Screaming Frog SEO Spider: анализ результатов парсинга

Успешный аудит сайта — это фундамент оптимизации SEO. В этой статье разберем инструмент для проведения технического SEO-аудита сайта Screaming Frog. Рассмотрим возможности программы, которыми чаще всего пользуюсь при аудите сайта.

Начнем с загрузки программы.

Скачать Screaming Frog можно на официальном сайте www.screamingfrog.co.uk Программа бесплатная, но за полный функционал придется заплатить. Бесплатная версия включает скриминг 500 Urls и не поддерживает дополнительные расширения.

За годовую подписку на расширенную версию придется потратить около 6 тыс. грн. Если вы SEO-специалист, эта программа must-have на “Рабочем столе”, она существенно облегчит и ускорит сбор и анализ технических недочетов сайта.

Разбор функционала, которым чаще всего пользуюсь.

Скриминг фрог позволяет сканировать сайт несколькими способами:

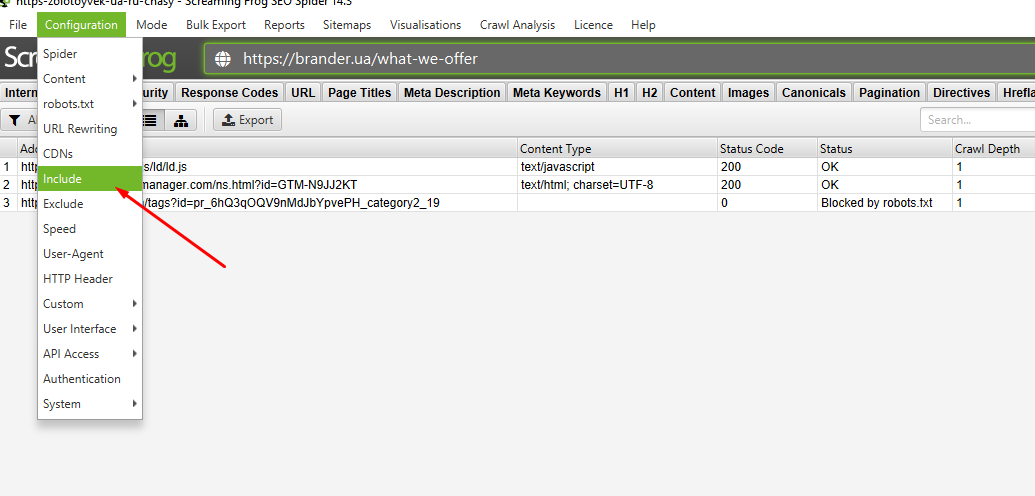

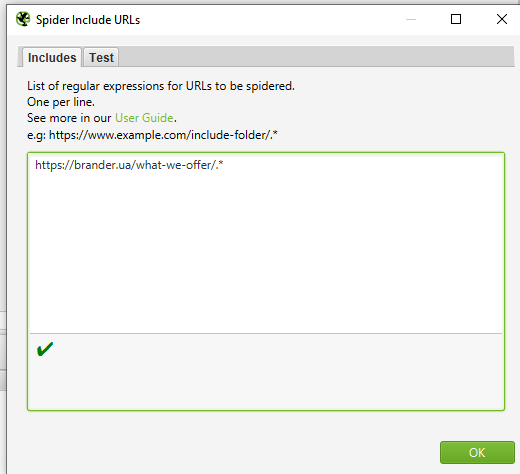

Есть задача спарсить раздел сайта brander.ua/what-we-offer. Для этого я добавляю правило в Configuration — Include.

Затем с помощью регулярного выражения (синтаксис указан в окне) ввожу нужный для сканирования раздел.

Старт и вуаля. Мы просканировали только отдельную категорию на сайте. Бывают ситуации, когда необходимые для сканирования страницы не лежат в какой-либо вложенности, а просканировать сайт полностью нет возможности по ряду причин (объем сайта, ломаный js и тд.). Тогда действуем от обратного. Можно внести в исключения Extend все категории, что существенно уменьшит количество урлов, и успешно спарсить остаток.

Перед началом сканирования сайта рекомендую подключить аналитику, что позволит не делать отдельных анализов по всем сервисам, а выгрузить все и сразу. Доступна аналитика по Google Analytics, Search Console, Moz, Pagespeed, Ahrefs, Majestiks. Это можно сделать с помощью вкладки Configuration — API Access.

Screaming Frog SEO Spider

Регулярный аудит сайта – это неизменная часть работы любого оптимизатора. Один из наиболее удобных инструментов для этого – эта программа. Разберемся, как в ней работать.

Достаточно долго одним из лидеров в области аудита сайтов был такой инструмент, как Xenu, однако несколько лет назад к нему в компанию добавилось другое полезное приложение – Screaming Frog SEO Spider, о котором и пойдет речь в этой статье.

Программу разработал опытный британский сеошник; она существует как в бесплатном, так и в платном варианте. Естественно, бесплатная версия отличается несколько меньшим функционалом, а также ограничением на количество страниц, которые можно отсканировать: не более 500. Поэтому для аудита крупного сайта предпочтительнее выбрать платную версию.

Основной функционал Screaming Frog SEO Spider

Останавливаться подробно на покупке и скачивании Скриминг СЕО Фрога мы не будем: для этого достаточно базовых умений компьютерного и интернет-пользователя. Вместо этого рассмотрим основной функционал seo frog, представленный последовательно во всех ее вкладках:

Internal. Как понятно из названия, вкладка посвящена внутренним ссылкам. Здесь можно получить ключевую информацию обо всех страницах сайта (их, при желании, можно отсортировать по алфавиту). Достаточно кликнуть по URL какой-либо страницы, чтобы увидеть достаточно подробные данные о ней. В разделах вкладки «in links» и «out links» можно просмотреть отдельные данные о входящих и исходящих ссылках соответственно, что поможет откорректировать внутриссылочный вес каждой страницы. Также можно получить информацию о расположенных на странице картинках, заголовках, мета-тегах, размере страницы в байтах, уровне ее вложенности по отношению к главной странице интернет-портала, и так далее.

External. Эта вкладка, напротив, посвящена внешним ссылкам. Она включает в себя полный список сайтов, на которые со станиц вашего ресурса ведут открытые ссылки. Для каждой из них можно узнать тип, кодировку, уровень вложенности соответствующей страницы и другие данные.

Response Codes. Здесь содержится информация обо всех редиректах сайта: адреса страниц, исходящих ссылок и, что самое важное, коды и статусы ответа веб-сервера. В контексте оптимизации сайта пристального внимания заслуживают страницы с кодами 404 (Not Found), 302 (Found) и 301 (Moved Permanently). Особенно важно грамотно настроить 301 редирект.

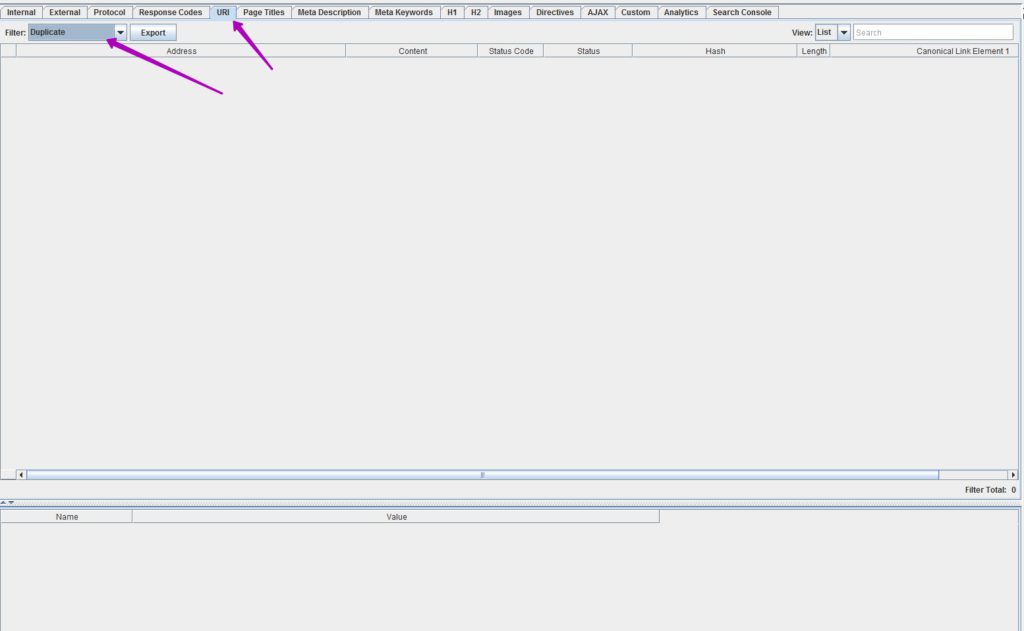

URI. Это отдельная вкладка, целиком и полностью посвященная «проблемным» страницам сайта. Их адреса могут попасть сюда по разным причинам: например, если в их названии присутствуют символы, которых нет в ASCII; если длина адреса превышает 115 символов; если адрес является динамическим; если страницы дублируются; и по ряду других. То, что какая-то страница попала на эту вкладку, еще не значит, что с ней гарантированно что-то не так – однако это повод лишний раз проверить ее и, при необходимости, внести корректировки.

Page Titles. Здесь собрана информация о тайтлах всех страниц сайта. Соответственно, тут можно узнать, на каких страницах не оказалось тайтлов (и добавить их, поскольку они крайне важны для продвижения); где тайтлы совпадают с H1 (что также лучше исправить); у каких страниц одинаковые тайтлы (и это, опять же, лучше откорректировать, сделав Title разных страниц уникальными); где размер тайтла выходит за пределы рекомендуемой длины в 60-70 символов.

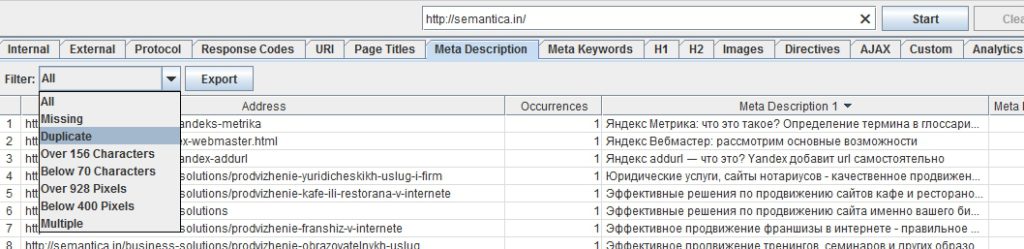

Meta Description. Суть вкладки примерно аналогична предыдущей, только здесь речь идет уже не о Title, а о Description всех страниц сайта. Тут так же можно узнать, на каких страницах нет мета-тега, на каких он чрезмерно длинный, на каких – дублируется с других страниц, и так далее, после чего принять необходимые меры.

Meta Keywords. Это то же самое, но для прописанных Keywords. Поскольку в нынешних реалиях прописывать их практически бессмысленно, эта вкладка не несет в себе особой ценности.

H По аналогии с несколькими предыдущими вкладками, здесь можно получить информацию об H1 всех страниц и откорректировать их, если где-то они слишком длинны, дублированы или вовсе отсутствуют.

H В этой вкладке можно посмотреть полный перечень заголовков второго уровня для каждой страницы и, опять же, наметить планы по их корректировке в случае необходимости.

Images. Здесь можно получить информацию обо всех изображениях, которые загружены на сайт, и их весе. Вкладка полезна в контексте ускорения загрузки интернет-портала, которой можно добиться благодаря оптимизации картинок.

Meta&Canonical. В этой вкладке можно, во-первых, просмотреть мета-теги robots для каждой страницы: это теги, которые позволяют или запрещают поисковым роботам индексировать страницу и использовать размещенные на ней ссылки. Здесь же можно получить информацию о канонических ссылках rel=canonical для всех страниц, то есть адресах, которые будут индексироваться при появлении дублей. Это также весьма существенная и периодически нуждающаяся в корректировке информация с точки зрения продвижения и оптимизации сайта.

Как сканировать сайт с помощью Screaming Frog SEO Spider?

Чтобы получить все перечисленные выше данные и возможность использовать их для оптимизации сайта, необходимо его просканировать в программе Screaming frog SEO Spider. Для этого достаточно ввести адрес сайта в соответствующее поле и нажать на кнопку «Start».

При этом важно знать, что все поддомены программа воспринимает как внешние ссылки. Поэтому в том случае, если вы хотите, чтобы они расценивались как часть основного ресурса, понадобится пометить галочкой пункт «Crawl All Subdomains» в разделе меню «Spider Configurations».

При помощи SEO Spider Tool можно сканировать не только весь сайт, но и какой-либо его раздел: для этого достаточно ввести его адрес в поле и нажать на кнопку «Start». В то же время, определенные разделы можно исключать из анализа: для этого нужно зайти в пункт меню «Configurations». В разделе «Exclude settings» этого пункта вы можете задать правила исключения конкретных разделов сайта из общего процесса сканирования.

Для удобства просмотра и использования результатов анализа сайта, полученных при помощи Screaming Frog SEO Spider, их можно преобразовать в более привычный и комфортный для восприятия Excel-формат. Чтобы это сделать, достаточно воспользоваться кнопкой «Export».

Создание Sitemap.XML

Файл Sitemap.XML должен лежать в корневой папке сайта и содержать подробную, точную информацию обо всех его страницах, датах их обновления и приоритетах просмотра. Он важен по многим причинам, и в первую очередь – для эффективной работы поисковых роботов. В этой связи особенно полезной представляется такая дополнительная функция программы Screaming Frog, как создание карты сайта. Для этого нужно воспользоваться пунктом меню «Sitemaps» после того, как вы просканируете весь интернет-портал. Во вкладке «Pages» можно будет добавить в карту дополнительные элементы (например, страницы, которые были закрыты от индексирования), после чего нажать на кнопку «Next».

Таким образом, Screaming Frog SEO Spider – это современный многофункциональный инструмент, который может дать оптимизатору практически всю необходимую информацию для успешной работы с сайтом.

Материал подготовила Светлана Сирвида-Льорентэ.

Технический аудит сайта с помощью Screaming Frog SEO spider

Очень не люблю долгие вступления. Да, и пришли вы сюда не за этим. Давайте сразу к делу: сегодня мы рассмотрим вопрос технического аудита сайта с помощью программы Screaming Frog SEO.

Как пользоваться Screaming Frog SEO Spider

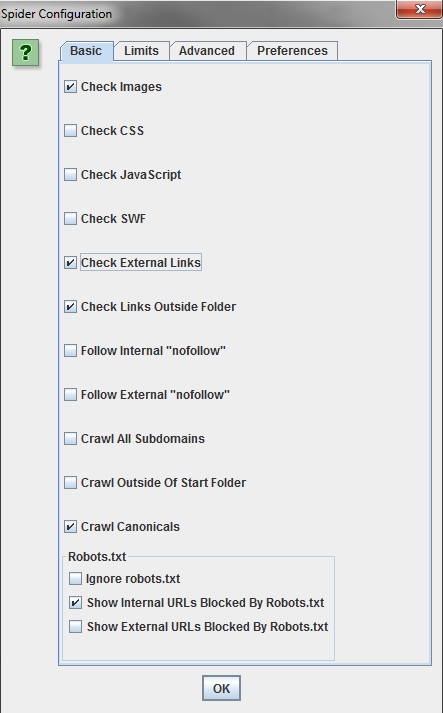

Basic

Чтобы ускорить анализ сайта, можно исключить из парсинга CSS стили, JavaScript, SWF (это проприетарный формат для флеш-анимации, векторной графики, видео и аудио в инете).

Limits

Тут нас интересует только Limit Search Depth — это настройка ограничения по вложенности страницы. Например, страницы больших сайтов с огромным количеством товаров в каталоге обычно имеют глубокую вложенность по url. Ставим подходящее нам ограничение и заметно экономим время.

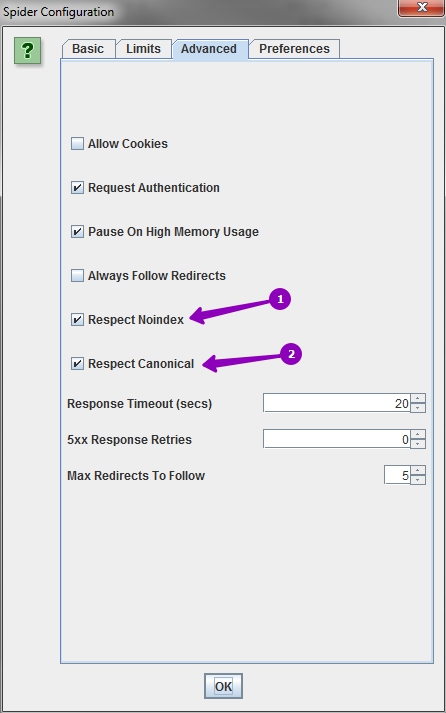

Advanced

Cтавим галочки так, как показано на скриншоте. Тем самым будем изучать только ту информацию, которую видят поисковые роботы.

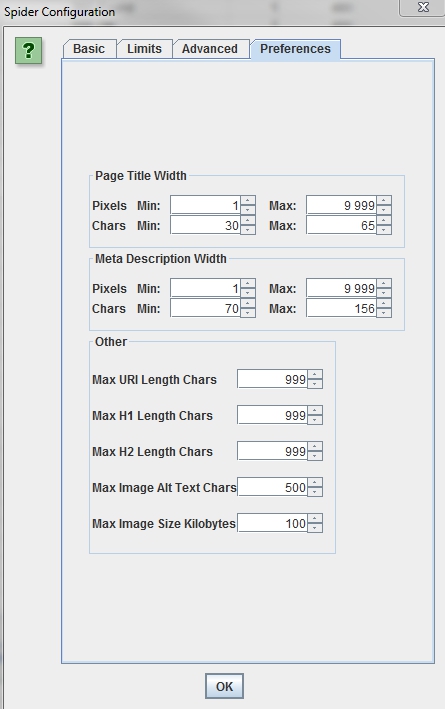

Preferences

Screaming SEO Frog предлагает указать пожелания по размеру метатегов, урла, заголовков h1/h2, длине атрибута alt и размера изображения. Можно указать большие значения, чтобы не упускать ничего.

Бывает, что необходимо проверить только определенные разделы или один, а может и наоборот — все, кроме некоторых или кроме одного. Чтобы проверить конкретные разделы, заходим в Configuration > Include, где указываем раздел. Если нужно исключить: Configuration > Exclude и аналагично указываем исключаемые разделы.

Если у вас новый сайт, который еще не готов к открытию (и админки как таковой еще нет), а провести технический аудит нужно — в SEO Screamig Frog можно указать логин и пароль. Чтобы не указывать админский доступ, можно создать ограниченный — гостевой

Если сайт закрыт в robots. txt, в настройках (вкладка Basic) необходимо включить опцию игнорирования данного файла.

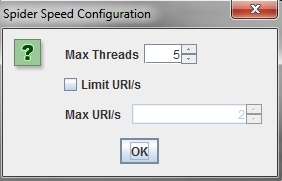

Скорость парсинга

Еще одна основная настройка SEO Frog. При запуске парсинга в самом низу указывается средняя скорость и текущая. Если сайт не выдерживает большой скорости, то лучше в настройках указать определенное значение.

Все настройки готовы и теперь можно приступить к старту парсинга сайта. В верхней части SEO Frog указываем сайт, нажимаем Start и ждем. Время ожидания зависит от размера сайта, в основном это от 5 до 25 минут.

Проверим качество парсинга

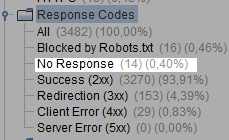

Переходим в правую часть программы и ищем Response Codes. Если в строке No Response слишком большое значение, то необходимо вернуться в настройки и понизить скорость парсинга. Тише едешь — дальше будешь.

Пример аудита сайта

Перед тем как приступить к работе, хочется дать небольшой совет. Каждую страницу из SEO Spider Frog можно выгружать и затем форматировать на свое усмотрение в Excel. В большинстве случаев это очень удобно: можно фильтровать и откидывать ненужную информацию. В данной статье мы разберем программу и информацию без выгрузки файлов, но суть от этого не меняется.

Итак, давайте из всей отчетной информации выберем самую важную.

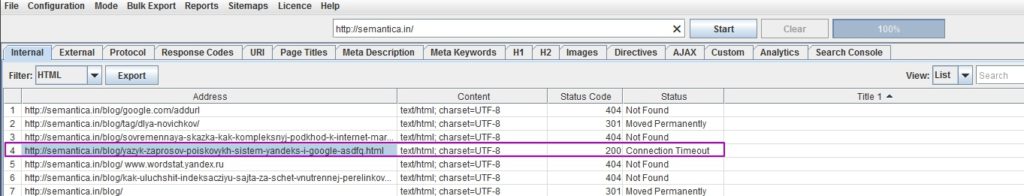

Проверка кодировки страниц

Выбираем вкладку Internal и в фильтре HTLM и глазами пробегаемся по столбцу Content. Везде должна быть кодировка UTF-8. Если она отличается, то следует посмотреть на код ответа сервера в соседней колонке. Например, если есть 301 редирект, значит все ок.

Проверяем мета-теги с помощью SEO Spider Screaming Frog

Данный пункт имеет большое значение. Сперва стоит проверить на всех ли страницах есть h1, title и description. Для этого находим нужный столбец, фильтруем его двойным нажатием на заголовок и смотрим результат. На скриншоте видно, что все страницы без мета-тега Title имеют код ответа сервера 404 или 301 редирект. За исключением одной страницы, но это ошибка при парсинге, т.к. если зайти на нее можно убедиться, что тайтл присутствует. Ошибки программа выдает крайне редко и 1 на 500 страниц не так и страшно, если ошибок много, то следует уменьшить в настройках скорость парсинга и перезапустить процесс.

Так можно проверить title, description, заголовки h1 и h2. Помимо наличия в соседней колонке указывается длина в символах и ширина в пикселях. Поэтому необходимо после проверки наличия мета-тегов проверить и их длину.

Также следует проверить одинаковые description, title и h1. Сделать это можно вручную: пробежать глазами по списку (если страниц немного) или во вкладке отфильтровать должным образом.

После проверки необходимо заполнить все мета-теги и сделать их уникальными в пределах ресурса. Данная процедура имеет немалое значение в SEO оптимизации сайта и весьма положительно влияет на место в выдаче.

Теперь перейдем к вопросу — как найти дубли страниц на сайте. Переходим во вкладку URL, в фильтре выбираем дубликат. В идеале получаем такой результат.

Если дубли все же есть, необходимо избавиться от них. Сделать это можно двумя способами: удалить все дубли или закрыть от индексации поисковыми системами в файле robots.txt.

Также стоит обратить внимание на размеры и время загрузки страниц сайта. Возвращаемся во вкладку Internal и ищем колонки Size и Response Time. Размер кода страницы не должен превышать 200 килобайт, если видим больше — заходим на страницу и анализируем проблему. Скорость загрузки не должна превышать 5−6 секунд. Обычно «тяжелые» страницы прогружаются именно на этом временном пороге, т. е. больше уже плохо. Опять же заходим, анализируем, исправляем.

Оптимизация изображений

Оптимизация картинок также имеет свое значение в комплексном аудите сайта. Например, Яндекс охотнее возьмет картинку в соответствующую выдачу, а это дополнительный трафик и + в карму от поисковой системы. Скриминг фрог и в этом вопросе может нам помочь. Переходим на вкладку Images, в фильтре выбираем Over 100 kb, ищем объемные картинки и затем Missing Alt Text. Конечно, настроек изображений много, но это основные две, которые рекомендуется соблюдать.

Анализ перелинковки

Не будем подробно разбирать правила перелинковки, просто расскажу два важных правила:

Во вкладке Internal ищем inlinks и outlinks, сортируем по значению. Желательно найти все важные и продвигаемые разделы в списке, для этого можно воспользоваться поиском. Значения входящих и исходящих ссылок у каждого сайта будут разные. Поэтому стоит отталкиваться от общего количества страниц и средне-ссылочной массы каждой из них.

Поиск пустых страниц

Там же (во вкладке Internal) выбираем в фильтр HTML и переходим к столбцу Word Count. Отфильтровываем по значению и смотрим, где значение равно нулю либо подозрительно маленькое. Главное, сразу отбросить страницы с кодом 404 и 301 редиректами. Пустые страницы следует наполнить контентом (если они нужны). В противном случае закройте их от индексации или избавьтесь от них вовсе.

Поиск проблемных URL

В SEO Spider Frog переходим во вкладку URL и смотрим по разным параметрам фильтра, но прежде давайте разберемся «who is who».

В любых операциях с URL не стоит забывать про 301 редирект.

Анализ внешних ссылок с сайта с помощью Frog Sreaming

Вкладка External позволяет просмотреть список всех исходящих внешних ссылок. Желательно провести детальный анализ и затем периодически проверять их количество и качество. Переходим на вкладку External и фильтруем колонку Status Code по значению. Нас интересуют нерабочие ссылки. Просматриваем, меняем их на своем сайте или удаляем вовсе. Внизу во вкладке In Links можно увидеть список страниц, которые содержат ссылку на определенный сайт.

Далее желательно просмотреть все ссылки, проверить все ли ваши. Бывают случаи, когда кто-то получает доступ к вашему сайту и шпионским образом проставляет ссылки. Случай редкий, но проверить надо.

Экспертное мнение

С каждым днем факторов ранжирования поисковыми системами становиться все больше. Попасть в заветный ТОП выдачи все сложнее, а тут еще и конкуренты выкатывают свои сайты. Необходимо встать на голову (а то и на две) выше остальных. Для этого SEO специалисты делают технический аудит сайта и детально анализируют каждый пункт.

Если вы не сеошник, то решение провести самостоятельный технический аудит сайта похвально. Такая программа как Screaming Frog Spider SEO может очень помочь вам в этом деле, но для полной оптимизации сайта этого все же недостаточно. Существует множество сервисов, которые помогают проанализировать проблемы, но, на мой взгляд, данная программа имеет самый обширный арсенал возможностей. И помните главное правило — лучше делать долго, но качественно, чем быстро и почти никак.

Сканирование сайта в Screaming Frog – полное руководство

Screaming Frog SEO Spider – один из наиболее важных инструментов в арсенале оптимизатора. Этот сервис просто незаменим при анализе интернет-ресурса, так как позволяет автоматизировать сбор и структурирование самых важных данных о сайте, тем самым сильно ускоряя работу.

Если вы занимаетесь развитием собственного веб-проекта, или продвижением сайтов клиентов, то Screaming Frog наверняка вам знаком. Но используете ли вы доступные возможности на 100%? В этой статье мы подготовили максимально подробное руководство по использованию данного инструмента. Надеемся, вы сможете найти здесь много нового и полезного.

Базовое сканирование сайта

Как сканировать весь сайт

Приступая к сканированию сайта, важно наперед определить, какую информацию вы хотите получить, насколько велик сайт, и какую часть сайта вам нужно сканировать, чтобы получить доступ к нужным данным.

Примечание: Иногда для масштабных ресурсов лучше ограничить сканер подразделом URL-адресов, чтобы получить хороший репрезентативный образец данных. Это делает размеры файлов и экспорт данных более управляемыми. Мы рассмотрим это более подробно ниже.

Для сканирования всего сайта, включая все дочерние домены, вам нужно внести небольшие изменения в конфигурацию spider, чтобы начать.

По умолчанию Screaming Frog сканирует только субдомен, который вы ввели. Любые дополнительные субдомены, с которыми сталкивается spider, будут рассматриваться, как внешние ссылки. Для обхода дополнительных поддоменов, необходимо изменить настройки в меню Spider Configuration. Отметив Crawl All Subdomains, вы убедитесь, что SEO Spider сканирует любые ссылки, которые он встречает, на другие поддомены на вашем сайте.

Шаг 1:

Шаг 2:

Если вы запускаете сканирование из определенной подпапки или подкаталога и по-прежнему хотите, чтобы Screaming Frog сканировал весь сайт, установите флажок Crawl Outside of Start Folder.

По умолчанию SEO Spider настроен только на сканирование подпапки или подкаталога, который вы сканируете. Если вы хотите сканировать весь сайт и запускать из определенного подкаталога, убедитесь, что для конфигурации задан обход за пределами начальной папки.

Совет: Чтобы сэкономить время и место на диске, помните о ресурсах, которые могут вам не понадобиться при сканировании. Снимите флажки с изображения, CSS, JavaScript и SWF-ресурсов, чтобы уменьшить размер обхода.

Как сканировать один подкаталог

Если вы хотите ограничить сканирование одной папкой, просто введите URL-адрес и нажмите Start, не изменяя никаких настроек по умолчанию. Если вы перезаписали исходные настройки по умолчанию, сбросьте настройки по умолчанию в меню File.

Если вы хотите начать сканирование в определенной папке, но нужно продолжить сканирование в остальных частях субдомена, обязательно выберите Crawl Outside Of Start Folder в настройках Spider Configuration, прежде, чем вводить ваш конкретный стартовый URL.

Как сканировать определенный набор поддоменов или подкаталогов

Чтобы ограничить просмотр определенным набором поддоменов или подкаталогов, вы можете использовать RegEx, чтобы установить эти правила в параметрах Include или Exclude в меню Configuration.

Exclusion (Исключение)

В этом примере мы просмотрели каждую страницу на elit-web.ru, исключая страницы blog на каждом поддомене.

Шаг 1:

Перейдите в Configuration > Exclude, используйте подстановочные регулярные выражения для определения URL или параметров, которые вы хотите исключить.

Шаг 2:

Проверьте свое регулярное выражение, чтобы убедиться, что оно исключает ожидаемые страницы до начала сканирования:

Include (Включение)

В приведенном ниже примере мы хотели просмотреть только подпапку команды на elit-web.ru. Опять же, используйте закладку Test, чтобы протестировать несколько URL и убедиться, что RegEx правильно настроен для вашего правила inclusion.

Это отличный способ сканирования больших сайтов. На самом деле, Screaming Frog рекомендует этот метод, если вам нужно разделить и сканировать сайт с большим числом обратных ссылок.

Как получить список всех страниц на моем сайте

По умолчанию, Screaming Frog настроен на сканирование всех изображений, JavaScript, CSS и флэш-файлов, с которыми сталкивается SEO Spider. Чтобы сканировать (crawl) только HTML, вам придется снять выделение с пунктов Check Images, Check CSS, Check JavaScript и Check SWF в меню Spider Configuration.

Запуск SEO Spider с этими настройками без галочки, по сути, предоставит вам список всех страниц вашего сайта, на которые есть внутренние ссылки, указывающие на них.

После завершения сканирования перейдите на вкладку Internal и отфильтруйте результаты по HTML. Нажмите кнопку Export, и у вас будет полный список в формате CSV.

Совет: Если вы склонны использовать одни и те же настройки для каждого сканирования, Screaming Frog теперь позволяет вам сохранить настройки конфигурации:

Как получить список всех страниц в определенном подкаталоге

В дополнение к снятию флажка Check Images, Check CSS, Check JavaScript и Check SWF, вы также захотите снять флажок Check Links Outside Folder в настройках Spider Configuration. Запуск SEO Spider с этими настройками без флажка, даст вам список всех страниц в вашей стартовой папке (если они не являются страницами, на которые нет внутренних или внешних ссылок).

Как найти все субдомены на сайте и проверить внутренние ссылки

Есть несколько разных способов найти все поддомены на сайте.

Способ 1

Используя Screaming Frog для идентификации всех поддоменов на данном сайте, перейдите в Configuration > Spider и убедитесь, что выбрана опция Crawl all Subdomains. Как и при сканировании всего сайта, это поможет сканировать любой поддомен, связанный с обходом сайта. Тем не менее, это не найдет поддоменов, которые не связаны ссылками.

Способ 2

Используйте Google, (расширение для браузера Scraper Chrome) для идентификации всех проиндексированных поддоменов, мы можем найти все индексируемые субдомены для данного домена.

Шаг 1:

Шаг 2:

Используйте расширение Scraper, чтобы извлечь все результаты в Google Sheet. Просто щелкните правой кнопкой мыши URL-адрес в поисковой выдаче, нажмите Scrape Similar и экспортируйте в Google Doc.

Шаг 3:

В вашем Документе Google Doc используйте следующую функцию, чтобы обрезать URL-адрес до субдомена:

По сути, приведенная выше формула должна помочь удалить любые подкаталоги, страницы или имена файлов в конце сайта. Эта формула, позволяет не экспортировать в Excel то, что находится слева от конечной косой черты. Стартовое число 9 является важным, потому что мы просим его начать искать косую черту «/» после 9-го символа. Это составляет протокол: https://, длиной в 8 символов.

Дублируйте список и загрузите его в Screaming Frog в режиме списка (List Mode) – вы можете вручную вставить список доменов, использовать функцию вставки (paste) или загрузить (upload) CSV.

Способ 3

Введите URL-адрес корневого домена в инструменты (tools), чтобы найти сайты, которые могут существовать на том же IP-адресе. Также вы можете воспользоваться поисковыми системами, специально предназначенными для поиска поддоменов, например FindSubdomains. Создайте бесплатную учетную запись для входа и экспорта списка поддоменов. Затем загрузите список в Screaming Frog, используя режим списка (List Mode).

Как только SEO Spider закончит работу, вы сможете увидеть код состояния, а также любые ссылки на домашних страницах поддоменов, текст привязки и дубликаты заголовков страниц, среди прочего.

Как сканировать интернет-магазин или другой большой сайт

Изначально Screaming Frog не был создан для сканирования сотен тысяч страниц, но благодаря некоторым обновлениям он становится многофункциональнее с каждым днем.

Последняя версия Screaming Frog была обновлена, чтобы полагаться на хранилище базы данных для обходов. В версии 11.0 Screaming Frog позволял пользователям сохранять все данные на диске в базе данных, а не просто хранить их в оперативной памяти. Это открыло возможность сканирования очень больших сайтов в один клик.

В версии 12.0 сканирование автоматически сохраняет обходы в базе данных. Это позволяет получить к ним доступ и открыть с помощью File > Crawls в меню верхнего уровня (на случай, если вы удивляетесь, куда пошла команда open?)

Хотя использование обхода базы данных помогает Screaming Frog лучше управлять большими объемами информации, это, конечно, не единственный способ сканирования большого сайта.

Во-первых, вы можете увеличить выделение памяти в SEO Screaming Frog.

Во-вторых, вы можете разбить сканирование по подкаталогу или сканировать только определенные части сайта, используя настройки Include / Exclude.

В-третьих, вы можете не сканировать изображения, JavaScript, CSS и flash. Отменив выбор этих параметров в меню Configuration, сэкономив тем самым память, сканируя только HTML.

Совет: До недавнего времени Screaming Frog SEO Spider мог приостанавливаться или зависать при сканировании большого сайта. Теперь, когда хранилище базы данных является настройкой по умолчанию, вы можете восстановить обходы, чтобы выбрать, где вы остановились. Кроме того, вы также можете получить доступ к URL-адресам в очереди. Это может дать вам представление о любых дополнительных параметрах или правилах, которые вы можете исключить для сканирования большого сайта.

Как сканировать сайт, размещенный на старом сервере, или как сканировать сайт без сбоев

В некоторых случаях старые серверы могут не обрабатывать количество URL-запросов по умолчанию в секунду. Мы рекомендуем включить ограничение на количество сканируемых URL-адресов в секунду, чтобы на всякий случай не усложнять работу сервера сайта. Лучше всего, чтобы клиент знал, когда вы планируете сканировать сайт, на случай, если у него может быть защита от неизвестных пользовательских агентов. С одной стороны, им может понадобиться внести в белый список ваш IP или пользовательский агент (User-Agent), прежде, чем вы будете сканировать сайт. В худшем случае вы можете отправить слишком много запросов на сервер и непреднамеренно завершить работу сайта.

Чтобы изменить скорость сканирования, выберите Speed в меню Configuration и во всплывающем окне выберите максимальное количество потоков, которые должны работать одновременно. В этом меню вы также можете выбрать максимальное количество URL-адресов, запрашиваемых в секунду.

Совет: Если вы обнаружите, что при сканировании возникает много ошибок сервера, перейдите на вкладку Advanced в меню Spider Configuration и увеличьте значение Response Timeout и 5xx Response Retries, чтобы получить лучшие результаты.

Как сканировать сайт, который требует куки

Хотя поисковые роботы не принимают файлы cookie, если вы сканируете сайт и хотите разрешить использование файлов cookie, просто выберите Allow Cookies на вкладке Advanced в меню Spider Configuration.

Как сканировать, используя другой пользовательский агент (User-Agent)

Чтобы сканировать с использованием другого пользовательского агента, выберите User Agent в меню Configuration, затем выберите поискового бота из выпадающего списка или введите нужные строки пользовательского агента.

Поскольку Google теперь ориентирован на мобильные устройства, попробуйте просканировать сайт как смартфон Googlebot или измените User-Agent, чтобы он был как смартфон Googlebot. Это важно по двум причинам:

Как сканировать страницы, требующие аутентификации

Когда Screaming Frog встречает страницу, защищенную паролем, появляется всплывающее окно, в котором вы можете ввести требуемое имя пользователя и пароль.

Аутентификация на основе форм является очень мощной функцией и может потребовать рендеринга JavaScript для эффективной работы.

Примечание: проверку подлинности на основе форм следует использовать экономно и только опытным пользователям. Сканер запрограммирован так, что он кликает каждую ссылку на странице, это может привести к появлению ссылок для выхода из системы, создания сообщений или даже удаления данных.

Чтобы управлять аутентификацией, перейдите к Configuration > Authentication.

Чтобы отключить запросы на аутентификацию, отмените выбор Authentication на основе стандартов в окне Authentication в меню Configuration.

Внутренние ссылки

Как получить информацию обо всех внутренних и внешних ссылках на моем сайте (якорный текст, директивы, ссылки на страницу и т. д.)

Если вам не нужно проверять изображения, JavaScript, Flash или CSS на сайте, отмените выбор этих параметров в меню Spider Configuration, чтобы сэкономить время и память.

Как только SEO Spider завершит сканирование, используйте меню Bulk Export, чтобы экспортировать CSV All Links. Это предоставит вам все ссылки, а также соответствующий якорный текст, директивы и т. д.

Все ссылки могут быть в большом отчете. Помните об этом при экспорте. Для большого сайта этот экспорт может занять несколько минут.

Для быстрого подсчета количества ссылок на каждой странице перейдите на вкладку Internal и отсортируйте по Outlinks. Страницы, где более 100 ссылок, возможно, потребуется пересмотреть.

Как найти неработающие внутренние ссылки на странице или сайте

Как и в предыдущем пункте, отмените выбор JavaScript, Flash или CSS сайта в меню Spider Configuration, если вам не нужно проверять изображения.

После того, как SEO Spider завершит сканирование, отсортируйте результаты вкладки Internal по Status Code. Любой 404, 301 или другой код состояния будут легко доступны для просмотра.

Нажав на любой отдельный URL в результатах сканирования, вы увидите изменение информации в нижнем окне программы. Нажав на вкладку In Links в нижнем окне, вы увидите список страниц, которые ссылаются на выбранный URL, а также якорный текст и директивы, используемые в этих ссылках. Вы можете использовать эту функцию для определения страниц, на которых необходимо обновить внутренние ссылки.

Чтобы экспортировать полный список страниц, которые содержат неработающие или перенаправленные ссылки, выберите Redirection (3xx) In Links или Client Error (4xx) In Links или Server Error (5xx) In Links в меню Advanced Export, и вы получите CSV-экспорт данных.

Чтобы экспортировать полный список страниц, которые содержат неработающие или перенаправленные ссылки, посетите меню Bulk Export. Прокрутите вниз до кода ответов и посмотрите следующие отчеты:

Просмотр всех этих отчетов должен дать вам адекватное представление о том, какие внутренние ссылки следует обновить, чтобы они указывали на каноническую версию URL и эффективно распределяли качественные ссылки.

Как найти неработающие исходящие ссылки на странице или сайте (или все исходящие ссылки в целом)

После отмены выбора Check Images, Check CSS, Check JavaScript и Check SWF в настройках Spider Configuration убедитесь, что Check External Links остается выбранной.

После того, как SEO Spider завершит сканирование, нажмите на вкладку External в верхнем окне, отсортируйте по Status Code Вы легко сможете найти URL с кодом состояния, отличными от 200. После нажатия на любой отдельный URL, просканируйте результаты, а затем, нажав на вкладку In Links в нижнем окне, вы увидите список страниц, которые указывают на выбранный URL-адрес. Вы можете использовать эту функцию для определения страниц, на которых необходимо обновить исходящие ссылки.

Чтобы экспортировать полный список исходящих ссылок, нажмите External Links на вкладке Bulk Export.

Для получения полного списка всех местоположений и текста привязки исходящих ссылок выберите All Outlinks в меню Bulk Export. Отчет All Outlinks также будет включать исходящие ссылки на ваши субдомены. Если вы хотите исключить свой домен, воспользуйтесь отчетом External Links, упомянутым выше.

Как найти ссылки, которые перенаправляются

После завершения сканирования выберите вкладку Response Codes в основном пользовательском интерфейсе и выполните фильтрацию по коду состояния. Поскольку Screaming Frog использует регулярные выражения для поиска, отправьте в качестве фильтра следующие критерии: 301 | 302 | 307. Это должно дать вам довольно солидный список всех ссылок, которые возвращались с каким-либо перенаправлением, независимо от того, был ли контент постоянно перемещен, найден и перенаправлен, или временно перенаправлен из-за настроек HSTS (это вероятная причина 307 перенаправлений в Screaming Frog ).

Сортируйте по Status Code, и вы сможете разбить результаты по типу. Нажмите на вкладку In Links в нижнем окне, чтобы просмотреть все страницы, на которых используется ссылка для перенаправления.

Если вы экспортируете напрямую из этой вкладки, то увидите только те данные, которые отображаются в верхнем окне (оригинальный URL, код состояния и куда он перенаправляется).

Чтобы экспортировать полный список страниц, содержащих перенаправленные ссылки, вам нужно будет выбрать Redirection (3xx) In Links в меню Advanced Export. Это вернет CSV, который включает в себя местоположение всех ваших перенаправленных ссылок. Чтобы показать только внутренние перенаправления, отфильтруйте столбец Destination в CSV, чтобы включить только ваш домен.

Совет: Используйте функцию VLOOKUP (ВПР) между двумя вышеупомянутыми файлами экспорта, чтобы сопоставить столбцы Source и Destination с окончательным расположением URL-адреса.

Для чего нужны данные о ссылках

Грамотное распределение внутренних ссылок может повысить эффективность поискового продвижения, особенно когда вы занимаетесь стратегическим подходом к распределению PageRank и качественных ссылок, ранжирование ключевых слов и привязки к ключевым словам.

Контент сайта

Как определить страницы с неинформативным контентом

После завершения сканирования SEO Spider перейдите на вкладку Internal, отфильтруйте их по HTML, затем прокрутите вправо до столбца Word Count. Сортируйте столбец Word Count по убыванию, чтобы найти страницы с низким содержанием текста. Вы можете перетащить столбец Word Count влево, чтобы лучше сопоставить значения низкого количества слов с соответствующими URL-адресами. Нажмите Export на вкладке Internal, если вы предпочитаете вместо этого управлять данными в CSV.

Как получить список ссылок на изображения на определенной странице

Если вы уже просмотрели весь сайт или подпапку, просто выберите страницу в верхнем окне, а затем нажмите вкладку Image Info в нижнем окне, чтобы просмотреть все изображения, найденные на этой странице. Изображения будут перечислены в столбце To.

Совет: Щелкните правой кнопкой мыши любую запись в нижнем окне, чтобы скопировать или открыть URL-адрес.

Кроме того, вы также можете просматривать изображения на одной странице, сканируя только этот URL. Убедитесь, что в настройках конфигурации SEO Spider задана глубина сканирования 1, затем после сканирования страницы перейдите на вкладку Images, и вы увидите все изображения, найденные screaming frog.

Как найти изображения, в которых отсутствует текст alt или изображения с длинным текстом alt

Во-первых, вы должны убедиться, что в меню Spider Configuration выбран Check Images. После того, как SEO Spider закончил анализировать, перейдите на вкладку Images и отфильтруйте по Missing Alt Text или Alt Text Over 100 Characters. Вы можете найти страницы, где находится любое изображение, нажав на вкладку Image Info в нижнем окне. Страницы будут перечислены в столбце From.

Наконец, если вы предпочитаете CSV, используйте меню Bulk Export, чтобы экспортировать All Images или Images Missing Alt Text Inlinks, чтобы увидеть полный список изображений, где они находятся, и любой связанный с ним текст alt или проблемы с alt Text.

Кроме того, используйте правую боковую панель, чтобы перейти к разделу изображений для обхода. Здесь вы можете легко экспортировать список всех изображений, пропущенным текстом alt.

Как найти каждый файл CSS на моем сайте

В меню Spider Configuration выберите Crawl и Store CSS перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal с помощью CSS.

Как найти каждый файл JavaScript на сайте

В меню Spider Configuration выберите Check JavaScript перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal по JavaScript.

Как определить все плагины jQuery, используемые на сайте, и на каких страницах они используются

Во-первых, убедитесь, что в меню Spider Configuration выбран Check JavaScript. После того, как SEO Spider завершил сканирование, отфильтруйте вкладку Internal по JavaScript, затем найдите jquery. Это предоставит вам список файлов плагинов. Сортируйте список по Address для более удобного просмотра при необходимости, затем просмотрите InLinks в нижнем окне или экспортируйте данные в CSV, чтобы найти страницы, где используется файл. Они будут в столбце From.

Кроме того, вы можете использовать меню Advanced Export, чтобы экспортировать CSV All Links и отфильтровать столбец Destination, чтобы отображались только URL-адреса с jquery.

Совет: Не все плагины jQuery вредны для SEO. Если вы видите, что сайт использует jQuery, лучше всего убедиться, что контент, который вы хотите проиндексировать, включен в источник страницы и обслуживается при загрузке страницы, а не после. Если вы все еще не уверены, установите плагин Google для получения дополнительной информации о том, как он работает.

Как определить места со встроенным flash

В меню Spider Configuration выберите Check SWF перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal по Flash.

Это становится все более важным, чтобы находить и идентифицировать контент, который поставляется Flash, и предлагать альтернативный код для него. Flash постепенно устаревает для Chrome. Потому этот функционал действительно нужно использовать, чтобы определить, если есть проблемы с критическим контентом и Flash на сайте.

Как найти любые внутренние PDF-файлы

После завершения сканирования в Screaming Frog отфильтруйте результаты на вкладке Internal по PDF.

Как понять сегментацию контента внутри сайта или группы страниц

Если вы хотите найти на своем сайте страницы с определенным типом контента, установите специальный фильтр для HTML-кода, уникального для этой страницы. Это следует сделать перед запуском screaming frog.

Как найти страницы с кнопками социальных сетей

Чтобы найти страницы, содержащие кнопки социальных сетей, вам нужно установить собственный фильтр перед запуском. Чтобы установить пользовательский фильтр, перейдите в меню Configuration и нажмите Custom. Оттуда введите любой фрагмент кода из исходного кода страницы.

В приведенном выше примере фильтр для facebook.com/plugins/like.php.

Как найти страницы, которые используют iframes

Чтобы найти страницы, которые используют iframe, установите пользовательский фильтр для Robots.txt > Settings

Как найти или проверить разметку схемы или другие микроданные на моем сайте

Чтобы найти каждую страницу, содержащую разметку схемы или любые другие микроданные, вам нужно использовать пользовательские фильтры. Просто нажмите Custom → Search в меню конфигурации и введите нужный элемент footprint.

Чтобы найти каждую страницу, содержащую разметку схемы, просто добавьте следующий фрагмент кода в пользовательский фильтр: itemtype = http://schema.org

Чтобы найти конкретный тип разметки, вам нужно быть более конкретным. Например, с помощью пользовательского фильтра для ‹span itemprop = ratingValue› вы получите все страницы, содержащие разметку схемы для оценок.

Начиная с Screaming Frog 11.0, Spider SEO также предлагает нам возможность сканировать, извлекать и проверять структурированные данные непосредственно из сканирования. Проверяйте любые структурированные данные JSON-LD, Microdata или RDFa в соответствии с рекомендациями Schema.org и спецификациями Google в режиме реального времени во время сканирования. Чтобы получить доступ к инструментам проверки структурированных данных, выберите параметры в Config > Spider > Advanced.

Теперь в главном интерфейсе есть вкладка Structured Data, которая позволит вам переключаться между страницами, которые содержат структурированные данные, и которые могут иметь ошибки или предупреждения проверки:

Вы также можете выполнить массовый экспорт проблем со структурированными данными, посетив Reports> Structured Data > Validation Errors & Warnings.

Карта сайта

Как создать XML Sitemap

После того, как SEO Spider завершит сканирование вашего сайта, нажмите меню Siteamps и выберите XML Sitemap.

Открыв настройки конфигурации XML-карты сайта, вы можете включать или исключать страницы по коду ответов, последним изменениям, приоритетам, частоте изменений, изображениям и т. Д. По умолчанию Screaming Frog включает только 2xx URL-адресов, но это правило можно исправить.

В идеале, ваша карта сайта XML должна содержать только 200 статусных, единичных, предпочтительных (канонических) версий каждого URL-адреса, без параметров или других дублирующих факторов. После внесения любых изменений нажмите ОК. Файл XML-файла сайта будет загружен на ваше устройство и позволит вам редактировать соглашение об именах по вашему усмотрению.

Создание XML-файла Sitemap путем загрузки URL-адресов

Вы также можете создать карту сайта XML, загрузив URL-адреса из существующего файла или вставив вручную в Screaming Frog.

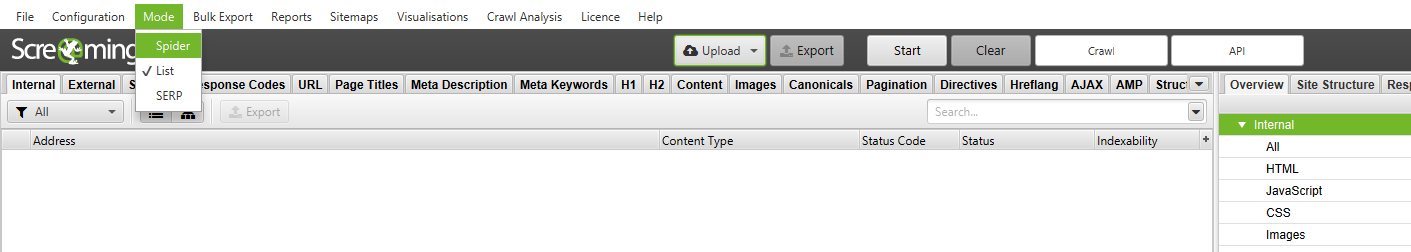

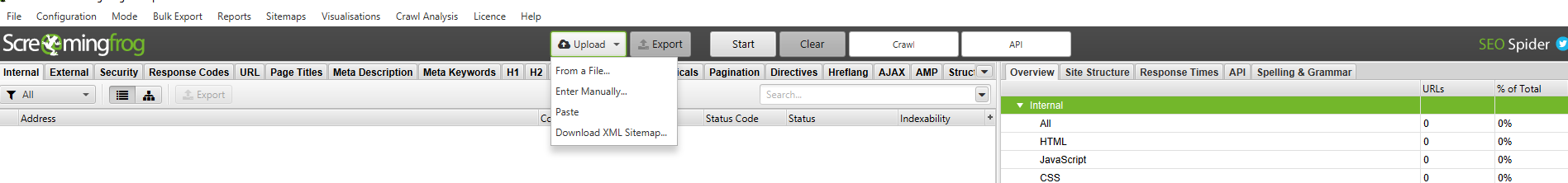

Измените Mode с Spider на List и нажмите на выпадающий список Upload, чтобы выбрать любой из вариантов.

Нажмите кнопку Start и Screaming Frog будет сканировать загруженные URL-адреса. После сканирования URL вы будете следовать тому же процессу, который указан выше.

Как проверить мой существующий XML Sitemap

Вы можете легко загрузить существующую XML-карту сайта или индекс карты сайта, чтобы проверить наличие ошибок или несоответствий при сканировании.

Перейдите в меню Mode в Screaming Frog и выберите List. Затем нажмите Upload в верхней части экрана, выберите Download Sitemap или Download Sitemap Index, введите URL-адрес карты сайта и начните сканирование. Как только SEO Spider закончит сканирование, вы сможете найти любые перенаправления, 404 ошибки, дублированные URL-адреса и многое другое. Вы можете легко экспортировать и выявленные ошибки.

Определение отсутствующих страниц в XML Sitemap

Вы можете настроить параметры сканирования, чтобы обнаруживать и сравнивать URL-адреса в ваших XML-файлах сайта с URL-адресами в пределах вашего сайта.

После обновления настроек сканирования XML-файла Sitemap перейдите к пункту Crawl Analysis в навигации, затем нажмите Configure и убедитесь, что кнопка Sitemaps отмечена. Сначала запустите полное сканирование сайта, затем вернитесь к Crawl Analysis и нажмите Start.

После завершения анализа сканирования вы сможете увидеть любые расхождения при сканировании, такие как URL-адреса, обнаруженные в рамках полного сканирования сайта, которые отсутствуют в карте сайта XML.

Общие проблемы

Как определить, почему определенные разделы сайта не индексируются или не ранжируются

Хотите знать, почему некоторые страницы не индексируются? Во-первых, убедитесь, что они не были случайно помещены в файл robots.txt или помечены как noindex. Затем вы должны убедиться, что SEO Spider может добраться до страниц, проверив ваши внутренние ссылки. Страницу, которая не имеет внутренних ссылок на вашем сайте, часто называют «сиротами» (Orphaned Page).

Чтобы выявить потерянные страницы, выполните следующие действия:

Перейдите в Configuration → API Access → Google Analytics – используя API, вы можете получить аналитические данные для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы из органического поиска, убедитесь, что они разделены на органический трафик.

Вы также можете перейти к разделу General → Crawl New URLs Discovered In Google Analytics, если вы хотите, чтобы URL-адреса, обнаруженные в GA, были включены в ваш полный обход сайта. Если это не включено, вы сможете просматривать только новые URL-адреса, извлеченные из GA, в отчете Orphaned Pages.

Перейдите в Configuration → API Access → Google Search Console – используя API, вы можете получить данные GSC для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы, вы можете искать URL-адреса, на которых получены клики и показы, которые не включены в ваш просмотр. Вы также можете перейти к разделу General → Crawl New URLs Discovered In Google Search Console, если вы хотите, чтобы URL-адреса, обнаруженные в GSC, были включены в ваш полный обход сайта. Если этот параметр не включен, вы сможете просматривать только новые URL-адреса, извлеченные из GSC, в отчете Orphaned Pages.

Просмотрите потерянные URL-адреса на каждой из вкладок или выполните Bulk Expor всех потерянных URL-адресов, перейдя в Reports → Orphan Pages.

Откройте файл CSV и на втором листе вставьте список URL-адресов, которые не индексируются или плохо ранжируются. Используйте VLOOKUP, чтобы увидеть, были ли URL-адреса в вашем списке на втором листе найдены при сканировании.

Как найти медленные страницы на моем сайте

После того, как SEO Spider завершил сканирование, перейдите на вкладку Response Codes и отсортируйте по столбцу Response Time по возрастанию, чтобы найти страницы, которые могут страдать от медленной скорости загрузки.

Как найти вредоносное ПО или спам на моем сайте

Во-первых, вам необходимо идентифицировать след вредоносного ПО или спама. Далее в меню Configuration нажмите Custom → Search и введите искомый элемент, который вы ищете.

Вы можете ввести до 10 различных фильтров для сканирования. Наконец, нажмите OK и продолжайте сканирование сайта или списка страниц.

Когда SEO Spider завершит сканирование, выберите вкладку Custom в верхнем окне, чтобы просмотреть все страницы, содержащие ваш отпечаток. Если вы ввели более одного пользовательского фильтра, вы можете просмотреть каждый, изменив фильтр по результатам.

PPC и аналитика

Как проверить список URL-адресов PPC навалом

Затем выберите файл для загрузки и нажмите Start или вставьте свой список вручную в Screaming Frog. Посмотрите код состояния каждой страницы, перейдя на вкладку Internal.

Зачистка

Как очистить метаданные для списка страниц

Как очистить сайт для всех страниц, которые содержат определенный размер?

Во-первых, вам нужно определить след. Затем в меню Configuration нажмите Custom → Search или Extraction и введите искомый элемент, который вы ищете.

Вы можете ввести до 10 различных следов на сканирование. Наконец, нажмите OK и продолжайте сканирование сайта или списка страниц. В приведенном ниже примере я хотел найти все страницы с надписью УСЛУГИ в разделе цен, поэтому я нашел и скопировал HTML-код из исходного кода страницы.

Когда SEO Spider завершит проверку, выберите вкладку Custom в верхнем окне, чтобы просмотреть все страницы, содержащие ваш отпечаток. Если вы ввели более одного пользовательского фильтра, вы можете просмотреть каждый, изменив фильтр по результатам.

Ниже приведены некоторые дополнительные общие следы, которые вы можете почерпнуть с веб-сайтов, которые могут быть полезны для ваших аудитов SEO:

В нижнем окне вы сможете увидеть необработанный и визуализированный HTML. Это может помочь выявить проблемы с тем, как ваш контент отображается и просматривается сканерами.

В заключение

Мы надеемся, что это руководство даст вам лучшее представление о том, какие возможности вам доступны в Screaming Frog, а также поможет сэкономить часы работы.