Sff 8644 что за разъем

SAS (Serial Attached SCSI)

SAS обратно совместим с интерфейсом SATA: устройства SATA II и SATA 6 Gb/s могут быть подключены к контроллеру SAS, но устройства SAS нельзя подключить к контроллеру SATA. Последняя реализация SAS обеспечивает передачу данных со скоростью до 12Гбит/с на одну линию. К 2017-му году ожидается появление спецификации SAS со скоростью передачи данных 24Гбит/с

SAS сочетает преимущества интерфейсов SCSI (глубокая сортировка очереди команд, хорошая масштабируемость, высокая помехозащищённость, большая максимальная длина кабелей) и Serial ATA(тонкие, гибкие дешёвые кабели, возможность горячего подключения, топология типа «точка-точка», позволяющая достигать большей производительности в сложных конфигурациях) с новыми уникальными возможностями – такими, как продвинутая топология подключения с использованием хабов, именуемых SAS-расширителями (SAS- экспандерами), подключение к одному диску двух SAS-каналов (как для повышения надёжности, так и производительности), работа на одном контроллере дисков как с SAS, так и с SATA-интерфейсом.

В сочетании с новой системой адресации это позволяет подключать до 128 устройств на один порт и иметь до 16256 устройств на контроллере, при этом не требуются какие-либо манипуляции с перемычками и т.п. Снято ограничение в 2 Терабайта на объём логического устройства.

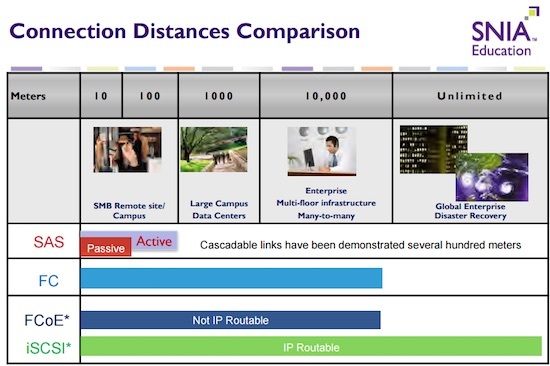

Максимальная длина кабеля между двумя SAS-устройствами –10 м при использовании пассивных медных кабелей.

Производимые в данный момент SAS контроллеры имеют внутренние разъёмы типа SFF-8643 (так же может называться mini SAS HD), но все еще могут встретиться разъемы типа SFF-8087 (mini SAS), на который выведено 4 SAS канала.

Внешний вариант интерфейса использует разъём SFF-8644, но все еще может встретиться разъем SFF-8088. Он так же поддерживает четыре SAS канала.

Обычно SAS корзины/объединительные панели (backplane) снаружи имеют SATA-разъёмы и в них всегда можно вставлять обычные SATA диски, поэтому их (такие корзины) обычно и называют SAS/SATA.

Однако существуют реверсивные варианты такого кабеля для подключения бэкплейна с внутренними разъёмами SFF-8087 к SAS-контроллеру, имеющему обычные SATA-разъёмы. Между собой такие кабели невзаимозаменяемы.

SAS диски нельзя подключить к SATA контроллеру или установить в SATA корзину/объединительную панель (backplane).

Для подключения SAS дисков к контроллеру с внутренними разъёмами SFF-8643 или SFF-8087 без использования SAS корзин необходимо использовать кабель типа SFF-8643->SFF-8482 или SFF-8087->SFF-8482 соответственно.

Существующие версии интерфейса SAS (1.0, 2.0, и 3.0) имеют совместимость между собой, то есть диск SAS2.0 можно подключать к контроллеру SAS 3.0 и наоборот. Кроме того будущая версия 24 Gb/s так же будет иметь обратную совместимость.

Подключаем SAS диски к ПК

Всем привет, сегодня у нас маленький эксперимент по подключению SAS дисков к обычному персональному компьютеру. Обычно в компьютер можно установить только SATA диски, так как на материнской плате есть встроенный SATA контроллер. А SAS диски в обычный ПК не вставишь.

Дело в том, что SATA контроллер поддерживает только SATA диски. А SAS контроллер может поддерживать и SAS диски и SATA диски. SAS обратно совместим с интерфейсом SATA: устройства 3 Гбит/с и 6 Гбит/с SATA могут быть подключены к контроллеру SAS, но не наоборот.

SATA (Serial ATA) — последовательный компьютерный интерфейс обмена данными с накопителями информации. Предназначен для настольных ПК.

SAS (Serial Attached SCSI) — последовательный компьютерный интерфейс, разработанный для подключения различных устройств хранения данных, например, жёстких дисков и ленточных накопителей. Последняя реализация SAS обеспечивает передачу данных со скоростью до 12 Гбит/с на одну линию. Предназначен для серверов.

SAS не предназначен для настольных ПК, но иногда очень надо. Мне, например, по работе требуется иногда работать с SAS дисками. Подключаем SAS диск к ПК.

Что нужно для подключения SAS диска к ПК

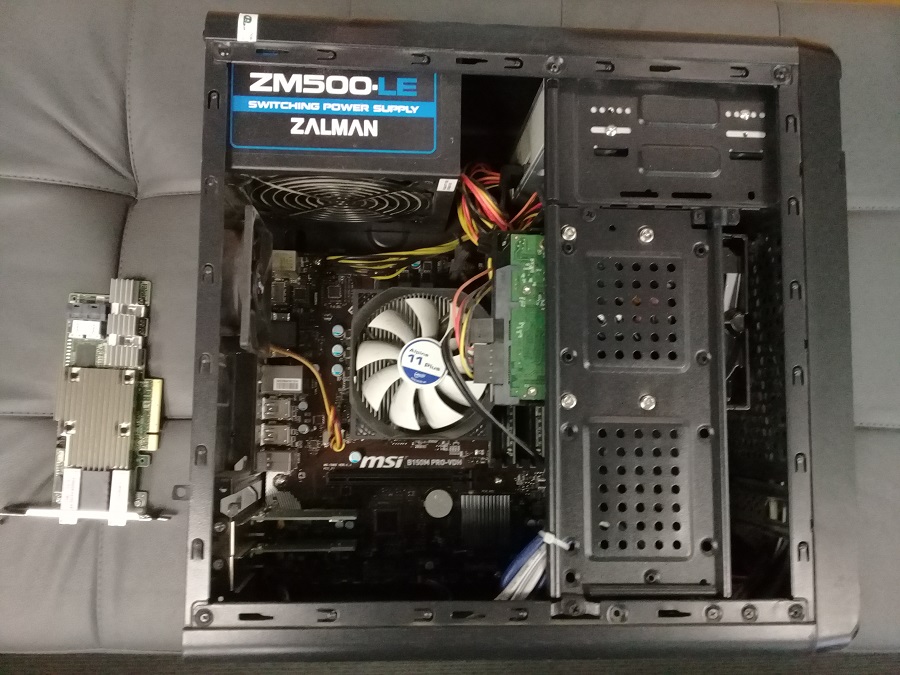

Потребуется обычный ПК. Поскольку SAS контроллера на обычном ПК нет, то нам потребуется такой контроллер. Я попробую два варианта:

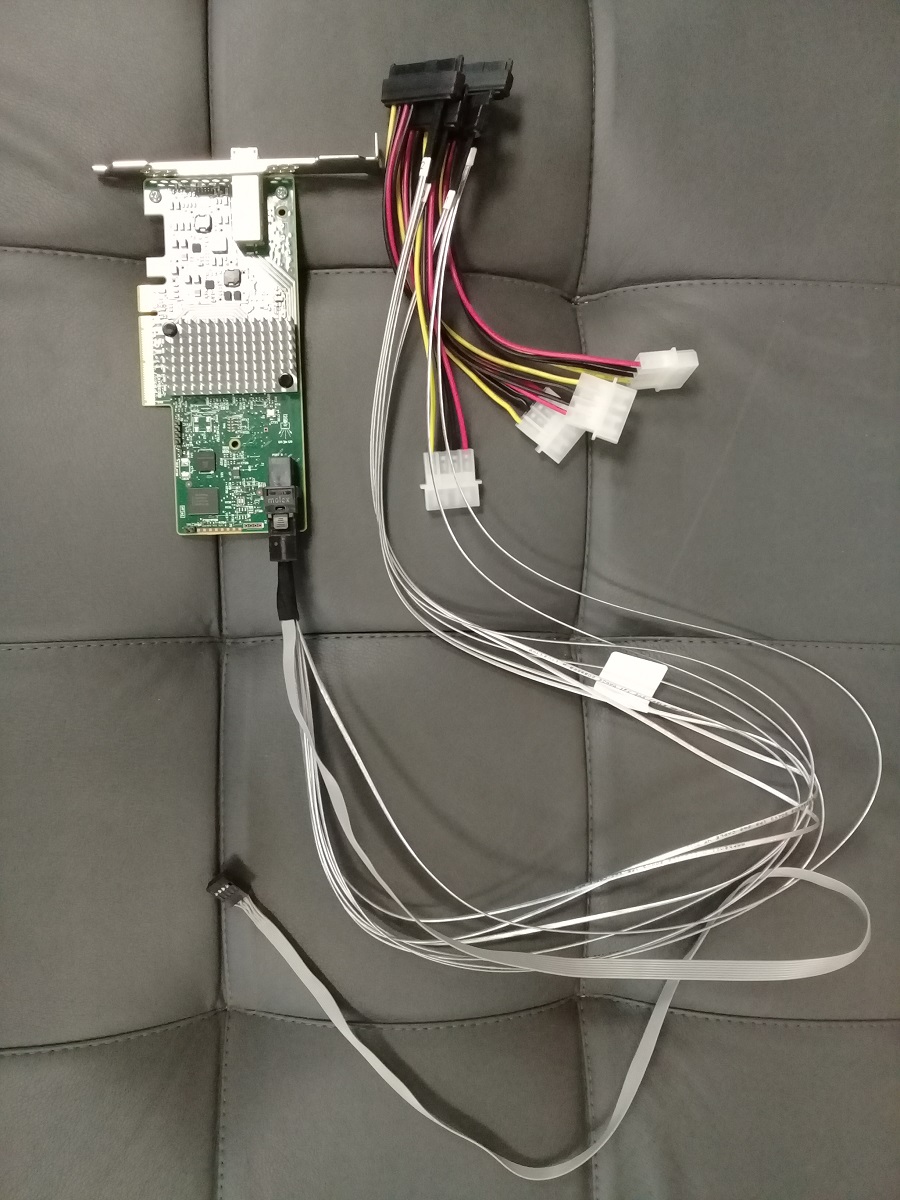

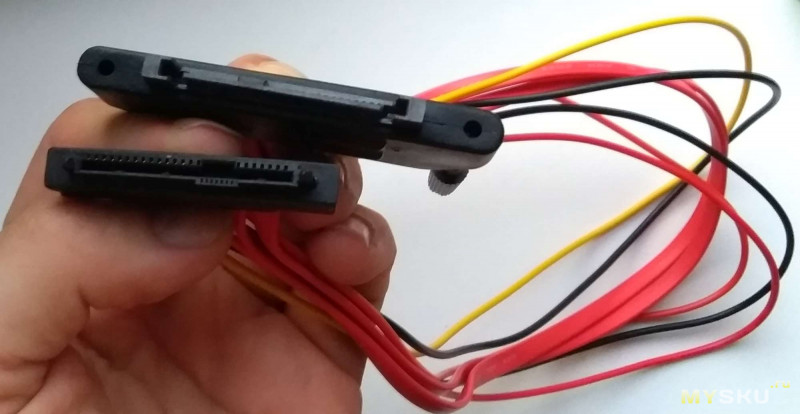

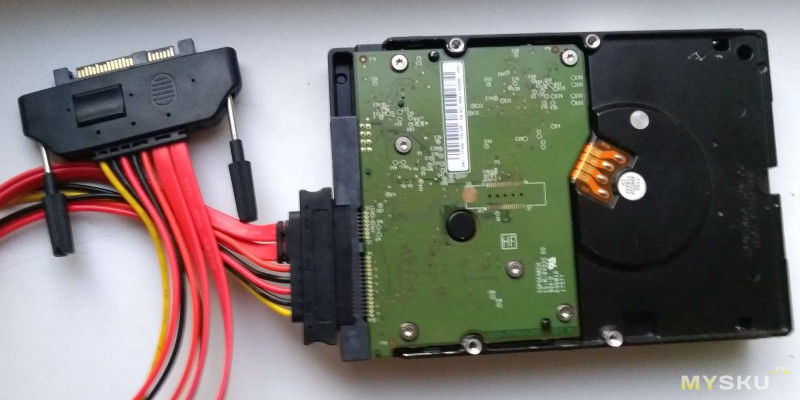

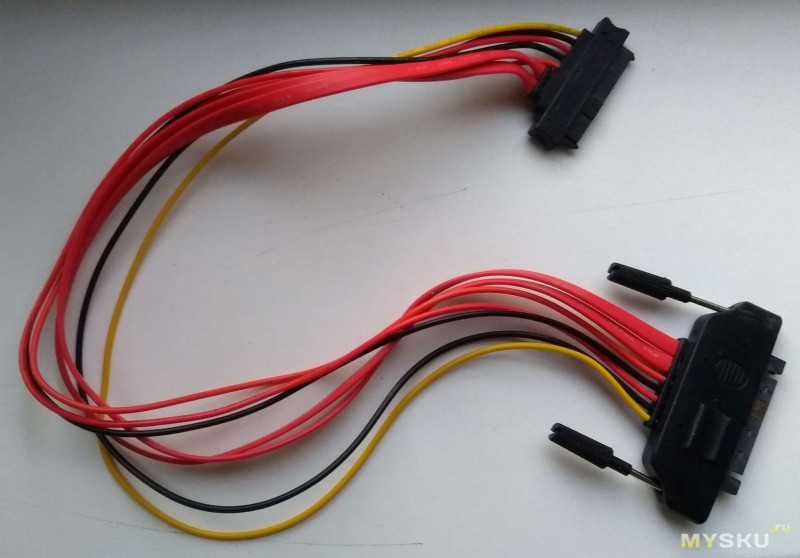

Для подключения дисков к контроллеру без использования корзины потребуется кабель переходник. Купил такой:

Переходник позволяет подключить 4 HDD с интерфейсом SAS или SATA к контроллеру с разъемом SFF-8643. Питание подаётся на каждый диск через 4-pin Molex.

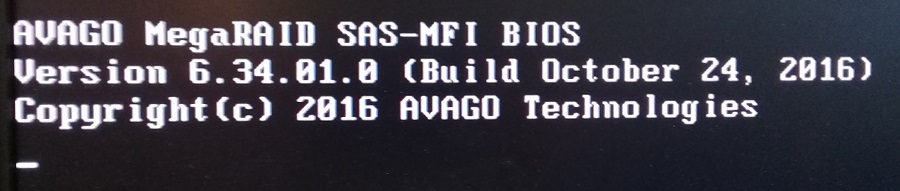

Подключение SAS диска через RAID контроллер Avago MegaRAID SAS 9380-8i8e

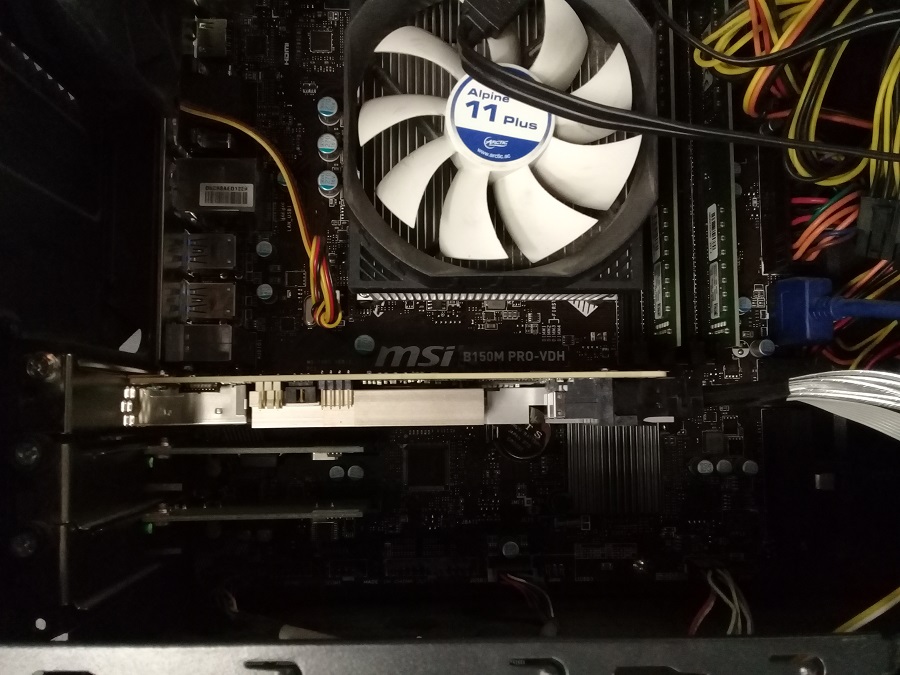

Устанавливаем контроллер в PCIe слот.

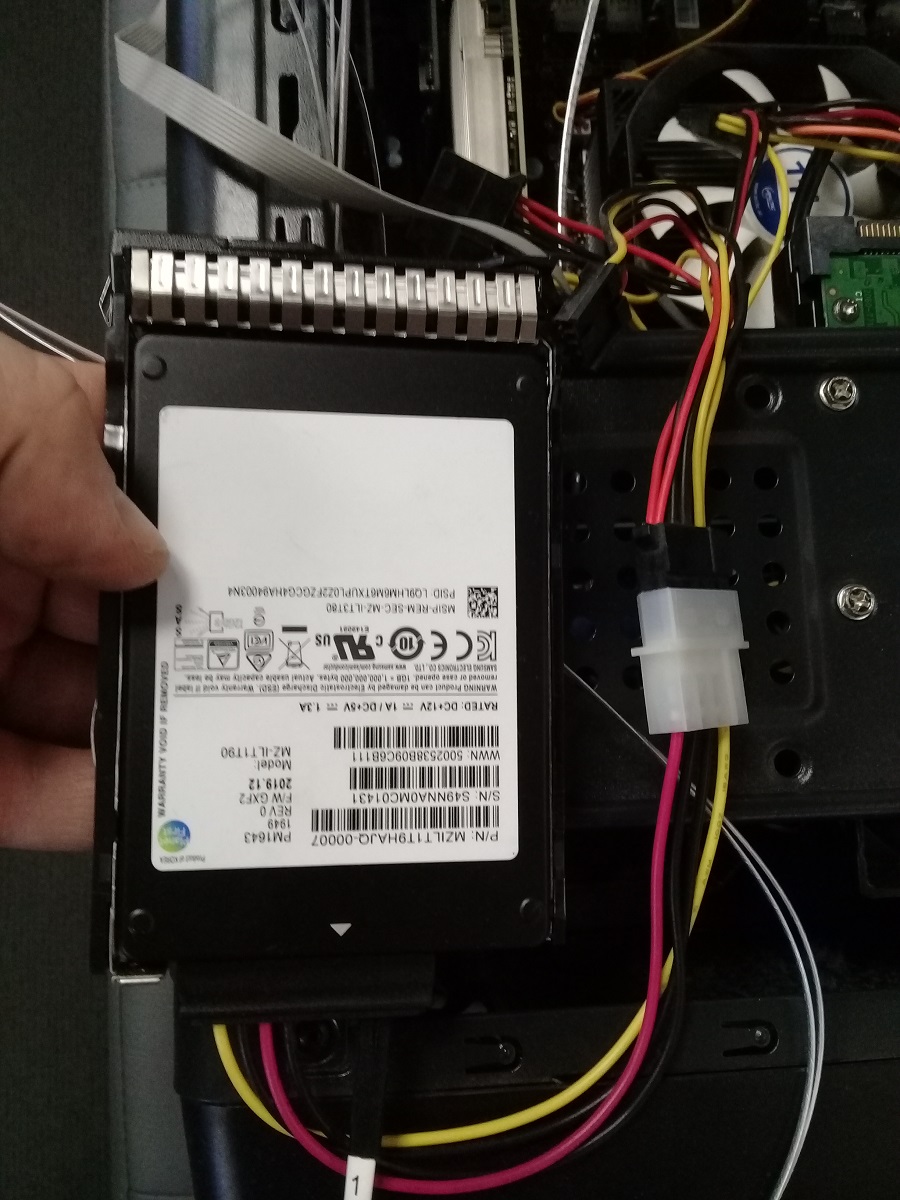

Подключаем диск через переходник.

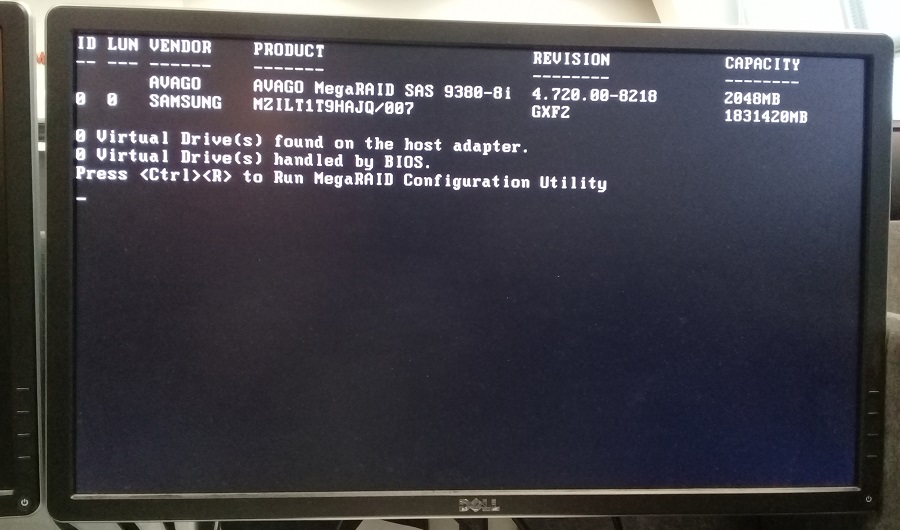

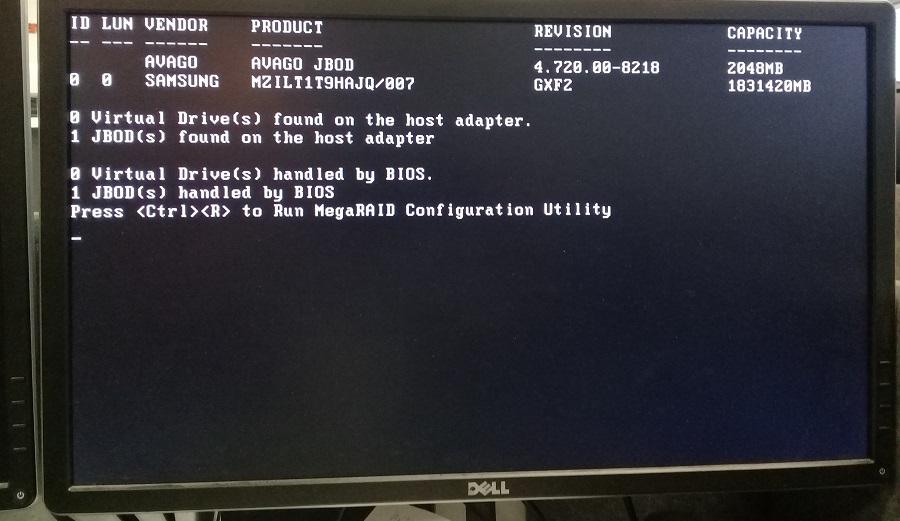

RAID контроллер определился. Видим, что диск SAMSUNG тоже определился.

Для доступа в конфигурационную утилиту MegaRAID Configuration Utility нажимаем Ctrl+R.

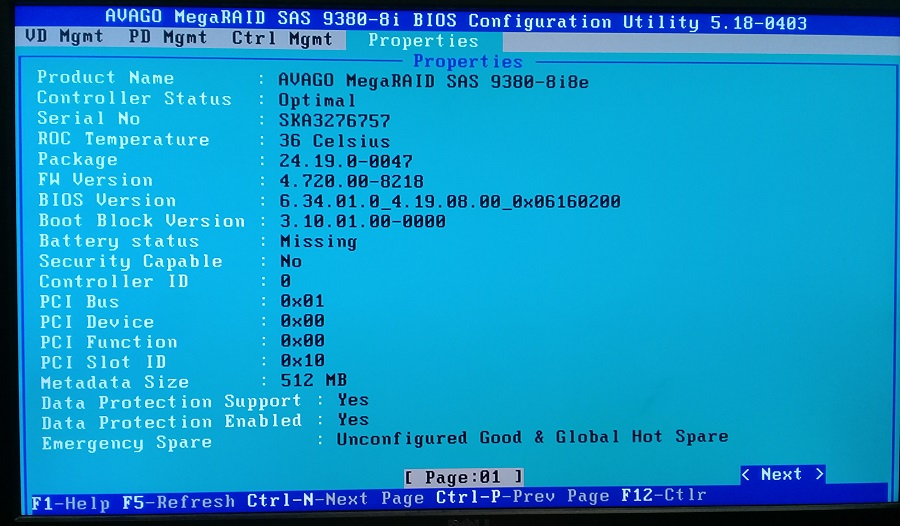

Можем посмотреть настройки контроллера.

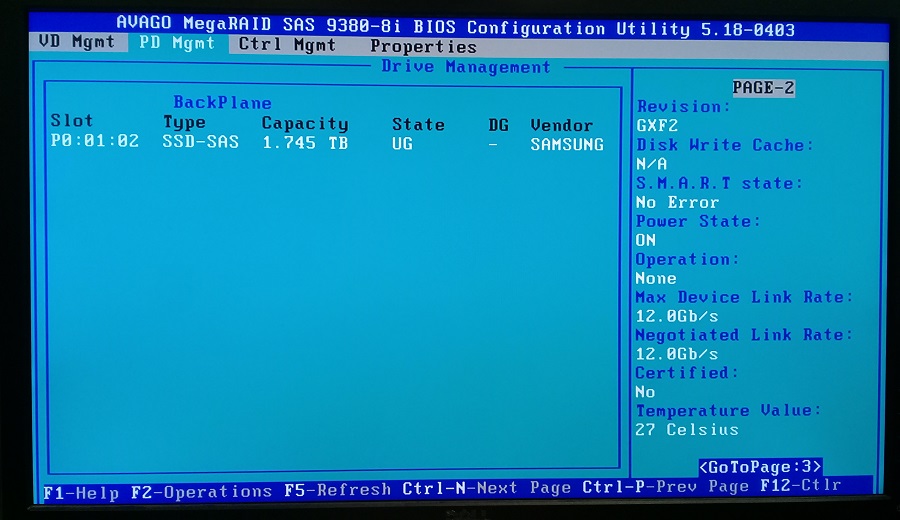

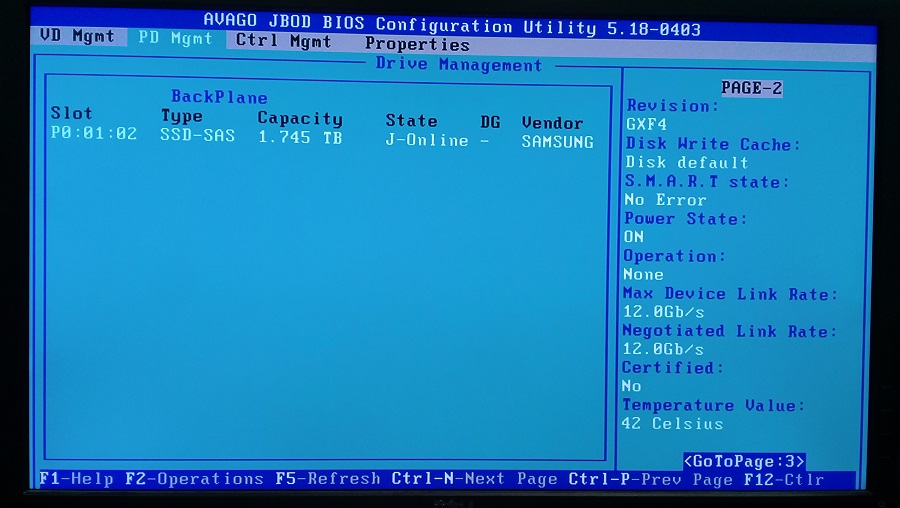

Можем посмотреть физические диски. Я подключал только один диск, он определился. Обратите внимание, что состояние диска UG — Unconfigured Good.

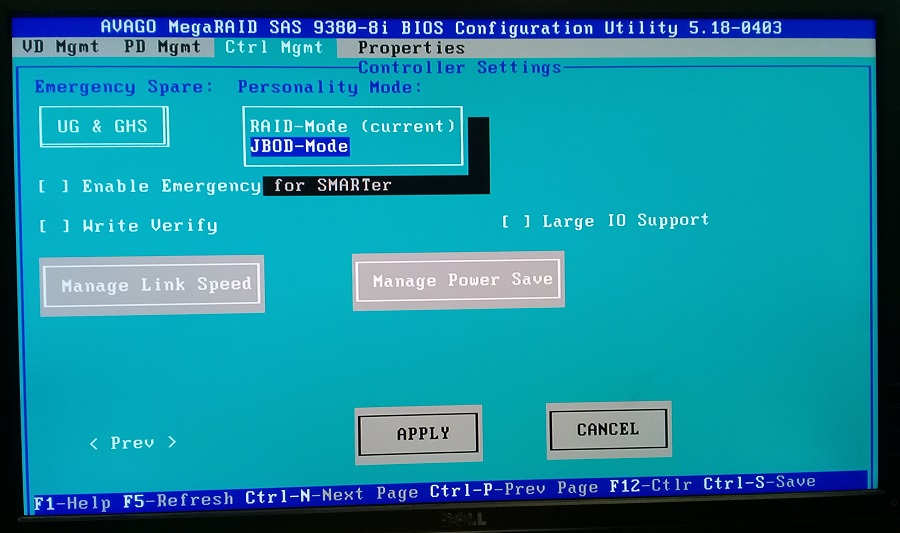

RAID контроллер по умолчанию показывает операционной системе не физические диски а RAID массивы. Я же хочу просто пробросить диск. Для этого необходимо RAID контроллер переключить в режим HBA.

В настройках контроллера меняем режим на JBOD-Mode. Применяем изменения и перезагружаем компьютер.

При загрузке уже 1 JBOD найден и handled by BIOS, это уже хорошо. Для проверки снова зайдем в настройки контроллера.

Диск в состоянии J-Online. Загружаем операционную систему.

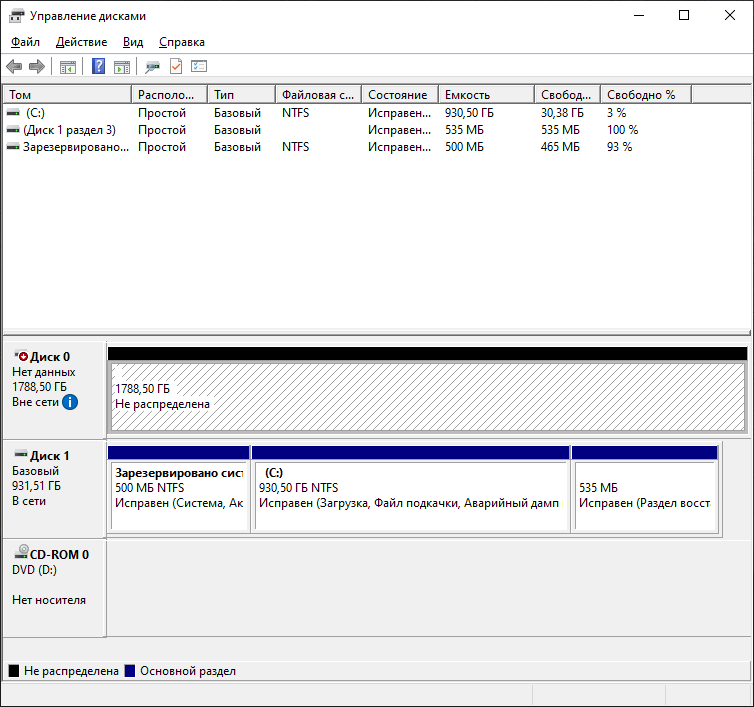

Появился новый Диск 0.

Подключение SAS диска через HBA адаптер LSI SAS 9300-4i4e

Подключаем к адаптеру переходник.

Устанавливаем адаптер в PCIe слот и подключаем диск.

Для входа в настройки адаптера нужно нажать Ctrl+C.

4 и более SATA/SAS дисков: кабели, корзины, контроллеры. Мультиобзор

Если дисков компьютере пара-тройка, подключение их простое. Но если дисков захотелось много — возникают особенности. На КДПВ SAS кабель с Али, уже проскакивавший в прошлом обзоре про ленту, так неожиданно тепло встреченным сообществом. Спасибо, камрады. Попробую затронуть тему, потенциально полезную чуть более широкому кругу. Хотя и специфическую. Начну с этого кабеля и обязательной программы, но только для затравки. Разные кусочки пазла приходится собирать в разных местах.

Хочу сразу предупредить, что текст получился плотный и довольно тяжёлый. Заставлять себя читать и понять всё это уж точно не обязательно. Много картинок!

Кто-то скажет, 9 баксов за тупой кабель? Что делать, в быту это применяется крайне редко, а на промышленные вещи тиражи ниже, а цены — выше. За сложный SAS кабель и сотню-другую баксов могут не моргнув глазом выставить. Так что китайцы ещё кратно снижают 🙂

Доставка и упаковка

Заказ 6 мая 2017, получено 17 мая — просто ракета. Трек был.

Обычный серый пакет, внутри ещё один — вполне достаточно, товар не хрупкий.

Спецификация

Мама-папа SFF-8482 SAS 29 пин кабель.

Длина 50 см

Масса нетто 66 г

Картинка продавца

Реальный внешний вид, как видите — отличается

За лишнюю пластмассу продавец получил 4 звезды вместо 5, но на работоспособность не влияет.

Про SAS и SATA разъёмы

Что такое SFF-8482 и с чем его едят? Во-первых, это самый массовый разъём на SAS устройствах (Вика о SAS), например, на моём лентопротяге

А ещё SFF-8482 прекрасно садится на SATA диск (но не наоборот)

Сравните, у SATA между данными и питанием промежуток. А у SAS он заполнен пластмассой. Поэтому SATA разъём на SAS устройство не налезет.

Конечно, в этом есть смысл. По сигналам SAS и SATA разные. И SATA контроллер не сможет работать с SAS устройством. A SAS — контроллер сможет и с тем и с другим (хотя встречается совет не смешивать при определённых обстоятельствах, дома вряд ли реальных)

SAS контроллеры и экспандеры

Ну и что, спросит читатель. Что я выигрываю от такой совместимости? Мне и SATA контроллеров достаточно!

Истинная правда! Если достаточно — на этом месте можно нужно бросать читать. Вопрос был что делать, если МНОГО дисков?

Вот так выглядит простенький SAS контроллер из моего зипа — DELL H200.

Мой прошит в HBA, то есть все диски оси видны отдельно

А это древний SAS RAID HP

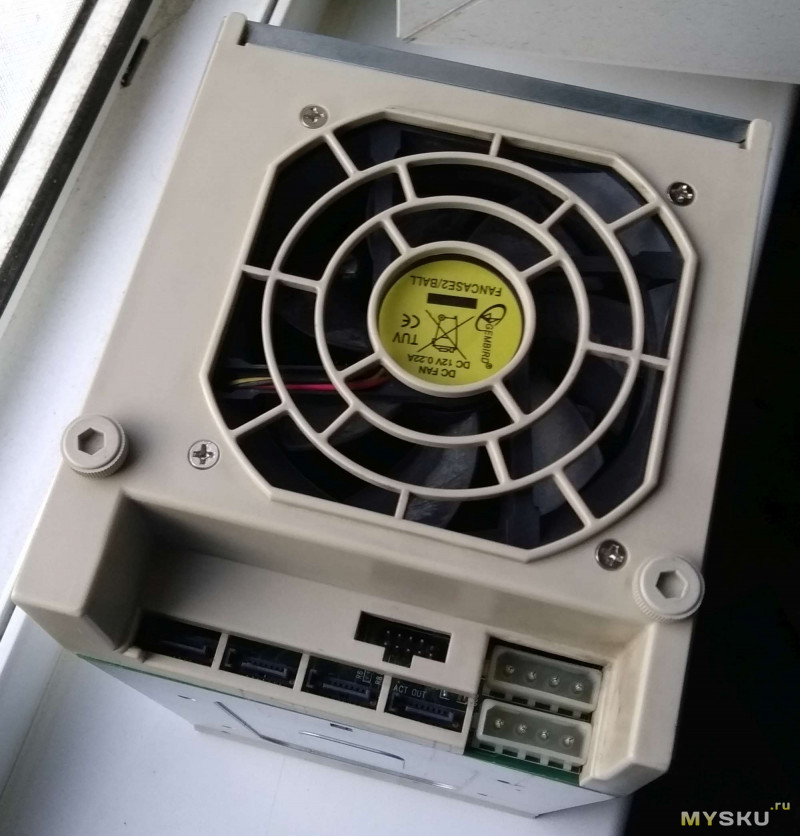

У обоих мы видим внутренние разъёмы (называются sff 8087 или, чаще, miniSAS) и один внешний — sff 8088

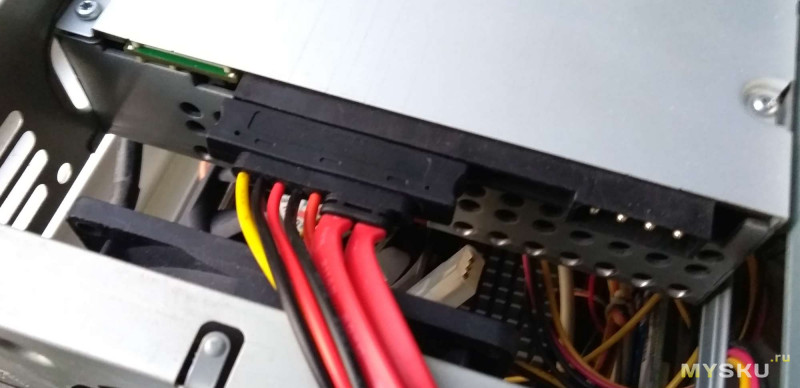

Сколько дисков можно подключить на один miniSAS? Ответ зависит. Тупым кабелем — 4шт, то есть 8 на такой контроллер. Кабель из моего ЗИП выглядит вот так

На одном конце miniSAS, на другом — 4шт SATA (и ещё один разъём, о нём ниже)

Но можно взять miniSAS-miniSAS кабель и подключить к экспандеру, то есть размножителю портов. И контроллер потянет до 256 (двухсот пятидесяти шести) дисков. Причём скорости канала хватит уж на десятки дисков — точно.

Экспандер как отдельная карта выглядит, например, как мой Ченбро

А может быть распаян на дисковой корзине. Тогда в неё может идти всего один miniSAS канал (а может — больше). Вот такими кабелями.

Согласитесь, кабель менеджмент несколько упрощается 🙂

Корзины

Понятно, диски прекрасно могут работать и без специальных корзин. Но иногда корзины могут быть полезны.

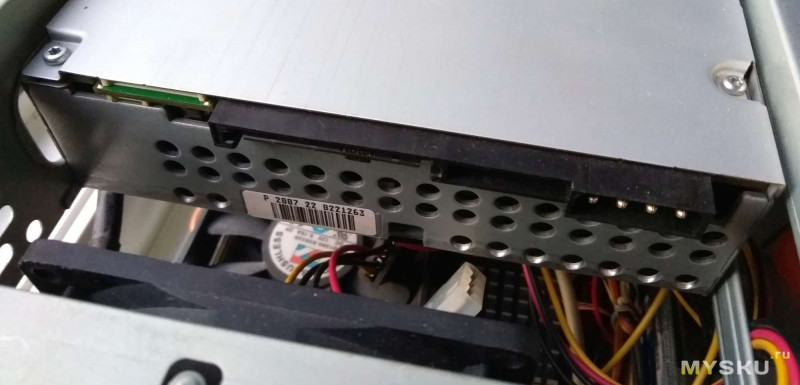

Вот так выглядит SATA корзинка старой модели Супермикро. Можно найти за 1000 р, но скорее за 5+ тыс.

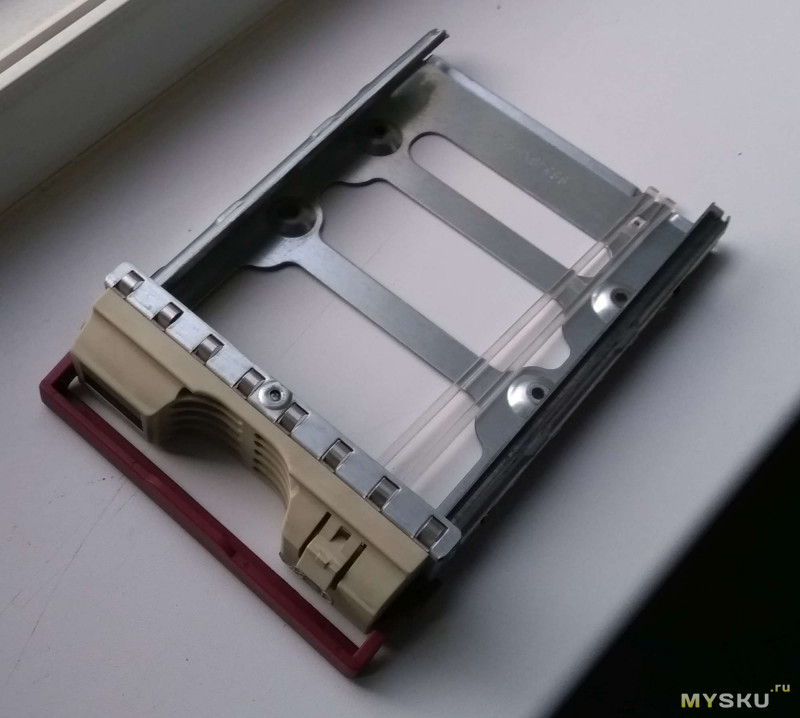

Её лоток для диска

Вид изнутри, видно, что там SATA разъёмы.

Если корзинка SAS — ещё лучше, меньше проводов. Если SCSI или FC — использовать её вы не сможете. Я взял одну 19″ FC на пробу — ничего полезного не сделал. Там, правда, лома цветмета оказалось почти на те деньги, за которые купил.

Вид сзади, видим 4 SATA, 2 MOLEX и тот самый порт, что был на кабеле. Предназначен для управления LED активности дисков.

Вот так выглядит одна из самых простых корзинок (моделей много разных, но похожих)

Именно такие уже не продают, так что детали не важны. Просто кусок металла с амортизаторами и карлсоном впереди.

Вот так это выглядело в 2013 году, когда я переводил железо в корпус побольше

Картонный костыль внизу и третья корзина были только на момент для перекачки данных с 2T дисков на 4T. С тех пор работает 24/7.

SAS+SATA у меня

Точнее работало до того, как мне понадобилось подключить лентопротяг. Первым делом я воткнул второй SAS контроллер, купил кабель miniSAS на sff 8482, примерно такой

И включил. Всё заработало, но в режиме 24/7 каждый ватт стоит денег. Я искал переходники с sff 8482 на SATA, но решение оказалось ещё проще. Вы же помните, что SATA диск подключается на SAS sff 8482?

Вот я теперь тоже помню, но тогда пару месяцев тупил 🙂 А потом вынул лишний контроллер, переключил один из дисков на чипсетный порт SATA порт, три остальных на sff 8482. Пришлось менять подключение питания, был разветвитель Molex-SATA, пришлось покупать на Али Molex-много Molex. Вот такой

Брал здесь, всё хорошо.

А лентопротяг переехал в другой корпус именно с использованием обозреваемого кабеля. Но это отдельная песня, а, караул, чувствую, устал 🙂

Где всё это выгоднее искать

Цены на новое серверное железо для дома запретительны. Так что бу, в том числе из ЗИП от выводимого из эксплуатации оборудования.

Кабели можно найти на месте. За сравнимые деньги на e-bay. На Али — несколько менее вероятно, но бывают исключения — я же купил.

Контроллеры — прежде всего на e-bay, причём из Европы. Можно из США, там сильно дешевле, если как-то решить вопрос с доставкой. Можно найти на Родине — авито. (На комке — дорого). В Китае покупать очень опасно. Множество жалоб на подделку из отбраковки. То работает, то нет. Никому ничего не докажешь.

Корзины разумнее искать локально. Есть даже варианты простейшие корзины покупать новые. Простые корзины без электроники можно брать и в Китае и в Европе и на барахолке. Корзины с экспандерами — см пункт про контроллеры.

PS Если для вас это стало выступлением Капитана Очевидность — прошу прощения за отнятое время.

Если бредом сивой кобылы — тем более мои искренние извинения. Трудно балансировать, хотелки, задачи и исходные у каждого свои.

Да, про кабель же! Продавца рекомендую, кабелем доволен, доставка молниеносная.

Конспект админа: отличие микроскопа от молотка при построении SAN (обновлено)

Однажды один из клиентов компании-интегратора, где я работал, попросил оперативно нарисовать проект небольшой системы хранения данных. Как назло, специальный человек по SAN оказался недоступен и задачу поручили мне. На тот момент мои знания по СХД сводились к непробиваемой идее «Fibre Channel – это круто, а iSCSI – не очень«.

Для всех тех, кто попал в похожую ситуацию или немного интересуется темой SAN, мы подготовили цикл материалов в формате «конспект». Сегодняшняя статья посвящена технологиям хранения для небольших и средних организаций. Постараюсь не занудствовать с теорией и использовать побольше примеров.

СХД различные и в меру необычные

Если инженер не особенно знаком с сетями хранения данных (СХД), то выбор подходящего устройства часто начинается с изучения рынка в преломлении собственных стереотипов. Например, я в свое время обычно останавливался на простых DAS-системах, что удивительно дополняло своей нелогичностью тезис про «крутость» Fibre Channel. Зато DAS был понятным и не требовал чтения длинных руководств администратора и погружения в темный мир сетей хранения.

Если в организации просто заканчивается место на общем сетевом диске, то хватит и недорогого сервера с относительно высокой плотностью дисков, в качестве задела на будущее. Из специализированных систем неплохо подойдет сетевое файловое хранилище (NAS), вроде Synology DS414 SLim. На нем и общие папки создавать удобно, и права гибко настраиваются, и с Active Directory интеграция есть.

Чем мне нравятся хранилища Synology, так это удобным интерфейсом с множеством плагинов на любые сценарии использования. Но поведение у них бывает весьма странным. Например, у одного заказчика был Synology DS411+II. Работал прекрасно до очередной перезагрузки, после которой не включился. Не спрашивайте, как я до этого дошел, но алгоритм запуска после сбоя был следующий:

1. Вынуть все диски, включить устройство, выключить устройство;

2. Воткнуть один диск, включить устройство, выключить устройство;

3. Воткнуть второй диск, включить устройство, выключить устройство;

4. Повторить для третьего и четвертого диска. После установки четвертого диска, устройство включается и работает.

Способ был опубликован на форуме Synology и оказалось, что я не один такой везучий. С тех пор предпочитаю небольшие серверы с GNU\Linux на борту, у них хотя бы с диагностикой проще.

Из сборок для NAS могу порекомендовать Openmediavault.

Все усложняется когда нужно нарастить дисковый объем имеющихся серверов или появляются мысли о высокой доступности. Тут-то и возникает соблазн построить полноценную NAS или впасть в другую крайность, ограничившись простой дисковой полкой DAS.

SAN, Storage Area Network – архитектурное решение для подключения по сети внешних устройств хранения данных, вроде дисковых массивов и ленточных библиотек. Причем, подключить на блочном уровне, чтобы клиент работал с ними так же, как с обыкновенными локальными дисками. В русскоязычной литературе используется аббревиатура СХД (Сеть Хранения Данных) – не путайте с Системой Хранения Данных, которой может считаться любая дисковая полка.

В этой статье я не буду касаться программных реализаций, вроде Storage Spaces в среде Windows, а ограничусь железными и архитектурными нюансами СХД.

Зачем отдельная сеть хранения

Начнем с типовых решений для хранения данных, которые предполагают использование специальных сетей и интерфейсов, так как с ними больше всего вопросов.

Самым недорогим способом организации SAN является интерфейс Serial Attached SCSI (SAS). Тот самый, с помощью которого подключаются диски в любом современном сервере. Используют SAS и для прямого подключения внешнего дискового массива к серверу.

Для массива DAS возможна организация отказоустойчивого подключения к нескольким серверам. Делается это с помощью Multipath, технологии коммутации клиента и СХД по нескольким маршрутам. Но большей популярностью пользуется разделение дисков между серверами, которые уже самостоятельно собирают из них группы RAID и делят на тома. Подобная схема называется «Разделяемый JBOD».

Для подключение к серверу используются адаптеры (HBA) под конкретный интерфейс, которые просто позволяют ОС увидеть готовые дисковые тома.

Стоит отметить, что SAS поддерживает три стандарта:

SAS-1, со скоростью 3 Гб/с на устройство;

SAS-2, со скоростью 6 Гб/с;

При планировании архитектуры стоит также иметь в виду отличия в разъемах SAS, что часто приводит к путанице при заказе кабелей. Самыми популярными при подключении внешнего оборудования являются SFF-8088 (mini-SAS) и SFF-8644 (mini-SAS HD).

Являясь частностью SCSI, SAS поддерживает экспандеры, что позволяет подключать до 65 535 устройств к одному контроллеру и порту. Конечно, цифра скорее теоретическая и не учитывает различные накладные расходы. Чаще всего встречаются контроллеры с реальным ограничением в 128 дисков, но масштабировать подобный SAN для двух и более серверов простыми экспандерами уже не так удобно. В качестве более адекватной альтернативы можно использовать коммутаторы SAS. По сути, это те же экспандеры, но с поддержкой распределения ресурсов по серверам, т.н «зонирование». Например, для стандарта SAS-2 наибольшей популярностью пользуется LSI 6160.

С помощью коммутаторов SAS возможна реализация отказоустойчивых схем для нескольких серверов без единой точки отказа.

Из плюсов использования SAS можно отметить:

Низкую стоимость решения;

Высокую пропускную способность – даже при использовании SAS-2 получится 24 Гб/с на каждый порт контроллера;

Не обошлось и без минусов:

Отсутствуют механизмы репликации средствами дискового массива;

В качестве типового решения для малых и средних организаций разберем создание небольшого отказоустойчивого кластера виртуальных машин. Под кластер выделим два узла с единственным дисковым массивом. В качестве условного среднего объема дискового тома выберем 1 ТБ.

Замечу, что программными решениями вроде StarWind Native SAN можно получить такой же кластер без отдельного дискового массива, или же с простыми JBOD. Кроме того, большинство гипервизоров поддерживают в качестве хранилищ сетевые ресурсы NFS или SMB 3.0. Но в программных реализациях больше нюансов и «слабых звеньев» из-за большей сложности системы. Да и производительность обычно ниже.

Для сборки такой системы понадобится:

Дисковый массив возьмем для примера HP MSA 2040 с двенадцатью отсеками под HDD. Для подключения будем использовать SAS 3.0 на скорости 12 Гб/с. Посчитаем первым попавшимся конфигуратором общую стоимость системы хранения:

| Дисковая полка HP MSA 2040 | 360 250 ₽ |

| Dual Raid Controller 8×12 Gb SAS | 554 130 ₽ |

| HDD 600GB SAS 12G x4 | 230 560 ₽ |

| Кабель mSAS внешний 2м x4 | 41 920 ₽ |

| HP SmartArray P441 8-external channel SAS 12G x2 | 189 950 ₽ |

| Итого | 1 376 810 ₽ |

А вот и схема подключения:

Каждый сервер будет соединятся с каждым контроллером СХД для Multipathing.

На мой взгляд, SAS 3.0 оптимален, если не нужны распределенные SAN-сети и не требуется детальное разграничение прав доступа к СХД. Для небольшой организации так можно достичь отличного баланса цены и производительности.

После приобретения второго массива в будущем станет возможным соединение каждого сервера с контроллером каждой дисковой полки, но при росте числа клиентов это серьезно усложнит архитектуру. Для большего числа клиентов лучше приобрести один SAS коммутатор. Или два, для построения отказоустойчивого решения.

Традиционным выбором для построения SAN является Fibre Channel (FC) – интерфейс, связующий узлы сети по оптическому волокну.

FC поддерживает несколько скоростей: от 1 до 128 Гб/с (стандарт 128GFC вышел как раз в 2016). В основном используются 4GFC, 8GFC и 16GFC.

Существенные различия по сравнению с SAS-системами проявляются при проектировании крупных SAN:

Расширение производится не за счет экспандеров, а возможностями топологии сети;

В небольших организациях обычно применяют структуру с одним коммутатором (single-switch), когда один сервер через один коммутатор подключается к дисковому массиву. Такая схема составляет основу остальных топологий: каскад (cascade), решетка (mesh) и кольцо (ring).

Наиболее масштабируемая и отказоустойчивая схема называется «центрально-распределенная» (core-edge). Она напоминает известную всем сетевую топологию “звезда”, но только в середине два центральных коммутатора, распределяющих трафик по периферийным. Частным случаем этой схемы является “коммутируемая архитектура” (switched fabric), без периферийных коммутаторов.

При проектировании стоит обратить внимание на разные типы трансиверов. Это специальные модули, которые преобразуют цифровой сигнал в оптический, для чего используются светодиоды или лазерные излучатели. Трансиверы поддерживают разные длины волны и разные оптические кабели, что влияет на протяженность сегмента.

Есть два типа трансиверов:

Коротковолновые (Short Wave, SW, SX) – подходят только для многомодовых волокон;

К обоим типам кабель подключается разъемом LC, а вот SC-разъемы встречаются довольно редко.

Типичный HBA c двумя портами FC

При выборе оборудования для SAN не лишним будет проверить все компоненты по таблицам совместимости производителя железа. Активное сетевое оборудование всегда лучше выбирать одного бренда, чтобы избежать проблем совместимости даже в теории – это стандартная практика для подобных систем.

К плюсам решений на FC можно отнести:

Возможность построения территориально распределенной SAN;

Высокая скорость передачи данных;

На другой чаше весов традиционно лежит стоимость.

Системы хранения из раздела про SAS можно построить и на 16GFC, заменив лишь HBA и контроллер дисковой полки. Стоимость при этом вырастет уже до 1 845 790 ₽.

В своей практике я встречал у заказчика даже построенный на FC массив DAS, заполненным дисками менее, чем наполовину. Почему не использовали SAS? Самый оригинальный ответ был такой: «а что, можно было?».

В более сложной инфраструктуре FC становится структурно более похож на TCP\IP. У протокола также описаны уровни, как и у стека TCP\IP, существуют маршрутизаторы и коммутаторы, описано даже «тегирование» для изоляции сегментов на манер VLAN. Кроме того, на FC-коммутаторах исполняются службы разрешения имен и обнаружения устройств.

Не буду углубляться в тонкости, ведь на тему FC написано уже немало хороших статей. Обращу внимание лишь на то, что при выборе коммутаторов и маршрутизаторов для SAN нужно обращать внимание на логические типы портов. В разных моделях поддерживаются разные сочетания основных типов из таблицы:

| Тип Устройства | Наименование | Описание |

| Сервер | N_Port (Node port) | Используется для подключения к коммутатору или конечному устройству. |

| NL_Port (Node Loop port) | Порт с поддержкой топологии «петля». | |

| Коммутатор\ Маршрутизатор | F_Port (Fabric port | Для подключения N_Port, «петля» не поддерживается. |

| FL_Port (Fabric Loop port), | Порт с поддержкой «петли». | |

| E_Port (Expansion port | Порт для соединения коммутаторов. | |

| EX_port | Порт для соединения коммутатора и маршрутизатора. | |

| TE_port (Trunking Expansion port) | E-port с поддержкой VSAN. | |

| Общие | L_Port (Loop port) | Любой порт с поддержкой петли (NL_port или FL_port). |

| G_port (Generic port) | Любой незанятый порт устройства с авто определением. |

Статья была бы неполной без упоминания варианта построения SAN на InfiniBand. Этот протокол позволяет достичь действительно высоких скоростей передачи данных, но по стоимости выходит далеко за рамки SMB.

Использование привычного Ethernet

Можно обойтись и без изучения новых видов сетей, используя старый добрый Ethernet.

Популярный протокол для создания SAN в Ethernet-сетях называется Internet Small Computer Systems Interface (iSCSI). Строится он поверх TCP\IP, и основной его плюс в приличной работе по обычной гигабитной сети. В обиходе такие решения часто называют «бесплатный SAN». Разумеется, гигабита под серьезные задачи не хватит, и к вашим услугам сети 10 Гб/с.

К безусловным плюсам можно отнести низкую стоимость базового оборудования. Так как iSCSI реализуется программно, можно установить соответствующие приложения на обычные серверы. Большинство NAS класса SOHO поддерживают этот протокол изначально.

У заказчика однажды остро встал вопрос перемещения Exchange 2003 с умирающего сервера. Решили виртуализировать его с минимальным простоем. Для этого подняли iSCSI-target на том самом NAS Synology DS411 из первой части статьи и подключили к Exchange. Далее перенесли туда БД и мигрировали на MS Virtual Server 2005 c помощью disk2vhd. После успешной миграции перенесли базу обратно. Позже такие операции проводились при переходе с MS Virtual Server на VMware.

Разумеется, для построения SAN на iSCSI, даже если для задач хватает и гигабитной сети, не стоит «выпускать» его в общий LAN. Работать оно будет, но широковещательные запросы и прочий служебный трафик непременно скажутся на скорости и создадут помехи пользователям. Лучше построить отдельную изолированную сеть со своим оборудованием. Или, в крайнем случае, хотя бы выделить подсеть с iSCSI в отдельный VLAN. Стоит отметить, что для достижения максимальной производительности таких систем необходимо включать поддержку Jumbo Frames на всем пути следования пакетов.

В качестве меры экономии бюджета может возникнуть мысль об объединении гигабитных портов при помощи агрегации каналов (LACP). Но, как правильно заметил VitalKoshalew в комментариях, реальной балансировки между отдельным сервером и хранилищем с помощью LACP не получится. Более правильным бюджетным решением будет использование технологий Multipath на верхних уровнях модели OSI.

К слову, совсем правильное iSCSI-решение на базе 10 Гб сети, с поддерживающими аппаратное ускорение iSCSI сетевыми картами и соответствующими коммутаторами приближается по стоимости к FC.

Подобная схема сети возможна благодаря тому, что iSCSI работает поверх TCP\IP.

Из интересных решений на базе iSCSI можно отметить работу тонких клиентов без сервера терминалов – вместо локальных дисков используется том iSCSI. Гигабитной сети вполне достаточно для такой работы, а реализовать что-либо подобное другими средствами не так просто.

Возможность построения территориально распределенной сети;

Задержки при обращении к данным могут быть существенными, особенно при работе с пулом виртуальных машин;

Есть и более «взрослая» альтернатива iSCSI. Можно использовать ту же сеть Ethernet, но протокол хранения завернуть непосредственно в кадры Ethernet, минуя TCP\IP. Протокол называется Fibre Channel over Ethernet (FCoE) и для работы использует Ethernet 10 Гб. Помимо традиционной оптики, можно использовать специальные медные кабели или витую пару категории 6a.

Важное отличие от FC в том, что порт Ethernet можно использовать совместно с TCP\IP. Для этого нужны специальные сетевые адаптеры, так называемые Converged Network Adapter (CNA) с поддержкой FC и FCoE, хотя есть и программные решения. Поскольку протокол работает ниже уровня TCP\IP, то простой коммутатор не подойдет. Кроме того, обязательно должна быть поддержка Jumbo Frames и Data Center Bridging (DCB, иногда встречается Data Center Ethernet). Подобные решения обычно стоят дороже (например, Cisco серии Nexus).

В теории, FCoE можно запустить и в гигабитной сети без использования DCB, но это весьма неординарное решение, для которого я не встречал рассказов об успешных запусках.

Если вернуться к нашему маленькому, но гордому кластеру виртуализации, то для него решения на 10 Гб/с iSCSI и FCoE будут практически одинаковыми по стоимости, но в случае с iSCSI можно использовать дешевые гигабитные сети.

Также стоит упомянуть и довольно экзотичный протокол ATA over Ethernet (AoE), схожий по своей работе с FCoE. Дисковые массивы с ним – редкость, обычно используются программные решения.

Что в итоге

Выбор конкретной реализации системы хранения требует вдумчивого изучения конкретной ситуации. Не стоит подключать дисковый массив с помощью FC просто потому, что «оптика» звучит гордо. Решение на SAS даст аналогичную или даже большую производительность там, где оно архитектурно уместно. Если не брать в расчет стоимость и сложности обслуживания, то существенным отличием между всеми описанными технологиями подключения СХД будет дистанция соединений. Эту мысль хорошо иллюстрирует один из кадров презентации SNIA:

Если после прочтения статьи хотите подробнее изучить самобытный мир SAN, могу порекомендовать следующие бестселлеры:

Мы раздумываем над публикацией других статей по серверным технологиям в формате «ликбез», поэтому было бы здорово получить от вас обратную связь в виде оценки этого материала. Если какие-то темы вам особенно интересны – обязательно расскажите о них в комментариях.