В чем заключается объемный подход при измерении информации

kpet-ks.ru

Компьютерные сети. г.Котово

Подходы к измерению количества информации

1.Алфавитный (объёмный) подход к измерению информации

Теория:

N=2 i

Для измерения информации используются и более крупные единицы:

2.Содержательный поход

В содержательном подходе количество информации, заключенное в сообщении, определяется объемом знаний, который это сообщение несет получающему его человеку.

Вспомним, что с «человеческой» точки зрения информация — это знания, которые мы получаем из внешнего мира. Количество информации, заключенное в сообщении, должно быть тем больше, чем больше оно пополняет наши знания.

Вы уже знаете, что за единицу измерения информации принимается 1 бит.

1 бит — минимальная единица измерения количества информации.

Проблема измерения информации исследована в теории информации, основатель которой — Клод Шеннон.

В теории информации для бита дается следующее определение:

Сообщение, уменьшающее неопределенность знания в два раза, несет 1 бит информации.

Что такое неопределенность знания, поясним на примерах.

Допустим, вы бросаете монету, загадывая, что выпадет: орел или решка. Есть всего два возможных результата бросания монеты. Причем ни один из этих результатов не имеет преимущества перед другим. В таком случае говорят, что они равновероятны.

В случае с монетой перед ее подбрасыванием неопределенность знания о результате равна двум.

Игральный же кубик с шестью гранями может с равной вероятностью упасть на любую из них. Значит, неопределенность знания о результате бросания кубика равна шести.

Еще пример: спортсмены-лыжники перед забегом путем жеребьевки определяют свои порядковые номера на старте. Допустим, что имеется100 участников соревнований, тогда неопределенность знания спортсмена о своем номере до жеребьевки равна 100.

Следовательно, можно сказать так:

Неопределенность знания о результате некоторого события (бросание монеты или игрального кубика, вытаскивание жребия и др.) — это количество возможных результатов.

Вернемся к примеру с монетой. После того как вы бросили монету и посмотрели на нее, вы получили зрительное сообщение, что выпал, например, орел. Определился один из двух возможных результатов. Неопределенность знания уменьшилась в два раза: было два варианта, остался один. Значит, узнав результат бросания монеты, вы получили 1 бит информации.

Сообщение об одном из двух равновероятных результатов некоторого события несет 1 бит информации.

Пусть в некотором сообщении содержатся сведения о том, что произошло одно из Nравновероятных событий.

Тогда количество информацииi, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, можно определить из формулы Хартли:

Данная формула является показательным уравнением относительно неизвестногоi.

Из математики известно, что решение такого уравнения имеет вид:

i=log2N– логарифм N по основанию 2.

Если N равно целой степени двойки (2,4,8,16и т. д.), то такое уравнение можно решить «в уме».

Шахматная доска состоит из64 полей:8 столбцов на 8 строк.

Какое количество бит несет сообщение о выборе одного шахматного поля?

Решение.

Поскольку выбор любой из 64 клеток равновероятен, то количество бит находится из формулы:

2 i =64,

i=log264=6, так как 2 6 =64.

Следовательно, i=6 бит.

В противном случае количество информации становится нецелой величиной, и для решения задачи придется воспользоваться таблицей двоичных логарифмов.

Также, если N не является целой степенью 2, то можно выполнить округление i в большую сторону. При решении задач в таком случаеi можно найти какlog2K, гдеK— ближайшая к Nстепень двойки, такая, что K>N.

При игре в кости используется кубик с шестью гранями.

Сколько битов информации получает игрок при каждом бросании кубика?

Решение.

Выпадение каждой грани кубика равновероятно. Поэтому количество информации от одного результата бросания находится из уравнения:2 i =6.

Решение этого уравнения: i=log26.

Из таблицы двоичных логарифмов следует (с точностью до3-х знаков после запятой):

i=2,585бита.

Данную задачу также можно решить округлением i в большую сторону: 2 i =6 3 ,i=3 бита.

3.Вероятностный подход

В реальной жизни существует множество ситуаций с различными вероятностями. Например, если у монеты одна сторона тяжелей другой, то при ее бросании вероятность выпадения «орла» и «решки» будет различной.

Сначала разберемся с понятием «вероятность». Введем следующие понятия:

испытание – любой эксперимент;

единичное испытание – испытание, в котором совершается одно действие с одним предметом (например, подбрасывается монетка, или из корзины извлекается шар);

исходы испытаний – результаты испытания (например, при подбрасывании монеты выпал «орел», или из корзины извлекли белый шар);

множество исходов испытания – множество всех возможных исходов испытания;

случайное событие – событие, которое может произойти или не произойти (например, выигрыш билета в лотерее, извлечение карты определенной масти из колоды карт).

Вероятностью случайного события (p) называется отношение числа благоприятствующих событию исходов (m) к общему числу исходов (n):

Заметим, что вероятность случайного события может изменяться от 0 до 1.

Пример:

В беспроигрышной лотерее разыгрывается 3 книги, 2 альбома, 10 наборов маркеров, 10 блокнотов.

Какова вероятность выиграть книгу?

Общее число исходов 2+3+10+10=25; число благоприятствующих исходу событий равно 3. Вероятность выигрыша книги вычисляется по формуле: p=3/25=0,12.

Заметим, что во многих случаях события происходят с разной вероятностью, а значит формула N=2 i не всегда применима.

Вероятностный подход предполагает, что возможные события имеют различные вероятности реализации.

В этом случае, зная вероятность (p) событий, можно определить количество информации (i) в сообщении о каждом из них из формулы:

Количество информации будет определяться по формуле Шеннона, предложенной им в 1948 г. для различных вероятностных событий:

где I – количество информации;

N – количество возможных событий;

pi – вероятность i-го события.

Качественная связь между вероятностью события и количеством информации в сообщении состоит в следующем: чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

В корзине лежат 8 черных шаров и 24 белых. Сколько бит информации несет сообщение о том, что достали черный шар?

Решение. Общее число исходов: 8+24=32, число благоприятствующих исходу событий равно 8.

Вероятность выбора черного шара определяется как p=8/32=1/4=0,25.

Количество информации вычисляем из соотношения 2 i =1/0,25=1: (1/4)=4,

Пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий равны:

Тогда количество информации, которое будет получено после реализации одного из событий, можно вычислить по формуле Шеннона:

Измерение информации. Объёмный подход

Описание разработки

При работе с информацией важно возникают вопросы связанные с измерением информации:

— достаточно ли места на носителе, чтобы разместить нужную информацию?

— сколько времени понадобиться, чтобы передать её по имеющемуся каналу связи?

Величина, которая нас интересует в этих случаях, называется ОБЪЁМОМ ИНФОРМАЦИИ.

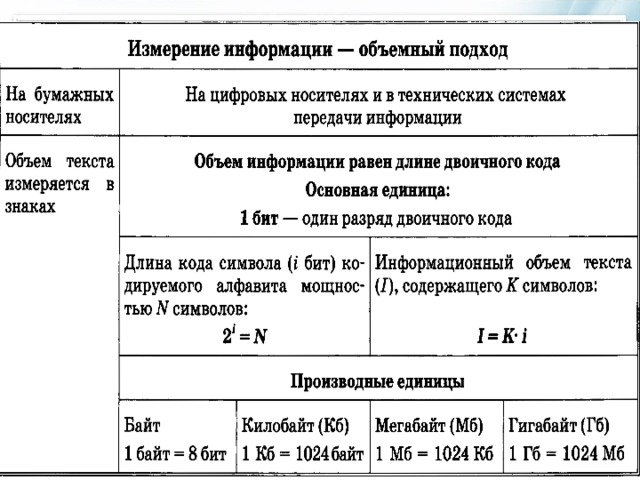

Когда говорят об объёме, то имеют ввиду размер текста в том алфавите. С помощью которого эта информация представлена.

Количество страниц не является универсальным измерением информации.

Объем информации, заключённый в тексте, разумнее измерять количеством знаков этого текста.

Объёмный способ измерения информации называют АЛФАВИТНЫМ ПОДХОДОМ.

Содержимое разработки

§3. Измерение информации. Объёмный подход.

Рыженко Е. В. МБОУ г. Астрахани » СОШ №64″

При работе с информацией важно возникают вопросы связанные с измерением информации:

Величина, которая нас интересует в этих случаях, называется ОБЪЁМОМ ИНФОРМАЦИИ.

Объём информации не связан с её содержанием.

Когда говорят об объёме, то имеют ввиду размер текста в том алфавите. С помощью которого эта информация представлена.

детскую книгу из нескольких десятков страниц можно перепечатать мелким шрифтом и без иллюстраций на 2-3 страницы.

Количество страниц не является универсальным измерением информации.

количество страниц определяет расход бумаги, а не объём информации.

объем информации, заключённый в тексте, разумнее измерять количеством знаков этого текста.

например, журналисту может быть дано ограничение на объём статьи в 40 000 знаков.

объёмный способ измерения информации называют

Для двоичного представления текстов в компьютере чаще всего используется равномерный восьмиразрядный код.

С его помощью можно закодировать 256 символов, 2 8 =256

При двоичном кодировании объём информации, выраженный в битах, равен длине двоичного кода, в котором информация представлена.

Информационный объём текста в память компьютера измеряется в байтах.

Он равен количеству знаков а записи текста.

1 Кб (килобайт) = 2 10 байт = 1024 байт

1 Мб (мегабайт) = 2 10 Кб = 1024 Кб

1 Гб (гигабайт) = 2 10 Мб = 1024 Мб

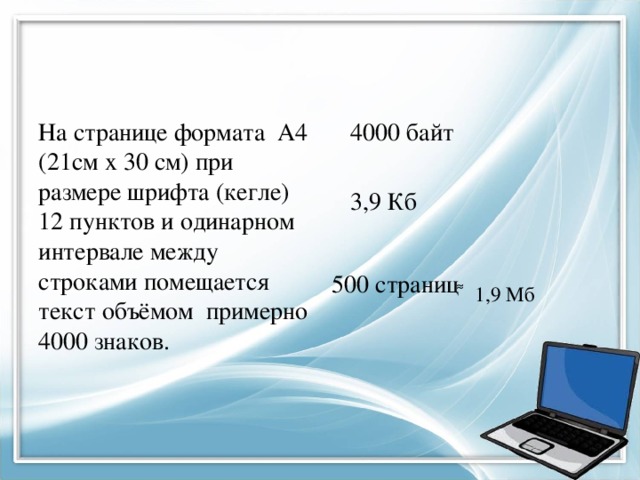

На странице формата А4 (21см х 30 см) при размере шрифта (кегле) 12 пунктов и одинарном интервале между строками помещается текст объёмом примерно 4000 знаков.

500 страниц ͌ 1,9 Мб

Учитель информатики

Сайт учителя информатики. Технологические карты уроков, Подготовка к ОГЭ и ЕГЭ, полезный материал и многое другое.

Подходы к измерению информации

§ 2. Подходы к измерению информации

Информатика. 10 класса. Босова Л.Л. Оглавление

Информация и её свойства

Информация и её свойства являются объектом исследования целого ряда научных дисциплин, таких как:

♦ теория информации (математическая теория систем передачи информации);

♦ кибернетика (наука об общих закономерностях процессов управления и передачи информации в машинах, живых организмах и обществе);

♦ информатика (изучение процессов сбора, преобразования, хранения, защиты, поиска и передачи всех видов информации и средств их автоматизированной обработки);

♦ семиотика (наука о знаках и знаковых системах);

♦ теория массовой коммуникации (исследование средств массовой информации и их влияния на общество) и др.

Рассмотрим более детально подходы к определению понятия информации, важные с позиций её измерения:

1) определение К. Шеннона, применяемое в математической теории информации;

2) определение А. Н. Колмогорова, применяемое в отраслях информатики, связанных с использованием компьютеров.

2.1. Содержательный подход к измерению информации

Клод Шеннон, разрабатывая теорию связи, предложил характеризовать информативность сообщения содержащейся в нём полезной информацией, т. е. той частью сообщения, которая снимает полностью или уменьшает существующую до её получения неопределённость какой-либо ситуации.

Клод Элвуд Шеннон (1916-2001) — американский инженер и математик. Является основателем теории информации, нашедшей применение в современных высокотехнологических системах связи. В 1948 году предложил использовать слово «бит» для обозначения наименьшей единицы информации.

Информация — это снятая неопределённость. Величина неопределённости некоторого события — это количество возможных результатов (исходов) данного события.

Сообщение, уменьшающее неопределённость знания в 2 раза, несёт 1 бит информации.

Такой подход к измерению информации называют содержательным.

Пример 1. Допустим, вы подбрасываете монету, загадывая, что выпадет: «орёл» или «решка». Перед подбрасыванием монеты неопределённость знания о результате равна двум. Действительно, есть всего два возможных результата этого события (бросания монеты). Эти результаты мы считаем равновероятными, т. к. ни один из них не имеет преимущества перед другим.

После того как конкретный исход стал известен (например, подброшенная монета упала «орлом» вверх), неопределённость уменьшилась в 2 раза. Таким образом, сообщение о том, что подброшенная монета упала «орлом» вверх, несёт в себе 1 бит информации.

Пример 2. Предположим, в книжном шкафу восемь полок. Книга может быть поставлена на любую из них. Сколько бит информации несёт сообщение о том, что книга поставлена на третью полку?

Ответ на этот вопрос можно получить, если дополнить исходное сообщение ещё несколькими сообщениями так, чтобы каждое из них уменьшало неопределённость знания в 2 раза.

Итак, количество возможных результатов (исходов) события, состоящего в том, что книга поставлена в шкаф, равно восьми: 1, 2, 3, 4, 5, 6, 7 и 8.

Сообщение «Книга поставлена на полку не выше четвёртой» уменьшает неопределённость знания о результате в два раза. Действительно, после такого сообщения остаётся всего четыре варианта: 1, 2, 3 и 4. Получен один бит информации.

Сообщение «Книга поставлена на полку выше второй» уменьшает неопределённость знания о результате в два раза: после этого сообщения остаётся всего два варианта: 3 и 4. Получен ещё один (второй) бит информации.

Сообщение «Книга поставлена на третью полку» также уменьшает неопределённость знания о результате в два раза. Получен третий бит информации.

Итак, мы построили цепочку сообщений, каждое из которых уменьшало неопределённость знания о результате в два раза, т. е. несло 1 бит информации. Всего было набрано 3 бита информации. Именно столько информации и содержится в сообщении «Книга поставлена на третью полку».

Подумайте, сколько информации содержится в сообщении о том, что книга поставлена на пятую полку. Обоснуйте свой ответ, построив соответствующую цепочку сообщений.

Метод поиска, на каждом шаге которого отбрасывается половина вариантов, называется методом половинного деления. Этот метод широко используется в компьютерных науках.

Пример 3. О результатах футбольного матча между клубами «Спартак» и «Динамо» известно, что больше трёх мячей никто не забил. Всего возможных вариантов счёта матча — 16:

Здесь первая цифра в каждой паре соответствует количеству мячей, забитых командой «Спартак», вторая — командой «Динамо».

Будем считать все варианты равновероятными и отгадывать счёт, задавая вопросы, на которые можно ответить только «да» или «нет». Вопросы будем формулировать так, чтобы количество возможных вариантов счёта каждый раз уменьшалось вдвое. Это позволит нам:

1) обойтись минимальным количеством вопросов;

2) подсчитать, сколько бит информации содержит сообщение о счёте матча.

Вопрос 1. «Спартак» забил больше одного мяча? Предположим, получен ответ «Нет». Такой ответ позволяет не рассматривать варианты, расположенные в нижней части таблицы, т. е. сокращает количество возможных исходов в 2 раза:

Вопрос 2. «Спартак» забил один мяч? Предположим, получен ответ «Да». Такой ответ позволяет не рассматривать варианты, расположенные в верхней строке таблицы, т. е. сокращает количество возможных исходов ещё в 2 раза:

Вопрос 3. «Спартак» пропустил больше одного мяча? Предположим, получен ответ «Нет». Можно отбросить ещё два варианта:

Вопрос 4. «Спартак» пропустил один мяч? Предположим, получен ответ «Да». Получаем единственный вариант:

Итак, нам удалось выяснить счёт матча, задав четыре вопроса, ответ на каждый из которых уменьшал неопределённость результата в два раза, т. е. нёс 1 бит информации. Сообщение о счёте матча несёт четыре бита информации.

Выясните, какому счёту матча будут соответствовать следующие цепочки ответов на поставленные выше вопросы:

2) Нет — Нет — Нет — Нет;

3) Да — Нет — Да — Нет.

Попробуйте придумать такие вопросы, чтобы цепочка ответов Нет — Да — Нет — Да приводила к счёту 2 : 3.

Вычислять количество информации, содержащееся в сообщении о том, что имел место один из множества равновероятных результатов некоторого события, с помощью метода половинного деления возможно, но затруднительно. Гораздо проще воспользоваться следующей закономерностью.

Количество информации i, содержащееся в сообщении об одном из N равновероятных результатов некоторого события, определяется из формулы: 2 i = N.

При N, равном целой степени двойки (2, 4, 8, 16, 32 и т. д.), это уравнение легко решается в уме. Решать такие уравнения при других N вы научитесь чуть позже, в курсе математики 11 класса.

Примюр 4. Петя и Вася заинтересовались игрой «Крестики — нолики» на поле n х n. Количество информации, полученное вторым игроком после первого хода первого игрока, составляет б бит. Требуется выяснить размеры поля, на котором играют Петя и Вася.

2.2. Алфавитный подход к измерению информации

Определение количества информации на основе уменьшения неопределённости наших знаний рассматривает информацию с точки зрения её содержания, понятности и новизны для человека. С этой точки зрения в примере о подбрасывании монеты одинаковое количество информации содержит и зрительный образ упавшей монеты, и короткое сообщение «Орёл», и длинная фраза «В результате подбрасывания монета упала так, что на её видимой части изображён орёл».

Однако при хранении и передаче информации с помощью технических устройств целесообразно отвлечься от её содержания и рассматривать информацию как последовательность символов (букв, цифр, кодов цвета точек изображения и т. д.) некоторого алфавита.

Информация — последовательность символов (букв, цифр, кодов цвета точек изображения и т. д.) некоторого алфавита.

Минимальная мощность алфавита (количество входящих в него символов), пригодного для кодирования информации, равна 2. Такой алфавит называется двоичным. Один символ двоичного алфавита несёт 1 бит информации.

Согласно Колмогорову, количество информации, содержащейся в последовательности символов, определяется минимально возможным количеством двоичных знаков, необходимых для кодирования этой последовательности, безотносительно к содержанию представленного ею сообщения. Данный подход к определению количества информации называют алфавитным.

Андрей Николаевич Колмогоров (1903-1987) — один из крупнейших математиков XX века. Им получены основополагающие результаты в математической логике, теории сложности алгоритмов, теории информации, теории множеств и ряде других областей математики и её приложений.

Информационным объёмом сообщения называется количество двоичных символов, которое используется для кодирования этого сообщения. В двоичном коде один двоичный разряд несёт 1 бит информации.

В отличие от определения количества информации по Колмогорову в определении информационного объёма не требуется, чтобы число двоичных символов было минимально возможным. При оптимальном кодировании понятия количества информации и информационного объёма совпадают.

Из курса информатики основной школы вы знаете, что двоичные коды бывают равномерные и неравномерные. Равномерные коды в кодовых комбинациях содержат одинаковое число символов, неравномерные — разное.

Первый равномерный двоичный код был изобретён французом Жаном Морисом Бодо в 1870 году. В коде Бодо используются сигналы двух видов, имеющие одинаковую длительность и абсолютную величину, но разную полярность. Длина кодов всех символов алфавита равна пяти (рис. 1.7).

Рис. 1.7. Фрагмент кодовой таблицы кода Бодо

Всего с помощью кода Бодо можно составить 2 5 = 32 комбинации.

Пример 5. Слово WORD, закодированное с помощью кода Бодо, будет выглядеть так:

Информационный объём такого сообщения равен 20 битам; таково количество двоичных символов, которое используется для кодирования этого сообщения.

Пример 6. Для двоичного представления текстов в компьютере чаще всего используется равномерный восьмиразрядный код. С его помощью можно закодировать алфавит из 256 символов (2 8 = 256). Фрагмент кодовой таблицы ASCII представлен на рисунке 1.8.

Рис. 1.8. Фрагмент кодовой таблицы ASCII

Слово WORD, закодированное с помощью таблицы ASCII:

Информационный объём такого сообщения равен 32 битам.

Из курса информатики основной школы вам известно, что с помощью i-разрядного двоичного кода можно закодировать алфавит, мощность N которого определяется из соотношения:

2 i = N.

Иными словами, зная мощность используемого алфавита, всегда можно вычислить информационный вес символа — минимально возможное количество бит, требуемое для кодирования символов этого алфавита. При этом информационный вес символа должен быть выражен целым числом.

Соотношение для определения информационного веса символа алфавита можно получить и из следующих соображений.

Пусть N — мощность алфавита, используемого для кодирования сообщений. При этом в каждом конкретном сообщении какие-то символы алфавита будут использоваться чаще, какие-то — реже, а какие-то — не будут использоваться вообще. Не станем обращать на это внимание, наоборот, будем считать, что любой из символов может появиться в сообщении с равной вероятностью. Другими словами, появление в сообщении очередного символа — одно из N равновероятных событий. Но количество информации i, содержащееся в сообщении об одном из N равновероятных результатов некоторого события, определяется из формулы 2 i = N.

Алгоритм вычисления информационного объёма сообщения выглядит так:

1) определить мощность используемого алфавита N;

2) из соотношения 2 i = N определить i — информационный вес символа алфавита в битах (длину двоичного кода символа из используемого алфавита мощности N);

3) вычислить информационный объём сообщения I, умножив информационный вес символа i на количество символов в сообщении К.

При алфавитном подходе информационный объём сообщения I, состоящего из К символов, вычисляется по формуле:

I = К * i,

где I — информационный вес символа в битах, связанный с мощностью используемого алфавита N соотношением:

2 i = N.

Пример 7. Для регистрации на некотором сайте пользователю надо придумать пароль, состоящий из 10 символов. В качестве символов можно использовать десятичные цифры и шесть первых букв латинского алфавита, причём буквы используются только заглавные. Пароли кодируются посимвольно. Все символы кодируются одинаковым и минимально возможным количеством бит. Для хранения сведений о каждом пользователе в системе отведено одинаковое и минимально возможное целое число байт.

Необходимо выяснить, какой объём памяти потребуется для хранения 100 паролей.

2.3. Единицы измерения информации

Итак, в двоичном коде один двоичный разряд несёт 1 бит информации. 8 бит образуют один байт. Помимо бита и байта, для измерения информации используются более крупные единицы:

1 Кбайт (килобайт) = 2 10 байт;

1 Мбайт (мегабайт) = 2 10 Кбайт = 2 20 байт;

1 Гбайт (гигабайт) = 2 10 Мбайт = 2 20 Кбайт = 2 30 байт;

1 Тбайт (терабайт) = 2 10 Гбайт = 2 20 Мбайт = 2 30 Кбайт = 2 40 байт;

1 Пбайт (петабайт) = 2 10 Тбайт = 2 20 Гбайт = 2 30 Мбайт = 2 40 Кбайт = 2 50 байт.

Чтобы избежать путаницы с различным использованием одних и тех же приставок, в 1999 г. Международная электротехническая комиссия ввела новый стандарт наименования двоичных приставок. Согласно этому стандарту, 1 килобайт равняется 1000 байт, а величина 1024 байта получила новое название — 1 кибибайт (Кибайт).

У нас в стране в 2009 году принято «Положение о единицах величин, допускаемых к применению в Российской Федерации». В нём сказано, что наименование и обозначение единицы количества информации «байт» (1 байт = 8 бит) применяются с двоичными приставками «кило», «мега», «гига», которые соответствуют множителям «2 10 », «2 20 » и «2 30 » (1 Кбайт = 1024 байт, 1 Мбайт = 1024 Кбайт, 1 Гбайт = 1024 Мбайт). Данные приставки пишутся с большой буквы.

Рассмотрим ещё несколько примеров решения задач, связанных с определением информационного объёма сообщений.

Пример 8. При регистрации в компьютерной системе каждому пользователю выдаётся пароль длиной в 12 символов, образованный из десятичных цифр и первых шести букв английского алфавита, причём буквы могут использоваться как строчные, так и прописные — соответствующие символы считаются разными. Пароли кодируются посимвольно. Все символы кодируются одинаковым и минимально возможным количеством бит. Для хранения сведений о каждом пользователе в системе отведено одинаковое и минимально возможное целое число байт.

Кроме собственно пароля для каждого пользователя в системе хранятся дополнительные сведения, для которых отведено 12 байт. На какое максимальное количество пользователей рассчитана система, если для хранения сведений о пользователях в ней отведено 200 Кбайт?

Прежде всего, выясним мощность алфавита, используемого для записи паролей: N — 6 (буквы прописные) + 6 (буквы строчные) + 10 (десятичные цифры) = 22 символа.

Для кодирования одного из 22 символов требуется 5 бит памяти (4 бита позволят закодировать всего 2 4 = 16 символов, 5 бит позволят закодировать уже 2 5 = 32 символа); 5 — минимально возможное количество бит для кодирования 22 разных символов алфавита, используемого для записи паролей.

Для хранения всех 12 символов пароля требуется 12 • 5 = 60 бит. Из условия следует, что пароль должен занимать целое число байт; т. к. 60 не кратно восьми, возьмём ближайшее большее значение, которое кратно восьми: 64 = 8 • 8. Таким образом, один пароль занимает 8 байт.

Информация о пользователе занимает 20 байт, т. к. содержит не только пароль (8 байт), но и дополнительные сведения (12 байт).

Максимальное количество пользователей («польз.»), информацию о которых можно сохранить в системе, равно 10 240:

Пример 9. Объём сообщения, состоящего из 8192 символов, равен 16 Кбайт. Какова максимальная мощность алфавита, использованного при передаче сообщения?

САМОЕ ГЛАВНОЕ

Информация (по Шеннону) — это снятая неопределённость. Величина неопределённости некоторого события — это количество возможных результатов (исходов) данного события. Сообщение, уменьшающее неопределённость знания в 2 раза, несёт 1 бит информации. Количество информации i, содержащееся в сообщении об одном из N равновероятных результатов некоторого события, определяется из формулы: 2 i = N. Такой подход к измерению информации называют содержательным.

Информация (по Колмогорову) — последовательность символов (букв, цифр, кодов цвета точек изображения и т. д.) некоторого алфавита. Информационным объёмом сообщения называется количество двоичных символов, которое используется для кодирования этого сообщения. В двоичном коде один двоичный разряд несёт 1 бит информации. Такой подход к измерению информации называют алфавитным.

При алфавитном подходе информационный объём сообщения I, состоящего из К символов, вычисляется по формуле:

I = K * i, где i — информационный вес символа в битах, связанный с мощностью используемого алфавита N соотношением 2 i = N. Единицы измерения информации:

1 Кбайт (килобайт) = 2 10 байт;

1 Мбайт (мегабайт) = 2 10 Кбайт = 2 20 байт;

1 Гбайт (гигабайт) = 2 10 Мбайт = 2 20 Кбайт = 2 30 байт;

1 Тбайт (терабайт) = 2 10 Гбайт = 2 20 Мбайт = 2 30 Кбайт = 2 40 байт;

1 Пбайт (петабайт) = 2 10 Тбайт = 2 20 Гбайт = 2 30 Мбайт = 2 40 Кбайт = 2 50 байт.

Вопросы и задания

1. Что такое неопределённость знания о результате какого-либо события? Приведите пример.

2. В чём состоит суть содержательного подхода к определению количества информации? Что такое бит с точки зрения содержательного подхода?

3. Паролем для приложения служит трёхзначное число в шестнадцатеричной системе счисления. Возможные варианты пароля:

Ответ на какой вопрос (см. ниже) содержит 1 бит информации?

1) Это число записано в двоичной системе счисления?

2) Это число записано в четверичной системе счисления?

3) Это число может быть записано в восьмеричной системе счисления?

4) Это число может быть записано в десятичной системе счисления?

5) Это число может быть записано в шестнадцатеричной системе счисления?

4. При угадывании целого числа в некотором диапазоне было получено 5 бит информации. Каковы наибольшее и наименьшее числа этого диапазона?

5. Какое максимальное количество вопросов достаточно задать вашему собеседнику, чтобы точно определить день и месяц его рождения?

6. В чём состоит суть алфавитного подхода к измерению информации? Что такое бит с точки зрения алфавитного подхода?

7. Закодируйте фразу «ALL IN GOOD TIME» кодом Бодо и восьмиразрядным компьютерным кодом. Сравните полученные информационные объёмы текста.

8. Какие единицы используются для измерения объёма информации, хранящейся на компьютере?

9. Объём сообщения, содержащего 11 264 символа, равен 11 Кбайт. Определите максимальную мощность алфавита, который мог быть использован для кодирования этого сообщения? Какова минимальная мощность алфавита, использование которого привело к такому же информационному объёму закодированного сообщения?

10. В школе 750 учащихся, коды учащихся записаны в школьной информационной системе с помощью минимального количества бит. Каков информационный объём в байтах сообщения о кодах 180 учащихся начальных классов?

11. В школьной базе данных каждый ученик получил идентификатор, состоящий ровно из б символов. В качестве символов используются все заглавные буквы русского алфавита, кроме «Ё», «Ы», «Ъ» и «Ь», а также все десятичные цифры за исключением цифры 0. Каждый такой идентификатор в информационной системе записывается минимально возможным и одинаковым целым количеством байт (при этом используют посимвольное кодирование и все символы кодируются одинаковым и минимально возможным количеством бит). Определите объём памяти, необходимый для хранения в этой системе 180 идентификаторов учащихся начальных классов. Ответ выразите в килобайтах.

12. В ходе телевизионного шоу проводится СМС-голосование: каждый телезритель отдаёт свой голос за одного из 12 артистов-участников шоу, отправляя сообщение с его номером. Голос каждого телезрителя, отданный за того или иного участника, кодируется одинаковым и минимально возможным количеством бит и сохраняется для подведения итогов. За время телевизионного шоу в голосовании приняли участие 163 840 зрителей. Определите объём сохранённой информации о голосовании и выразите его в килобайтах.

13. При регистрации в компьютерной системе каждому пользователю выдаётся пароль, состоящий из 6 символов и содержащий только символы из шестибуквенного набора А, В, С, D, Е, F. Для хранения сведений о каждом пользователе отведено одинаковое и минимально возможное целое число байт. При этом используют посимвольное кодирование паролей и все символы кодируются одинаковым и минимально возможным количеством бит. Кроме собственно пароля для каждого пользователя в системе хранятся дополнительные сведения, занимающие 15 байт. Определите объём памяти в байтах, необходимый для хранения сведений о 120 пользователях.