Vae fyi что это

Что значит аббревиатура FYI в интернет переписке?

В английском языке, а особенно в интернет-переписке, сокращения гораздо более популярны, чем в нашем. На немногие «спс», «пжл» и пару других припадают сотни англоязычных, которые понемногу проползают даже в русский язык. «лол» идеальный пример такой аббревиатуры-интернационализма, ее расшифровку не знают многие пользователи рунета.

Аббревиатура «FYI» у нас менее известна, ведь чаще используется в деловой переписке между сотрудниками, работающими удаленно или в разных офисах. В то же время, например, в сфере программистов ее используют многие.

Как произносится аббревиатура FYI?

Все аббревиатуры произносятся путем отдельного произношения каждой буквы и эта не исключение. В разговоре ее правильно назвать Еф Вай Ай, но в устной речи она используется редко, так что вряд ли вам придется ее произносить. Для понимания этого сокращения надо знать его смысл. В английском она может иметь два значения:

Оба, по сути, идентичны.

Где используется FYI?

Аббревиатура не может стоять в письме-поручении начальника и т. д. Неудобно для пользователей то, что некоторые используют аббревиатуру, как синоним слова «переслать».

В случае с передачей письма кому-то одному это удобно, но если переслать надо 10 писем, появляется длинная и неудобная цепочка из 10 FYI, которую надо пролистать, чтобы увидеть сам текст.

Советуют два метода борьбы с этим:

Также сокращение популярно в программах обмена мгновенными сообщениями и обозначает текст, который любопытно будет прочитать любому посетителю.

Примеры употребления

Деловой. Допустим, друг написал вам, что завтра начальника не будет на месте, он попал в больницу, а вы знаете — другой коллега завтра должен именно этому начальнику сдать задание.

Тогда вы пересылаете полученное письмо с пометкой FYI потому что информация может быть полезна получателю, но ему самому решать, делать что-то по этому поводу или нет.

При общении. Вы разговариваете с друзьями на форуме поклонников марки Volkswagen, и неожиданно вам попадается новость о том, что они анонсировали появление новой машины.

Вы скидываете текст новости с пометкой FYI, ведь ваших друзей заинтересует эта информация, но никаких действий вроде срочного предзаказа машины она не подразумевает.

Другие популярные в английском языке сокращения

В деловой электронной переписке

В дружеской переписке в соц. сетях, на форумах

IMHO — “In my hummble Opinion”, переводится, как “По моему скромному мнению». Аббревиатура употребляется, когда кто-то хочет что-то сказать и подчеркивает, что это его личное мнение. Подметим, что на самом деле оно редко бывает скромным. Русские шутники расшифровывают ИМХО, как «Имею мнение хрен оспоришь», что все же далеко от оригинала.

FYI и другие английские аббревиатуры в интернет-переписке

Нет времени? Сохрани в

Hey, WUZUP? 2DAY we are going to talk about English slang abbreviations.

Сегодня мы поговорим об английских сленговых аббревиатурах. Ранее у нас в блоге уже выходила статья на эту тему. Там была длинная подборка сокращений в разных сферах. Если вы ее не читали, можете открыть в новой вкладке и просмотреть. А здесь мы разберем именно интернет-сокращения более подробно.

Содержание статьи:

Почему важно знать английскую аббревиатуру?

В учебниках по английскому, да и на многих курсах вы не встретите этой информации. Многие программы обучают только классическому языку. А ведь интернет-сленг используется постоянно. Знать сокращение FYI и что это значит, настолько же важно, насколько знать, что означает «лол».

Если вы посмотрите любую неформальные переписку носителей, она будет полна всяких сокращений вроде otoh, btw и так далее.

Кстати, переписываться с носителями языка — отличная возможность попрактиковать свой разговорный английский.

25 фразовых глаголов с look для пополнения словарного запаса

Виды сокращений в английском языке

Есть несколько основных вариантов. Сейчас пройдемся по каждому.

Аббревиатуры

Из слов в фразе берутся первые буквы и складываются вместе. Например, FYI (перевод: for your information — для вашей информации — к вашему сведению).

asap (as soon as possible) — как можно скорее

fyi (for your information) — для сведения

gl (good luck) — удачи

gb (good bye) — пока

afaik (as far as I know) — насколько я знаю

btw (by the way) — кстати

brb (be right back) — скоро вернусь

cul (see you later) — увидимся позже

ttyl (talk to you later) — напишу позже

imho (in my humble opinion) — по моему скромному мнению

aka (also known as) — также известный как

tia (thanks in advance) — спасибо заранее

lol (laugh out loud) — смеюсь вголос

jk (just kidding) — просто шучу

mu (miss you) — скучаю по тебе

np (no problem) — без проблем

omg (oh my god) — о боже

Сокращения слов и фраз

Зачастую опускаются гласные. Например: pls (please — пожалуйста).

abt (about) — около, приблизительно

abv (above) — выше; более, чем

am (I am) — я

youre (you are) — ты

hwr (however) — однако

msg (message) — сообщение, послание

ltr (letter) — письмо

hv (to have) — иметь

pct (per cent) — процент

prc (price) — цена

ps (parents) — родители

pls (please) — пожалуйста

rly (really) — действительно, правда

std (standard) — стандартный

wl (will) — вспомогательный глагол будущего времени

yr (year) — год

w (week) — неделя

dno (don’t know)— не знаю

thx (thanks) — спасибо

bc (because) — потому что

smth (something) — что-то

gf (girlfriend) — девушка, герлфренд

smb (somebody) — кто-то

wknd (weekend) — выходные

wanna (want to) — хотеть

gonna (going to) — собираться

gotta (got to) — должен

xlnt (excellent) — отлично

qt (cutie) — милашка

Сокращения окончаний

Просто убираем окончание. Например: sis (sister — сестра).

docs (documents) — документы

imm (immediately) — немедленно

nес (necessary) — необходимый

priv (private) — частный

tel (telephone) — телефон

tod (today) — сегодня

tom (tomorrow) — завтра

moth (mother) — мама

fath (father) — папа

Замена созвучных символов

Если слово встречается часто, его могут видоизменять для сокращения.

Например, слово you (ты) в переписке часто пишут просто как u (так как эта буква сама по себе читается так же, как полное слово). Иногда буквы могут заменяться на цифры (4 — for, 2 — to и так далее).

2U (to you) — тебе

4E (forever) — навсегда

B (be) — быть

B4 (before) — до, прежде чем

BZ (busy) — занят

U (you) — вы

R (are) — форма глаголы to be

ur (your) — ваш

2moro (tomorrow) — завтра

SOM1 (someone) — кто-то

2day (today) — сегодня

2G2BT (too good to be true) — слишком хорошо, чтобы быть правдой

2nite (tonight) — вечером

4ever (forever) — навсегда

WAN2 (want to) — хотеть

N2S (needless to say) — само собой разумеется, очевидно

NE1 (anyone) — кто угодно, любой

L8 (late) — поздно, недавно, за последнее время

L8R (later) — (позже)

GR8 (great) — замечательно, отлично

D8 (date) — дата, свидание

C (see) — видеть

Сокращения из латыни

Часто встречаемое выражение etc (и так далее) взято с латыни и не имеет расшифровки в английском.

etc. (et cetera) — и прочее

e. g. (exempli gratia) — например

vs (versus) — против

Другие сокращения

Сюда попадают те сокращения, которые не попадают под предыдущие пункты.

Например, x означает поцелуй (потому что буква визуально похожа на сложенные бантиком губки).

X (kiss) — поцелуй

XOXO (hugs and kisses) — объятия и поцелуи

ZZZ.. (to sleep) — спать (чтобы выразить сонливость)

Текст и перевод песни Antisocial (Ed Sheeran Travis Scott)

Забавные переписки на английском

Давайте посмотрим забавные скриншоты переписок, а заодно разберем, какие сокращения там используются.

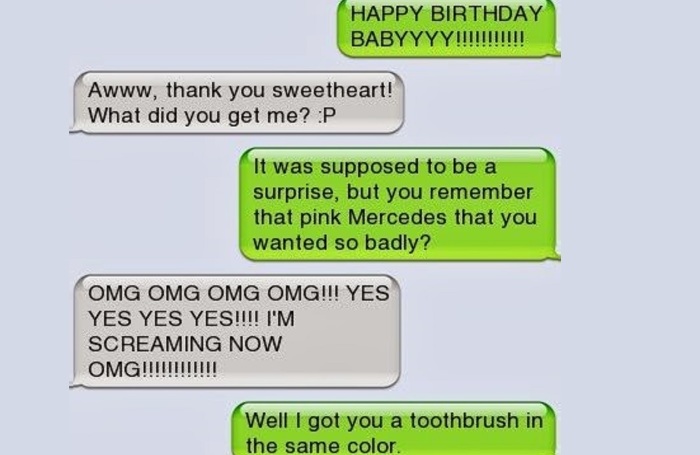

— С ДНЕМ РОЖДЕНИЯ ДЕТКА.

— Аааа, спасибо, любимый! Что ты мне приготовил? 😛

— Это должен был быть сюрприз, но помнишь Мерседес, который ты так сильно хотела?

— О БОЖЕ О БОЖЕ О БОЖЕ! ДА ДА ДА!! Я КРИЧУ ПРЯМО СЕЙЧАС О БОЖЕ.

— В общем, я приготовил тебе зубную щетку такого же цвета.

Запоминаем, что OMG расшифровывается как Oh My God (о боже!) и очень часто используется в переписке.

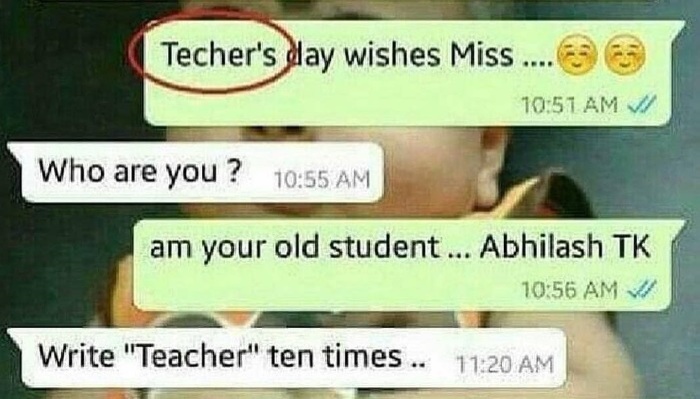

— Поздравляю с Днем Учитиля, Мисс.

— Кто это?

— Я ваш старый студент. Абхилаш Т.К.

— Напиши «Учитель» десять раз..

Из этой переписки запоминаем не только, что teacher пишется с «ea» в начале, но и то, что носители иногда сокращают I am до простого am (а you are до youre, даже без апострофа).

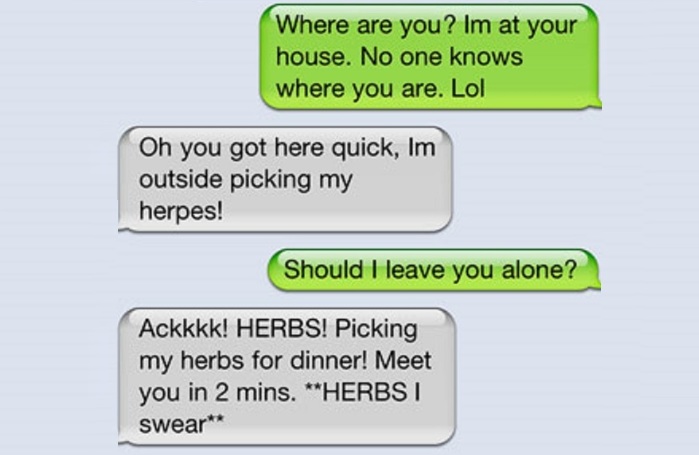

— Где ты? Я у тебя в доме. Никто не знает, где ты. Лол

— Оу, ты так быстро добрался. Я снаружи, собираю свой герпес!

— Мне оставить тебя наедине?

— Аааа! ТРАВЫ! Собираю свои травы к ужину! Встречу тебя через две минуты. **ТРАВЫ, я клянусь**

Тут снова опускается апостроф в сокращении. Плюс аббревиатура lol, которую вы, скорее всего, и так знаете.

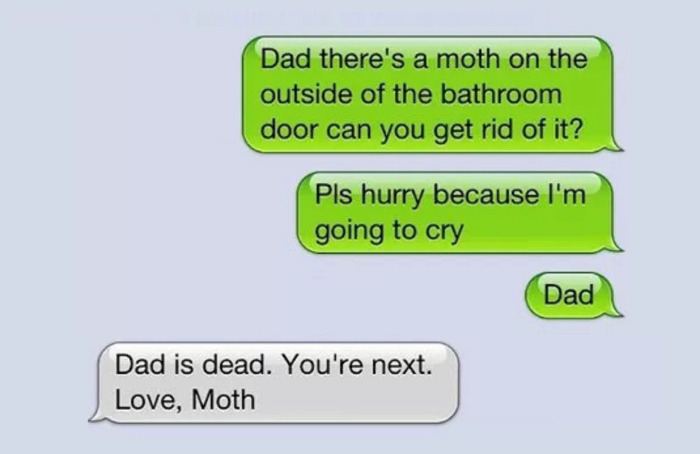

— Пап, там моль за дверью ванной комнаты, можешь избавиться от нее?

Пожалуйста, поторопись, я сейчас буду кричать

Пап

— Папа мерт. Ты следующий. С любовью, Моль

Здесь используются сокращения «moth» от mother и pls от please. Заодно можно запомнить выражение get rid of somebody, то есть избавиться от кого-то.

— Я очень скучаю по тебе, Сьерра

— Знаешь, по чему скучаю я?

По зерновым батончикам Oreo

— Что? Пожалуйста, будь серьезна

— Где они их продают?

Здесь встречается распространенное сокращение U (от you). Также вы можете заметить, что опускаются некоторые грамматические конструкции. «you know?» вместо «do you know?».

— От чего сокращенно «Лиз»?

— Елизавета, лол

— Мой думал, что Король Ящерица

Иногда сокращения сбивают детей с толку, и это забавно.

Теперь вы можете вести переписку самостоятельно. Кстати говоря, если вы переписываетесь не только со знакомыми, но и по работе, рекомендуем к прочтению эту статью. Там список именно деловых сокращений, которые не были упомянуты здесь. Например, COB — аббревиатура в деловой переписке, означающая Close of Business.

Желаем удачи!

EnglishDom #вдохновляемвыучить

FYI — что это значит и как ответить в переписке

Вы часто переписываетесь по электронной почте и не знаете что значит аббревиатура FYI в письме. Давайте подробно поговорим с Вами на тему того, когда и зачем надо использовать метку текста FYI, для чего она нужна и как на неё ответить.

Аббревиатура FYI

Что это — FYI? Что она вообще значит? Вы конечно знаете, что в текстах достаточно часто используют различные аббревиатуры. И наиболее часто ими пользуются в английском языке. Причём те же американцы активно их используют и в деловой и в повседневной переписке в социальных сетях и по электронной почте. Одна из наиболее популярных — аббревиатура FYI. Произносится она как “Эф Вай Ай”. Один мой знакомый очень любит называть её «Фуй», что не правильно, как Вы понимаете. Ниже я подробно расскажу про FYI — что это значит в письмах и как ответить.

Как правило, аббревиатуру FYI располагают в заголовке электронного письма для того, чтобы отправить информацию сотруднику, с которой он ещё не ознакомлен. При этом стоит заметить, что сокращение FYI не используется руководителем в письме, которое содержит в себе поручение. Информация не является срочной и не требует от получателя срочных и активных действий.

Данная аббревиатура имеет англоязычное происхождение и расшифровывается, как “For your information” или по-русски — «к твоему сведению», «чтобы ты знал» или просто «для информации». Иногда сокращение FYI расшифровывают как “For your interest”. Этот вариант тоже можно считать подходящим, так как в переводе означает “тебе будет интересно”. Ну то бишь письмо содержит интересную и полезную для адресата информацию, которую он не видел ранее.

Давайте рассмотрим использование аббревиатуры FYI на наглядных примерах:

Как ответить на письмо с таким заголовком? Да никак. Подобное письмо не предполагает какого-то обязательно ответа.

Альтернативные варианты использования:

Кроме общепринятых расшифровок, которые я привёл выше, у сокращения FYI есть ещё варианты расшифровки, порой достаточно необычные. Вот несколько самых популярных вариантов:

Использование FYI в письме

Аббревиация FYI используется для того, чтобы отметить, что письмо будет интересно получателю. В это же время она не требует от адресата, каких либо действий. Метка FYI ставится в теме письма, скорее для того, что бы обратить на себя внимание. Это значит, если вы желаете обратить внимание адресата на ваше электронное письмо вы можете указать FYI в теме письма.

Аббревиатура FYI в электронном письме

Весь смысл использования сокращения FYI я могу показать на примере: В компании вводится новая услуга или поступает в продажу новый товар и для того, чтобы все сотрудники были в курсе, информация о товаре или услуге рассылается им по электронной почте с пометкой FYI. Другой пример — Вы нашли что-то интересное и рассылаете по друзьям с такой пометкой, чтобы они тоже были в курсе. Как Вы видите, данную аббревиатуру можно использовать и в деловой и в неформальной переписке.

Как работает вариационный автоэнкодер (VAE)

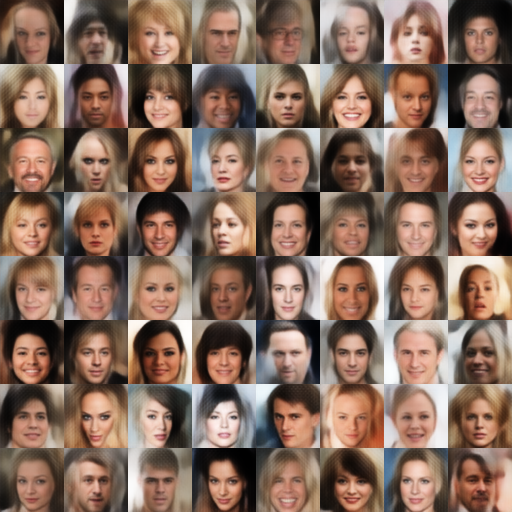

В противоположность использованию нейросетей в качестве регрессоров или классификаторов, вариационный автоэнкодер (Variational Autoencoder – VAE) — генеративная модель, которая находит применение во многих областях исследований: от генерации новых человеческих лиц до создания полностью искусственной музыки.

Эта статья рассказывает о том, что такое вариационный автоэнкодер, почему это архитектура стала так популярна, и почему VAE используют в качестве генеративного инструмента почти во всех областях цифрового медиа-пространства.

Прежде всего, зачем нужен вариационный автоэнкодер?

Генеративные модели используют для того, чтобы производить случайные выходные данные, которые выглядят схоже с тренировочным набором данных, и тоже самое вы можете делать с помощью VAEs. Однако, зачастую необходимо изменить или исследовать вариации на данных, которые уже имеются, и не случайным образом, а определённым желаемым способом. В этом случае VAEs работают лучше, чем любой другой ныне доступный метод.

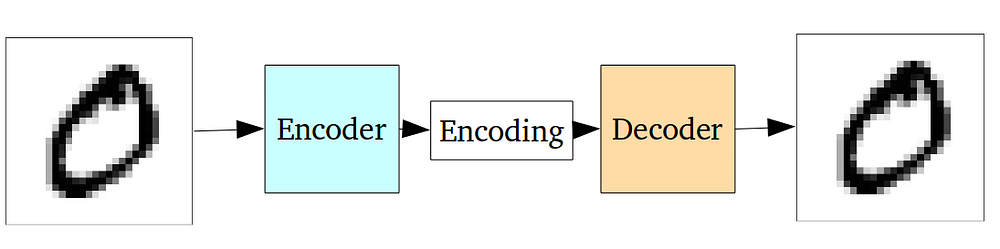

Нейросеть автоэнкодера на самом деле является парой из двух соединенных нейросетей – энкодера и декодера. Энкодер принимает входные данные и преобразует их, делая представление более компактным и сжатым. В свою очередь, декодер использует преобразованные данные для трансформации их обратно в оригинальное состояние.

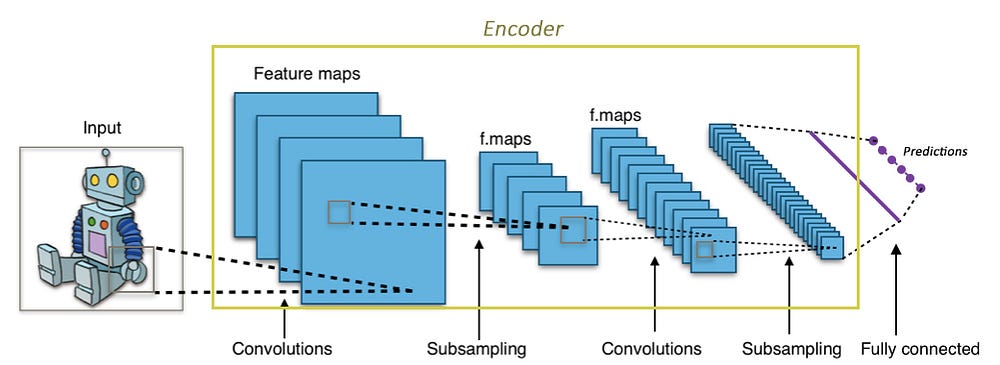

В случае, если вы незнакомы с энкодерами, но знаете о свёрточных нейронных сетях (Convolutional Neural Networks — CNNs), то, по сути, вы уже знаете, что делает автоэнкодер.

Свёрточные слои принимают большое изображение (к примеру, тензор 3-го ранга размером 299х299х3) и преобразует его в более компактный, плотный вид (к примеру, тензор 1-го ранга размером 1000). Этот сжатый вид затем использует нейросеть для классификации изображения.

Энкодер выполняет похожие операции. Это нейросеть, которая принимает входные данные и выдаёт их в сжатом виде (т.е. выполняет их кодирование), которые содержит достаточно информации для трансформации этих данным следующей нейросетью в желаемый формат. Обычно энкодер обучается одновременно с другими частями нейросети на основе метода обратного распространения, что позволяет ему производить вид кодирования, необходимый в конкретной задаче. В CNN кодирование изображения в массив из 1000 элементов производится таким образом, что этот массив становится пригодным для задач классификации.

Автоэнкодеры используют ту же идею, но в другом виде: энкодер генерирует закодированные данные, пригодные для восстановления входных данных.

Нейросеть обычно обучается как единое целое. Функция потерь выбирается как среднеквадратичная ошибка или как кросс-энтропия между входными и выходными данными, также известная как потеря восстановления ( reconstruction loss), которая не позволяет нейросети создавать выходные данные, сильно отличающиеся от входных.

Так как зашифрованные данные (которые являются просто выходными данными скрытого слоя в середине) имеют намного меньший размер, чем входные, то получается, что энкодер теряет часть информации. В то же время, энкодер обучается сохранять как можно больше значимой информации и откидывать второстепенные детали. В свою очередь, декодер обучается принимать зашифрованные данные и правильным образом восстанавливать из них входные изображения. Две этих нейросети вместе формируют автоэнкодер.

Проблема классических автоэнкодеров

Классические автоэнкодеры обучаются кодировать входные данные и восстанавливать их. Однако область их применения ограничивается в основном созданием шумоподавляющих кодеров.

Фундаментальная проблема автоэнкодеров заключается в том, что скрытое пространство, в котором они кодируют данные, и в котором лежат их закодированные векторы, может не быть непрерывным и не позволять производить интерполяцию.

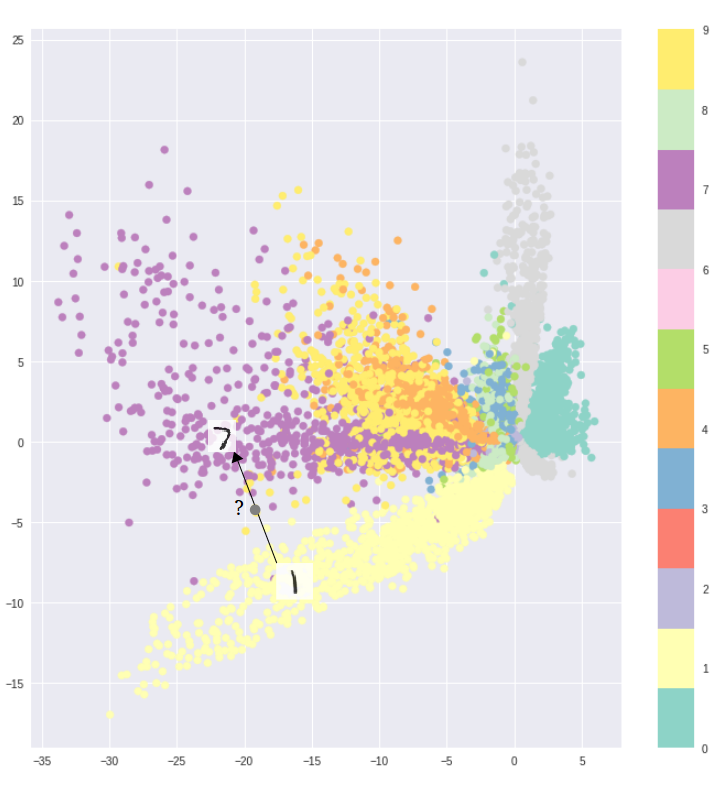

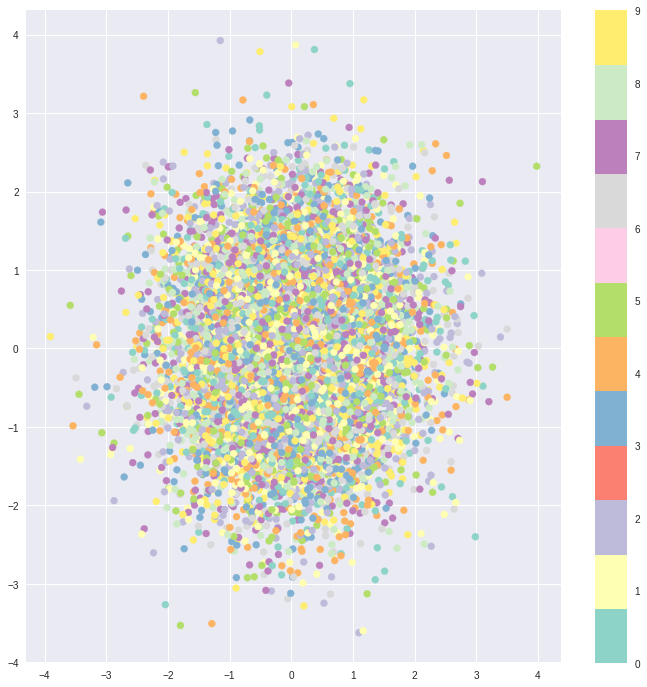

К примеру, обучение автоэнкодера на датасете MNIST и визуализация закодированных данных из двумерного скрытого пространства наглядно показывают формирование отдельных кластеров. Это имеет смысл, так как отдельные векторы кодирования для каждого типа изображения облегчают расшифровку данных, производимую энкодером.

Всё замечательно, если вам необходимо просто воспроизвести исходные изображения. Однако, если вы строите генеративную модель, ваша цель не простое дублирование изображений. В этом случае вы хотите получить случайное или видоизмененное изображение, восстановленное из непрерывного скрытого пространства.

Если пространство имеет разрывы (например, промежутки между кластерами), и вы пытаетесь сгенерировать изображение на основе закодированных данных из этого промежутка, то декодер выдаст нереалистичное изображение, потому что не имеет представления о том, что делать с этой областью скрытого пространства.

Вариационные Автоэнкодеры

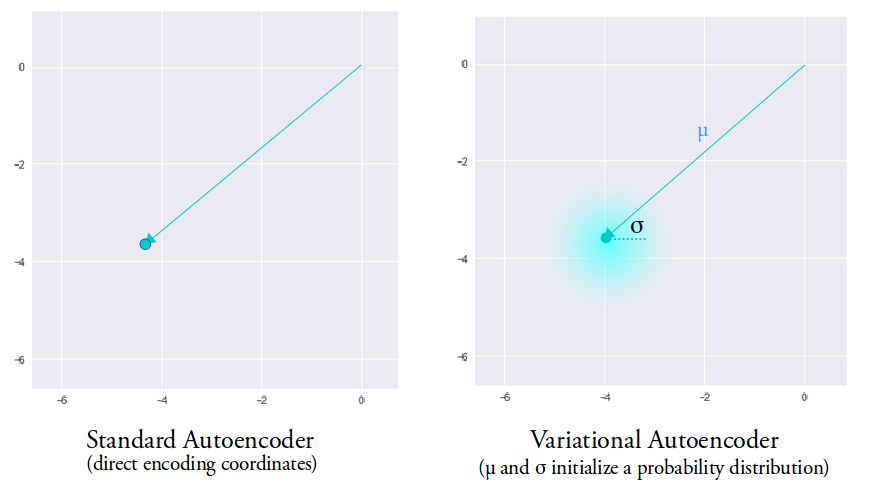

Вариационный автоэнкодер (VAE) имеет одно уникальное свойство, которое отличает его от стандартного автоэнкодера. Именно это свойство делает вариационные автоэнкодеры столь полезными при генерации данных: их скрытое пространство по построению является непрерывным, позволяя выполнять случайные преобразования и интерполяцию.

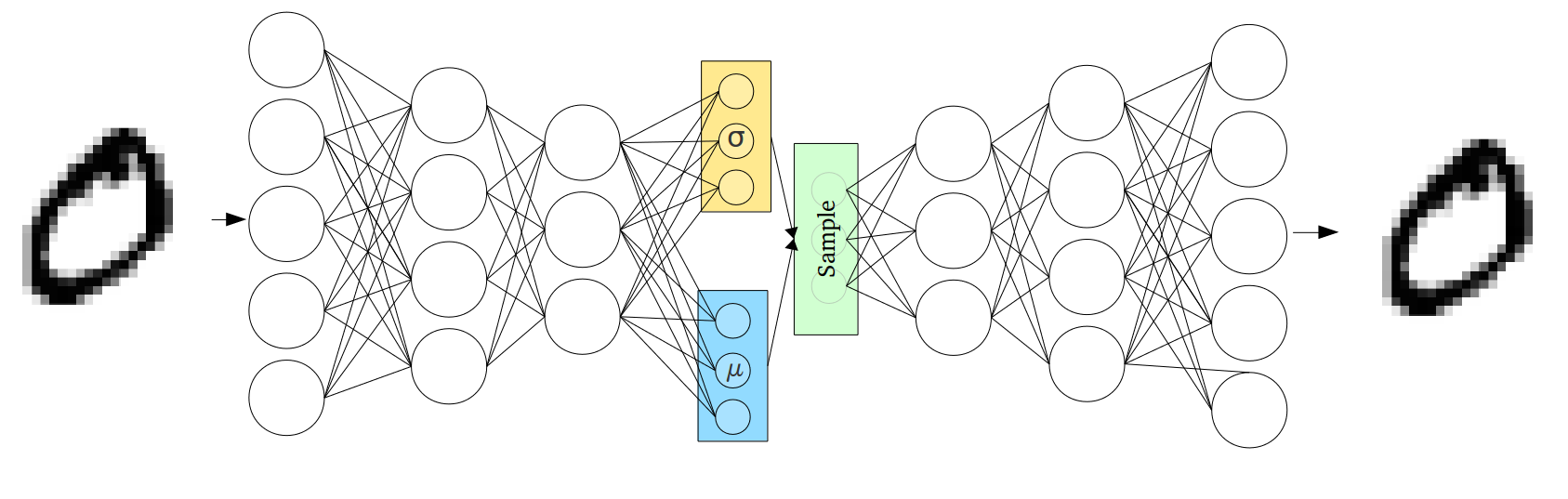

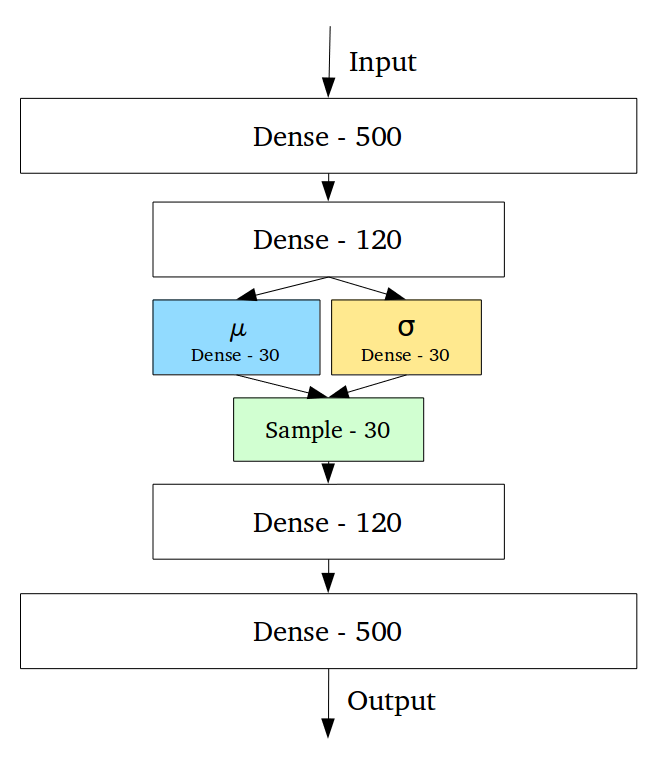

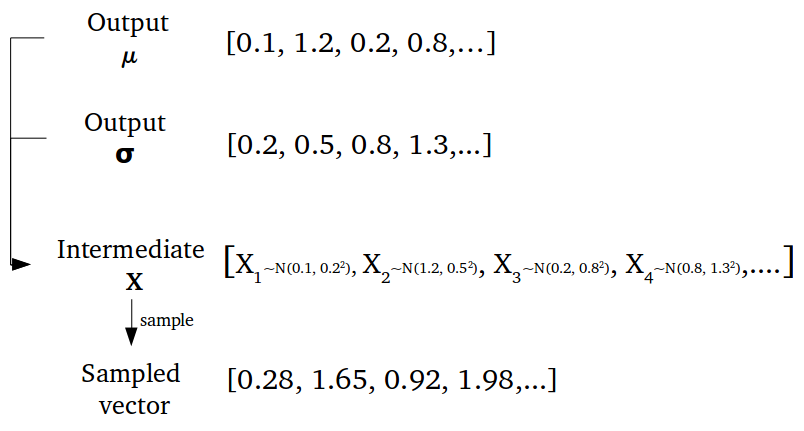

Непрерывность скрытого пространства достигается неожиданным способом: энкодер выдаёт не один вектор размера n, а два вектора размера n – вектор средних значений µ и вектор стандартных отклонений σ.

Вариационные автоэнкодеры формируют параметры вектора длины n из случайных величин Xi, причем i-е элементы векторов µ и σ являются средним и стандартным отклонением i-й случайной величины Xi. Вместе эти величины образуют n-мерный случайный вектор, который посылается на декодер для восстановления данных:

Эта так называемая стохастическая генерация означает, что даже для одинаковых входных данных результат кодирования будет разным вследствие случайности выбора вектора кодирования:

Среднее значение вектора определяет точку, вблизи которой будет вершина вектора, в то время как стандартное отклонение определяет насколько далеко может отстоять вершина от этого среднего. Таким образом, вершина вектора кодирования может лежать внутри n-мерного круга (см. рис. выше). Поэтому входному объекту соответствует уже не одна точка в скрытом пространстве, а некоторая непрерывная область. Этот факт позволяет декодеру работать не с одним единственным вектором кодирования, соответствующим входным данным, а с их набором, благодаря чему в восстановление даже одного изображения вносится доля вариативности. Код реализации такого подхода.

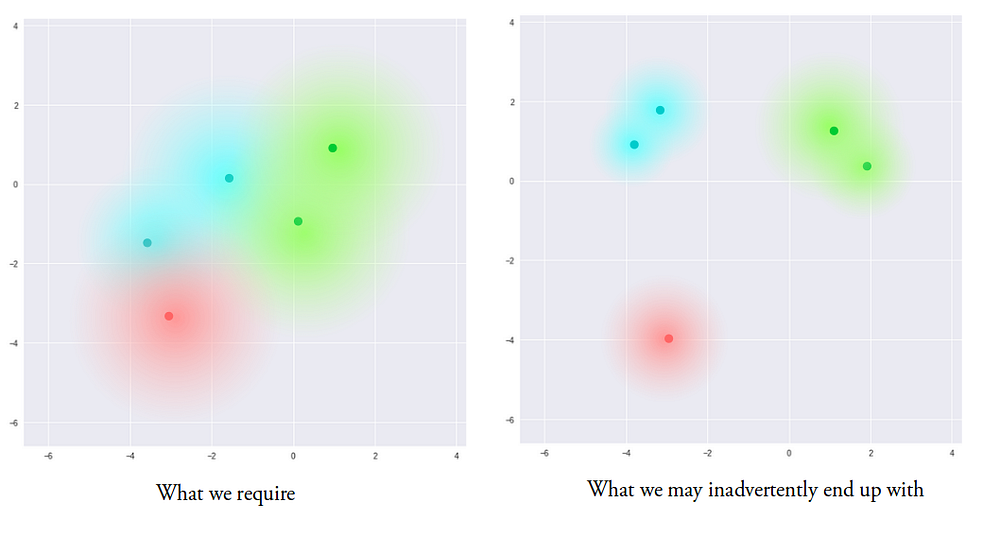

Теперь модель обладает вариативностью даже в пределах одного вектора кодирования, так как скрытое пространство локально непрерывно, т.е. непрерывно для каждого образца входных данных. В идеальном случае, нам хотелось бы перекрытия этих локальных областей и для образцов входных данных, которые не сильно похожи друг на друга, чтобы производить интерполяцию между ними. Однако, так как нет ограничений на значения, принимаемые векторами µ и σ, энкодер может быть обучен генерировать сильно отличающиеся µ для разных образцов входных данных, тем самым сильно удаляя их представления друг от друга в скрытом пространстве. Кроме того, энкодер будет минимизировать σ для того, чтобы векторы кодирования не сильно отличались для одного образца. Таким образом, декодер получает данные с малой степенью неопределенности, что позволяет ему эффективно восстанавливать данные из тренировочных сетов, но при этом мы можем не иметь непрерывного пространства:

Мы хотим, чтобы все области в скрытом пространстве были как можно ближе друг к другу, но при этом оставались различимыми как отдельные составляющие. В этом случае мы можем производить гладкую интерполяцию и создавать новые данные на выходе.

Для того чтобы достичь этого, в функцию потерь вводится так называемая Kullback–Leibler расходимость (KL divergence). КL расходимость между двумя функциями распределения показывает насколько сильно они отличаются друг от друга. Минимизация KL расходимости означает оптимизацию параметров распределения µ и σ таким образом, что они становятся близки к параметрам целевого распределения.

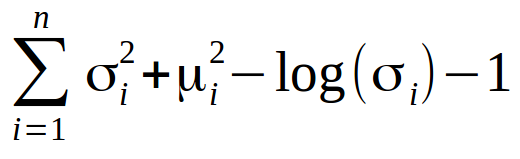

Для Вариационных Автоэнкодеров KL потери эквивалентны сумме всех KL расходимостей между распределением компонент Xi

N(μi, σi²) в векторе Х и нормальным распределением. Минимум достигается, когда µi = 0 и σi = 1.

Как видно, учёт KL потерь заставляет энкодер помещать каждую отдельную область кодирования в окрестности некоторой точки в скрытом пространстве.

При использовании KL потерь области кодирования расположены случайным образом в окрестности выделенной точки в скрытом пространстве со слабым учётом сходства между образцами входных данных. Поэтому декодер не способен извлечь что-либо значащее из этого пространства:

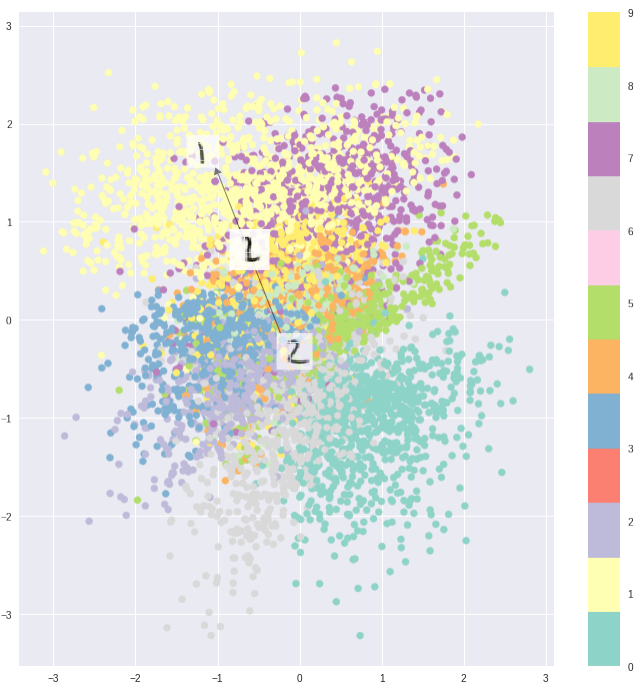

Однако, оптимизируя и энкодер и декодер, мы получаем скрытое пространство, которое отражает схожесть соседних векторов на глобальном уровне, и имеет вид плотно расположенных областей возле начала координат скрытого пространства:

Достигнутый результат – это компромисс между кластерной природой потерь восстановления, необходимой декодеру, и нашим желанием иметь плотно расположенные векторы при использовании KL потерь. И это здорово, потому что теперь, если вы хотите восстановить входные данные, вы просто выбираете подходящее распределение и посылаете его в декодер. А если вам необходимо произвести интерполяцию, то вы можете смело её осуществить, так как пространство представляет собой гладкое распределение особенностей, что декодер без труда способен обработать.

Векторная алгебра

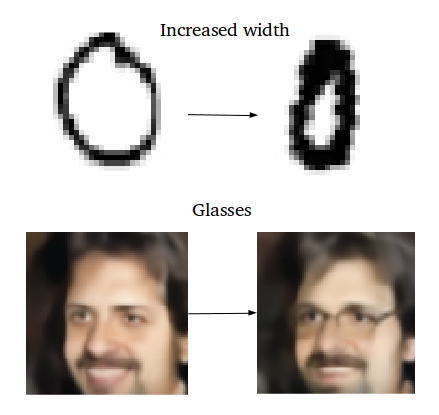

Как мы производим гладкую интерполяцию, о которой было так много сказано выше? Ответ кроется в простой векторной алгебре — рассмотрим её.

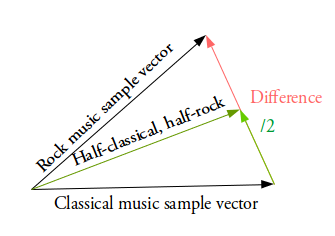

К примеру, вы хотите сгенерировать новый образец как нечто среднее между двумя заданными образцами. В этом случае вы находите разницу между двумя средними векторами этих образцов, делите её пополам и прибавляете этот результат к вектору, который был вычитаемым. Вы получили вектор, который является чем-то средним между двумя заданными векторами. Расшифровывая его, вы получите желаемый результат (см. рис.выше).

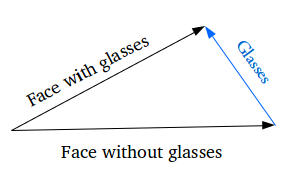

Как насчёт генерации специфических особенностей: например, добавления очков на портрет? Мы находим два схожих образца – один с очками, другой – без них, получаем их вектора с помощью энкодера и находим их разницу. Затем прибавляем этот разностный вектор, который и отвечает за наличие очков, к вектору портрета без очков и расшифровываем получившийся вектор с помощью декодера.

Улучшения VAE

Существует множество улучшений вариационных автоэнкодеров. К примеру, вы можете заменить стандартную пару из полностью соединённых энкодера и декодера на пару CNN-DNN энкодера и декодера, прямо как в этом проекте, в рамках которого были созданы искусственные фото людей.

Кроме того, вы можете обучать автоэнкодер, используя LSTM пару энкодер-декодер и модифицированную версию архитектуры seq2seq,и использовать его для дискретных данных. К примеру, генерировать текст или даже производить интерполяцию между MIDI сигнашами, как делает Google Brain’s Magenta’s MusicVAE:

Вариационные Автоэнкодеры способны работать с удивительно разнообразными типами данных: последовательными или непоследовательными, непрерывными или дискретными и т.д. Эта характерная черта делает их наиболее эффективными инструментами генерации и обуславливает их высокую популярность в сфере машинного обучения.