Virbr0 centos 7 что это

KVM в CentOS 7

Параметры управления виртуальной машиной настраиваются через файл /etc/libvirt/libvirtd.conf.

Установка пакетов KVM

Еще одним важным фактором является доступность хранилища. Когда вы устанавливаете виртуальную машину, она должна создать виртуальный диск. Этот виртуальный диск по умолчанию хранится в файле образа в каталоге /var/lib/libvirt/images. Убедитесь, что у вас достаточно свободного дискового пространства в разделе, где вы хотите установить виртуальные машины, прежде чем начинать установку.

После установки необходимых пакетов программного обеспечения вы можете перейти к созданию виртуальных машин и управлению ими.

2. Введите systemctl status libvirtd. Эта команда проверяет, запущена ли служба libvirtd. Если это так, то всё отлично. Если нет, введите systemctl start libvirtd, чтобы запустить службу.

Немного о KVM Host Networking

После установки KVM на сервере сеть также существенно меняется. На хосте создан виртуальный мост virbr0. Этот виртуальный мост работает как встроенный коммутатор и используется для подключения одного или нескольких физических сетевых интерфейсов хоста к различным виртуальным машинам.

Во время связи по сети виртуальная машина отправляет пакеты через свой внутренний (виртуальный) сетевой интерфейс, который обычно имеет имя eth0. На уровне гипервизора (хоста, где установлен KVM) эта сеть представлена интерфейсом vnet. Первая виртуальная машина, которая запускается, получает интерфейс vnet0, вторая машина, которая запускается, получает vnet1 и так далее.

Эти интерфейсы vnet в свою очередь подключаются к виртуальному мосту. Сам виртуальный мост подключен к физическому сетевому интерфейсу вашего хоста. Чтобы получить обзор конфигурации виртуальной сети, вы можете использовать команду brctl show. Эта команда показывает имя моста, уникальный идентификатор, который был назначен мосту, индикатор, который показывает, был ли включен протокол STP (Spanning Tree Protocol), и все интерфейсы, которые подключены к мосту.

Обратите внимание, что в CentOS 7 есть два разных способа управления сетевыми мостами. При установке CentOS в качестве хоста KVM автоматически создается мостовой интерфейс с именем virbr0. Кроме того, вы можете настроить мост вручную, используя утилиты мостового соединения, которые доступны в утилитах NetworkManager nmtui и nmcli. Чтобы упростить настройку конфигурации виртуальной сети, рекомендуется установить мост при настройке сервера в качестве хоста KVM.

Создание моста (br0)

Чтобы NIC на хосте работал в режиме моста, нужно установить пакет bridge-utils:

Первым делом узнаем название физического интерфейса. В моём случае это em4:

Затем открываем файл физического интерфейса:

Удаляем всё содержимое и вписываем туда:

Теперь создаем интерфейс br0:

Вписываем туда это содержимое:

Вместо моей адресации впишите ту, которая была на физическом интерфейсе, в моей случае это em4.

Перезапускаем сеть:

Перезапускаем libvirtd:

Теперь появился сетевой интерфейс br0 и он работает в режиме моста. Соответственно ему теперь назначена IP-адресация, которая была на em4:

С настройкой моста закончили, теперь установим дополнительные пакеты для работы с KVM, если вы хотите управлять виртуальными машинами из Windows.

Установка дополнительных пакетов

Установим virt-manager и дополнительные пакеты, благодаря которым можно управлять виртуальными машинами в графической среде прямо из ssh-сессии:

Далее:

И наконец произведем окончательную настройку выше скачанных программ.

Настройка дополнительных параметров SSH на хосте KVM

Настройка PuTTy и VcXsrv

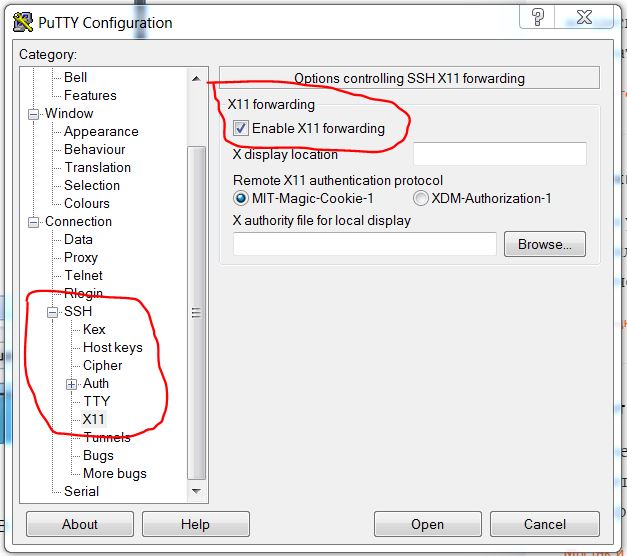

Запускаем PuTTy, вводим IP-адрес хоста KVM и имя сессии. После этого слева раскрываем SSH, выбираем X11 и ставим галочку напротив «Enable X11 forwarding» как на скриншоте ниже:

И наконец настроим VcXsrv

Последовательность запуска virt-manager следующая:

Установка и управление виртуальными машинами

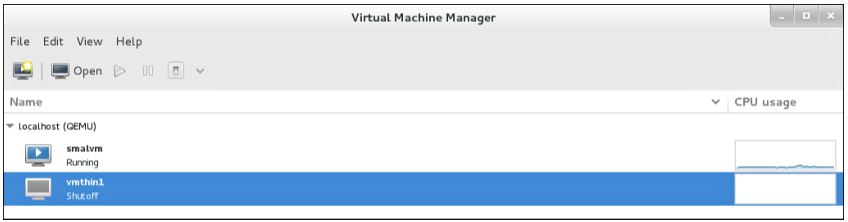

1. Введите virt-manager &, чтобы запустить диспетчер виртуальных машин (Virtual Machine Manager).

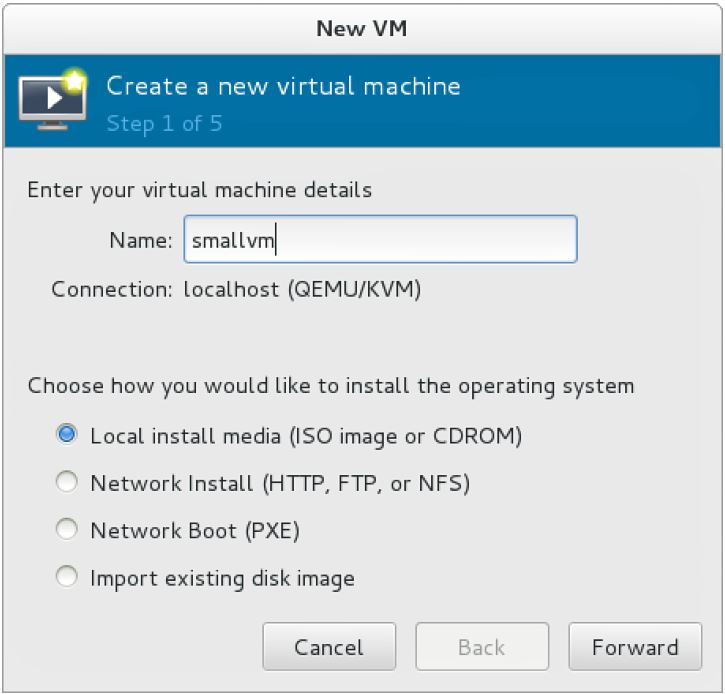

2. В диспетчере виртуальных машин нажмите Create a New Virtual Machine. Откроется окно шага 1 из 5 мастера создания новой виртуальной машины.

3. На шаге 2 из 5 мастера необходимо указать источник, где находится установочный диск, а также версию операционной системы и операционной системы, которые вы хотите установить.

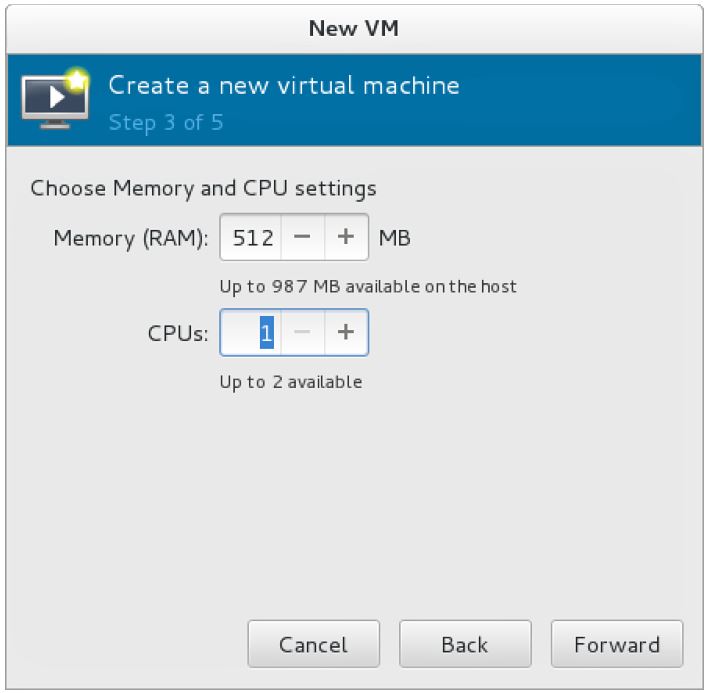

4. Далее необходимо указать объем оперативной памяти, которую вы хотите выделить для виртуальной машины, а также количество ядер ЦП. Конечно, вам нужно иметь как минимум ресурсы, которые вы выделяете на хост-машине. Для минимальной установки используйте 512 МБ ОЗУ и 1 ЦП.

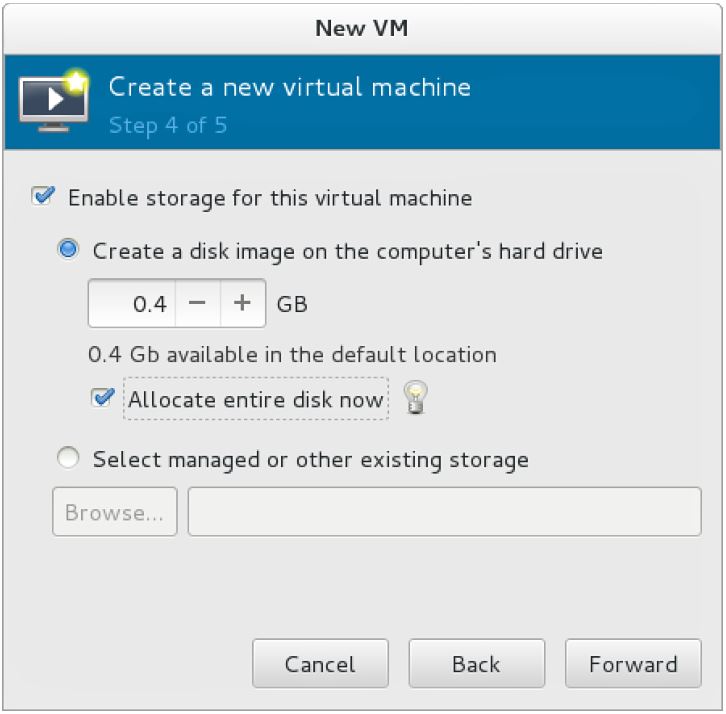

5. Теперь введите свойства виртуального диска, который вы хотите создать. Для базовой установки рекомендуется минимум 2 ГБ.

6. На данный момент вы ввели все свойства, которые будут использоваться для виртуальной машины.

Теперь вы можете нажать Finish, чтобы записать настройки виртуальной машины на диск и начать процедуру установки.

В этой процедуре вы определили настройки виртуального оборудования, которые будет использовать ваша виртуальная машина. Теперь можно начать установку.

Использование виртуальных машин KVM

Утилита virt-viewer похожа на Virtual Machine Manager. Он был разработан для предоставления пользователям доступа к виртуальной машине без предоставления возможности изменения настроек виртуальной машины.

Утилита GNOME Boxes является дополнением к интерфейсу GNOME 3, который используется на серверах, на которых установлен графический интерфейс. Он был разработан как утилита для конечных пользователей, которая упрощает использование и доступ к виртуальным машинам.

Доступ к виртуальным машинам из консоли хоста

1. Войдите в виртуальную машину и убедитесь, что у вас есть права root.

3. Перезагрузите виртуальную машину, используя команду reboot.

4. На хосте KVM используйте команду virsh console your_server.example.com для подключения к виртуальной машине. Теперь вы получите доступ к консоли VM, как показано ниже. Нажмите Ctrl +], чтобы выйти из сеанса консоли virsh. Обратите внимание, что имя виртуальной машины, к которой вы подключаетесь, должно совпадать с именем виртуальной машины, как вы можете увидеть это с помощью команды virsh list.

Управление свойствами виртуальной машины в графической среде

Управление виртуальными машинами из консоли

CentOS предлагает универсальный интерфейс командной строки для управления виртуальными машинами непосредственно из командной строки. Вы можете запустить команду virsh с множеством различных аргументов для выполнения определенных задач. Вы также можете просто набрать virsh, чтобы открыть интерфейс командной строки, из которого вы можете сразу ввести определенные команды. Таблица показывает некоторые из наиболее распространенных команд virsh.

При использовании команд virsh вам часто приходится указывать имя виртуальной машины. Альтернативой является использование идентификатора виртуальной машины. Чтобы получить обзор идентификаторов виртуальных машин, используйте virsh list. Вы увидите идентификаторы в списке для всех виртуальных машин, которые в данный момент активны

Узнать IP-адреса гостевой виртуальной машины KVM

Получить список сетей

Посмотреть адреса, выданные машинам этой сетью

Мониторинг активности ВМ с помощью top

В Linux вы можете использовать утилиту top для мониторинга активности процессов. Виртуальная машина похожа на любой другой процесс с точки зрения хоста, на котором она работает. Это означает, что виртуальные машины используют ресурсы, как и любые другие процессы. В утилите top для отображения такой активности используется интересный параметр; параметр st в строке загрузки ЦП указывает процент времени ЦП, которое было «украдено» у гипервизора виртуальными машинами. Сама виртуальная машина на хосте гипервизора отображается как один отдельный процесс сверху.

Таким образом, использование top на хосте позволяет увидеть, насколько занята виртуальная машина связана с другими процессами, запущенными на этом компьютере. Вы не можете видеть, что происходит внутри виртуальной машины, используя top с хоста, но вам придется делать это, используя соответствующие инструменты внутри виртуальной машины. На скриншоте показан вывод команды top хоста KVM, на котором запущены разные виртуальные машины. Каждая из виртуальных машин отображается как процесс qemu-kvm.

How to Remove virbr0 and lxcbr0 Interfaces on CentOS/RHEL 6,7

The Problem

There is only one Network card on machine but ifconfig shows 2 interface by name virbr0 and lxcbr0. How to remove or disable them permanently if not using them.

Solution

On a Linux host server, the virtual network switch shows up as a network interface. The default one, created when the libvirt daemon is first installed and started, shows up as virbr0. It will act as a gateway for the VMs to route traffic. libvirtd will also insert iptables rules in iptable configuration for proper routing/natting of VM packets.

If you dont want to use libvirtd service, you can stop the same which will remove all these network configurations from the system for virbr0 interface.

lxcbr0 – is a virtual bridge created when you install and configure lxc container with package lxc. you may also remove this interface if not running any lxc containers.

Removing virbr0 interface

Case 1 : Not using libvirtd service

If not using libvirtd service then you may stop that service.

For RHEL/CentOS 5,6

1. Stop the libvirtd service.

2. Disable the libvirtd service permanently, so that it will not start at boot.

For RHEL/CentOS 7

1. Check the status of the service and disable the libvirtd service using systemctl command.

2. To disable the service permanently.

Case 2 : Using libvirtd and dont want “virbr0”

In this scenario libvirtd service will be kept running but we will remove the virbr0 interface. Follow the steps below to remove the virbr0 interface.

1. List the default network set-up for the virtual machines

2. Destroy the network default.

3. Permanently remove the default vitual network from the configuration.

4. The interface virbr0 is now gone. You can verify it in the ifconfig or ip command output.

Removing virbr0 interface on running machines ( non-persistence across reboots )

1. First, list out the virtual bridge interfaces available on the system using the below command.

2. Make the bridge interface down before removal.

3. Now, remove the bridge

4. check if the bridge is removed

Removing lxcbr0 interface

lxcbr0 is a virtual bridge created when you install and configure lxc container with package lxc. To remove the lxcbr0 interface follow the steps given below.

1. change the below line in /etc/sysconfig/lxc. This will be effective after reboot.

change the line from

2. you may remove the lxcbr0 bridge interface for the running system. But this will not be effective after reboot. hence need to perform above step first. Lets first list the bridge interfaces.

3. Make the bridge interface down before removal

4. Now, remove the bridge using the ‘brctl delbr’ command.

CentOS

The Community ENTerprise Operating System

What is purpose of virbr0 interface

What is purpose of virbr0 interface

Post by kriticar » 2017/03/06 19:43:41

Re: What is purpose of virbr0 interface

Post by avij » 2017/03/06 19:58:24

Re: What is purpose of virbr0 interface

Post by TrevorH » 2017/03/06 20:57:18

Re: What is purpose of virbr0 interface

Post by kriticar » 2017/03/06 23:49:26

systemctl disable libvirtd.service

will I be able latter to enable the service with

systemctl disable libvirtd.service

Re: What is purpose of virbr0 interface

Post by avij » 2017/03/07 08:10:04

Re: What is purpose of virbr0 interface

Post by kriticar » 2017/03/07 08:33:46

Re: What is purpose of virbr0 interface

Post by jlehtone » 2017/03/07 09:52:58

Ahh, gnome-boxes requires libvirt.

Libvirt, if installed, has libvirtd.service enabled by default.

Libvirt has a network definition «default» preconfigured and set to autostart.

The «virbr0» is a bridge interface that represents a network (a bridge is essentially a network switch).

Therefore, by installing libvirt (for any reason) by default dynamically creates the «virbr0» on every boot (and adds some netfilter rules too).

Русские Блоги

Сервис 21.2dhcp и PXE, virbr0

Введение

Ссылка на официальное руководство по установке Red Hat

В режиме только хоста виртуальной машины vmware сервис dhcp обычно выбирается для назначения IP-адреса сетевому адаптеру linux только для хоста в vmware, как показано на рисунке 1. Теперь отключите службу dhcp в режиме «только для узла» на рис. 1 и создайте службу dhcp на centos7 в виртуальной машине, чтобы предоставить службу dhcp другим узлам в виртуальной машине.

Кроме того, эксперимент dhcp, построенный здесь, предназначен для следующего эксперимента (подготовка к установке операционной системы centos из сети автоматизации)

Как показано на рисунке 1, остановите службу dhcp в режиме только хоста, виртуальный хост в vmware не может получить ip по dhcp, и вы можете настроить ip только вручную, так что служба dhcp является только локальной службой dhcp, которая будет создана centos7.

Виртуальная сетевая карта с именем virbr0 появляется в команде ifconfig:

Это генерируется после того, как служба libvirt установлена и включена. Libvirt генерирует виртуальный сетевой коммутатор (virbr0) на хосте сервера, и все виртуальные машины (гости) на хосте подключаются через этот virbr0.

По умолчанию virbr0 использует режим NAT (с использованием IP Masquerade), поэтому в этом случае гость может получить доступ к внешней стороне через хост.

Большую часть времени мы используем мост виртуальной машины (bridge) для прямого подключения к локальной сети, поэтому этот virbr0 не нужен (Примечание: мост и мост virbr0 здесь не имеют значения).

Шаги для выключения этого virbr0 следующие

Или Linux нижней базы 265 страниц

В centos7 есть виртуальная сетевая карта virbr0, [root @ cos7:

] # yum list libvirt *

libvirt-daemon

[root @ cos7:

] # yum удалить libvirt-daemon можно перезапустить

Virbr0 был удален здесь, и все centos на виртуальных машинах имеют только одну сетевую карту и находятся в режиме только хоста, чтобы упростить последующий эксперимент по настройке службы centos7 dhcp

Служба DHCP

Запустите службу dhcpd

Причины сообщения об ошибках: поскольку служба dhcp обслуживает этот сетевой сегмент поблизости, если вы не укажете диапазон ip подсети, в котором расположен ip хоста службы dhcp этой сети, будет сообщено об ошибке. Сконфигурируйте только диапазон IP-адресов для предоставления услуги dhcp для узлов в сети, а затем предоставьте dhcp для узлов во внешней сети, не будет сообщать об ошибке

Вы также можете пропинговать www в centos7, и centos7 будет обращаться к поисковому локальному домену в следующем файле для автоматического завершения

Перезапустите сервис без ошибок

Включите centos6 в виртуальной машине, и есть только один сетевой адаптер только для хоста, получите ip следующим образом

Centos6 добавляет сетевой адаптер только для хоста,

Службы pxe и dhcp

После того, как сетевая карта хоста получает IP-адрес от сервера dhcp, он также может получить файл следующего сервера tftp, и этот файл можно использовать для автоматизации установки системы из сетевой загрузки.

]# cat /etc/dhcp/dhcpd.conf

# will still come from the host declaration.

Легкий tftp сервер с небольшими файлами. Если вы хотите указать этому хосту автоматическую установку системы из сети, то аппаратная сетевая карта этого хоста может получать только IP-адрес от dhcp, без операционной системы, без программного обеспечения, клиентское программное обеспечение tftp, как загружать файлы?

Решение заключается в следующем: обычно мы покупаем облегченное клиентское программное обеспечение tpft на сетевой карте хоста компьютера. Пока сетевая карта получает IP-адрес, клиентское программное обеспечение tftp на сетевой карте можно загружать. файл

Предыдущая сетевая карта, интегрированная с облегченной сетевой картой tftp, стала дороже, теперь она стала популярной

Preboot Excution Environment PXE (операционная система установки сетевой автоматизации)

Установка и настройка KVM на CentOS 7

Подготовка сервера

Проверяем наличие поддержки со стороны процессора:

cat /proc/cpuinfo | egrep «(vmx|svm)»

Если команда ничего не вернет, на сервере отсутствует поддержка виртуализации или она отключена в настройках БИОС. Сам KVM поставить на такой сервер можно, но при попытке ввести команду управления гипервизором мы получим ошибку «WARNING KVM acceleration not available, using ‘qemu’». В таком случае необходимо перезагрузить сервер, войти в БИОС, найти поддержку технологии виртуализации (Intel VT или AMD-V) и включить ее.

Создадим каталоги, в которых будем хранить все, что касается виртуализации (предлагаемые по умолчанию не удобные):

* каталог /kvm/images для виртуальных дисков; /kvm/iso — для iso-образов.

Установка и запуск

Установка выполняется из репозитория следующей командой:

yum install qemu-kvm libvirt virt-install

* где qemu-kvm — сам гипервизор; libvirt — библиотека управления виртуализацией; virt-install — утилита для управления виртуальными машинами.

systemctl enable libvirtd

systemctl start libvirtd

Настройка сети

В данной инструкции рассмотрим использование сетевого моста.

Настраивая сетевой мост через удаленное подключение, внимательно проверяйте вводимые данные. В случае ошибки соединение будет прервано.

Устанавливаем пакет для работы с bridge:

yum install bridge-utils

Смотрим список сетевых интерфейсов и их настроек:

В моем примере были следующие данные:

1: lo: mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: enp4s0f0:

mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:16:76:04:26:c6 brd ff:ff:ff:ff:ff:ff

inet 192.168.1.24/24 brd 192.168.1.255 scope global enp4s0f0

valid_lft forever preferred_lft forever

inet6 fe80::216:76ff:fe04:26c6/64 scope link

valid_lft forever preferred_lft forever

3: enp5s5: mtu 1500 qdisc pfifo_fast state DOWN qlen 1000

link/ether 00:16:76:04:26:c7 brd ff:ff:ff:ff:ff:ff

4: virbr0: mtu 1500 qdisc noqueue state DOWN qlen 1000

link/ether 52:54:00:cd:86:98 brd ff:ff:ff:ff:ff:ff

inet 192.168.122.1/24 brd 192.168.122.255 scope global virbr0

valid_lft forever preferred_lft forever

5: virbr0-nic:

mtu 1500 qdisc pfifo_fast master virbr0 state DOWN qlen 1000

link/ether 52:54:00:cd:86:98 brd ff:ff:ff:ff:ff:ff

* из этого для нас важны enp4s0f0 — реальный сетевой интерфейс с настроенным IP-адресом 192.168.1.24, через который идет подключение сервера к локальной сети (из него мы будем делать мост); 00:16:76:04:26:c6 — mac-адрес реального ethernet адаптера; virbr0 — виртуальный сетевой адаптер.

Редактируем настройки реального адаптера:

Приводим его к виду:

ONBOOT=yes

BRIDGE=br0

TYPE=Ethernet

DEVICE=enp4s0f0

BOOTPROTO=none

Создаем интерфейс для сетевого моста:

DEVICE=br0

TYPE=Bridge

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.1.24

NETMASK=255.255.255.0

GATEWAY=192.168.1.1

DNS1=8.8.8.8

DNS2=77.88.8.8

Перезапускаем сетевую службу:

systemctl restart network

Сетевые настройки должны измениться — в моем случае:

2: enp4s0f0:

mtu 1500 qdisc pfifo_fast master br0 state UP qlen 1000

link/ether 00:16:76:04:26:c6 brd ff:ff:ff:ff:ff:ff

3: enp5s5: mtu 1500 qdisc pfifo_fast state DOWN qlen 1000

link/ether 00:16:76:04:26:c7 brd ff:ff:ff:ff:ff:ff

4: virbr0: mtu 1500 qdisc noqueue state DOWN qlen 1000

link/ether 52:54:00:cd:86:98 brd ff:ff:ff:ff:ff:ff

inet 192.168.122.1/24 brd 192.168.122.255 scope global virbr0

valid_lft forever preferred_lft forever

5: virbr0-nic:

mtu 1500 qdisc pfifo_fast master virbr0 state DOWN qlen 1000

link/ether 52:54:00:cd:86:98 brd ff:ff:ff:ff:ff:ff

6: br0:

mtu 1500 qdisc noqueue state UP qlen 1000

link/ether 00:16:76:04:26:c6 brd ff:ff:ff:ff:ff:ff

inet 192.168.1.24/24 brd 192.168.1.255 scope global br0

valid_lft forever preferred_lft forever

inet6 fe80::216:76ff:fe04:26c6/64 scope link

valid_lft forever preferred_lft forever

Настаиваем перенаправления сетевого трафика:

systemctl restart libvirtd

Создание виртуальной машины

Смотрим доступные варианты гостевых операционных систем:

Для создания первой виртуальной машины вводим следующую команду:

Дожидаемся создание виртуальной машины. И переходим к подключению по VNC.

Подключение к виртуальной машине

Для установки операционной системы скачиваем VNC-клиент на компьютер администратора, например, TightVNC и устанавливаем его.

На сервере смотрим, на каком порту слушает VNC созданной машины:

virsh vncdisplay FirstTest

в моем случае было:

Это значит, что нужно к 5900 прибавить 0. Если результат команды будет :1 — 5900 + 1 = 5901 и так далее.

Открываем порт на брандмауэре:

* в данном примере добавлено сразу 6 tcp-портов от 5900 до 5905.

Запускаем установленный TightVNC Viewer, в открывшемся окне вводим IP-адрес сервера KVM и порт, на котором слушает наша ВМ (в данном примере, 5900):

Нажимаем Connect. Программа запросит пароль — вводим тот, что указали при создании ВМ, (в данном примере, my_password). Мы подключимся к виртуальной машине, как будто, к ней подключен монитор или удаленная консоль KVM.

Устанавливаем операционную систему. Если это будет Windows, то проверяем корректность определения драйверов и, при наличии неустановленных устройств, выполняем установку драйверов KVM для гостевой Windows.

Базовые команды управления ВМ

1. Получить список созданных машин:

2. Включить / перезагрузить / выключить.

а) включить виртуальную машину можно командой:

virsh start FirstTest

* где FirstTest — имя созданной машины.

virsh reboot FirstTest

* посылает команду операционной системе на корректную перезагрузку.

в) выключить корректно:

virsh shutdown FirstTest

* посылает команду операционной системе на корректное выключение.

г) выключить принудительно:

virsh destroy FirstTest

* грубо выключает ВМ. Может привести к потере данных. Способ стоит применять при полном зависании виртуалки.

virsh suspend FirstTest

Для возобновления работы вводим команду:

virsh resume FirstTest

е) отправить команду всем гостевым операционным системам:

* первыя команда запустит все ВМ, вторая — отправит команду на выключение.

3. Разрешаем автостарт для созданной ВМ:

virsh autostart FirstTest

4. Удаление виртуальной машины:

Удаляем виртуальную машину:

virsh undefine FirstTest

Удаляем виртуальный жесткий диск:

* где /kvm/images — папка, где хранится диск; FirstTest-disk1.img — имя виртуальног диска для удаленной машины.

5. Редактирование конфигурации виртуальной машины:

Открыть редактор для изменения конфигурации:

virsh edit FirstTest

Также можно менять параметры из командной строки. Приведем несколько примеров для работы с виртуальной машиной FirstTest.

а) изменить количество процессоров:

б) изменить объем оперативной памяти:

6. Работа со снапшотами

а) Создать снимок виртуальной машины можно командой:

* где FirstTest — название виртуальной машины; FirstTest_snapshot_2020-03-21 — название для снапшота.

б) Список снапшотов можно посмотреть командой:

* данной командой мы просмотрим список всех снапшотов для виртуальной машины FirstTest.

в) Для применения снапшота, сначала мы должны остановить виртуальную машину. Для этого можно либо выполнить выключение в операционной системе или ввести команду:

virsh shutdown FirstTest

* где FirstTest — имя виртуальной машины; FirstTest_snapshot_2020-03-21 — имя созданного снапшота.

г) Удалить снапшот можно так:

7. Клонирование виртуальных машин

Для примера, склонируем виртуальную машину FirstTest и создадим новую SecondTest.

Для начала, мы должны остановить виртуалку:

virsh suspend FirstTest

После можно клонировать:

* итого, мы склонируем виртуальную машину FirstTest. Новая машина будет иметь название SecondTest, а путь до диска будет /kvm/images/SecondTest-disk1.img.

Восстанавливаем работу FirstTest:

virsh resume FirstTest

Управление дисками

Отдельно рассмотрим процесс работы с виртуальными дисками.

Добавление диска

Создаем файл для нового диска:

* в данном примере мы создадим файл формата raw по полному пути /kvm/images/FirstTest-disk2.img размером 4 Гб.

Теперь подключим данный диск к виртуальной машине:

* в данном примере мы подключили его к машине VMname в качестве диска vdb.

Готово. Подключаемся к виртуальной машине и проверяем, что у нас появился новый диск. Например, в Linux можно посмотреть командой:

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sr0 11:0 1 1024M 0 rom

vda 252:0 0 24G 0 disk

— vda1 252:1 0 24G 0 part

— ubuntu—vg-root 253:0 0 23G 0 lvm /

— ubuntu—vg-swap_1 253:1 0 980M 0 lvm [SWAP]

vdb 252:16 0 4G 0 disk

Увеличение диска

Получаем список дисков для виртуальной машины:

virsh domblklist FirstTest

Останавливаем виртуальную машину:

virsh shutdown FirstTest

Увеличиваем размер диска:

qemu-img resize /kvm/images/FirstTest-disk1.img +100G

* данной командой мы расширим дисковое пространство виртуального диска /kvm/images/FirstTest-disk1.img на 100 Гигабайт.

Запускаем виртуальную машину:

virsh start FirstTest

Меняем размер блочного устройства:

virsh blockresize FirstTest /kvm/images/FirstTest-disk1.img 200G

* где 200G — новый окончательный размер диска.

Получаем информацию о виртуальном диске:

qemu-img info /kvm/images/FirstTest-disk1.img

После необходимо увеличить диск внутри операционной системы.

Управление через веб-интерфейс

Существуют различные веб-интерфейсы для управления гипервизором KVM. В данной инструкции мы рассмотрим oVirt.

Для его установки вводим команды:

yum install http://resources.ovirt.org/pub/yum-repo/ovirt-release41.rpm

yum install ovirt-engine

После разворачиваем и настраиваем портал:

* после запуска команды система задаст ряд вопросов, на все, кроме ввода пароля, можно ответить по умолчанию (просто нажать Enter).

После окончания установки в браузере вводим https://kvm/ovirt-engine/sso/, где kvm — имя сервера. В открывшемся окне вводим логин admin и пароль, который создали при выполнении команды engine-setup. После успешного входа можно управлять виртуальными машинами через веб-интерфейс.

Обновление базы операционный систем

Ранее мы использовали команду:

. для получения вариантов возможных операционных систем. Со временем данные список устаревает и его необходимо обновлять. Для этого переходим на страницу releases.pagure.org/libosinfo и копируем ссылку на самую последнюю базу:

Используя скопированную ссылку, загружаем базу на сервер:

* в моем примере это версия 20210621.