Как искусственный интеллект пишет музыку

5 нейросетей, делающих музыку: от цифровой Эми Уайнхаус и до бесконечного метала

Разве может робот написать симфонию? Может.

Фото Possessed Photography, unsplash

Идея делать музыку с помощью компьютера появилась с появлением самих компьютеров. Первая композиция «в цифре» была написана аж в 1957 году — это короткая зарисовка The Silver Scale, созданная инженером Bell Laboratories Ньюманом Гутманом.

Искусственным интеллектом как помощником и соавтором впервые заинтересовались академические композиторы: первопроходцем тут считается великий авангардист Янис Ксенакис. Технологии развивались — в девяностые появились алгоритмы для генерации джазовых соло и даже целых аранжировок. А расцвет нейросетей привел к тому, что сгенерированная компьютером музыка рассматривается как перспективное направление: всевозможные инструментальные композиции «для бега» или «для сна» уже есть в стриминговых сервисах.

1 MuseNet

Разработанная отечественными программистами нейросеть научилась сочетать разные стили и жанры музыки: от классики и до кантри. Ее долго натаскивали на сотнях тысяч файлов, в результате мы можем задать программе, например, начальные ноты из шопеновского произведения — а она попытается сгенерировать из этого поп-хит.

2. Ampermusic

В этом случае попробовать сгенерировать свою музыку может любой желающий — в отличие от большинства музыкальных нейросетей, у этой есть простой онлайн-интерфейс. Выбираем стиль, настроение, подходящие инструменты — и вперед. Получается довольно бедно, но забавно.

3. Нейронная оборона, а также почти живые Курт Кобейн и Эми Уайнхаус

В этих примерах разработчики прибегли к читерству. Они понимают, что компьютер, может, и способен сымитировать мелодию, то есть последовательность нот, а также написать текст — но озвучить все это с должной душевностью у него не получится. Да что там, у музыкальных нейросетей до сих пор дикие проблемы с генерированием музыки с вокалом.

Поэтому есть много проектов, в которых нейросети пишут музыкальный и текстовый материал — а живые люди озвучивают это.

Так, сотрудники «Яндекса» Иван Ямщиков и Алексей Тихонов с помощью нейросети записали альбом несуществующих песен Егора Летова. Пел и играл тут сам Иван, так что стопроцентной схожести добиться не получилось.

Аналогичным образом поступила благотворительная организация Over the Bridge, помогающая страдающим от психических расстройств музыкантам. Здесь нейросеть написала песни для проекта «Утерянные записи Клуба 27», попытавшись изобразить стиль Курта Кобейна, Эми Вайнхауc, Джима Моррисона и других рано ушедших от нас звезд. Музыка и тексты сгенерированы на компьютере — а исполняют все это живые люди.

Искусственный интеллект научился сочинять музыку, совсем как человек

Британский стартап Jukedeck разработал искусственный интеллект, который может писать музыку. Основатель стартапа Эд Ньютон-Рекс рассказал, как появился на свет этот творческий ИИ и какой у него потенциал.

Уроки истории

«Все началось с того, что еще будучи студентом, я задал себе вопрос: а могут ли уже компьютеры сочинять музыку? — рассказал основатель стартапа. — Я решил, что они наверняка должны это уметь, и задумался, какой смысл будет в этом умении. Каким удивительным образом его можно будет использовать? В итоге я отправился к подруге в Гарвард, где она как раз изучала компьютерные науки. Я посетил что-то вроде вводной лекции в информатику и понял, что в принципе вполне реально научить компьютер писать музыку.

Я начал работать над прототипом — тогда он представлял собой элементарную систему алгоритмического написания музыки. Работа была сложной, и на нее ушло много времени, но в итоге мне удалось сделать довольно неплохой прототип. Я отвез его в инвестиционное подразделение Кембриджского университета, чтобы получить финансирование».

Фото: Andrii Degeler

ИИ Jukedeck пишет музыку с помощью нейронных сетей — один из многочисленных методов, которые использовались в истории для написания компьютерной музыки. Первые известные эксперименты в этой области проводились еще в 50-х годах XIX века. Первой, кто заговорил о попытках написания машиной музыки, была изобретательница двоичного кода Ада Лавлейс. В 1843 году она написала, что «аналитическая машина Чарльза Бэббиджа может сочинять осмысленные отрывки музыки любой сложности и длины».

Спустя столетия композитор Лейярен Хиллер и программист Леонард Айзексон написали с помощью искусственного интеллекта сюиту «Иллиак». При ее создании ИИ опирался на правила теории музыки. Для своего времени получившееся произведение звучало довольно неплохо.

В XX веке появился еще один способ написания компьютерной музыки — на этот раз с помощью грамматики. Проще говоря, ИИ пытался проанализировать систему строения музыки и создать по ней собственную мелодию. Среди известных людей, пользовавшихся этим методом, был американский ученый и композитор Дэвид Коуп. Благодаря его идее «рекомбинаторики» появился искусственный интеллект, который мог анализировать существующие музыкальные отрывки и на их основе создавать собственные. Вот так, например, звучит имитация произведения Вивальди:

Для написания музыки использовалась и так называемая цепь Маркова (система, чье текущее состояние зависит только от предыдущего), ведь ее концепция очень напоминает принцип создания музыки. Так появился алгоритм Continuator, созданный ученым Франсуа Паше, который может продолжать сочинять музыкальное произведение с того места, где остановился живой композитор.

Еще один метод, которым пользовались для создания музыки с помощью ИИ, это эволюционные алгоритмы. Именно их использует проект британских ученых DarwinTunes. Согласно его основному принципу, любой желающий может прослушать различные отрывки музыки и выбрать из них те, что понравились больше всего. Прошедшие такой «естественный отбор» фрагменты эволюционируют, то есть воспроизводятся в новых вариациях.

Вот, например, одна из композиций DarwinTunes:

Несмотря на то, что с помощью этих методов действительно можно сочинять неплохую музыку, у них всегда есть ограничения. Либо они слишком зависят от теории музыки, либо все сводится к индивидуальным предпочтениям человека, который отбирает лучшие образцы созданной музыки.

Работа нейронных сетей

По словам Ньютона-Рекса, самой большой технологической трудностью в создании ИИ, который смог бы писать музыку, является то, что не существует «хорошей» или «плохой» музыки. Если взять, к примеру, распознавание изображений с помощью нейронных сетей, то там можно научить алгоритм анализировать, какая картинка правильная, а какая нет.

Но с музыкой так не получится, потому что не существует универсального определения, что такое «хорошая» музыка. Музыканты, работающие над Jukedeck, поставили перед собой цель выработать у алгоритма музыкальный вкус и навыки написания музыки.

«Мы слушаем музыку, оцениваем результат и корректируем сети нужным образом, — рассказал Ньютон-Рекс. — При корректировке мы полагаемся на собственный слух (в конце концов, мы же музыканты!) и на количество скачиваний композиций с нашего сайта («стали ли люди скачивать музыку чаще после внесенных изменений?»). Мы используем эти два метода потому что алгоритмическое написание музыки по-прежнему находится на очень раннем этапе развития».

«Стоит отметить, что сама система сильно отличается от того, как работают эволюционные методы, — добавил Ньютон-Рекс. — По эволюционному методу пользователь отбирает лучшие результаты, и система пересоздает их с новыми вариациями — и так до бесконечности. Система ничему не учится. А когда мы используем нейросети, она анализирует данные своего обучения и творит уже на их основе».

Квиз №1. Сможете угадать, какой из этих двух музыкальных фрагментов написан компьютером?

Заменит ли компьютер живых музыкантов?

Несмотря на то, что человечество проводит эксперименты в плане написания музыки с помощью ИИ вот уже более 50 лет, считается, что эта технология еще находится на ранней стадии развития. Однако будущее ее выглядит светлым — по крайней мере, так считают те, кто с ней работают.

«Я очень удивлюсь, если через 10-15 лет большинство музыкальных произведений будет создаваться с помощью искусственного интеллекта», — сказал Ньютон-Рекс.

Это значит, что в будущем композиторам — в частности тем, кто пишет музыку на заказ — возможно, придется искать другую работу.

Сами композиторы пока что не сильно беспокоятся на этот счет. Дмитрий Лившиц, скрипач, инженер звукозаписи и лучший композитор на популярной площадке стоковой музыки считает, что искусственный интеллект и проект Jukedeck смогут достичь мастерства человека еще лишь спустя много лет.

«Электроника звучит более-менее нормально, — сказал он после прослушивания музыки, созданной Jukedeck. — А вот гитары в рок-композициях просто ужас. У такой музыки немного синтетическое звучание, но, думаю, для тех, кто не задумывается, что играет на фоне, сойдет. Рекламные агентства, конечно же, не станут использовать эту музыку, а вот влогеры на YouTube вполне могут».

Лившиц согласен, что когда ИИ сможет создавать действительно хорошую фоновую музыку для видеоблогов и рекламных роликов, стоковым композиторам действительно придется искать новый вид заработка. Однако он не выразил сожаления и заявил, что уже «сотрудничает» с ИИ — а именно пользуется приложением, которое генерирует музыкальные идеи и тем самым помогает композиторам, у которых пропало вдохновение.

Квиз №2. Давайте попробуем еще раз. Какой из этих треков написан компьютером?

«Только образованные люди могут создать произведение искусства, которое будет нести в себе какую-то мысль, — заявил он. — Сомневаюсь, что искусственный интеллект сможет когда-нибудь написать саундтрек к фильму, который бы вызывал мурашки. Машина на такое не способна».

У Ньютон-Рекса другая позиция на этот счет. Он считает, что с помощью творческого ИИ написание музыки станет занятием, доступным более широкой аудитории.

«Сейчас создание музыки — это занятие, доступно только элите, — сказал он. — Чтобы хорошо писать музыку, нужно получить дорогое образование и долго учиться. Музыкальное творчество недоступно большинству людей. ИИ сможет решить эту проблему. С его помощью люди смогут писать музыку, а значит ее станет больше, и она будет более персонализированной».

Однако именно этого и боятся некоторые композиторы.

«Инструменты, позволяющие генерировать музыку, с одной стороны являются отличными помощниками для композиторов, — сказал Владимир Поникаровский, композитор стоковой музыки, который сейчас перешел в индустрию разработки игр. — С другой же, если ими будет пользоваться огромное количество людей, на свет появится тонна некачественного контента, из-за чего может в среднем упасть качество стоковой музыки».

Но Ньютон-Рекс спешит развеять все опасения о том, что ИИ окажет негативный эффект на музыку в целом. По его словам, когда-то все точно так же возмущались по поводу электронных инструментов, и даже было движение против синтезаторов. В итоге благодаря технологическим инновациям в музыке на свет появились целые новые музыкальные жанры — и в будущем может произойти то же самое благодаря ИИ.

А что насчет денег?

У Jukedeck нет специальной системы для защиты музыки от нелегального копирования, поэтому стартапу приходится полагаться лишь на честность своих клиентов. Хотя, возможно, вскоре ситуация изменится.

«В самом начале мы делали музыку для видеороликов, — рассказал Ньютон-Рекс. — Мы создавали ее для видеоблогеров на YouTube и не монетизировали ее. Мы думали так: «Давайте докажем всем, что наша музыка хороша, и ей захотят пользоваться люди». Сейчас же на нашем сайте более полумиллиона композиций. Пока что мы не объявили о следующем шаге, но вообще рассматриваем различные области видеорынка, где могли бы монетизировать свои произведения. Именно этим мы планируем заниматься в ближайшие несколько месяцев».

Представители музыкальной индустрии и крупные игроки технологического рынка тоже обратили внимание на возможность сочинять музыку с помощью ИИ. Например, у Sony есть собственное средство для создания музыки под названием Flow Machines, о котором прошлой осенью много писала пресса. Этот ИИ создал песню под названием Daddy’s Car в стиле The Beatles.

Для Ньютон-Рекса и его проекта Jukedeck появление таких новых игроков с большими ресурсами, означает, что конкуренция на рынке станет гораздо жестче. А для рядового слушателя это значит лишь то, что довольно скоро его ждут совершенно новые музыкальные впечатления.

Как искусственный интеллект сочиняет музыку

Пьеса «Из мира будущего» чешского композитора Антонина Дворжака оставалась незаконченной 115 лет. Искусственный интеллект AIVA завершил ее за 72 часа — и в позапрошлом году пьеса увидела свет в исполнении оркестра Пражской филармонии. Певица Граймс написала в соавторстве с нейросетью бесконечную колыбельную для своего ребенка по имени X Æ A-12. Зачем? Да чтобы не воспитывать его на устаревших детских песенках. А трек, состоящий из хрюканья коалы и криков кукабарры, принес своим создателям победу в первом «Евровидении» для ИИ. Рассказываем, на что еще способны нейросети в мире музыки, и предлагаем послушать самые интересные примеры.

Как вообще машина пишет музыку?

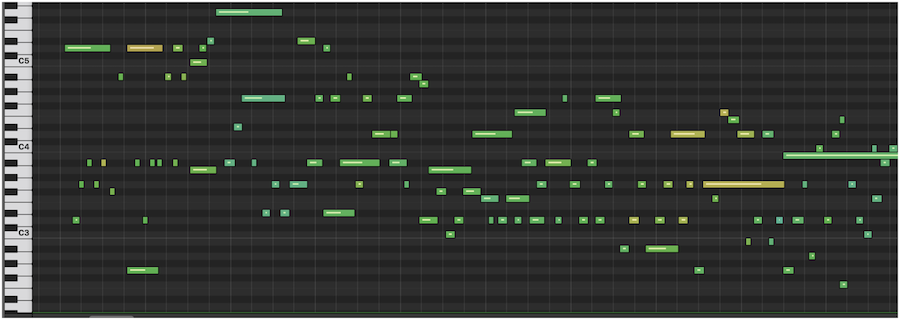

Прежде чем начать «сочинять», нейросеть учится. Программист « кормит» ее большим количеством музыкальных MIDI-дорожек, чтобы ИИ выявлял закономерности между звуками. Основываясь на этих самых закономерностях, компьютерный мозг генерирует что-то новое.

Варианта два. Первый: машина « слушает» музыкальный фрагмент, а затем пытается воспроизвести его – так, чтобы было максимально похоже на оригинал. Второй: компьютер «слышит» одну ноту и пытается предсказать следующую, опираясь на свой «слушательский» опыт.

И что, из этого может получиться нормальный трек?

В среднем 9 из 10 мелодий, написанных нейросетью, звучат как какофония. Но оставшиеся 10% довольно приемлемы. Правда, полноценными композициями они становятся только после того, как обработкой займется человек. Без нас пока, к сожалению или к счастью, машине-композитору не обойтись.

Нейросеть feat. Скрябин

В 2017-м конференция Яндекса на тему применения новейших цифровых технологий неожиданно началась со звуков классической музыки. Камерный оркестр играл произведение в стиле композитора Александра Скрябина. Только вот создала ее нейросеть.

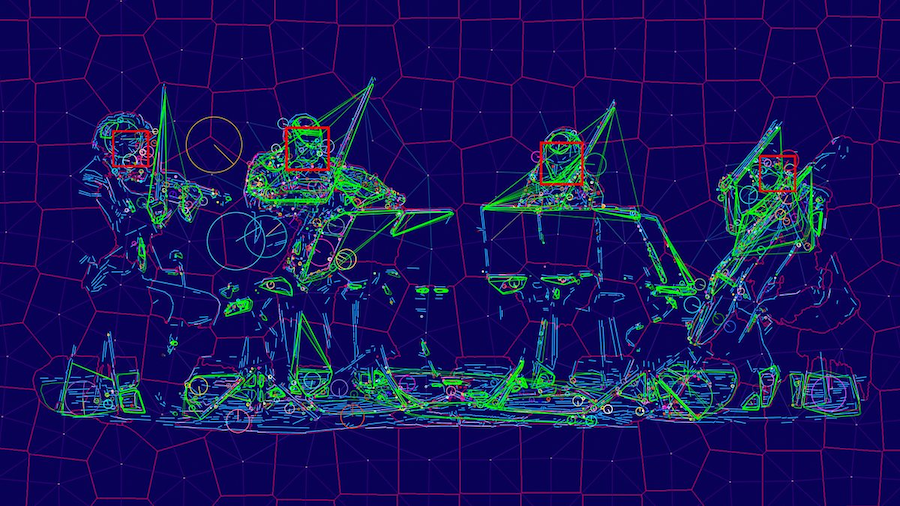

Чтобы машина написала музыку, программисты Яндекса Алексей Тихонов и Иван Ямщиков воспитывали ее не только на композициях Скрябина, но и на произведениях его великих предшественников — Моцарта, Брамса, Бетховена. В общей сложности нейросеть «проглотила» около 4 гигабайтов MIDI-файлов и примерно 600 часов музыки. После этого ликбеза машина выдала несколько треков, а композитор и эксперт по творчеству Скрябина Мария Чернова написала аранжировку. Вот что получилось.

В 2019 году нейросеть Яндекса в соавторстве с людьми выдала еще три трека. Композитор Кузьма Бодров выбрал несколько мелодических линий, сочиненных машиной, и на их основе написал 8-минутную пьесу для альта с оркестром. Это творение нейросети и Бодрова прозвучало на закрытии Зимнего международного фестиваля искусств в Сочи — причем в исполнении оркестра «Новая Россия» под управлением Юрия Башмета.

Техно-музыкант Никита Забелин тоже взял несколько музыкальных фрагментов, созданных нейросетью, и превратил их в эмбиент-трек. А вот группа «Комсомольск» не просто обогатила мелодию искусственного интеллекта аранжировкой, но и написала к ней текст — получилась песня под названием «Мы ищем человека».

Все эти дуэты людей и нейросетей вошли в альбом «Нечеловеческая музыка».

Новые релизы вместо Nirvana и Metallica

С музыкой понятно, но что со словами? Искусственный интеллект и рифмует неплохо. Пока группа Metallica уже несколько лет не может закончить новый альбом, блогер Funk Turkey «скормил» нейросети тексты рокеров о любви и смерти, и она предложила свою версию нового текста. Мелодию блогер придумал сам — получилась песня «Deliverance Rides». В комментариях кто-то сказал, что дал послушать трек отцу, и тот ответил: «Metallica так отлично не звучала уже давно».

На волне успеха Funk Turkey решил создать композицию в стиле Nirvana. Всю музыку и вокал он записал и свел на кухне, где, помимо плиты и чайника, были только гитара, плохой микрофон и программа Pro Tools. Текст снова написала нейросеть. Стихи получились слишком загадочными: «Я бы съел вашу коробку в форме сердца», «Эй, погоди! У меня тут комар!», «В соснах, где ты меня задушил». Но вопрос тут не к ИИ, а к текстам Курта Кобейна, из которых нейросеть повыбирала отдельные слова и речевые обороты.

Бесконечный концерт для басового соло

Если вы переслушали весь дэнс-панк или испанский джаз и соскучились по новым именам, ИИ может выступить в вашем любимом жанре. Например, в 2017 году машина создала альбом Coditany of Timeness на основе пластинки Diotima нью-йоркских блэк-металлистов Krallice. Получилось вполне реалистично.

Этот эксперимент был проведен в рамках проекта DADABOTS. Его основали два друга, которые познакомились на факультете компьютерных технологий Бостонского университета, — исследователь ИИ Си Джей Карр и саунд-продюсер Зак Зуковски. Возможностями нейросетей парни увлекались еще в студенческие годы и решили объединить этот интерес со своей страстью — хорошей музыкой.

Эмбиент на все случаи жизни

В 2019 году звукозаписывающая компания Warner Music впервые заключила контракт на создание музыки с помощью алгоритмов. Не с кем-нибудь, а с русскими парнями — основателями немецкого сервиса Endel.

Плодовитые алгоритмы Endel выпустили 20 альбомов с расслабляющими мелодиями. У каждого диска есть «погода» и настроение, только прочтите их названия: «Стрессовое облачное утро», «Расслабленный летний вечер», «Ясная ночь».

Стоит знать, что один из основателей Endel — Олег Ставицкий — музыке не учился, просто работал в журнале «Игромания» и часто писал статьи под эмбиент. Так ему было легче сосредоточиться. Только вот старые альбомы быстро надоедали, а найти классные новые было непросто. Тогда он задумал приложение, которое умело бы бесконечно генерировать эмбиент и помогало бы человеку сконцентрироваться, расслабиться или уснуть.

Система Endel берет за основу звуковые дорожки, которые пишет Дмитрий Евграфов, композитор и второй сооснователь приложения. И, помимо уже готовых плейлистов, Endel предлагает каждому пользователю музыку, которая автоматически пишется специально для него, собираясь из семплов и дорожек как конструктор. Система анализирует данные о человеке, например, измеряемую смарт-часами частоту пульса, а потом соотносит их с внешними факторами — временем суток, погодой за окном и местоположением. В результате ИИ пишет идеальный «саундтрек» для любого занятия. А е сли данные меняются, технология быстро на это реагирует и предлагает новое, более подходящее звуковое сопровождение — для работы, прогулки в парке, дневного сна или утреннего кофе.

Колыбельная для X Æ A-12

Пока основатель SpaceX Илон Маск планировал колонизировать Марс, его девушка — певица Граймс — записала для их ребенка X Æ A-12 колыбельную. Но не простую, а в паре с искусственным интеллектом — здесь ей на помощь пришли ребята из Endel.

Это все ради хайпа? Да нет. Девушка волновалась, что малышу X Æ A-12 не подойдут обычные детские песенки. Граймс, по собственному признанию, не хотела «портить ему знакомство с миром». А под Endel ей самой нравилось засыпать — вот и предложила им организовать для сына бесконечную цифровую колыбельную. Примеры мелодий Граймс записала самостоятельно. По словам певицы, для эксперимента она выбирала только те семплы, которые вызывали у малыша улыбку.

Песня коал, кукабарр и тасманских дьяволов

К ак вообще на «Евровидении» могла появиться песня на эту тему? Виной тому был источник данных. Искусственный интеллект обучали не только на голландском фольклоре и лучших песнях « Евровидения», но и на текстах с онлайн-платформы Reddit, чтобы разнообразить язык. Так родилась песня с анархистским уклоном — нетипичный выбор для телевизионных конкурсов. Команда Can AI Kick It все же решила отправить жюри именно ее — чтобы показать, как непредсказуемо себя может повести ИИ в жизнерадостной попсовой среде.

Нейронная соната: как искусственный интеллект генерирует музыку

Об эксперте: Ольга Перепелкина, эксперт в области машинного обучения и нейросетей, преподаватель и автор курса Affective Computing в ВШЭ.

Творчество всегда считалось прерогативой человечества. И если в когнитивных задачах, таких как вычисления и обработка информации, мы уже признали превосходство искусственного интеллекта и активно пользуемся плодами автоматизации, то в таких «человеческих» видах деятельности как живопись, поэзия или композиторство алгоритмы нам уступают. И вообще, разве можно поставить на поток производство шедевров? Однако задачей автоматического создания картин, стихов и музыки ученые занимаются уже несколько десятилетий, и некоторые успехи определенно достигнуты.

Первая музыка, созданная с использованием компьютера, появилась в 1957 году в Bell Laboratories. Это была композиция длиной 17 секунд, которую ее автор Ньюман Гутман назвал The Silver Scale («Серебряная чешуя»):

В том же году The Illiac Suite стала первой партитурой, написанной компьютером. Она был названа в честь компьютера ILLIAC I университета штата Иллинойс в США. Это ранний пример алгоритмической композиции, основанной на вероятностном моделировании (цепях Маркова). В области синтеза звука знаменательным событием стал выпуск синтезатора DX 7 компанией Yamaha в 1983 году, использующего модель синтеза на основе частотной модуляции (FM).

Генерация музыки

Когда мы говорим о создании музыки при помощи компьютера, речь может идти как об ассистивной системе или компьютерной среде, помогающей музыкантам (композиторам, аранжировщикам, продюсерам), так и об автономной системе, нацеленной на создание оригинальной музыки. В обоих типах систем могут участвовать нейросетевые алгоритмы и глубокое обучение.

Мы также можем говорить о разных этапах создания музыки, где искусственный интеллект встраивается в процесс и помогает нам: сочинение, аранжировка, оркестровка и т.д. Когда человек сочиняет музыку, он редко создает новое произведение с нуля. Он повторно использует или адаптирует (сознательно или бессознательно) музыкальные элементы, которые слышал ранее, а также руководствуется принципами и рекомендациями из теории музыки. Так и компьютерный помощник может включаться на различных этапах создания произведения, чтобы инициировать, предлагать или дополнять композитора-человека.

Генерация нот

Традиционным подходом является создание музыки в символической форме. Результатом процесса генерации может быть музыкальная партитура, последовательность событий MIDI (распространенный стандарт цифровой звукозаписи), простая мелодия, последовательность аккордов, текстовое представление или какое-либо другое представление более высокого уровня. То есть искусственный интеллект создает символическую форму, по которой затем можно сыграть произведение.

Иными словами, физический процесс, посредством которого создается звук, упраздняется — вместо создания всего многообразия аудиосигнала, алгоритм выдает «инструкцию». Это резко сокращает объем информации, которую алгоритмы должны производить, что сводит проблему синтезирования к более решаемой и позволяет эффективно использовать простые модели машинного обучения.

Такой подход, например, позволил создать музыку в стиле Баха. Другой пример — нейросеть от OpenAI Musenet, которая появилась в апреле 2019 года. MuseNet может сочинять четырехминутные композиции на десяти инструментах и комбинировать стили «от Моцарта до Beatles». Эта нейросеть была обучена на огромном массиве MIDI-записей.

Генерация аудио

Но символический подход не позволяет создать нюансы человеческого голоса и различные характеристики тембра, динамики и выразительности музыкального произведения. Другой способ — это создавать музыку напрямую в виде аудиосигнала. Сложность этого подхода в том, что последовательность, которую мы в таком случае пытаемся создать — очень длинная. Например, для песни в несколько минут в хорошем студийном качестве это будет десятки миллионов значений.

В апреле 2020 года, компания OpenAI выпустила Jukebox, — нейросеть, которая генерирует музыку в различных жанрах. Она может сгенерировать даже элементарный голос, а также различные музыкальные инструменты. Jukebox создает аудиосигнал напрямую, минуя символьное представление. Такие музыкальные модели имеют гораздо большую емкость и сложность, чем их символьные аналоги, что подразумевает более высокие вычислительные требования для обучения модели.

Как творят нейросети?

Как же именно нейросети создают музыку? Общий принцип заключается в том, что нейросеть «смотрит» на огромное количество примеров и учится генерировать что-то похожее. В основе таких алгоритмов обычно лежат автокодировщики и генеративно-состязательные нейросети (Generative Adversarial Network, GAN).

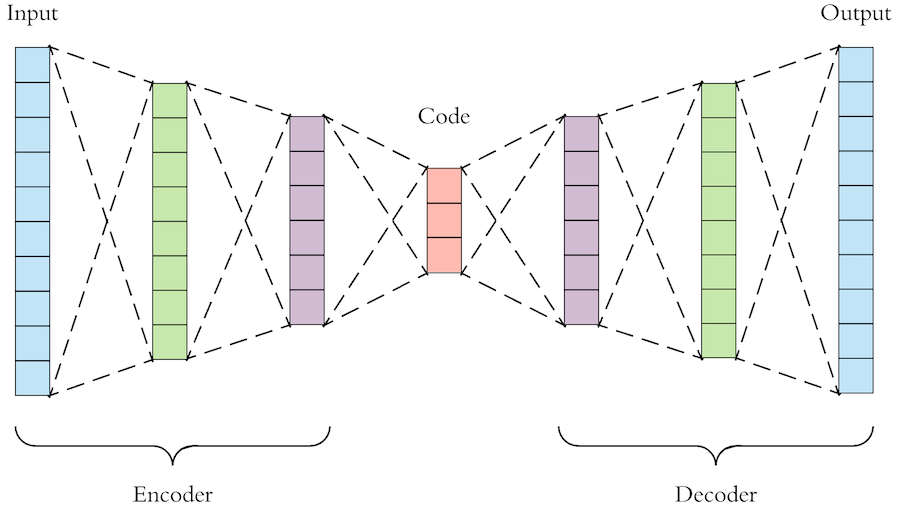

Автокодировщик — это нейросеть, которая учится представлять сложный и многомерный набор данных в «упрощенном» виде, а затем из этого упрощенного представления снова воссоздать исходные данные. То есть модель генерации музыки на основе автокодировщика сначала сжимает необработанный звук в пространство меньшей размерности, отбрасывая некоторые из несущественных для восприятия битов информации. Затем мы обучаем модель генерировать звук из этого сжатого пространства и повышать качество до исходного звукового пространства.

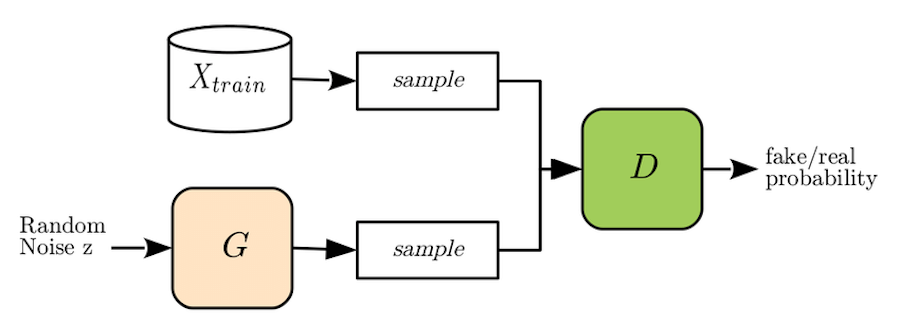

Генеративно-состязательную нейросеть метафорично можно представить как работу «фальшивомонетчика» и «следователя». Задача «фальшивомонетчика», или генеративой модели нейронной сети (generator, G), — создать из шума реалистичный экземпляр данных, например, изображение лица или, в нашем случае, музыкальную последовательность. «Следователь», или дискриминативная модель (discriminator, D) пытается отличить реальный экземпляр данных (настоящую фотографию лица или настоящую музыкальную мелодию) от «фальшивой», созданной генератором. И так, соревнуясь друг с другом, обе модели совершенствуют свои «навыки», в результате чего генеративная модель обучается создавать очень правдоподобные примеры данных.

Для обучения модели Jukebox использовал базу данных из 1,2 млн песен (600 тыс. из которых на английском языке), которая включала как сами композиции, так и тексты песен и метаданные — исполнителя, жанр и ключевые слова.

Музыкальный тест Тьюринга

Как понять, что музыкальное произведение, созданное машиной, действительно достойно нашего внимания? Для проверки работы систем искусственного интеллекта был придуман тест Тьюринга. Его идея заключается в том, что человек взаимодействует с компьютерной программой и с другим человеком. Мы задаем вопросы программе и человеку и пытаемся определить, с кем же мы разговариваем. Тест считается пройден программой, если мы не можем отличить программу от человека.

В области генерации музыки иногда используют «музыкальный тест Тьюринга». Так, например, был протестирован алгоритм DeepBach, который генерирует ноты в стиле Баха. Были опрошены более 1,2 тыс. людей (как эксперты, так и обычные люди), которые должны были отличить реального Баха от искусственного. И оказалось, что сделать это очень сложно — люди с трудом могут различать хоралы, сочиненные Бахом, и созданные DeepBach.

В области создания аудио успехи пока не столь впечатляющие. Несмотря на то, что Jukebox представляет собой смелый шаг вперед в плане качества музыки, длины аудио и способности настроиться на исполнителя или определенный жанр, различия между искусственной музыкой и произведениями, созданными людьми, все еще заметны. Так, в мелодиях от Jukebox хоть и есть традиционные аккорды и даже впечатляющие соло, мы не слышим крупные музыкальные структуры, такие как повторяющиеся припевы. Также в искусственных произведениях слышны шумы, связанные со способом работы моделей. Скорость генерации музыки также пока еще невысока — для полного рендеринга одной минуты звука с помощью Jukebox требуется около девяти часов, поэтому их пока нельзя использовать в интерактивных приложениях.

А как же лирика?

Хорошо, с музыкальными композициями разобрались, а как же тексты для песен? Может ли искусственный интеллект сочинять стихи? Да, и эта задача даже проще, чем написание мелодий, хотя и сложностей здесь тоже хватает — алгоритму нужно не только «придумать» осмысленный текст, но и учесть его ритмическую структуру.

В 2016 году разработчики «Яндекса» выпустили альбом «Нейронной обороны». В него вошли 13 песен в стиле «Гражданской обороны», тексты для которых сочинил искусственный интеллект. А годом позже вышел альбом «Neurona» с четырьмя песнями в стиле Nirvana, стихи для которых также были сгенерированы нейросетями.

Сейчас спою

Музыку мы создавать научились, стихи для нее писать — тоже, а как же быть с человеческим голосом? Могут ли нейросети петь вместо нас?

Генерация реалистичного человеческого голоса нужна не только для пения, но и во многих системах — от call-центров до личных голосовых помощников. Еще в 2016 году компания DeepMind выпустила алгоритм WaveNet, который создает очень реалистичный голос по заданному тексту (Text-To-Speech). Технология доступна для двух языков — английского и китайского.

В апреле 2020 года в ByteDance AI Lab (лаборатории компании, создавшей знаменитый TikTok) создали алгоритм ByteSing. Эта система на основе нейросетевых автокодировщиков позволяет генерировать очень реалистичное пение на китайском языке.

Большинство разработчиков современных алгоритмов генерации музыки, стихов и пения отмечают, что их системы являются ассистивными. Они не претендуют на полноценную замену человеческого творчества, а, напротив, призваны помочь человеческой музе. Человек не перестанет творить по мере развития алгоритмов и программ, но будет использовать их в своей деятельности. Очень вероятно, что в будущем великие шедевры будут созданы людьми и искусственным интеллектом совместно.