Tof камера что это

Что такое ToF-камера в смартфоне

Между производителями смартфонов идет постоянное соперничество. Чтобы как-то выделиться среди конкурентов и переманить покупателей на свою сторону, компании наделяют мобильники все новыми и новыми фишками. Кто-то развивается в плане дизайна, предлагая то вырезы, то изогнутые дисплеи, а кто-то разрабатывает новые форм-факторы вроде слайдеров, выдвижных элементов и гибких дисплеев.

Один из распространенных рецептов по созданию уникального и интересного смартфона касается камеры. Поле для экспериментов в этой области широкое: в современных мобильниках используются несколько объективов. Производителю остается только выбрать, какую комбинацию установить.

Последним нововведением в мобильных камерах стал датчик ToF, или времяпролетная камера. Давайте разберемся, что это и какую пользу от нее может получить простой обыватель.

Что такое ToF-камера

Времяпролетная камера, как подсказывает ее название, измеряет время, затраченное на движение импульса света от датчика до объекта съемки и обратно. Полученные данные используются камерой для построения карты глубины, то есть объемной картинки.

Этот метод построения изображения существует давно. У него есть свои особенности, которые до недавних пор не позволяли использовать его в коммерческих целях в таких малогабаритных устройствах, как смартфон. Свет перемещается с невероятной скоростью – 299 792 458 метров в секунду, поэтому ToF-камера должна обладать технологией, способной улавливать мельчайшую разницу в показателях времени, и иметь компактный размер, чтобы уместиться в корпусе смартфона.

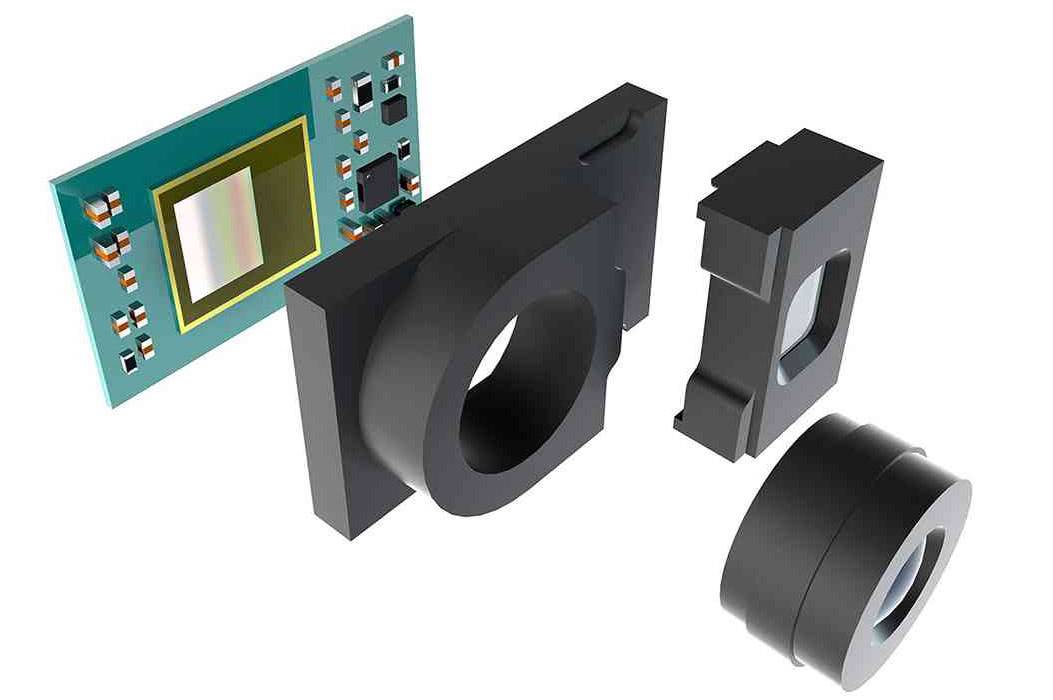

ToF-камера состоит из 4 основных компонентов:

Сенсор и линза – обязательные компоненты любой камеры. У времяпролетного датчика есть еще излучатель и процессор. Первый испускает поток света, второй отвечает за измерение времени. На работу ToF-камеры уходят доли секунды.

Как работает ToF-камера

Луч света, испускаемый датчиком, возвращается быстро, если объект съемки находится близко к объективу. Чем дальше расположен объект или его часть, тем больше времени уйдет на то, чтобы луч достиг его, отразился и вернулся. Показатель расстояния измеряется для каждого пикселя. Это дает подробное представление о том, как выглядит объект, какие особенности формы имеет и как далеко находится. В качестве импульса используется инфракрасный свет, невидимый для человеческого глаза.

Аналогичный подход использует Apple в камере TrueDepth для разблокировки по лицу: там тоже создается трехмерное изображение лица пользователя по точкам, только за основу взята лазерная технология LIDAR.

У мобильной ToF-камеры есть свои недостатки. Первый связан с тем, что яркое освещение может мешать работе датчика: отраженные лучи теряются в окружающем пространстве, а камере не хватает чувствительности, чтобы распознать их и не перепутать с посторонними бликами. Второй недостаток – относительно низкое разрешение по сравнению с основными камерами.

Для чего нужна ToF-камера в смартфоне

В смартфонах времяпролетные камеры используются для сбора информации о глубине кадра, которая в свою очередь нужна для построения трехмерных изображений, отделения фона от объекта съемки в портретном режиме и распознавания жестов.

До недавнего времени смартфоны могли создавать 3D-изображения с помощью программных алгоритмов или специально выделенной камеры, исполняющей роль датчика глубины (стереовидение). ToF-камера – это новая ступень в развитии мобильной фотографии, так как она способна работать в темноте, обладает более высокой точностью и сниженным энергопотреблением.

В каких смартфонах есть ToF-камера

Времпролетная камера – инновационный элемент в мобильной индустрии. Пока она доступна лишь во флагманском сегменте, но в будущем наверняка станет встречаться и в аппаратах среднеценового класса. Пока что обладателями ToF-датчика являются:

По слухам, времяпролетная камера будет включена в фотомодуль iPhone 2019.

Time of flight

Знаете, меня порой удивляет причудливая структура общественного мнения. Взять к примеру технологию 3D-визуализации. Огромный общественный резонанс вызывают в последнее время технологии очков виртуальной реальности: Oculus Rift, Google Glass. Но ведь ничего нового тут нет, первые шлемы виртуальной реальности появились ещё в конце 90-х. Да, они были сложны, они опередили своё время, но почему тогда это не вызывало такого WOW-эффекта? Или 3D-принтеры. Статьи о том, как они круты или как быстро они захватят мир появляются в информационном поле два раза в неделю последние года три. Я не спорю, это круто и мир они таки захватят. Но ведь эта технология была создана ещё в 80х и с тех пор вяло прогрессирует. 3D-телевидение? 1915 год…

Технологии все эти хороши и любопытны, но откуда столько шумихи из-за каждого чиха?

Что, если я скажу, что в последние 10 лет была изобретена, разработана и внедрена в массовое производство технология 3D съёмки, очень сильно отличающаяся от любой другой? При этом технология уже повсеместно используемая. Отлаженная и доступная простым людям в магазинах. Вы слышали про неё? (наверное только специалисты по робототехнике и сопутствующим областям науки уже догадались, что я говорю про ToF-камеры).

Что такое ToF камера? В русской Википедии (англ) вы не найдёте даже коротенького упоминания о том, что это такое. «Time of flight camera» переводится как «Времяпролётная камера». Камера определяет дальность через скорость света, измеряя время пролёта светового сигнала, испускаемого камерой, и отражённого каждой точкой получаемого изображения. Сегодняшним стандартом является матрица 320*240 пикселей (следующее поколение будет 640*480). Камера обеспечивает точность измерения глубины порядка 1 сантиметра. Да-да. Матрица из 76800 сенсоров, обеспечивающих точность измерения времени порядка 1/10,000,000,000 (10^-10) секунды. В продаже. За 150 баксов. А может вы ею даже пользуетесь.

А теперь чуть подробнее про физику, принцип работы, и где вы встречали эту прелесть.

Существуют три основных типа ToF-камер. Для каждого из типов используется своя технология измерения дальности положения точки. Самая простая и понятная — «Pulsed Modulation» она же «Direct Time-of-Flight imagers ». Даётся импульс и в каждой точке матрицы измеряется точное время его возвращения:

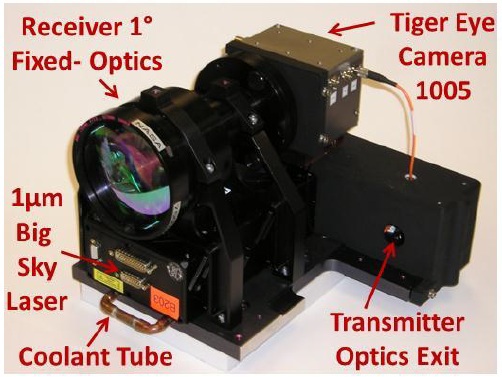

По сути матрица состоит из триггеров, срабатывающих по фронту волны. Такой же способ используется в оптических синхронах для вспышек. Только тут на порядки точнее. В этом-то и основная сложность этого метода. Требуется очень точное детектирование времени срабатывания, что требует специфических технических решений (каких — я не смог найти). Сейчас такие сенсоры тестирует NASA для посадочных модулей своих кораблей.

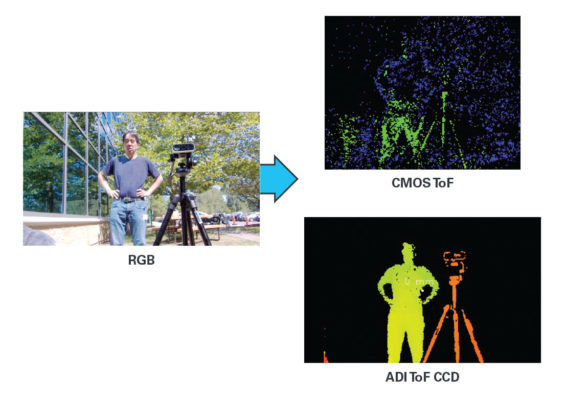

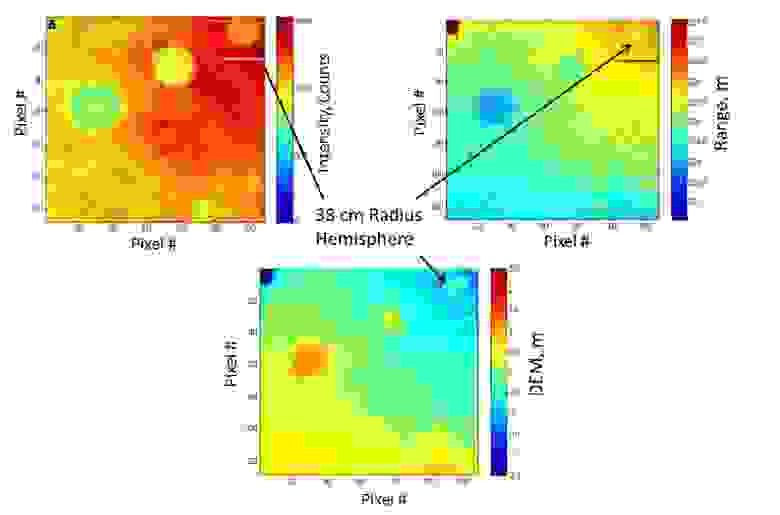

А вот картинки которые она выдаёт:

Подсветки на них хватает, чтобы триггеры срабатывали на оптический поток отражённый с расстояния порядка 1 километра. На графике приведено число сработавших в матрице пикселя в зависимости от расстояния 90% работают на расстоянии в 1км:

Второй способ — постоянная модуляция сигнала. Излучатель посылает некоторую модулированную волну. Приёмник находит максимум корреляции того, что он видит с этой волной. Это определяет время, которое сигнал потратил на то, чтобы отразиться и прийти на приёмник.

Пусть излучается сигнал:

где w — модулирующая частота. Тогда принятый сигнал будет выглядеть как:

где b-некий сдвиг, a-амплитуда. Корреляция входящего и исходящего сигнала:

Но полную корреляцию со всеми возможными сдвигами по времени произвести достаточно сложно за реальное время в каждом пикселе. Поэтому используется хитрый финт ушами. Полученный сигнал принимается в 4 соседних пикселя со сдвигом в 90⁰ по фазе и коррелируется сам с собой:

Тогда сдвиг по фазе определяется как:

Зная полученный сдвиг по фазе и скорость света получаем дальность до объекта:

Эти камеры чуть попроще, чем те, что построены по первой технологии, но всё равно сложны и дороги. Делает их вот эта компания. И стоят они порядка 4килобаксов. Зато симпатишные и футуристичные:

Третья технология — » Range gated imagers «. По сути затворная камера. Идея тут до ужаса проста и не требует ни высокоточных приёмников, ни сложной корреляции. Перед матрицей стоит затвор. Предположим, что он у нас идеальный и работает моментально. В момент времени 0 включается освещение сцены. Затвор закрывается в момент времени t. Тогда объекты, расположенные дальше, чем t/(2∙c), где с — скорость света видны не будут. Свет просто не успеет долететь до них и вернуться назад. Точка, расположенная вплотную к камере будет освещаться всё время экспозиции t и иметь яркость I. Значит любая точка экспозиции будет иметь яркость от 0 до I, и эта яркость будет репрезентацией расстояния до точки. Чем ярче — тем ближе.

Осталось сделать всего пару мелочей: ввести в модель время закрытия затвора и поведение матрицы при этом событии, неидеальность источника освещения (для точечного источника света зависимость дальности и яркости не будет линейной), разную отражающую способность материалов. Это очень большие и сложные задачи, которые авторы устройств решили.

Такие камеры самые неточные, но зато самые простые и дешёвые: всю сложность в них составляет алгоритм. Хотите пример того как выглядит такая камера? Вот он:

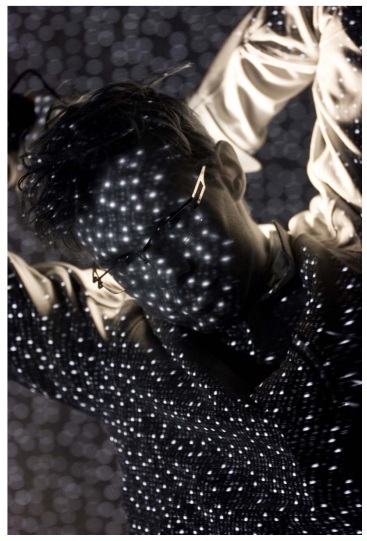

Да-да, во втором Kinect стоит именно такая камера. Только не стоит путать второй Kinect с первым (на хабре когда-то давно была хорошая и подробная статья где всё же перепутали). В первом Kinect используется структурированная подсветка. Это куда более старая, менее надёжная и более медленная технология:

Там используется обычная инфракрасная камера, которая смотрит на проектируемый паттерн. Его искажения определяют дальность (сравнение методов можно посмотреть вот тут).

Но Kinect далеко не единственный представитель на рынке. Например Intel выпускает камеру за 150 долларов, которая выдаёт 3д карту изображения. Она ориентирована на более ближнюю зону, но у них есть SDK для анализа жестов в кадре. Вот ещё один вариант от SoftKinetic (у них тоже есть SDK, плюс они как-то завязаны на texas instruments).

Сам я, правда до сих пор не сталкивался ни с одной из этих камер, что жалко и досадно. Но, думаю и надеюсь, что через пяток лет они войдут в обиход и моя очередь настанет. Насколько я знаю, их активно используют при ориентации роботов, внедряют в системы распознавания по лицам. Круг задач и применений очень широк.

Камеры глубины. Обзор устройств.

В этой заметке мы разберемся, какие устройства для 3D сканирования доступны рядовому пользователю, и на что способны мобильные камеры глубины. Обзор инструментов, подходящих для сканирования помещений.

Есть отрасли, где геометрия объекта и понимание того, насколько далеко объекты расположены от зрителя и относительно друг друга, играет ключевую роль: протезирование, инженерия, связанные с проектированием деталей задачи, беспилотные автомобили и даже криминалистика — сканирование места преступлений. Для маркетинга и мультимедиа представление объектов в 3D расширяет границы возможностей — пример тому набравшие популярность 3D туры по музеям, оцифровка экспонатов и достопримечательностей.

При сканировании, модель и сцены создаются не художником или конструктором, а берутся из реального окружения. С помощью устройства, снабженного различными камерами и датчиками, физические свойства объекта или пространства (форма, цвет) переносятся в цифровую среду. Отсканированные модели можно использовать как основу для дальнейшей доработки или другого анализа, в том числе семантического. Такой подход будет экономить время и деньги, а силы специалистов в результате можно будет направить на решение более творческих задач — все это ведет к автоматизации, к которой мы все так стремимся.

Описание задачи

Перед нами стояла задача — быстрое и качественное сканирование помещений. Необходимо:

— иметь возможность зайти в помещение и быстро, не более чем за пару минут, получить 3D модель комнаты;

— осуществить доступ к полученной 3D модели для редактирования и отображения каких-либо данных, связанных с объектами внутри комнаты.

Задача не новая, но для нас был особенно важен следующий ее аспект — как добиться цели, не приобретая дорогой производственный 3D cканер, с наилучшим соотношением цены и качества?

Для того, чтобы построить 3D модель, нам необходимо как-то получить карту глубины. То есть помимо цветной картинки с обычной камеры, нам понадобится камера глубины, благодаря которой каждому пикселю изображения будет ставиться в соответствие число — расстояние до этого пикселя.

Чтобы получить 3D модель, необходимо провести множество сканирований с разных сторон, а затем привести результаты к общей системе координат (сделать выравнивание).

Подробно про получение данных с камер, механизм сопоставления кадров, совмещение значений цвета и глубины, а также про другие нюансы при построении непосредственно 3D модели, вы сможете прочитать во второй части статьи.

А сейчас разберемся с тем, откуда брать глубину, какие технологии и устройства доступны сейчас на рынке.

Направления развития depth камер

Основные направления развития камер глубины, с обзором принципа их работы и современного применения, хорошо описаны тут. Поэтому не будем повторяться, лишь перечислим устройства, использующие наиболее активно развивающиеся технологии датчиков глубины.

Очевидно, что RGB-D камеры становятся важной частью современного рынка устройств. Есть даже приложение в Google Play для 3D сканирования.

Structured Light камеры

Structured Light камеры основаны на сканировании структурированным светом — с помощью проектора (обычно инфракрасного) формируется проекция световой сетки на объекте, и с помощью камеры фиксируются искажения сетки.

Time of Flight камеры (ToF)

ToF основаны на измерении времени отклика лучей от поверхности объекта.

Depth from Stereo камеры

Depth from Stereo камеры схожи с принципом работы стереоскопического зрения человека — на основании различия в снимках двух камер, направленных в одном направлении, определяется расстояние до каждой точки изображения.

Примеры устройств:

С помощью стереоскопии на смартфоне не удастся сканировать помещения, но можно заметно увеличивать качество фотографий и менять глубину резкости, благодаря возможности выделения объектов на переднем плане.

Light Field камеры

С помощью массива микролинз, расположенных перед сенсором камеры, в каждой точке фиксируется двумерный массив световых лучей, в результате чего получается четырехмерный кадр. Подробнее можно прочитать здесь. Мы не будем останавливаться на этой технологии, так как на данный момент из мобильных устройств она применяется только в Google Pixel 2, для выделения объектов на переднем плане и получения стереофото.

Обзорная таблица рассмотренных устройств

Мы сделали таблицу по рассмотренным камерам глубины, которая заполнялась в ходе экспериментов и изучения технических спецификаций устройств.

В таблицу входят некоторые устройства, которые не удалось протестировать или узнать достаточно характеристик, чтобы включить в обзор: Matterport Pro2 3D Cammera, Leica Geosystems BLK360, THE DPI-8S HANDHELD 3D SCANNER. “Нет информации” в ячейках означает, что в открытых источниках информация по этому пункту недостаточно полная.

Далее мы рассмотрим каждое устройство более подробно.

Обзор камер глубины

В наш обзор войдут устройства, оснащенные камерой для получения цвета, и камерой глубины, которые будут давать возможность в риал-тайм получать облако точек (point cloud) или полигональную модель с расстояния 1–4 метра в движении.

Для дальнейшей работы нам так же необходимо выбрать SDK или приложение для выгрузки полученной модели. На основании этих требований для ряда устройств, рассмотрим следующие характеристики:

Мы отдельно обращаем внимание на наличие инфракрасного передатчика-приемника —качество построения облака точек на устройствах без этого датчика сильно зависит от качества освещения сканируемого помещения.

Хотелось бы обратить внимание на то, что выбор 3D редактора, алгоритмов постобработки и анализа сцены (например, для автоматической расстановки меток с дополнительной информацией или для выделения плоскостей стен и пола) — это тоже отдельная и важная задача, которую мы не затрагиваем в этой статье.

Внимание! Указанные цены и сравнение результатов сканирования актуальны на момент написания статьи.

Structure Sensor by Occipital

От 399$. Цена зависит от комплектации.

Сам сенсор не имеет встроенной RGB камеры. Он использует камеру устройства.

Canvas by occipital — продуктовое решение от Оccipital, позволяет сканировать помещения и получать меш без текстур (получение облака точек не предусмотрено).

Occipital SDK доступно при покупке structure sensor. Дает доступ к высокоуровневому SLAM алгоритму, который строит 3D сцену.

Intel RealSense D435

Согласно характеристикам сенсора:

В RealSense SDK 2.0 есть возможности для работы с RGB и depth кадрами. SDK открыто.

ZED mini

ZED SDK от Stereolabs дает доступ к широким возможностям по работе как с самими камерами, так и с различными алгоритмами обработки. В частности, реализован алгоритм построения 3D сцены, предусмотрены методы для получения облака точек и текстурированного меша.

Мы тестировали SDK, используя имеющуюся камеру ZED mini и тестовое приложение для 3D сканирования, написанное разработчиками SDK для С++. Результаты сканирования получились неудовлетворительными:

Такие результаты, по всей видимости, связаны с отсутствием ИК модуля на самом устройстве — информация о глубине со стереокамер выходит весьма условной. Такое решение подойдет скорее для сканирования относительно простых сред, например, фасадов домов.

Устройство сканирует медленнее, чем решения от Occipital, иногда теряет сцену, после чего уже довольно сложно продолжать сканирование. При резких движениях можно потерять позицию. Размер сканируемого пространства ограничен объёмом оперативной памяти устройства.

Нет доступа к исходным кодам SDK.

Lenovo Phab2 Pro (project Tango)

RTAB-Map — SDK и автономное приложение, которое можно использовать в построении 3D скана помещения. Полностью открытый код. Можно выбирать SLAM алгоритмы, множество настроек.

Приложение возможно использовать на устройствах project Tango. Тестировали RTAB-Map Tango на Lenovo Phab 2 Pro.

На Lenovo Phab 2 Pro удалось просканировать довольно большое помещение (

150 м²). Так же существует возможность склеить отсканированные на мобильном устройстве части помещения через RTAB-Map на компьютере, но требуется соблюдать предложенные рекомендации по сканированию.

К сожалению, в нашем распоряжении не было всех устройств, заслуживающих внимания. Выше мы описали результаты сканирования на основе наших собственных тестов, с имеющихся в распоряжении камер. Ниже перечислим ещё несколько устройств, потенциально пригодных для решения нашей задачи, исходя из примеров с сайтов производителей, технической спецификации и документации.

Structure Sensor Mark II

От 419$ (для iPad Pro)

Улучшенная версия Structure Sensor.

Используются те же SDK, что и для Structure Sensor.

Azure Kinect

Microsoft прекратил производство Kinect for Windows v2, на смену которому пришел Azure Kinect DK.

Неизвестно, будет ли в Azure Kinect Sensor SDK решение для сканирования помещений. Согласно описанию, есть возможность использовать инструменты Azure. Примеры отсутствуют, но в SDK есть функционал получения облака точек каждого кадра. Исходный код открыт.

Заключение

Из обзора можно сделать вывод, что при использовании дешевых открытых решений, качество сканирования в основном оставляет желать лучшего — для его проведения требуется соблюдение особых условий (объем сканирования, условия освещения) или доработка алгоритмов. Например, доработав алгоритм позиционирования с помощью RTAB-Map в Occipital SDK, теоретически можно добиться такого же качества, что и в закрытом решении Сanvas для того же устройства. Нам показалось, что этот вариант даст наилучший результат.

Если вы не хотите тратить время и силы на переписывание исходных кодов под свои задачи, и в приоритете использование готового решения, то Lenovo Phab 2 Pro + RTAB-Map — приемлемый вариант. Хоть Project Tango это уже давно закрытый проект, качество скана в процессе тестирования у нас получилось лучше, чем во многих других современных решениях из нашего обзора. А если сделать связку с какой-либо современной моделью телефона и RTAB-Map, качество может получиться еще лучше, но будет необходим разбор вопроса с интеграцией RTAB-Map.

В заключении хотелось бы еще раз отметить, что помимо сканирования объектов и помещений, камеры глубины активно используются в AR, распознавании жестов, распознавании лица, построении скелетной анимации. Если вам интересно почитать про другие кейсы использования устройств—ознакомьтесь с нашей статьей о создании 2.5D видео (ссылка будет добавлена немного позже).

Надеемся, что наш материал помог вам справиться с поставленной задачей! Будем рады получить фидбек или вопросы по проведенным вами экспериментами 🙂

Что делают 3D-сенсоры в смартфонах? РАЗБОР

Все чаще мы видим в смартфонах так называемые 3D-сенсоры, или сенсоры глубины. Большинство из них также называют ToF-сенсорами аналогично одноименной технологии. По слухам, такой сенсор будет установлен и в новом iPhone (там он называется LiDAR, подробнее мы об этом рассказывали в другом материале). Эти сенсоры довольно дорого стоят, но зачем они нужны понятно не всем. Производители уверяют, что сенсоры позволяют делать лучше фото и портреты или добавляют фишки в дополненную реальность. Но так ли это на самом деле?

Сегодня обсудим, зачем нужны 3D-сенсоры в смартфонах, как это работает, ну и конечно, проведем несколько тестов и проверим заявления производителей.

Что такое 3D сенсор (сенсор глубины)

Для начала, давайте разберемся, а что такое 3D-сенсор? Фотокамеры захватывают проекцию окружающего мира на плоскость. По одной лишь фотографии не понять реальный размер объекта — размером ли он с бутылку или с Пизанскую башню. И расстояние до него тоже не понять.

Для того, чтобы понимать реальные размеры объектов на фото, масштабы съемки, отличать, что ближе к камере, а что дальше, и нужны 3D-сенсоры. Они уже давно и активно применяются в робототехнике, автономном транспорте, играх, медицине и много где еще. Более того, наши глаза — это тоже 3D сенсор. При этом, в отличие от LiDAR’а и ToF-сенсоров в смартфонах, глаза — пассивный 3D-сенсор. То есть не излучающий никакого света, а работающий только на основе поступающего света. Только благодаря этому мы можем хоть как-то перемещаться в пространстве и взаимодействовать с окружающими объектами. Теперь 3D-сенсоры появились и в смартфонах.

Как работает ToF?

LiDAR в iPad’е, а также все 3D-сенсоры в Android-смартфонах — это time-of-flight или сокращенно ToF-сенсоры. Они определяют расстояния до объектов вокруг, напрямую измеряя сколько времени понадобится свету, чтобы долететь от камеры до объекта и вернуться обратно. Это очень похоже на эхо в пещере, оно тоже после отражения от стенок возвращается к нам с запаздыванием. Чтобы пролететь 1 метр свету нужно 3 наносекунды, для 1 см — 30 пикосекунд. Вроде бы все понятно. Но есть проблема.

Это очень маленькие промежутки времени. Как камера может такое замерить? Не будет же она делать миллиард кадров в секунду, а потом их сравнивать? Есть 2 основных подхода для решения этой проблемы: dToF (direct ToF) и iToF (indirect ToF). И чтобы вас заинтриговать еще сильнее: абсолютное большинство Android-смартфонов используют как раз iToF сенсоры, тогда как LiDAR в Apple iPad и скорее всего в грядущих iPhone — это редкий представитель семейства dToF сенсоров. Так чем же они отличаются?

iToF — indirect ToF

Начнем с iToF. В таких сенсорах излучатель отправляет высокочастотный модулированный свет, то есть этот свет постоянно включается и выключается с частотой десятки миллионов раз в секунду. За счет того, что свету нужно время для полета до объекта и обратно, фаза, то есть вот это состояние где-то между включенностью и выключенностью, света, вернувшегося в камеру, немного отличается от фазы света в момент отправки. На сенсоре исходный и отраженный обратно от объекта сигналы накладываются друг на друга, и за счет этого определяется сдвиг фаз, который и позволяет понять расстояние до каждой точки объекта.

dToF — direct ToF

dToF работает немного иначе. В таких сенсорах напрямую измеряется разница во времени между отправкой света и детектированием его отражения на сенсоре. Для этого используются так называемые SPAD: single photon avalanche diodes. Они могут детектировать крайне маленькие импульсы света, фактически даже ловить единичные фотоны. Такие SPAD расположены в каждом пикселе сенсора. А в качестве излучателя в таких сенсорах используются как правило так называемые VCSEL — Vertical Cavity, Surface Emitting Laser. Это лазерный излучатель, подобный тем, что используются в лазерных мышках и много где еще. dToF сенсор в LiDAR разработан совместно с Sony и является первым массовым коммерческим dToF сенсором.

Можно лишь гадать, почему в iPad используется dToF сенсор, но давайте отметим преимущества такого сенсора. Во-первых, в отличие от iToF сенсора излучатель испускает не сплошную стену света, а лишь светит в отдельных направлениях, что позволяет экономить батарейку. Во-вторых, dToF сенсор меньше подвержен ошибкам в измерении глубины из-за так называемой multipath interference. Это типичная проблема iToF сенсоров. Она возникает из-за переотражения света между объектами перед попаданием обратно в сенсор и искажает измерения сенсора.

Как это работает, разобрались, давайте теперь посмотрим, а зачем вообще 3D-сенсоры используются в смартфонах.

Зачем это нужно в смартфонах

1. Безопасность

Первым массовым внедрением 3D-сенсоров в смартфонах мы обязаны Apple и технологии Face ID. Распознавание лиц при использовании трёхмерных данных намного точнее и надежнее классического распознавания лиц по фото. Для Face ID Apple использует технологию структурированной подсветки, на ней мы остановимся подробнее как-нибудь в следующий раз.

Большинство производителей заявляют, что именно более качественный и точный режим дополненной реальности является главной задачей 3D-сенсоров. Более того, это также поддерживается непосредственно компанией Google. Буквально недавно они представили грядущее обновление своей библиотеки дополненной реальности ARCore, позволяющее более реалистично размещать виртуальные объекты в реальности и взаимодействовать с реальными объектами.

Для этой же задачи Apple встроили LiDAR в iPad Pro. Такое можно делать и без 3D-сенсора, но с ним все работает точнее и надежнее, плюс задача становится вычислительно сильно проще и разгружает процессор. 3D-сенсор выводит AR на другой уровень.

3. Улучшение фотографий

Ряд производителей, например, Samsung и HUAWEI заявляют, что 3D-сенсор используется в первую очередь для более качественного размытия фона и более точного автофокуса при съемке видео. Другими словами, он позволяет увеличить качество обычных фото и видео.

4. Прочее

Доступ к данным сенсоров у некоторых смартфонов открыт, поэтому появляется все больше приложений, предлагающих новые применения. Так, например, с помощью внешних приложений 3D-сенсор можно использовать для измерения объектов, трехмерного сканирования и motion tracking’а. Есть даже приложение, позволяющее сделать из своего смартфона прибор ночного видения.

Тесты

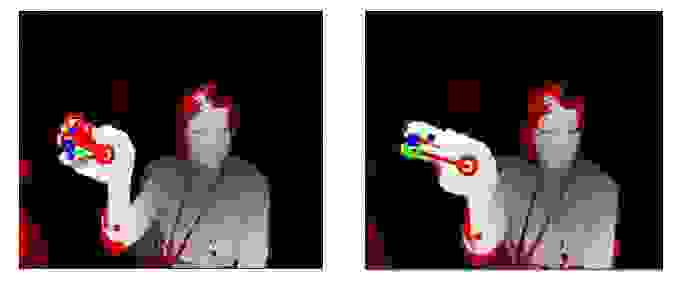

С тем как это работает в теории разобрались, давайте теперь посмотрим, как это работает на практике, и есть ли какой-то толк от этих дорогущих 3D-сенсоров в флагманах. Для тестов мы взяли Redmi Note 9S, у него есть ToF-сенсор и мы сделали несколько снимков в портретном режиме, но во втором случае просто закрыли 3D-камеру пальцем. И вот что получилось.

Всё просто — размытие действительно больше и лучше, если ToF работает.

И для частоты эксперимента мы взяли Samsung Galaxy S20 Ultra, который также получил ToF-камеру.

И найдите хотя бы одно отличие?

Что получается? Дело в том, что в зависимости от производителя ToF-камера используется по-разному и в разной степени.

Можно сказать, что часть производителей смартфонов располагает ToF-датчики в своих смартфонов не для маркетинга, чтобы добавить ещё одну камеру, а скорее на всякий случай. А дальше уже алгоритмы решают — использовать эту камеру или нет?

При этом на сегодняшний момент необходимости в LiDAR или ToF-камерах прямо нет. Так что это видимо чуть больше маркетинг.