Yandexwebcache net что это

9 способов найти удаленный сайт или страницу

Сервисы и трюки, с которыми найдётся ВСЁ.

Зачем это нужно: с утра мельком прочитали статью, решили вечером ознакомиться внимательнее, а ее на сайте нет? Несколько лет назад ходили на полезный сайт, сегодня вспомнили, а на этом же домене ничего не осталось? Это бывало с каждым из нас. Но есть выход.

Всё, что попадает в интернет, сохраняется там навсегда. Если какая-то информация размещена в интернете хотя бы пару дней, велика вероятность, что она перешла в собственность коллективного разума. И вы сможете до неё достучаться.

Поговорим о простых и общедоступных способах найти сайты и страницы, которые по каким-то причинам были удалены.

1. Кэш Google, который всё помнит

Google специально сохраняет тексты всех веб-страниц, чтобы люди могли их просмотреть в случае недоступности сайта. Для просмотра версии страницы из кэша Google надо в адресной строке набрать:

http://webcache.googleusercontent.com/search?q=cache:https://www.iphones.ru/

Где https://www.iphones.ru/ надо заменить на адрес искомого сайта.

2. Web-archive, в котором вся история интернета

Во Всемирном архиве интернета хранятся старые версии очень многих сайтов за разные даты (с начала 90-ых по настоящее время). На данный момент в России этот сайт заблокирован.

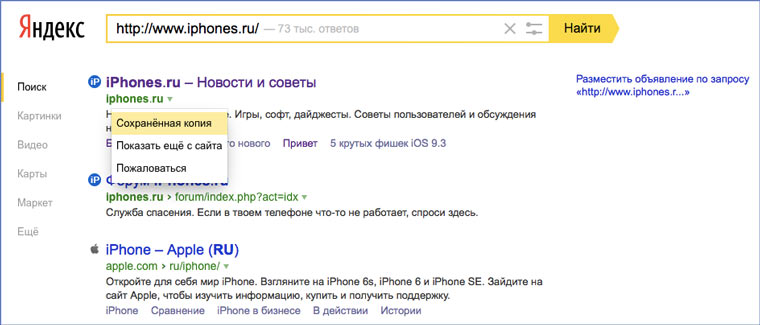

3. Кэш Яндекса, почему бы и нет

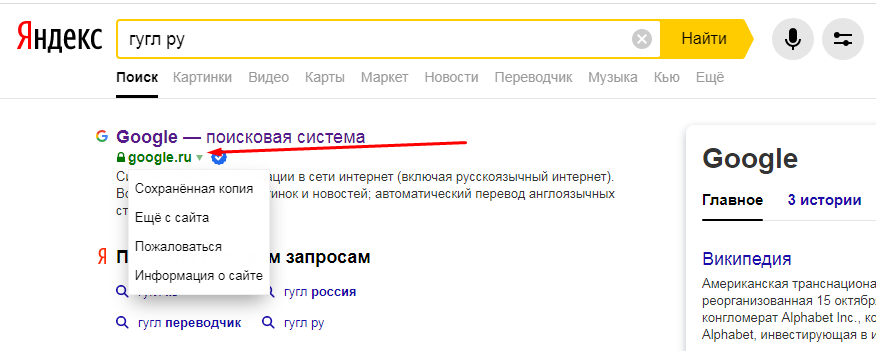

К сожалению, нет способа добрать до кэша Яндекса по прямой ссылке. Поэтому приходиться набирать адрес страницы в поисковой строке и из контекстного меню ссылки на результат выбирать пункт Сохраненная копия. Если результат поиска в кэше Google вас не устроил, то этот вариант обязательно стоит попробовать, так как версии страниц в кэше Яндекса могут отличаться.

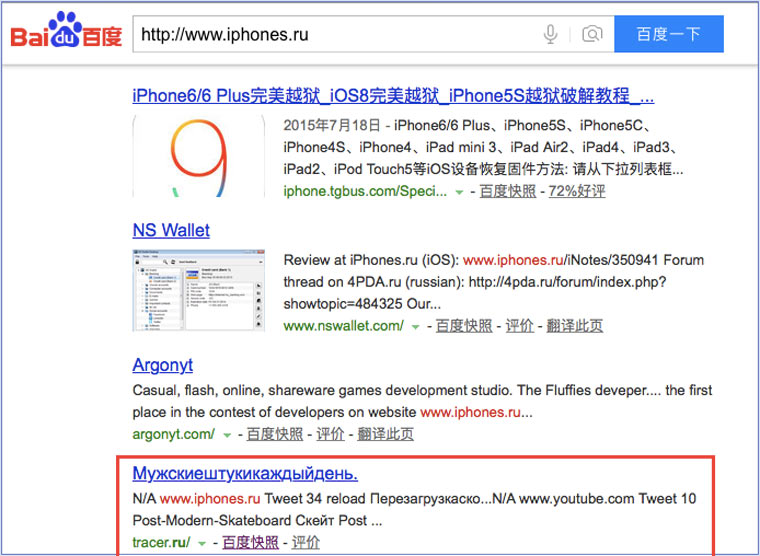

4. Кэш Baidu, пробуем азиатское

Когда ищешь в кэше Google статьи удаленные с habrahabr.ru, то часто бывает, что в сохраненную копию попадает версия с надписью «Доступ к публикации закрыт». Ведь Google ходит на этот сайт очень часто! А китайский поисковик Baidu значительно реже (раз в несколько дней), и в его кэше может быть сохранена другая версия.

Иногда срабатывает, иногда нет. P.S.: ссылка на кэш находится сразу справа от основной ссылки.

5. CachedView.com, специализированный поисковик

На этом сервисе можно сразу искать страницы в кэше Google, Coral Cache и Всемирном архиве интернета. У него также еcть аналог cachedpages.com.

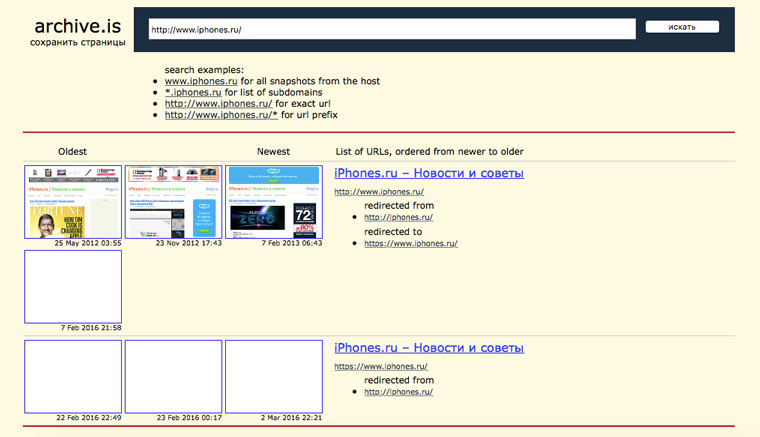

6. Archive.is, для собственного кэша

Если вам нужно сохранить какую-то веб-страницу, то это можно сделать на archive.is без регистрации и смс. Еще там есть глобальный поиск по всем версиям страниц, когда-либо сохраненных пользователями сервиса. Там есть даже несколько сохраненных копий iPhones.ru.

7. Кэши других поисковиков, мало ли

Если Google, Baidu и Yandeх не успели сохранить ничего толкового, но копия страницы очень нужна, то идем на seacrhenginelist.com, перебираем поисковики и надеемся на лучшее (чтобы какой-нибудь бот посетил сайт в нужное время).

8. Кэш браузера, когда ничего не помогает

Страницу целиком таким образом не посмотришь, но картинки и скрипты с некоторых сайтов определенное время хранятся на вашем компьютере. Их можно использовать для поиска информации. К примеру, по картинке из инструкции можно найти аналогичную на другом сайте. Кратко о подходе к просмотру файлов кэша в разных браузерах:

Safari

Ищем файлы в папке

Google Chrome

В адресной строке набираем chrome://cache

Opera

В адресной строке набираем opera://cache

Mozilla Firefox

Набираем в адресной строке about:cache и находим на ней путь к каталогу с файлами кеша.

9. Пробуем скачать файл страницы напрямую с сервера

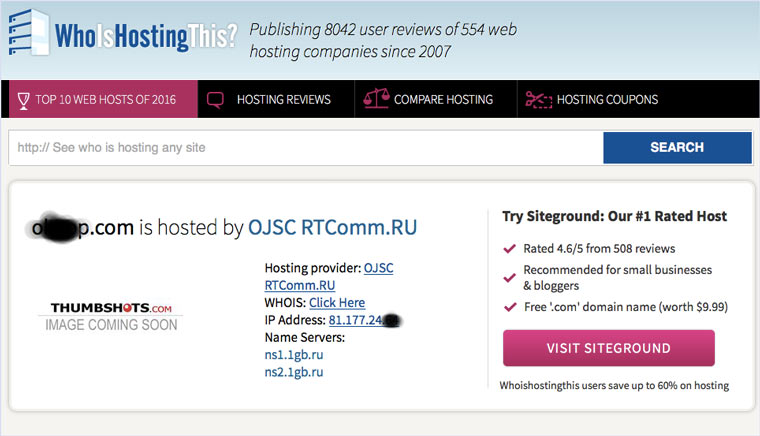

Идем на whoishostingthis.com и узнаем адрес сервера, на котором располагается или располагался сайт:

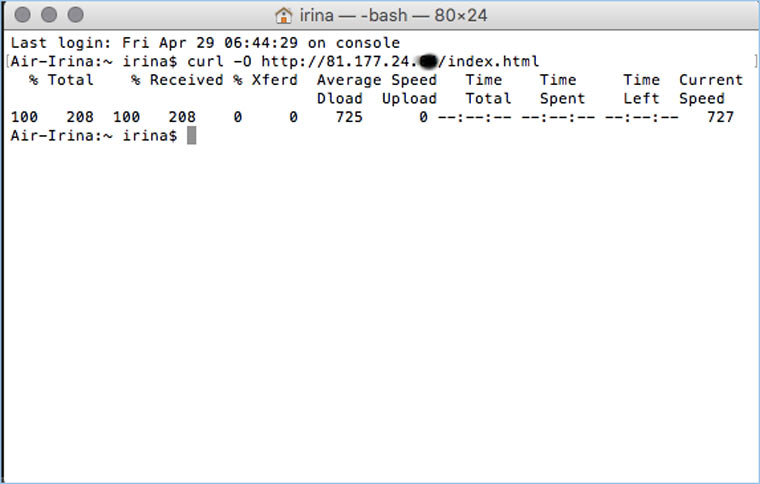

После этого открываем терминал и с помощью команды curl пытаемся скачать нужную страницу:

Что делать, если вообще ничего не помогло

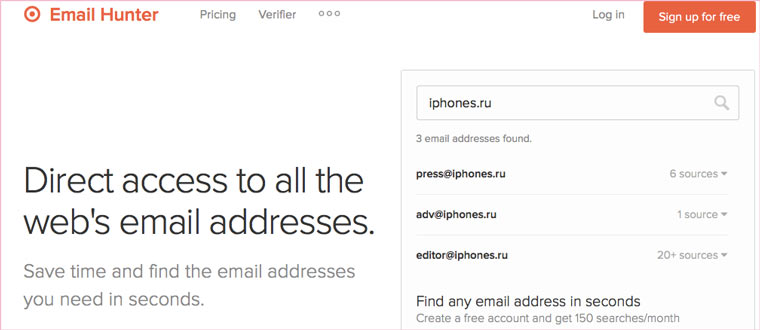

Если ни один из способов не дал результатов, а найти удаленную страницу вам позарез как надо, то остается только выйти на владельца сайта и вытрясти из него заветную инфу. Для начала можно пробить контакты, связанные с сайтом на emailhunter.com:

Сохраненная копия сайта или бесплатный бэкап от поисковиков

Сохраненная копия сайта (в Яндексе или другой поисковой системе) — это версия страницы, которая уже проиндексирована. Если при вводе поискового запроса посмотреть на сниппет нужного результата, там найдется блок с дополнительными данными. Там-то и лежит «Сохраненная копия».

Что это такое, зачем она нужна, как просмотреть и каковы последствия отсутствия копии — вопросы, на которые несложно найти простые ответы.

С помощью сохраненной копии можно просмотреть сайт, если к нему будет внезапно ограничен доступ по той или иной причине.

В Google происходит то же самое — найдя в cash копию и перейдя по ссылке, можно просмотреть, как выглядела страница, когда Гугл в последний раз ее скопировал.

Для чего нужны сохраненные страницы?

Кэш-страницы сайта в поисковых системах позволяют увидеть, какую версию документа уже успели проиндексировать роботы поисковых систем и участвует ли страница в ранжировании. Грубо говоря, если страница начала сохраняться — это главный фактор пройденной индексации.

Бесплатный бэкап

В работе с сайтами, может возникнуть масса непредвиденных ситуаций. Особенно на стадии запуска проекта, на сайте частенько ведутся технические работы, предполагающие корректировку дизайна и текстовых блоков. В такие моменты не исключены ошибки, которые могут «положить» сайт или нарушить его работу, также могут пропасть тексты, изображения и так далее.

Большинству разработчиков знакомы такие ситуации и если не был проведен бэкап, а дешевый хостинг не позволяет сделать «откат», то все печально. Вот тут-то и приходит на помощь кэш сайтов — копия позволяет сохраниться и проверить, какие ошибки нужно исправить.

Важно! Все же не стоит надеяться на Яндекс и Гугл, и хранить сайт только в копиях поисковиков. Если робот попал на нерабочую страницу или ее версию с ошибками, он будет копировать то, что «видел», и старая информация будет недоступна. Так что заранее продумывайте способы «отката» сайта.

SEO-продвижение

Еще один случай, когда кеш придет на помощь, связан с текстами. Например, вы откорректировали текст, чтобы повысить его релевантность. Чтобы проверить, обновилась и проиндексировалась ли нужная страница, достаточно взглянуть на копию.

Технические проблемы, просрочка оплаты и так далее

Часто интернет-ресурсы бывают недоступны из-за технических проблем на сервере, истечения срока оплаты хостинга и т.п. В этом случае попасть на сайт можно также через копию, которая хранится в кэше.

Как посмотреть кэшированную копию в Яндексе: основные способы

Перед тем как открыть сохраненную копию сайта в Яндексе, выберите удобный способ — с помощью сервисов (Page Promoter в Firefox или RDS bar в Google Chrome) или вручную. Плагины — это удобно, но они могут давать сбой, поэтому стоит освоить и ручной метод просмотра.

Способ № 1 — плагины

Расширения для браузеров, плагины и различные онлайн-сервисы позволяют быстро открывать кэш сайтов. Один из самых популярных на сегодня сервисов — это RDS bar. Плагин отличается интуитивным пользовательским интерфейсом и позволяет посмотреть последние изменения страницы, отсканированной роботами. Но если нужная страница еще не проиндексировалась, то и плагин ничего не покажет.

Способ № 2 — вручную

Самый простой и эффективный «механический» способ просмотра. Что нужно сделать:

Как посмотреть сохраненную копию страницы в Google

Алгоритм просмотра кэшированных страниц в системе Гугл не отличается от ручного способа для Яндекса. Все просто:

Почему страницы может не быть?

Иногда во время поиска при нажатии на стрелочку сниппета нужного пункта может и не быть. Это происходит по ряду причин:

Нет копии: чем это грозит?

С точки зрения продвижения — опасность нулевая. А вот сами причины, из-за которых невозможно сохранение, могут быть вредны, нужно разбираться именно в них.

Эксперты уверены, что проблема с копиями может обернуться трудностями при работе с биржами ссылок. Так, на некоторых известных биржах строго контролируют, есть ли в Яндексе копия, проверяя параметр No Index Cache (NIC).

Другие способы

Заключение

Всем мы хорошо помним и знаем, что всё нужно бэкапить — от семейных фото с отпуска до страниц сайтов. Но настолько же хорошо мы об этом еще и забываем. В этом случае приходит на помощь сохраненная версия сайта, которую можно найти в Яндексе, Гуле и других поисковых системах и даже вытянуть из Всемирных архивов.

Главное, чтобы поисковые системы успели кэшировать ваши страницы, а от вас дело за малым — просто выбрать удобный способ просмотра копии.

Достаём потерянные статьи из сетевых хранилищ

Решение рассматривается (пока) только для одного сайта — того, на котором мы находимся. Идея появилась в результате того, что один пользователь сделал юзерскрипт, который переадресует страницу на кеш Гугла, если вместо статьи видим «Доступ к публикации закрыт». Понятно, что это решение будет работать лишь частично, но полного решения пока не существует. Можно повысить вероятность нахождения копии выбором результата из нескольких сервисов. Этим стал заниматься скрипт HabrAjax (наряду с 3 десятками других функций). Теперь (с версии 0.859), если пользователь увидел полупустую страницу, с которой можно перейти лишь на главную, в личную страницу автора (если повезёт) и назад, юзерскрипт предоставляет несколько альтернативных ссылок, в которых можно попытаться найти потерю. И тут начинается самое интересное, потому что ни один сервис не заточен на качественное архивирование одного сайта.

Кстати, статья и исследования порождены интересным опросом А вас раздражает постоянное «Доступ к публикации закрыт»? и скриптом пользователя dotneter — комментарий habrahabr.ru/post/146070/#comment_4914947.

Требуется, конечно, более качественный сервис, поэтому, кроме описания нынешней скромной функциональности (вероятность найти в Гугл-кеше и на нескольких сайтах-копировщиках), поднимем в статье краудсорсинговые вопросы — чтобы «всем миром» задачу порешать и прийти к качественному решению, тем более, что решение видится близким для тех, кто имеет сервис копирования контента. Но давайте обо всём по порядку, рассмотрим все предложенные на данный момент решения.

Кеш Гугла

В отличие от кеша Яндекса, к нему имеется прямой доступ по ссылке, не надо просить пользователя «затем нажать кнопку „копия“». Однако, все кеширователи, как и известный archive.org, имеют ряд ненужных особенностей.

1) они просто не успевают мгновенно и многократно копировать появившиеся ссылки. Хотя надо отдать должное, что к популярным сайтам обращение у них частое, и за 2 и более часов они кешируют новые страницы. Каждый в своё время.

2) далее, возникает такая смешная особенность, что они могут чуть позже закешировать пустую страницу, говорящую о том, что «доступ закрыт».

3) поэтому результат кеширования — как повезёт. Можно обойти все такие кеширующие ссылки, если очень надо, но и оттуда информацию стоит скопировать себе, потому что вскоре может пропасть или замениться «более актуальной» бессмысленной копией пустой страницы.

Кеш archive.org

Он работает на весь интернет с мощностями, меньшими, чем у поисковиков, поэтому обходит страницы какого-то далёкого русскоязычного сайта редко. Частоту можно увидеть здесь: wayback.archive.org/web/20120801000000*/http://habrahabr.ru

Да и цель сайта — запечатлеть фрагменты истории веба, а не все события на каждом сайте. Поэтому мы редко будем попадать на полезную информацию.

Кеш Яндекса

Нет прямой ссылки, поэтому нужно просить (самое простое) пользователя нажать на ссылку «копия» на странице поиска, на которой будет одна эта статья (если её Яндекс вообще успел увидеть).

Как показывает опыт, статья, повисевшая пару часов и закрытая автором, довольно успешно сохраняется в кешах поисковиков. Впоследствии, скорее всего, довольно быстро заменится на пустую. Всё это, конечно, не устроит пользователей веба, который по определению должен хранить попавшую в него информацию.

Yahoo Pipes

pipes.yahoo.com/pipes/search?q=habrahabr+full&x=0&y=0 и прочие.

Довольно интересное решение. Те, кто умеет их настраивать, возможно, полноценно решат задачу архивирования RSS. Из имеющегося, я не нашёл пайпов с поиском статьи по её номеру, поэтому пока нет прямой ссылки на такие сохранённые полные статьи. (Кто умеет с ним работать — прошу изготовить такую ссылку для скрипта.)

Многочисленные клонировщики

Все из них болеют тем, что не дают ссылки на статью по её номеру, не приводят полный текст статьи, а некоторые вообще ограничиваются «захабренным» или «настолько ленивы», что копируют редко (к примеру, раз в день), что актуально не всегда. Однако, если хотя бы один автор копировщика подкрутит движок на сохранение полноценного и актуального контента, он окажет неоценимую услугу интернету, и его сервис займёт главное место в скрипте HabrAjax.

Из живых я нашёл пока что 4, некоторые давно существовавшие (itgator) на данный момент не работали. В общем, пока что они почти бесполезны, потому что заставляют искать статью по названию или ключевым словам, а не по адресу, по которому пользователь пришёл на закрытую страницу (а по словам отлично ищет Яндекс и не только по одному их сайту). Приведены в скрипте для какой-нибудь полезной информации.

Задача

Перед сообществом стоит задача, не утруждая организаторов сайта, довести продукт до качественного, не теряющего информацию ресурса. Для этого, как правильно заметили в комментариях к опросу, нужен архиватор актуальных полноценных статей (и комментариев к ним заодно).

В настоящее время неполное решение её, как описано выше, выглядит так:

Если искать в Яндексе, то подобранный адрес выведет единственную ссылку (или ничего):

Нажав ссылку «копия», увидим (если повезёт) сохранённую копию (страница выбрана исключительно для актуального на данный момент примера):

В Гугле несколько проще — сразу попадаем на копию, если тоже повезёт, и Гугл успел сохранить именно то, что нам надо, а не дубль отсутствующей страницы.

Забавно, что скрипт теперь предлагает «выбор альтернативных сервисов» и в этом случае («профилактические работы»):

Жду предложений по добавлению сервисов и копировщиков (или хотя бы проектов) (для неавторизованных — на почту spmbt0 на известном гуглоресурсе, далее выберем удобный формат).

UPD 23:00: опытным путём для mail.ru было выяснено строение прямой ссылки на кеш:

Знатоки или инсайдеры, расскажите, что это за ссылка, насколько она стабильна (не изменится ли, например, домен 3-го уровня), что значит приставка «g»-cached? Значит ли это кеш Гугла или это кеш движка Gogo? Пример.

Добавил ссылки мейла и ВК в обновление скрипта (habrAjax) (0.861), теперь там — на 2 строчки больше.

Яндекс помогает распространять вредоносное ПО?

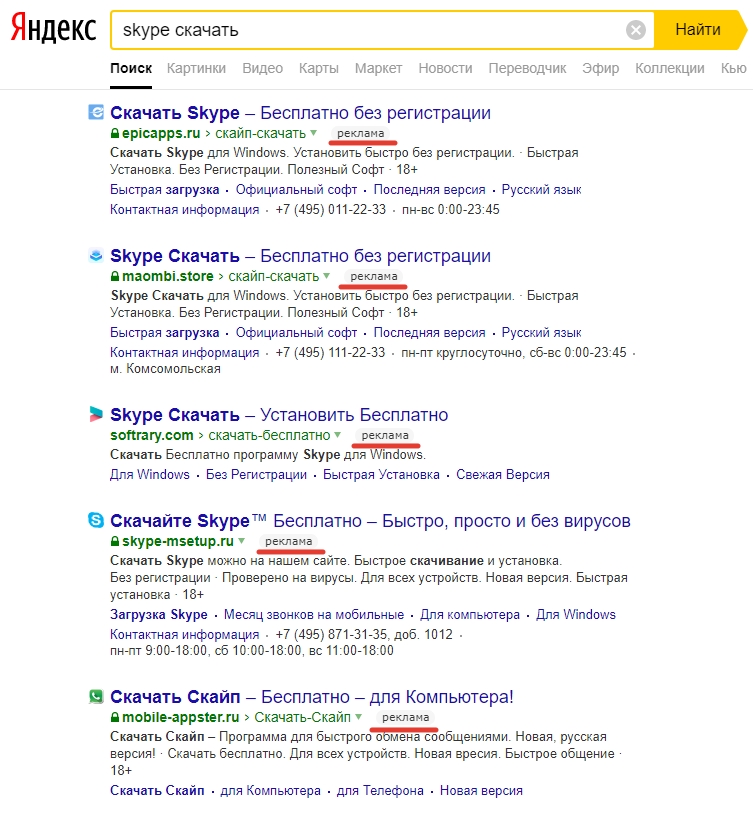

По роду деятельности мне приходится наблюдать за работой сотен рядовых пользователей ПК. Человек, который не первый день держит мышку, всё чаще сталкивается с проблемами при банальном скачивании бесплатного ПО. При разборе выясняется, что он всего лишь набрал в Яндексе «скачать Вайбер», а дальше что-то пошло не так. Я давно слежу за распространением заразы при непосредственном участии Яндекса. Когда-то это были единичные случаи, но теперь явление уже приобрело массовый характер. Объясню, в чём суть. Введём в запросе название любой популярной программы, которую условный домашний пользователь хочет скачать, и получим примерно такую выдачу:

Каждая строка с пометкой «реклама» — это платное объявление от физического или юридического лица, которое зарегистрировано в сервисе Яндекс.Директ со всеми адресами, телефонами и прочими ИНН. Каждое такое объявление проходит ручную модерацию, то есть, в данном случае модератора вовсе не смутил тот факт, что пять разных «официальных» сайтов подали рекламу для скачивания бесплатного приложения. И уж точно проверенный модератором номер (495) 111-22-33 не принадлежит Скайпу.

И, что самое интересное, порядок выдачи разных объявлений по одному запросу определяется аукционом. Если не вдаваться в подробности админки Директа — кто выставил бОльшую стоимость клика, того показывают выше. Да, каждое нажатие на такую ссылку обходится автору объявления в N рублей! За что именно борются рублём рекламодатели — неизвестно, вариантов много: от относительно безобидного майнинга криптовалюты на чужом железе до перехвата платёжных данных из Сбербанк.Онлайн или Алиэкспресса. Но логично, что альтруизмом здесь и не пахнет.

upd2 На двух предыдущих скринах результаты поиска прокручены, чтобы нижний рекламный блок оказался рядом с запросом.

На Директе мошенничество не заканчивается. Ниже обычная поисковая выдача без рекламы по запросу «anydesk» — популярного приложения от бывшей команды TeamViewer. anydesk.com — это настоящий сайт, который и должен вылезать первым по данному запросу. А уже второй результат (с точка ru) — фэйк. Достаточно одного взгляда на этот одностраничный сайт с морально устаревшим клипартом, чтобы понять, что перед нами подделка, нарисованная на коленке за 15 минут. НО только не для модераторов Яндекса. Обратите внимание: адрес этого сайта содержит заглавные и строчные буквы (AnyDesk, а не anydesk). Такое возможно только в одном случае: автор сайта зарегистрирован в сервисе Яндекс.Вебмастер и прошёл ручную модерацию на изменение регистра символов в адресе этого «официального сайта».

Помойка в выдаче повторяется для любого ПО, которое только приходит в голову, хоть платного, хоть бесплатного. Приписка «официальный сайт» положение не спасает, а популярная среди начинающих пользователей фраза «скачать бесплатно» наоборот только помогает попасть на поддельный сайт. Чудесные алгоритмы ранжирования Яндекса, которые совершенствуются каждый день, помогают подозрительным сайтам лезть выше. А как показывает практика, неопытный пользователь обычно жмёт первый результат поиска, доверяя лучшему отечественному поисковику.

И ещё немного про Директ. Сервис позволяет таргетировать рекламу по разным признакам. Например, показывать её только жителям Кировской области мужского пола в возрасте от 25 до 45 лет. Это удобно для честной рекламы, скажем, магазина электроинструмента. Или можно показывать её только пользователям браузера Internet Explorer. Последние обычно ассоциируются с неопытными пользователями ПК, поэтому за такого «чайника» можно заплатить и побольше: рекламная ссылка в примере ниже вылезает даже выше искомого официального сайта. Этот запрос сделан в Internet Explorer, в альтернативном браузере рекламный блок здесь не появляется.

upd3 Проверим теорию с таргетингом: заходим под *nix, и всю платную рекламу по тем же запросам как рукой сняло — такие пользователи точно зря потратят стоимость клика.

Что делать с этой информацией? Ограничивать права учётных записей на компьютерах родственников, и объяснять, что верить никому нельзя.

И вопрос к Яндексу, если этот текст до него дойдёт: вы собираетесь как-то решать эту проблему?

Массовость проблемы подтверждает статистика запросов wordstat.yandex.ru: по каждому из ключевых слов тысячи и десятки тысяч ежемесячных запросов.

upd Изначально похвалил Гугл, но в комментариях меня поправили. Google занимается тем же самым (установленная баннерорезка скрыла эти результаты).

upd4 В комментариях появился ответ от представителя Яндекса:

На Хабре меня достаточно давно знают как автора публикаций про технологии Яндекса, поэтому я вызвался добровольцем ответить на этот пост. Кроме того, мне уже приходилось рассказывать про то, как вообще работает дистрибуция софта в индустрии.

Во-первых, Яндекс сотрудничает только с теми компаниями, которые производят или распространяют ПО на легальных основаниях. Это касается и рекламы в выдаче. Вы можете возразить: но ведь на скриншотах неофициальные сайты. Суть в следующем.

Неофициальность сайта с программой в абсолютном большинстве случаев не означает, что он вредоносный. Разработчики ПО как правило заинтересованы в том, чтобы их продукты также распространялись через сайты партнёров. Для них это увеличение загрузок, а для партнёров — проценты от доходов разработчиков.

Во-вторых, как верно подметил автор, Яндекс проверяет такие объявления. Не только вручную, но и с применением наших технологий в области антифрода. Собственно, в комментариях уже подметили, что ни по одному из примеров нет однозначного вердикта о вредоносности со стороны каких-либо сканеров и баз данных. Эти примеры мы тоже перепроверили на всякий случай. Никаких признаков вредоносной деятельности там нет.

В общем, всё не так страшно. Но если вы видите что-то подозрительное, то можете сообщить об этом поддержке Яндекса или лично мне — проверим.

Как открыть кэш любого сайта в Google, Яндекс или Archive

Бывает, что нужно посмотреть старую версию сайта в архивах поисковиков. Cache.pw поможет с этим. Просто вставьте URL вот тут и кликните по необходимой кнопке.

Открыть кэш сайта

Введите URL с https:// или http:// в начале и нажмите на кнопку.

Как это работает

Когда вы вставите URL и кликните по любой из кнопок вы будете перенаправлены на кещированную версию этой странице в том сервисе, по кнопке которого вы кликнули.

Кэш Google

Кэш Google (Google Cache) включает в себя множество сохранённых страниц из интернета и продолжает пополнять их число каждый день. Это полезно: если нужный сайт недоступен вы можете открыть кэшированную версию страницы от Гугла.

Закешированные страницы обновляются достаточно часто, изменения с оригинальной страницы попадают на копию из кэша за 1-2 дня.

Кэш Яндекса

Кэш Яндекса (Yandex Cache) включает в себя множество сохранённых страниц из интернета и продолжает пополнять их число каждый день. Это полезно: если нужный сайт недоступен вы можете открыть кэшированную версию страницы от Yandex’а.

Закешированные страницы обновляются не слишком часто, изменения с оригинальной страницы попадают на копию за

Кэш Archive.org

Archive.org, также известный как Wayback Machine, представляет собой цифровой архив Интернета, который был создан некоммерческой организацией Internet Archive из Сан-Франциско, Калифорния.

Сервис позволяет пользователям просматривать старые версии веб-страниц, причём за разные промежутки времени, можно отследить жизненный путь страницы на сайте.