Wayback machine что это

Как пользоваться сервисом Wayback Machine: 10 советов для интернет-маркетологов

Wayback Machine – это широко известный и полезный сервис, позволяющий увидеть сайты в том виде, в котором они существовали в прошлом, но это не единственная полезная функция Wayback Machine – сервис можно использовать и в интернет-маркетинге.

1. Отслеживание изменений сайта

Это основная функция Wayback Machine. Снимки сайта (snapshots) Wayback Machine можно использовать для сравнения вида сайта в разное время, чтобы посмотреть, что изменилось.

Даже если у Wayback Machine мало снимков сайта (обычно такое случается с не очень популярными сайтами), вы все равно можете определить дату внесения изменений. Это полезно, если вы считаете, что изменения могли быть причиной падения сайта в поисковой выдаче, посмотрите на версию страницы того времени, после которого произошло падение и узнаете, что за негативные изменения ее вызвали. Используйте эти данные, чтобы исправить проблему.

2. Знакомство с сайтом

Когда вы работаете с новым клиентом, важно быть ознакомленным с его сайтом и разбираться в тонкостях его бренда. Wayback Machine вам в этом поможет. Вы можете посмотреть, как сайт менялся с годами и насколько изменилась политика бренда. Согласуйте с клиентом изменения: «Раньше вы утверждали одно, а теперь другое, так ведь?».

3. Поиск прежних редиректов

Один из хороших способов использовать Wayback Machine – поиск URL, на которые через какое-то время повесили редиректы. Такое часто бывает с крупными брендами, сайты которых начинали работу в 90 или начале 2000, а потом были переделаны в соответствии с требованиями поисковых систем. Чтобы найти более ранние версии ссылок и проверить их код состояния, используйте Wayback Machine в паре с Screaming Frog.

4. Поиск старой структуры URL

Иногда структура URL сайтов меняется, а старая теряется. Если вы знаете приблизительную дату изменения структуры ссылки, то можете использовать Wayback Machine, чтобы выяснить, когда именно были внесены изменения и как выглядела прежняя структура. Затем вы можете сравнить более новые версии ссылки с предыдущими. Эта функция полезна, если контент сайта был реорганизован или подразделы были переименованы.

5. Изучение Robots.txt

Wayback Machine индексирует все, что находит на сайте, в том числе и файлы robots.txt. И это здорово: если у вашего сайта есть технические уязвимости, вы сможете узнать, когда именно были внесены изменения в документе robots.txt, приведшие к этим уязвимостям. Все, что надо сделать – это найти документ robots.txt и сравнивать срезы данных страниц за разные даты до тех пор, пока не найдете причину уязвимостей.

6. Проверка работы счетчика аналитики

Wayback Machine индексирует исходный код страниц и позволяет отследить изменения, которые были в него внесены. Введите URL страницы, выберите дату и снимки сайта, которые вам нужны, и кликните на просмотр исходного кода и оцените, насколько правильно он сделан.

7. Анализ пути клиента

Если вы хотите провести полный анализ пути клиента, то с этим вам также может помочь Wayback Machine. Используя этот сервис, вы сможете сравнить текущую длину пути с тем, который был в прошлом, чтобы определить, какие стадии изменились с течением времени. Также Wayback Machine открывает способы повысить конверсию. Если конверсия на вашем сайте была высокой в определенной время, то можно посмотреть на предыдущее оформление, кнопки и ссылки на странице, чтобы определить, как они повлияли на конверсию.

8. Определение структуры сайта

Wayback Machine показывает, как в прошлом выглядела иерархическая структура сайта. Иногда разделы могут объединять или наоборот разбивать на несколько штук. Если вы посмотрите на то, какой была структура сайта в прошлом, вы сможете сказать, какие страницы были недавно объединены в одну категорию или разделены на самостоятельные.

9. Поиск старого контента

Wayback Machine поможет найти старый контент, который был утерян или случайно удален. Достаточно открыть страницу, на которой находился контент, на более ранней дате.

10. Проведение смешанного маркетингового анализа

С помощью Wayback Machine можно анализировать рост трафика посадочных страниц. Предположим, что в прошлом году контекст работал хорошо, но результат в этом году далеко не такой впечатляющий. Посмотрите на ваши посадочные страницы с помощью Wayback Machine, чтобы выяснить, какие ключевые слова приносили результат, и что изменилось на посадочных страницах и привело к снижению эффективности этих ключевиков.

Назад в будущее

На первый взгляд, Wayback Machine – это просто сервис, показывающий более раннюю версию сайтов, действительно «машина времени» интернета. Однако, его функции могут быть полезны и в сфере интернет-маркетинга. А какие способы использования Wayback Machine приходят в голову вам? Поделитесь в комментариях.

В Google и «Яндексе», соцсетях, рассылках, на видеоплатформах, у блогеров

HackWare.ru

Этичный хакинг и тестирование на проникновение, информационная безопасность

Веб-архивы Интернета: как искать удалённую информацию и восстанавливать сайты

Что такое Wayback Machine и Архивы Интернета

В этой статье мы рассмотрим Веб Архивы сайтов или Интернет архивы: как искать удалённую с сайтов информацию, как скачать больше несуществующие сайты и другие примеры и случаи использования.

Принцип работы всех Интернет Архивов схожий: кто-то (любой пользователь) указывает страницу для сохранения. Интернет Архив скачивает её, в том числе текст, изображения и стили оформления, а затем сохраняет. По запросу сохранённые страницу могут быть просмотрены из Интернет Архива, при этом не имеет значения, если исходная страница изменилась или сайт в данный момент недоступен или вовсе перестал существовать.

Многие Интернет Архивы хранят несколько версий одной и той же страницы, делая её снимок в разное время. Благодаря этому можно проследить историю изменения сайта или веб-страницы в течение всех лет существования.

В этой статье будет показано, как находить удалённую или изменённую информацию, как использовать Интернет Архивы для восстановления сайтов, отдельных страниц или файлов, а также некоторые другие случае использования.

Wayback Machine — это название одного из популярного веб архива сайтов. Иногда Wayback Machine используется как синоним «Интернет Архив».

Какие существуют веб-архивы Интернета

Я знаю о трёх архивах веб-сайтов (если вы знаете больше, то пишите их в комментариях):

web.archive.org

Этот сервис веб архива ещё известен как Wayback Machine. Имеет разные дополнительные функции, чаще всего используется инструментами по восстановлению сайтов и информации.

Для сохранения страницы в архив перейдите по адресу https://archive.org/web/ введите адрес интересующей вас страницы и нажмите кнопку «SAVE PAGE».

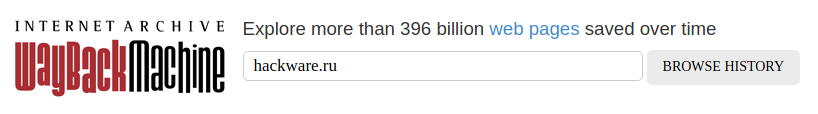

Для просмотра доступных сохранённых версий веб-страницы, перейдите по адресу https://archive.org/web/, введите адрес интересующей вас страницы или домен веб-сайта и нажмите «BROWSE HISTORY»:

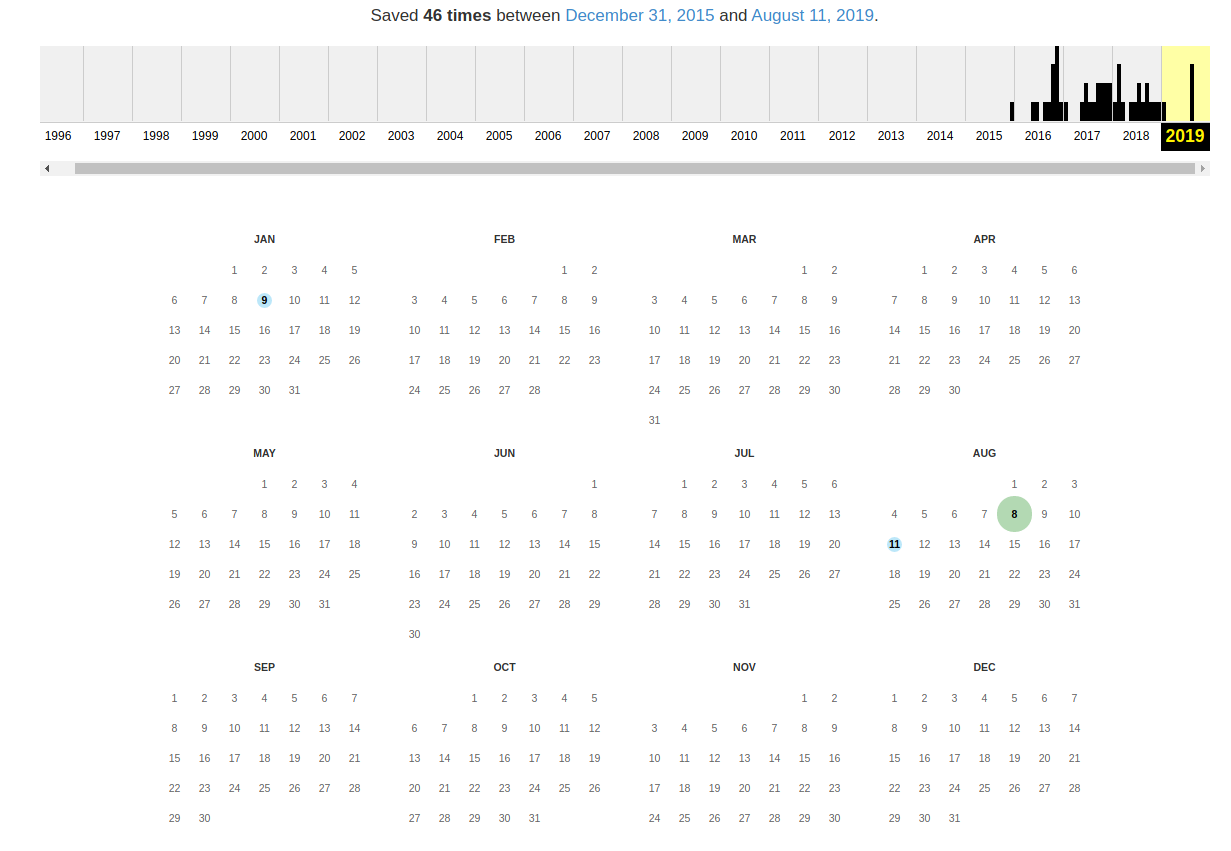

В самом верху написано, сколько всего снимком страницы сделано, дата первого и последнего снимка.

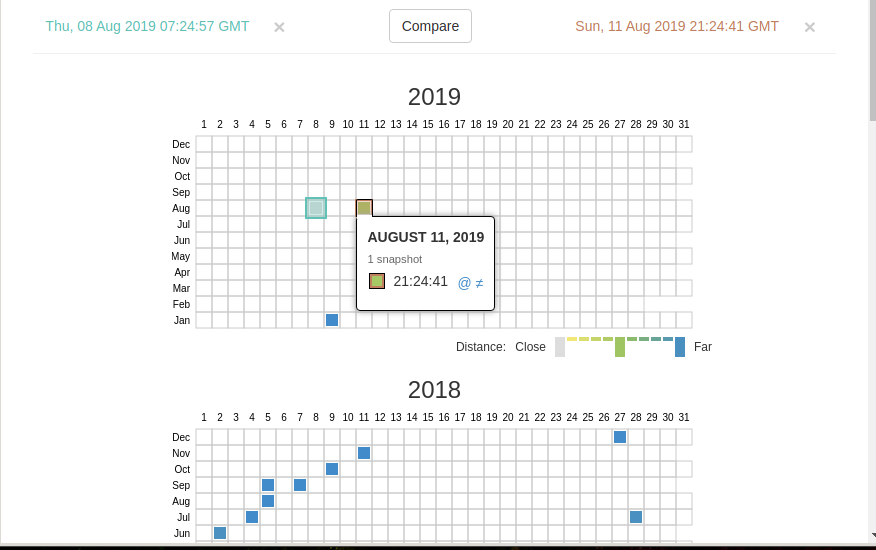

Затем идёт шкала времени на которой можно выбрать интересующий год, при выборе года, будет обновляться календарь.

Обратите внимание, что календарь показывает не количество изменений на сайте, а количество раз, когда был сделан архив страницы.

Точки на календаре означают разные события, разные цвета несут разный смысл о веб захвате. Голубой означает, что при архивации страницы от веб-сервера был получен код ответа 2nn (всё хорошо); зелёный означает, что архиватор получил статус 3nn (перенаправление); оранжевый означает, что получен статус 4nn (ошибка на стороне клиента, например, страница не найдена), а красный означает, что при архивации получена ошибка 5nn (проблемы на сервере). Вероятно, чаще всего вас должны интересовать голубые и зелёные точки и ссылки.

При клике на выбранное время, будет открыта ссылка, например, http://web.archive.org/web/20160803222240/https://hackware.ru/ и вам будет показано, как выглядела страница в то время:

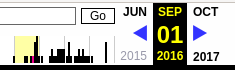

Используя эту миниатюру вы сможете переходить к следующему снимку страницы, либо перепрыгнуть к нужной дате:

Лучший способ увидеть все файлы, которые были архивированы для определённого сайта, это открыть ссылку вида http://web.archive.org/*/www.yoursite.com/*, например, http://web.archive.org/*/hackware.ru/

Кроме календаря доступна следующие страницы:

Changes

«Changes» — это инструмент, который вы можете использовать для идентификации и отображения изменений в содержимом заархивированных URL.

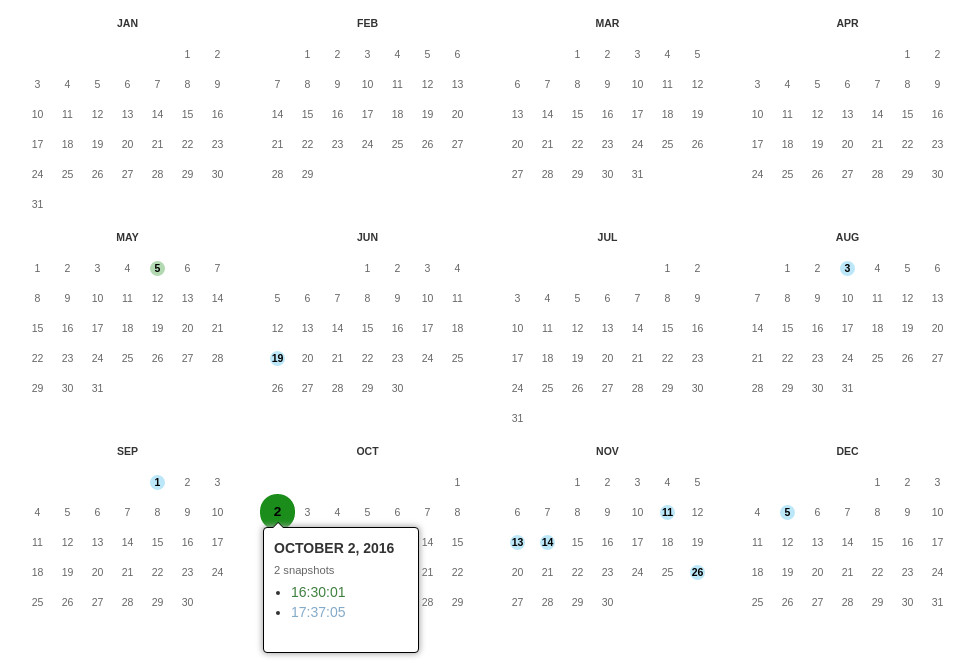

Начать вы можете с того, что выберите два различных дня какого-то URL. Для этого кликните на соответствующие точки:

И нажмите кнопку Compare. В результате будут показаны два варианта страницы. Жёлтый цвет показывает удалённый контент, а голубой цвет показывает добавленный контент.

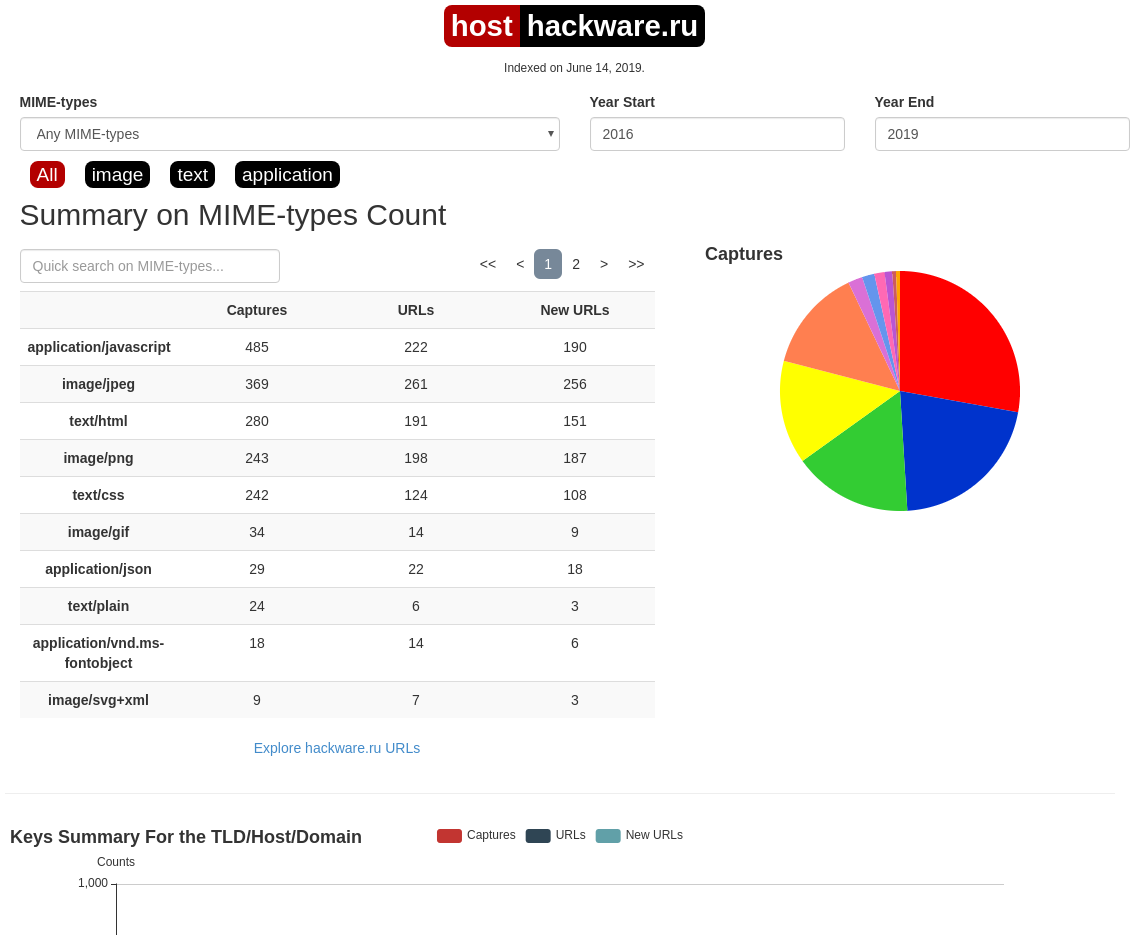

Summary

В этой вкладке статистика о количестве изменений MIME-типов.

Site Map

Как следует из название, здесь показывается диаграмма карты сайта, используя которую вы можете перейти к архиву интересующей вас страницы.

Поиск по Интернет архиву

Если вместо адреса страницы вы введёте что-то другое, то будет выполнен поиск по архивированным сайтам:

Показ страницы на определённую дату

Кроме использования календаря для перехода к нужной дате, вы можете просмотреть страницу на нужную дату используя ссылку следующего вида: http://web.archive.org/web/ГГГГММДДЧЧММСС/АДРЕС_СТРАНИЦЫ/

Обратите внимание, что в строке ГГГГММДДЧЧММСС можно пропустить любое количество конечных цифр.

Если на нужную дату не найдена архивная копия, то будет показана версия на ближайшую имеющуюся дату.

archive.md

Адреса данного Архива Интернета:

На главной странице говорящие за себя поля:

Для поиска по сохранённым страницам можно как указывать конкретный URL, так и домены, например:

Данный сервис сохраняет следующие части страницы:

Не сохраняются следующие части веб-страниц:

Архивируемая страница и все изображения должны быть менее 50 Мегабайт.

Для каждой архивированной страницы создаётся ссылка вида http://archive.is/XXXXX, где XXXXX это уникальный идентификатор страницы. Также к любой сохранённой странице можно получить доступ следующим образом:

Дату можно продолжить далее, указав часы, минуты и секунды:

Для улучшения читаемости, год, месяц, день, часы, минуты и секунды могут быть разделены точками, тире или двоеточиями:

Также возможно обратиться ко всем снимкам указанного URL:

Все сохранённые страницы домена:

Все сохранённые страницы всех субдоменов

Чтобы обратиться к самой последней версии страницы в архиве или к самой старой, поддерживаются адреса вида:

Чтобы обратиться к определённой части длинной страницы имеется две опции:

В доменах поддерживаются национальные символы:

Обратите внимание, что при создании архивной копии страницы архивируемому сайту отправляется IP адрес человека, создающего снимок страницы. Это делается через заголовок X-Forwarded-For для правильного определения вашего региона и показа соответствующего содержимого.

web-arhive.ru

Архив интернет (Web archive) — это бесплатный сервис по поиску архивных копий сайтов. С помощью данного сервиса вы можете проверить внешний вид и содержимое страницы в сети интернет на определённую дату.

На момент написания, этот сервис, вроде бы, нормально не работает («Database Exception (#2002)»). Если у вас есть по нему какие-то новости, то пишите их в комментариях.

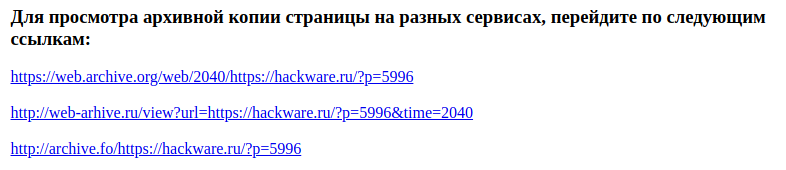

Поиск сразу по всем Веб-архивам

Может так случиться, что интересующая страница или файл отсутствует в веб архиве. В этом случае можно попытаться найти интересующую сохранённую страницу в другом Архиве Интернета. Специально для этого я сделал довольно простой сервис, который для введённого адреса даёт ссылки на снимки страницы в рассмотренных трёх архивах.

Что делать, если удалённая страница не сохранена ни в одном из архивов?

Архивы Интернета сохраняют страницы только если какой-то пользователь сделал на это запрос — они не имеют функции обходчиков и ищут новые страницы и ссылки. По этой причине возможно, что интересующая вас страница оказалась удалено до того, как была сохранена в каком-либо веб-архиве.

Тем не менее можно воспользоваться услугами поисковых движков, которые активно ищут новые ссылки и оперативно сохраняют новые страницы. Для показа страницы из кэша Google нужно в поиске Гугла ввести

Если ввести подобный запрос в поиск Google, то сразу будет открыта страница из кэша.

Для просмотра текстовой версии можно использовать ссылку вида:

Для просмотра исходного кода веб страницы из кэша Google используйте ссылку вида:

Например, текстовый вид:

Как полностью скачать сайт из веб-архива

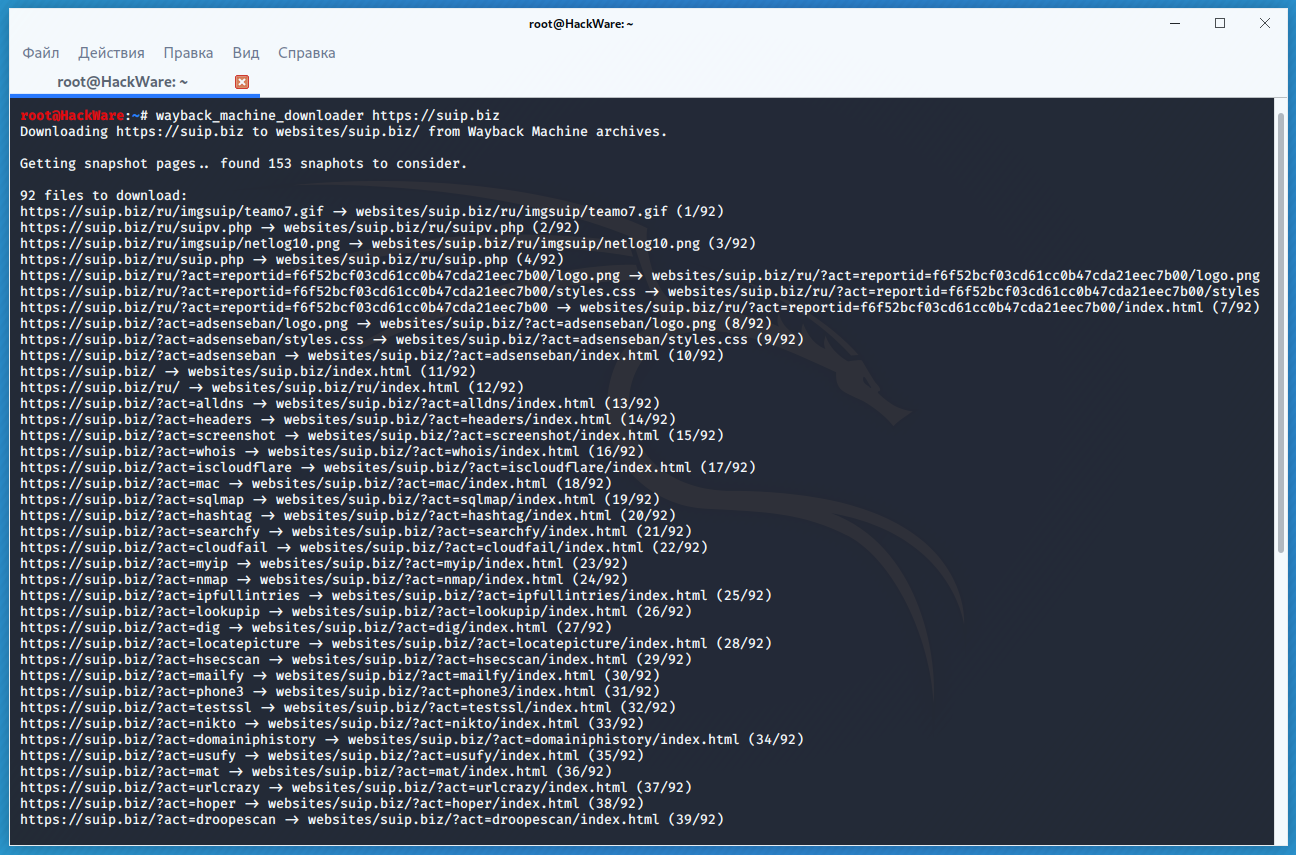

Если вы хотите восстановить удалённый сайт, то вам поможет программа Wayback Machine Downloader.

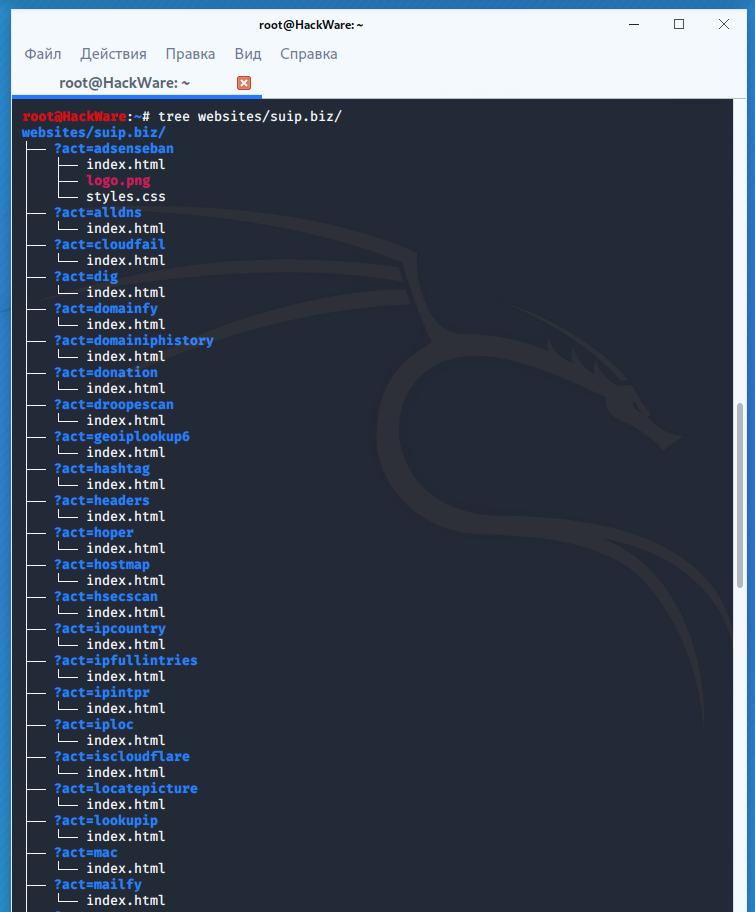

Программа загрузит последнюю версию каждого файла, присутствующего в Архиве Интернета Wayback Machine, и сохранить его в папку вида ./websites/example.com/. Она также пересоздаст структуру директорий и автоматически создаст страницы index.html чтобы скаченный сайт без каких либо изменений можно было бы поместить на веб-сервер Apache или Nginx.

Об установке программы и дополнительных опциях смотрите на странице https://kali.tools/?p=5211

Пример скачивания полной копии сайта suip.biz из веб-архива:

Структура скаченных файлов:

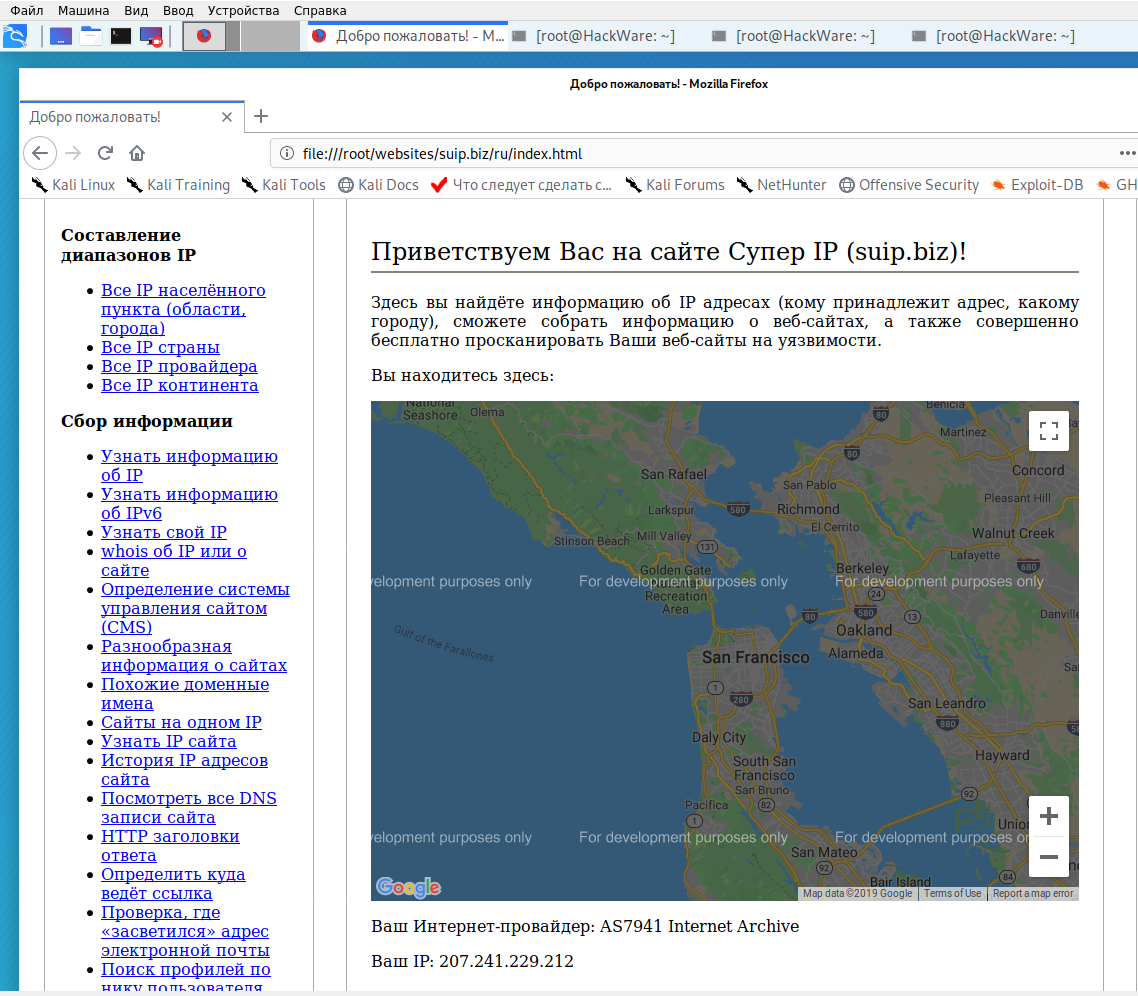

Локальная копия сайта, обратите внимание на провайдера Интернет услуг:

Как скачать все изменения страницы из веб-архива

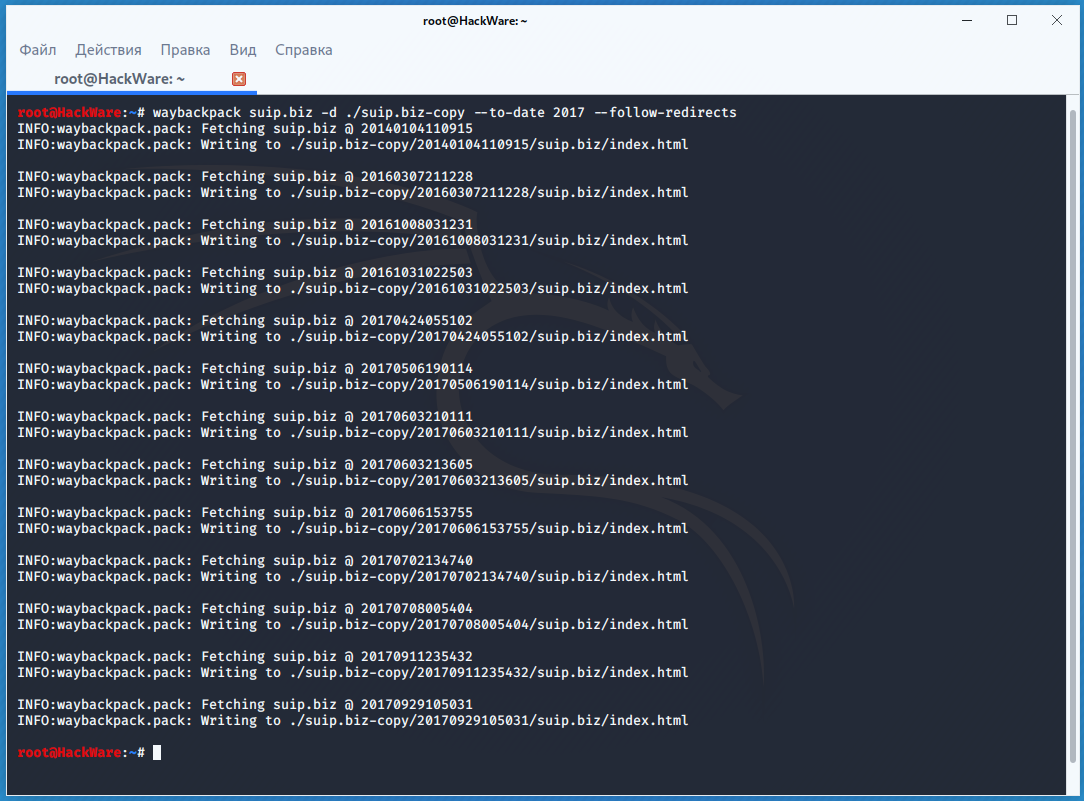

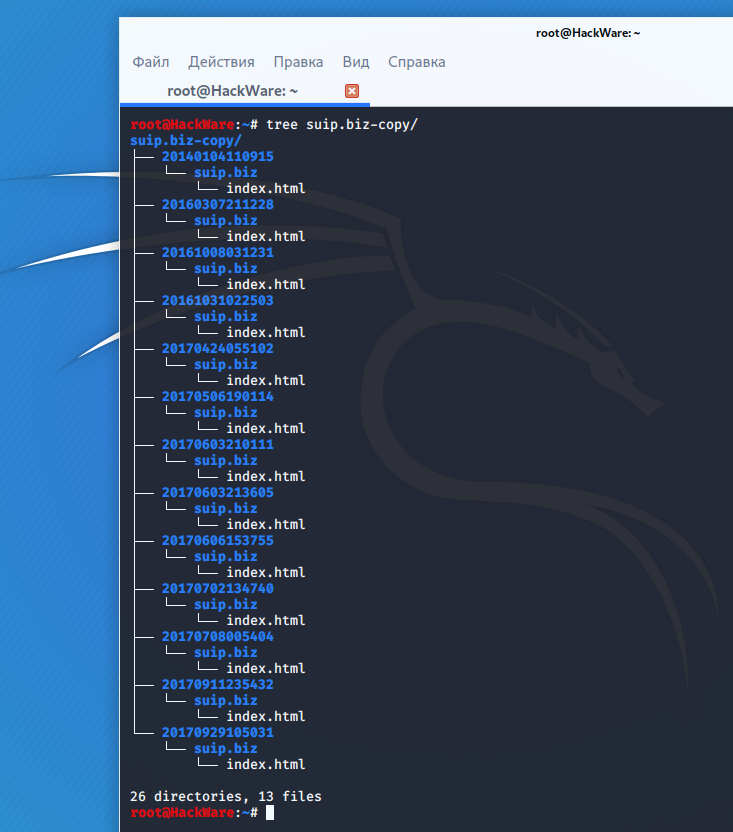

Если вас интересует не весь сайт, а определённая страница, но при этом вам нужно проследить все изменения на ней, то в этом случае используйте программу Waybackpack.

К примеру для скачивания всех копий главной страницы сайта suip.biz, начиная с даты (—to-date 2017), эти страницы должны быть помещены в папку (-d /home/mial/test), при этом программа должна следовать HTTP редиректам (—follow-redirects):

Чтобы для указанного сайта (hackware.ru) вывести список всех доступных копий в веб-архиве (—list):

Как узнать все страницы сайта, которые сохранены в веб-архиве

Для получения ссылок, которые хранятся в Архиве Интернета, используйте программу waybackurls.

Эта программа извлекает все URL указанного домена, о которых знает Wayback Machine. Это можно использовать для быстрого составления карты сайта.

Чтобы получить список всех страниц о которых знает Wayback Machine для домена suip.biz:

Заключение

Предыдущие три программы рассмотрены совсем кратко. Дополнительную информацию об их установке и об имеющихся опциях вы сможете найти по ссылкам на карточки этих программ.

Ещё парочка программ, которые работают с архивом интернета:

На каких серверах держится Архив Интернета?

Фото 1. Один из дата-центров Internet Archive в Сан-Франциско

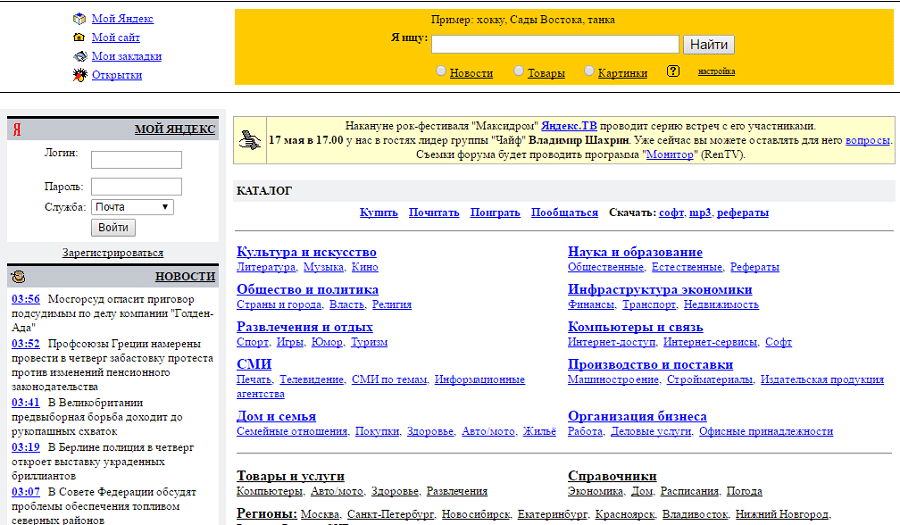

Internet Archive — некоммерческая организация, которая с 1996 года сохраняет копии веб-страниц, графические материалы, видео- и аудиозаписи и программное обеспечение. Каждый может зайти в Wayback Machine и посмотреть, как выглядел Хабр в 2006 году или «Яндекс» в 1998 году, хотя загрузка архивных копий занимает около минуты (это не для реализма 90-х, а по техническим причинам, см. ниже).

Архив быстро растёт. Сейчас объём всех накопителей достиг 200 петабайт. Но Internet Archive принципиально не обращается к стороннему хостингу или облачному сервису вроде AWS. У некоммерческой организации собственные дата-центры, свои серверы и свои инженеры. Это гораздо дешевле, чем услуги AWS.

Архив Интернета против облаков

Технические подробности серверного устройства Internet Archive раскрыл Джона Эдвардс (Jonah Edwards), руководитель инженерной группы Core Infrastructure Team.

По его мнению, понятие «облако» многих людей вводит в заблуждение как нечто абстрактное. На самом деле это просто чужие компьютеры, то есть серверы посторонней компании. Для Internet Archive это неприемлемо. У организации собственные серверные в собственных зданиях, компьютеры принадлежат им, и персонал тоже свой.

Четыре дата-центра Internet Archive располагаются в Сан-Франциско, Ричмонде и Редвуд-Сити (это пригороды Сан-Франциско)

Кто-то может посчитать такой подход архаичным, но в некоторых случаях он действительно оправдан. В случае Internet Archive на то есть три причины: это дешевле, обеспечивает лучший контроль за серверами и даёт гарантию, что пользователей не отслеживают рекламные трекеры.

Инфраструктура

Что представляет собой инфраструктура, которой управляет Core Infrastructure Team? На февраль 2021 года цифры такие:

Разумеется, техника постепенно обновляется. На смену старым накопителям приходят новые. Например, маленькие диски на 2 и 3 терабайта полностью вышли из обращения в 2017 и 2018 годах, соответственно, а с прошлого года постоянно растёт доля дисков на 16 ТБ.

Как показано на графике ниже, несмотря на увеличение ёмкости накопителей, общее число HDD тоже постепенно растёт: за три года оно выросло с 15 тыс. до 20 тыс.

Количество жёстких дисков разного объёма на серверах Internet Archive

Диски реплицируются по дата-центрам, для производительности контент по запросу выдаётся одновременно со всех копий. Все элементы Архива представляют собой директории на дисках. Веб-страницы Wayback Machine хранятся в файлах WARC (Web ARChive, сжатые файлы Web Archive). При запросе отдельной страницы её нужно извлечь из середины архива WARC, а если страница требует загрузки дополнительных ресурсов, то процесс повторяется. Это одна из причин, почему полная загрузка страниц из Wayback Machine достигает 90 секунд, хотя закэшированные копии и популярный контент загружаются быстрее.

Для надёжности копии Архива хранятся не только в Сан-Франциско, но и ещё в нескольких локациях по всему миру, в том числе в Амстердаме (Нидерланды) и Новой Александрийской библиотеке (Египет).

В 1996 году первые серверы Internet Archive подняли на недорогих компьютерах из стандартных комплектующих: по сути, на обычных десктопах под Linux. Хотя инфраструктура сильно выросла, в качестве операционной системы всегда использовали только Linux. С 2004 года все серверы перешли на Ubuntu, сейчас продолжается миграция на Ubuntu 20.4 LTS (Focal Fossa).

Объём Архива

В последнее время объём Архива возрастает примерно на 25% в год, сейчас это соответствует 5−6 петабайтам в квартал. С учётом резервных копий нужно добавлять накопителей на 10−12 петабайт в квартал.

Одна копия Архива занимает более 45 петабайт, но на дисках и лентах хранится минимум две копии каждого объекта.

Как видно на графике вверху, обновление дискового массива происходит только за счёт моделей максимальной ёмкости. Например, в конце 2021 года планируется переход на диски по 20 ТБ, и тогда в серверы будут устанавливать только их. Остальные HDD постепенно доживают свой век, и их количество медленно снижается.

Internet Archive возлагает большие надежды на новые технологии записи данных, такие как HAMR (heat-assisted magnetic recording), чтобы ёмкость HDD увеличивалась ещё быстрее. Технология HAMR предусматривает предварительное нагревание магнитной поверхности лазером в процессе записи, что позволяет значительно уменьшить размеры магнитной области, хранящей один бит информации — и увеличить плотность записи. Нагрев выполняется с помощью лазера, который за 1 пс разогревает область записи до 100 °C.

Разработка этой технологии затянулась на 15 лет, но в январе 2021 года были официально представлены первые диски HAMR на 20 ТБ. Пока что они официально поставляются только избранным клиентам в рамках фирменного сервиса Seagate Lyve, но вскоре должны появиться в свободной продаже.

Seagate обещает, что HAMR позволит наращивать ёмкость HDD на 20% в год. Поэтому в ближайшее время можно ожидать модель на 24 ТБ, а в будущем — диски на 30 и 50 ТБ. Internet Archive тоже надеется на это и внимательно следит за последними разработками.

На текущем размере дисков понадобится 15 вот таких серверных стоек, чтобы разместить одну копию Архива:

У Internet Archive 750 серверов и 20 000 жёстких дисков

Сейчас в дата-центрах установлено 75 серверных стоек, что обеспечивает некоторый запас и избыточное копирование.

По состоянию на февраль 2021 года на серверах хранились копии 534 млрд веб-страниц, 16 млн аудиозаписей, 8,7 млн видеозаписей фильмов, клипов и телепередач, 3,8 млн изображений, 629 тыс. компьютерных программ, более 29 млн книг и текстов, в том числе 72 771 текстов на русском языке.

Любой пользователь может создать аккаунт и добавить в архив медиафайлы.

В 2020 году Internet Archive пережил серьёзный рост количества запросов и объёма внешнего трафика с 40 до 60 Гбит/с. Из-за пандемии коронавируса и самоизоляции ресурсы Архива стали более востребованы. Количество запросов росло так быстро, что в определённый момент маршрутизаторы Internet Archive перестали справляться с нагрузкой, пришлось делать апгрейд сетевой инфраструктуры быстрее, чем планировалось. Сейчас веб-сайт входит в топ-300 крупнейших сайтов интернета.

Работа на собственных серверах имеет и свои недостатки. Основные причины сбоев Internet Archive — обрывы оптоволокна из-за строительных работ в городе, сбои энергоснабжения, случайные провалы напряжения в сети. Впрочем, прошлый год сайт завершил с аптаймом 99,9%.

Internet Archive планирует расширять внешний канал. Ожидается, что в ближайшее время внешний трафик вырастет до 80 Гбит/с.

Примерно так выглядит дизайн внутренней сети:

Дата-центры подключены к нескольким провайдерам первого уровня (Tier 1) и соединены между собой по оптоволокну с применением технологии плотного спектрального уплотнения (DWDM). Локальные университетские сети подключаются к этому кольцу напрямую через локальные точки обмена трафиком.

Вместо нынешнего оптоволокна планируется проложить пары 100-гигабитных кабелей по всему кольцу из четырёх дата-центров, так что внешний трафик тоже можно будет увеличить до 100 Гбит/с.

Прокладка новых кабелей по Сан-Франциско — весьма хлопотное и дорогое дело. Приходится перекладывать асфальт на автомобильных дорогах и тротуарах. К счастью, Internet Archive удалось получить официальный статус библиотеки, что даёт доступ к государственным субсидиям, в том числе к бюджету Федеральной комиссии по связи США (FCC) на подключение всех библиотек к интернету. Таким образом, львиную долю расходов на прокладку, обслуживание оптоволокна и трафик оплачивает FCC по программе E-Rate Universal Service Program.

С 2005 года Internet Archive начал проект Open Library по сканированию книг. С одной стороны, это действительно важный общественный проект. С другой стороны, он позволил получить государственные льготы и финансирование в качестве публичной библиотеки.

Кроме государственных грантов и пожертвований, организация оказывает платные услуги по сканированию книг, в основном, для других библиотек и университетов. Это ещё один источник финансирования.

Планы на будущее

Инженеры Internet Archive сейчас обдумывают варианты использования SSD и GPU в основных серверах, чтобы увеличить их производительность. Главная проблема здесь в том, что все дата-центры находятся в стеснённых городских условиях Сан-Франциско и пригородов с очень ограниченными возможностями охлаждения (см. фото 1). Так что каждый апгрейд требуется хорошо обдумать: не приведёт ли он к повышению температуры.

Интересно наблюдать за ростом инфраструктуры Internet Archive с увеличением количества серверных стоек. Есть подозрение, что рано или поздно наступит момент, когда сложность поддержания своей инфраструктуры превысит некий порог — и библиотека откажется от собственных дата-центров. Но пока что инженеры Core Infrastructure Team успешно справляются с работой.

В зависимости от методологии расчёта, хранение данных в собственных дата-центрах Internet Archive обходятся в 2−5 раз дешевле, чем в облаке. И это только хранение. Сложно даже посчитать, сколько будет стоить круглосуточный исходящий трафик 60 Гбит/с на AWS. Вероятно, он обойдётся даже дороже, чем хранение 200 петабайт.

Похоже, что некоторые сервисы просто «слишком велики» для облака. Компаниям приходится поднимать собственные дата-центры, потому что у них нет выхода. Другой вопрос: должна ли библиотека заниматься этим самостоятельно? Получается, что современная цифровая библиотека — это по сути хостинг-провайдер и дата-центр?

На правах рекламы

Эпичные серверы — это надёжные VDS на Linux или Windows с мощными процессорами семейства AMD EPYC и очень быстрой файловой системой, используем исключительно NVMe диски от Intel. Попробуйте как можно быстрее!