Qos что это в коммутаторе

Qos что это в коммутаторе

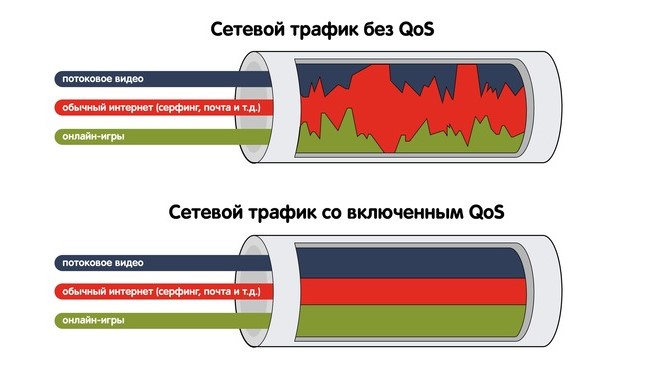

Quality of Service (с англ. «качество обслуживания») — это набор технологий, которые запускают высокоприоритетные приложения и трафик при лимитированной пропускной способности. Это означает, что более важный трафик будет обработан быстрее, а задержки по сети будут минимальны.

Измерения, касающиеся QoS, включают:

Дрожание (отклонение в задержке);

Благодаря технологии QoS можно научить маршрутизатор разделять пропускную способность и тогда ни потоковое видео, ни звонок в Skype не будут заикаться.

Как работает

Механизмы QoS для упорядочивания пакетов и выделения полосы пропускания:

управление полосой пропускания.

Необходимо разделить трафик с помощью инструментов классификации. Так организации смогут контролировать доступность ресурсов для приоритетных приложений. Трафик может быть классифицирован по порту, IP-адресу или с использованием более сложного подхода, такого как приложение или пользователь.

Затем для инструментов управления очередями и управления полосой пропускания назначают правила для обработки потоков трафика, характерных для классификации, которую они получили при входе в сеть.

Механизм организации очереди предназначен для хранения пакетов в потоках трафика до тех пор, пока сеть не будет готова их обработать. Это гарантирует, что наиболее важные приложения не будут лишены пропускной способности в сети из-за приложений с меньшим приоритетом.

Механизм управления пропускной способностью измеряет и контролирует потоки трафика, чтобы избежать перегруженности сети. Этот механизм включает в себя:

увеличение полезной полосы пропускания;

другие методы для обеспечения пропускной способности.

В зависимости от поставщика QoS перечисленными средствами можно управлять и объединять в блоки.

Когда используется

Каждый день корпоративные сети перегружаются натиском трафика. Часть этого трафика имеет решающее значение для успеха бизнес-операций. Особенно это может быть важно для IP-телефонии. Поэтому, когда возникает переполнение очереди на сетевых устройствах, QoS необходим, чтобы увеличить скорость обработки данных и убрать переполнение буфера памяти на сетевых устройствах.

Большинство организаций используют протокол передачи файлов (FTP) и приложения для видеоконференций, такие как Zoom или GoToMeeting. Хотя оба показателя важны для производительности сотрудников, пакеты FTP не так чувствительны к задержкам, как пакеты передачи голоса по Интернет-протоколу (VoIP). В случае задержки FTP-пакеты все равно будут доставлены без изменений. Но задержанный VoIP-пакет приведет к разобщенным видеозвонкам и сорванным деловым встречам.

Сервисные модели

Существуют три модели для реализации QoS:

Best-Effort (Негарантированная доставка);

IntServ (Интегрированное обслуживание);

DiffServ (Дифференцированные услуги).

Best-Effort — это модель сервиса по умолчанию, которая применяется к различным сетевым приложениям, таким как протокол передачи файлов (FTP) и электронная почта. Приложение может отправлять любое количество пакетов в любое время без уведомления сети. Затем сеть пытается передать пакеты. Модель Best-Effort подходит для услуг, которые предъявляют минимальные требования к задержке и скорости потери пакетов.

В модели IntServ приложение использует протокол сигнализации для уведомления сети о параметрах трафика и применения уровня QoS перед отправкой пакетов. Сеть резервирует ресурсы для приложения на основе параметров трафика. После того, как приложение получает подтверждение о зарезервированных ресурсах, оно начинает отправлять пакеты в пределах указанного диапазона.

DiffServ — часто используемая модель QoS, классифицирует пакеты в сети и выполняет установленные действия для каждого класса. Когда происходит перегрузка сети, пакеты классов обрабатываются на основе приоритетов, что приводит к неодинаковой частоте потери пакетов, неоднородным задержкам и дрожанию. Пакеты одного и того же класса объединяются и отправляются одним блоком.

В отличие от IntServ, модель DiffServ не требует протокола сигнализации. В этой модели приложение не запрашивает сетевые ресурсы перед отправкой пакетов. Вместо этого приложение устанавливает параметры QoS в пакетах, через которые сеть может узнать требования QoS приложения. Сеть предоставляет дифференцированные услуги на основе параметров QoS каждого потока данных.

Классификация и маркировка

Классификация и маркировка трафика – основа дифференцированных услуг.

Критерии для классификации данных:

IP-адрес источника или назначения;

значение класса CoS в заголовке;

значение типа услуги ToS в заголовке IP (приоритет IP или DSCP);

значение MPLS EXP в заголовке MPLS.

На этапе классификации маршрутизатор распознает трафик, который будет сопоставлен с каждым из классов.

После классификации маршрутизатор выполняет маркировку пакетов: связывает пакет с оригинальным параметром. Этот параметр используется в последующих маршрутизаторах для идентификации трафика. Маркировка может быть сделана:

на уровне 2 в заголовке Ethernet;

на уровне 2.5 в заголовке MPLS;

на уровне 3 в заголовке IP;

Благодаря этим изменениям трафик быстро распознается в любой точке сети.

Параметры, которые могут быть установлены или изменены:

значение CoS исходящего пакета;

значение DSCP в байте типа ToS;

значение поля MPLS EXP в верхней метке на интерфейсе ввода или вывода;

экспериментальное поле EXP многопротокольной коммутации по MPLS на введенных записях меток;

значение приоритета в заголовке пакета;

идентификатор группы QoS (ID);

биты ToS в заголовке IP-пакета.

Например, чтобы разместить голосовой и информационный трафик в отдельных очередях, используют классификацию. Метод маркировки помогает QoS изменять биты в заголовке пакета и указывать приоритет, понятный для других инструментов. Инструменты маркировки для голосовых пакетов используют для гарантии, что программа распознает их в сетевом потоке.

Настройка сервиса на роутере

Перед настройкой сервиса на роутере заходят на портал изготовителя, чтобы узнать, какие функции QoS поддерживаются и как получить к ним доступ.

Каждая платформа будет запрашивать скорость загрузки и выгрузки. Не стоит полагаться на заявленную провайдером скорость. Узнать доступную полосу пропускания для загрузки и выгрузки можно на speedtest.net. Полученные результаты преобразуют из Мбита в Кбит.

Алгоритм включения QoS на роутере:

Открыть панель администрирования.

В адресную строку браузера ввести IP-адрес маршрутизатора.

Войти под персональным именем и паролем (указано в руководстве к маршрутизатору).

После входа выбрать вкладку «NAT», затем «QoS».

Нажать «Включить», оставив порт установленным на WAN, а Packet Scheduler и Queueing Discipline в состоянии по умолчанию.

Заполнить значения восходящую и нисходящую линии связи (вводные данные составляют 80-95% значения, полученного в ходе теста скорости).

Платформа продуктивно работает, если может искусственно создать узкое место для перенаправления трафика. Если пользователь выставляет значения, равные или превышающие скорость соединения, тогда программе не остается пространства для маневра.

QoS в IP-телефонии

Настройка QoS в IP-телефонии важна для бизнеса, ведь качество связи влияет на количество звонков и, соответственно, конверсию.

Чтобы не допустить помехи связи и задержки звука, можно настроить приоритезацию для данных IP-телефонии. Перед настройкой обратите внимание на характеристики роутера и максимальный размер очереди обработки пакетов. Если канал узкий, то буфер устройства будет переполняться, а новые пакеты удаляться и приоритизация трафика в таком случае бесполезна. Необходимо проложить дополнительные маршруты.

Настроить приоритезацию в IP-телефонии можно двумя способами:

В веб-интерфейсе роутера:

По протоколу SIP/RTP (используется для передачи звука).

В приложении для звонков:

Необходимо открыть сетевые настройки (Ethernet, IP, ATM, MPLS и др.) и промаркировать трафик. Так роутер поймет, какие данные пропускать быстрее.

Единственный минус — не все роутеры понимают приоритет по заголовку, настройка будет зависеть от устройства и сервиса.

Заключение

Технология QoS помогает поддерживать производительность сети, гарантировать бесперебойную передачу трафика, а также регулярно оценивать состояние IT-инфраструктуры компании. QoS в IP-телефонии влияет на количество и качество звонков, а значит на конверсию.

Модульная командная строка QoS в Cisco

Switch(config)# class-map match-any cisco

Switch(config-cmap)# match access-group name test

Switch(config-cmap)# match interface fastethernet 0/1

Команда service policy используется для присоединения политики трафика, указанную командой policy-map, на интерфейс.

— Может быть применен как для входящих так и для исходящих пакетов на указанном интерфейсе, поэтому в данной команде необходимо указывать направление трафика.

Пример:

Switch(config)#interface fastethernet 0/1

Switch(config-if)#service-policy output policy1

Switch(config-if)#exit

Все пакеты покидающие указанные интерфейс должны быть совместимы с критериями указанными в политике трафика названной policy1.

Теперь попробуем объединить все что у нас получилось в единую конфигурацию, с небольшими разъяснениями:

1. Добавляем политику трафика к интерфейсу.

Switch(config)#interface fastethernet 0/1

Switch(config-if)#service-policy output policy1

2. Идентифицируем функцию QoS данной политики, используя классы.

Switch(config)#policy-map policy1

Switch(config-pmap)#class cisco

Switch(config-pmap-c)#bandwidth 3000

Switch(config-pmap)#class class-default

Switch(config-pmap-c)#bandwidth 2000

3. Классификация потока трафика, как принадлежащего к указанному классу QoS.

Switch(config)# class-map match-any cisco

Switch(config-cmap)# match access-group name test

Switch(config-cmap)# match interface fastethernet 0/1

Примерно так и функционирует модель QoS основанная на Cisco IOS, надеюсь я хоть немного смог раскрыть алгоритм данного функционала. Конечно данная статья является только лишь верхушкой айсберга под названием QoS, но надеюсь, что она поможет приобрести небольшую базу в построении политик QoS на устройствах Cisco.

Quality of Service: приоритизация трафика

Для обеспечения улучшенного качества передачи данных, имеющих повышенное значение, в сетях применяется специальный механизм Quality of Service (QoS). Поэтому любой специалист, занимающийся сетями, должен знать, что это — QoS, и как работает эта технология.

О технологии

Технология QoS используется для предотвращения потери и увеличения скорости обработки важных данных при отправке по сети. Ее суть заключается в приоритизации трафика. Умное распределение QoS — это предоставление деление трафика на классы с предоставлением им разных приоритетов в обслуживании. При этом трафик, которому присвоен более высокий класс, обрабатывается сетевым оборудованием в первую очередь. Поэтому он проходит по сети с минимальными задержками.

Что такое качество обслуживания?

При передаче данных по сетям качество обслуживания оценивается по следующим ключевым параметрам:

Поддержка QoS — это возможность сетевого оборудования контролировать все эти параметры. Этот механизм, который выделяет для информации заданную полосу пропускания, снижает уровень джиттера и задержки, защищает важные пакеты от потери.

Использовать технологию QoS можно при условии, что она поддерживается всеми сетевыми устройствами между получателем и отправителем.

Зачем использовать приоритизацию трафика?

По сетям проходит трафик разных видов. В том числе передаются данные электронной почты, веб-приложений, мессенджеров, голосовых сообщений, видео, телеметрии и других типов. Для каждого из вида трафика существуют определенные требования по качеству передачи. Так, для видео или голосового трафика характерна особая чувствительность к задержкам. Телеметрический трафик намного более устойчив к задержкам, но он должен гарантированно доставляться. Для выполнения всех требований каждому виду трафика присваивается определенный приоритет, в соответствии с которым определяется очередность его обработки сетевым оборудованием.

Приоритизация трафика дает следующие плюсы:

Приоритизация необходима, главным образом в особо нагруженных, узких местах, в которых пропускная способность канала не позволяет одновременно передавать большой объем поступающих пакетов. Также она позволяет защитить трафик, чувствительный к задержкам, от воздействия всплесков активности в сети.

Механизм работы QoS

Чтобы понять, что такое QoS в сетях, необходимо разобрать механизм его работы. Для реализации технологии применяется маркировка трафика, благодаря которой каждый передаваемый пакет имеет поле с указанной отметкой о его приоритете.

В сетевых коммутаторах применяются два стандартных способа маркировки:

Особенности маркировки IEEE 802.1p — Class of Service

Стандарт IEEE 802.1Q предусматривает тегирование трафика, что необходимо для передачи данных о принадлежности к VLAN. В кадр Ethernet включается тег 802.1Q размерностью 4 байта. Он содержит информацию о VLAN, а также сведения об установленном уровне приоритета трафика. Таким образом, IEEE 802.1p можно назвать частью IEEE 802.1Q.

В стандарте IEEE 802.1p предусматривается 8 классов приоритета трафика, которые приведены в таблице:

Качество передачи не гарантировано, но поддерживается на лучшем уровне из возможного

Приоритетный трафик. Не критичные к задержке, но критичные к потерям данные. Менее приоритетные, чем контролируемый трафик

Excellent Effort (business critical)

Контролируемый трафик. Критичный к потерям, но не критичный к задержке. Мультимедийные потоки

Controlled Load (streaming multimedia)

Видеопотоки. Критичной является задержка свыше 100 мс

Голосовой трафик. Критичной является задержка свыше 10 мс

Данные управления сетью

Network Control Reserved traffic

Несмотря на достаточно частое использование в локальных сетях, приоритизация по стандарту IEEE 802.1p имеет ряд существенных ограничений:

Особенности маркировки Differentiated Services (DiffServ) — Type of Service

QoS Type of Service — это маркировка, которая применяется в коммутаторах 3 уровня и маршрутизаторах. Она предусматривает включение специального байта ToS (Type of Service) в заголовок IP. В этом байте прописаны сведения о приоритете трафика.

Преимущества DiffServ перед IEEE 802.1p:

Очереди трафика

В коммутаторах поступающие на порт пакеты помещаются в несколько очередей трафика для ожидания их обработки устройством. Наиболее важный трафик помещается в первую очередь, менее важный — в последующие очереди по убыванию степени важности. Чем большее количество очередей поддерживает коммутатор, тем точнее он балансирует передачу данных.

Порядок работы коммутатора:

Существую разные механизмы очередей. Управляемыми коммутаторами применяется два типа таких механизмов: Weighted Fair Queuing (WFQ) и Strict Priority Queuing (SPQ).

При использовании механизма WFQ (взвешенная справедливая очередь) выполняется циклическое обслуживание очередей. Объем трафика, передаваемого за цикл, определяется в зависимости от приоритета очереди. Из высокоприоритетных очередей в единицу времени на выходной порт выдается больше пакетов, чем из очередей с меньшим приоритетом. Плюс этого механизма заключается в выделении определенного минимума пропускной способности всем классам трафика при полной загруженности полосы пропускания. Это исключает потерю менее приоритетного трафика при перегрузках.

Механизм SPQ (строгая очередь приоритетов) предусматривает первоочередную передачу трафика с высоким приоритетом. Менее приоритетный трафик начинает передаваться только после полной передачи данных с высшим приоритетом. Этот подход гарантирует отправку высокоприоритетных данных, но может приводить к потере менее приоритетного трафика при перегрузках канала.

В неуправляемых коммутаторах применяется механизм Weighted Round Robin (WRR), или взвешенный циклический алгоритм. Он предусматривает последовательное и циклическое обслуживание очередей. Каждой из очередей, в соответствии с ее приоритетом, задается определенное время обработки. Плюсом алгоритм можно назвать гарантию доступа к передаче в установленных пропорциях для каждой очереди.

Настройка приоритизации трафика на коммутаторах TING

Понимая, что такое тип QoS, нужно разобраться с настройкой трафика на сетевом оборудовании.

Настройка приоритизации на коммутаторах TING предусматривает назначение коэффициентов типам трафика. Они вступают в силу при полной загрузке канала. В результате пропускная способность распределяется для разных типов трафика в соответствии с установленными значениями коэффициентов, которые могут варьироваться от 1 до 100. Чем более высокий коэффициент присвоен трафику, тем более высокая доля пропускной способности канала предоставляется ему в случае повышенной нагрузки.

Настройка выполняется путем задания правил, ссылающихся на очереди, которые, в свою очередь, ссылаются на каналы (пайпы).

Для создания канала нужно перейти по пути Межсетевой экран — Ограничитель трафика — Настройки. После этого необходимо вызывать окно редактирования канала, кликнув на «+» на вкладке «Каналы». Здесь задается пропускная способность канала.

Далее нужно перейти на вкладку «Очереди» и нажать на значок «+». В появившемся окне редактирования ввести данные для очереди. Основным параметром для очереди будет ее весовой коэффициент.

После задания весового коэффициента для очереди приступают к созданию правил. Для этого нужно кликнуть на «+» на вкладке «Правила». Предусматривается возможность создания правил для трафика SMTP, HTTP, HTTPS — в таблицах прописывают соответствующие порты и IP-адреса. При этом трафик HTTP и HTTPS попадают в одну очередь и одинаково обрабатываются со скоростью до 1 Мбит/c.

Использование QoS в кольцевых топологиях Turbo Ring/Chain

При работе в топологиях Turbo Ring/Turbo Chain самый высокий приоритет всегда должен иметь служебный трафик протоколов резервирования. Если при настройке QoS наивысший приоритет задан другому трафику, это может привести к несвоевременной доставке служебных сообщений. Поэтому в резервированных сетях Turbo Ring/Chain не рекомендуется назначать наивысший приоритет никакому трафику в настройках, чтобы не допустить ухудшения работы и увеличения времени восстановления.

Защищаемся маршрутизатором: QoS

QoS — тема большая. Прежде чем рассказывать про тонкости настроек и различные подходы в применении правил обработки трафика, имеет смысл напомнить, что такое вообще QoS.

Quality of Service (QoS) — технология предоставления различным классам трафика различных приоритетов в обслуживании.

Во-первых, легко понять, что любая приоритезация имеет смысл только в том случае, когда возникает очередь на обслуживание. Именно там, в очереди, можно «проскользнуть» первым, используя своё право.

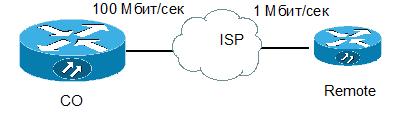

Очередь же образуется там, где узко (обычно такие места называются «бутылочным горлышком», bottle-neck). Типичное «горлышко» — выход в Интернет офиса, где компьютеры, подключенные к сети как минимум на скорости 100 Мбит/сек, все используют канал к провайдеру, который редко превышает 100 МБит/сек, а часто составляет мизерные 1-2-10МБит/сек. На всех.

Во-вторых, QoS не панацея: если «горлышко» уж слишком узкое, то часто переполняется физический буфер интерфейса, куда помещаются все пакеты, собирающиеся выйти через этот интерфейс. И тогда новопришедшие пакеты будут уничтожены, даже если они сверхнужные. Поэтому, если очередь на интерфейсе в среднем превышает 20% от максимального своего размера (на маршрутизаторах cisco максимальный размер очереди составляет как правило 128-256 пакетов), есть повод крепко задуматься над дизайном своей сети, проложить дополнительные маршруты или расширить полосу до провайдера.

Разберемся с составными элементами технологии

(дальше под катом, много)

Маркировка. В полях заголовков различных сетевых протоколов (Ethernet, IP, ATM, MPLS и др.) присутствуют специальные поля, выделенные для маркирования трафика. Маркировать же трафик нужно для последующей более простой обработки в очередях.

Ethernet. Поле Class of Service (CoS) — 3 бита. Позволяет разделить трафик на 8 потоков с различной маркировкой

IP. Есть 2 стандарта: старый и новый. В старом было поле ToS (8 бит), из которого в свою очередь выделялись 3 бита под названием IP Precedence. Это поле копировалось в поле CoS Ethernet заголовка.

Позднее был определен новый стандарт. Поле ToS было переименовано в DiffServ, и дополнительно выделено 6 бит для поля Differencial Service Code Point (DSCP), в котором можно передавать требуемые для данного типа трафика параметры.

Маркировать данные лучше всего ближе к источнику этих данных. По этой причине большинство IP-телефонов самостоятельно добавляют в IP-заголовок голосовых пакетов поле DSCP = EF или CS5. Многие приложения также маркируют трафик самостоятельно в надежде, что их пакеты будут обработаны приоритетно. Например, этим «грешат» пиринговые сети.

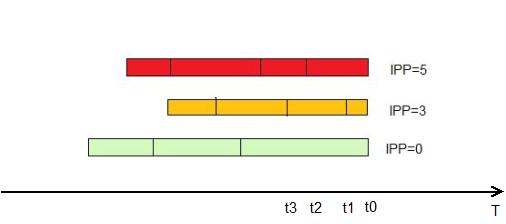

Даже если мы не используем никаких технологий приоритезации, это не значит, что не возникает очередей. В узком месте очередь возникнет в любом случае и будет предоставлять стандартный механизм FIFO (First In First Out). Такая очередь, очевидно, позволит не уничтожать пакеты сразу, сохраняя их до отправки в буфере, но никаких преференций, скажем, голосовому трафику не предоставит.

Если хочется предоставить некоторому выделенному классу абсолютный приоритет (т.е. пакеты из этого класса всегда будут обрабатываться первыми), то такая технология называется Priority queuing. Все пакеты, находящиеся в физическом исходящем буфере интерфейса будут разделены на 2 логических очереди и пакеты из привилегированной очереди будут отсылаться, пока она не опустеет. Только после этого начнут передаваться пакеты из второй очереди. Эта технология простая, довольно грубая, её можно считать устаревшей, т.к. обработка неприоритетного трафика будет постоянно останавливаться. На маршрутизаторах cisco можно создать

4 очереди с разными приоритетами. В них соблюдается строгая иерархия: пакеты из менее привилегированных очередей не будут обслуживаться до тех пор, пока не опустеют все очереди с более высоким приоритетом.

Справедливая очередь (Fair Queuing). Технология, которая позволяет каждому классу трафика предоставить одинаковые права. Как правило не используется, т.к. мало даёт с точки зрения улучшения качества сервиса.

Взвешенная справедливая очередь (Weighted Fair Queuing, WFQ). Технология, которая предоставляет разным классам трафика разные права (можно сказать, что «вес» у разных очередей разный), но одновременно обслуживает все очереди. «На пальцах» это выглядит так: все пакеты делятся на логические очереди, используя в

качестве критерия поле IP Precedence. Это же поле задаёт и приоритет (чем больше, тем лучше). Дальше, маршрутизатор вычисляет, пакет из какой очереди «быстрее» передать и передаёт именно его.

Считает он это по формуле:

IPP — значение поля IP Precedence

t(i) — Время, требуемое на реальную передачу пакета интерфейсом. Можно вычислить, как L/Speed, где L — длина пакета, а Speed — скорость передачи интерфейса

Такая очередь по умолчанию включена на всех интерфейсах маршрутизаторов cisco, кроме интерфейсов точка-точка (инкапсуляция HDLC или РРР).

WFQ имеет ряд минусов: такая очередизация использует уже отмаркированные ранее пакеты, и не позволяет самостоятельно определять классы трафика и выделяемую полосу. Мало того, как правило уже никто не маркирует полем IP Precedence, поэтому пакеты идут немаркированные, т.е. все попадают в одну очередь.

Развитием WFQ стала взвешенная справедливая очередь, основанная на классах (Class-Based Weighted Fair Queuing, CBWFQ). В этой очереди администратор сам задаёт классы трафика, следуя различным критериям, например, используя ACL, как шаблон или анализируя заголовки протоколов (см.NBAR). Далее, для этих классов

определяется «вес» и пакеты их очередей обслуживаются, соразмерно весу (больше вес — больше пакетов из этой очереди уйдёт в единицу времени)

Но такая очередь не обеспечивает строгого пропускания наиболее важных пакетов (как правило голосовых или пакетов других интерактивных приложений). Поэтому появился гибрид Priority и Class-Based Weighted Fair Queuing — PQ-CBWFQ, также известный как, Low Latency Queuing (LLQ). В этой технологии можно задать до 4х приоритетных очередей, остальные классы обслуживать по механизму CBWFQ

LLQ — наиболее удобный, гибкий и часто используемый механизм. Но он требует настройки классов, настройки политики и применения политики на интерфейсе.

Подробнее о настройках расскажу дальше.

Таким образом процесс предоставления качества обслуживания можно поделить на 2 этапа:

Маркировка. Поближе к источникам.

Обработка пакетов. Помещение их в физическую очередь на интерфейсе, подразделение на логические очереди и предоставление этим логическим очередям различных ресурсов.

Технология QoS — достаточно ресурсоёмкая и весьма существенно грузит процессор. И тем сильнее грузит, чем глубже в заголовки приходится залезать для классификации пакетов. Для сравнения: маршрутизатору гораздо проще заглянуть в заголовок IP пакета и проанализировать там 3 бита IPP, нежели раскручивать поток практически до уровня приложения, определяя, что за протокол идёт внутри (технология NBAR)

Для упрощения дальнейшей обработки трафика, а также для создания так называемой «области доверия» (trusted boundary), где мы верим всем заголовкам, относящимся к QoS, мы можем делать следующее:

1. На коммутаторах и маршрутизаторах уровня доступа (близко к клиентским машинам) ловить пакеты, раскидывать их по классам

2.В политике качестве действия перекрашивать заголовки по-своему или переносить значения QoS-заголовков более высокого уровня на нижние.

Например, на маршрутизаторе ловим все пакеты из гостевого WiFi домена (предполагаем, что там могут быть не управляемые нами компьютеры и софт, который может использовать нестандартные QoS-заголовки), меняем любые заголовки IP на дефолтные, сопоставляем заголовкам 3 уровня (DSCP) заголовки канального уровня (CoS),

чтобы дальше и коммутаторы могли эффективно приоритезировать трафик, используя только метку канального уровня.

Настройка очередей заключается в настройке классов, затем для этих классов надо определить параметры полосы пропускания и применить всю созданную конструкцию на интерфейс.

class-map NAME

match?

access-group Access group

any Any packets

class-map Class map

cos IEEE 802.1Q/ISL class of service/user priority values

destination-address Destination address

discard-class Discard behavior identifier

dscp Match DSCP in IP(v4) and IPv6 packets

flow Flow based QoS parameters

fr-de Match on Frame-relay DE bit

fr-dlci Match on fr-dlci

input-interface Select an input interface to match

ip IP specific values

mpls Multi Protocol Label Switching specific values

not Negate this match result

packet Layer 3 Packet length

precedence Match Precedence in IP(v4) and IPv6 packets

protocol Protocol

qos-group Qos-group

source-address Source address

vlan VLANs to match

Пакеты в классы можно рассортировывать по различным атрибутам, например, указывая ACL, как шаблон, либо по полю DSCP, либо выделяя конкретный протокол (включается технология NBAR)

policy-map POLICY

class NAME1

?

bandwidth Bandwidth

compression Activate Compression

drop Drop all packets

log Log IPv4 and ARP packets

netflow-sampler NetFlow action

police Police

priority Strict Scheduling Priority for this Class

queue-limit Queue Max Threshold for Tail Drop

random-detect Enable Random Early Detection as drop policy

service-policy Configure Flow Next

set Set QoS values

shape Traffic Shaping

Для каждого класса в политике можно либо выделить приритетно кусок полосы:

policy-map POLICY

class NAME1

priority?

1766594 Kilo Bits per second

percent % of total bandwidth

и тогда пакеты этого класса смогут всегда рассчитывать как минимум на этот кусок.

Либо описать, какой «вес» имеет данный класс в рамках CBWFQ

policy-map POLICY

class NAME1

bandwidth?

277415 Kilo Bits per second

percent % of total Bandwidth

remaining % of the remaining bandwidth

В обоих случаях можно указать как аболютное значение, так и процент от всей доступной полосы

Возникает резонный вопрос: а откуда маршрутизатор знает ВСЮ полосу? Ответ банален: из параметра bandwidth на интерфейсе. Даже если он не сконфигурирован явно, какое то его значение обязательно есть. Его можно посмотреть командой sh int.

Также обязательно помнить, что по умолчанию вы распоряжаетсь не всей полосой, а лишь 75%. Пакеты, явно не попавшие в другие классы, попадают в class-default. Эту настройку для дефолтного класса можно задать явно

policy-map POLICY

class class-default

bandwidth percent 10

(UPD, спасибо OlegD)

Изменить максимальную доступную полосу с дефолтных 75% можно командой на интерфейсе

Маршрутизаторы ревностно следят, чтобы админ не выдал случайно больше полосы, чем есть и ругаются на такие попытки.

Создаётся впечатление, что политика будет выдавать классам не больше, чем написано. Однако, такая ситуация будет лишь в том случае, если все очереди наполнены. Если же какая то пустует, то выделенную ей полосу наполненные очереди поделят пропорционально своему «весу».

Работать же вся эта конструкция будет так:

Если идут пакеты из класса с указанием priority, то маршрутизатор сосредотачивается на передаче этих пакетов. Причем, т.к. таких приоритетных очередей может быть несколько, то между ними полоса делится пропорционально указанным процентам.

Как только все приоритетные пакеты закончились, наступает очередь CBWFQ. За каждый отсчёт времени из каждой очереди «зачёрпывается» доля пакетов, указанная в настройке для данного класса. Если же часть очередей пустует, то их полоса делится пропорционально «весу» класса между загруженными очередями.

Применение на интерфейсе:

int s0/0

service-policy [input|output] POLICY

А что же делать, если надо строго рубить пакеты из класса, выходящие за дозволенную скорость? Ведь указание bandwidth лишь распределяет полосу между классами, когда очереди загружены.

Для решения этой задачи для класса трафика в политике есть технология

police [speed] [birst] conform-action [действие] exceed-action [действие]

она позволяет явно указать желаемую среднюю скорость (speed), максимальный «выброс», т.е. количество передаваемых данных за единицу времени. Чем больше «выброс», тем больше реальная скорость передачи может отклоняться от желаемой средней. Также указываются: действие для нормального трафика, не превышающего

указанную скорость и действие для трафика, превысившего среднюю скорость. Действия могут быть такими

police 100000 8000 conform-action?

drop drop packet

exceed-action action when rate is within conform and

conform + exceed burst

set-clp-transmit set atm clp and send it

set-discard-class-transmit set discard-class and send it

set-dscp-transmit set dscp and send it

set-frde-transmit set FR DE and send it

set-mpls-exp-imposition-transmit set exp at tag imposition and send it

set-mpls-exp-topmost-transmit set exp on topmost label and send it

set-prec-transmit rewrite packet precedence and send it

set-qos-transmit set qos-group and send it

transmit transmit packet

Часто возникает также и другая задача. Предположим, что надо ограничить поток, идущий в сторону соседа с медленным каналом.

Дабы точно предсказать, какие пакеты дойдут до соседа, а какие будут уничтожены в силу загруженности канала на «медленной» стороне, надо на «быстрой» стороне создать политику, которая бы заранее обрабатывала очереди и уничтожала избыточные пакеты.

И тут мы сталкиваемся с одной очень важной вещью: для решения этой задачи надо сэмулировать «медленный» канал. Для этой эмуляции не достаточно только раскидать пакеты по очередям, надо ещё сэмулировать физический буфер «медленного» интерфейса. У каждого интерфейса есть скорость передачи пакетов. Т.е. в единицу времени каждый интерфейс может передать не более, чем N пакетов. Обычно физический буфер интерфейса рассчитывают так, чтобы обеспечить «автономную» работу интерфейсу на несколько единиц вермени. Поэтому физический буфер, скажем, GigabitEthernet будет в десятки раз больше какого-нибудь интерфейса Serial.

Что же плохого в том, чтобы запомнить много? Давайте рассмотрим подробно, что произойдёт, в случае если буфер на быстрой передающей стороне будет существенно больше буфера принимающей.

Пусть для простоты есть 1 очередь. На «быстрой» стороне сэмулируем малую скорость передачи. Это значит, что попадая под нашу политику пакеты начнут накапливаться в очереди. Т.к. физический буфер большой, то и логическая очередь получится внушительной. Часть приложений (работающих через ТСР) поздно получат уведомление о том, что часть пакетов не получена и долго будут держать большой размер окна, нагружая сторону-приемник. Это будет происходить в том идеальном случае, когда скорость передачи будет равна или меньше скорости приёма. Но интерфейс принимающей стороны может быть сам загружен и другими пакетами

и тогда маленькая очередь на принимающей стороне не сможет вместить всех пакетов, передаваемых ей из центра. Начнутся потери, которые повлекут за собой дополнительные передачи, но в передающем буфере ведь ещё останется солидный «хвост» ранее накопленных пакетов, которые будут передаваться «вхолостую», т.к. на принимающей стороне не дождались более раннего пакета, а значит более позние будут просто проигнорированы.

Поэтому для корректного решения задачи понижения скорости передачи к медленному соседу физический буфер тоже надо ограничить.

Делается это командой

shape average [speed]

Ну а теперь самое интересное: а как быть, если мне помимо эмуляции физического буфера надо внутри него создать логические очереди? Например, выделить приоритетно голос?

Для это создаётся так называемая вложенная политика, которая применяется внутри основной и делит на логические очереди то, что в неё попадает из родительской.

Пришло время разобрать какой-нибудь залихватский пример на основе приведенной картинки.

Пусть мы собираеися создать устойчиво работающие голосовые каналы через интернет между CO и Remote. Для простоты пусть сеть Remote (172.16.1.0/24) имеет только связь с СО (10.0.0.0/8). Скорость интерфейса на Remote — 1 Мбит/сек и выделяется 25% этой скорости на голосовой трафик.

Тогда для начала нам надо выделить приоритетный класс трафика с обеих сторон и создать политику для данного класса. На СО дополнительно создадим класс, описывающий трафик между офисами

class-map RTP

match protocol rtp

policy-map RTP

class RTP

priority percent 25

ip access-list extended CO_REMOTE

permit ip 10.0.0.0 0.255.255.255 172.16.1.0 0.0.0.255

class-map CO_REMOTE

match access-list CO_REMOTE

На Remote поступим иначе: пусть в силу дохлости железа мы не можем использовать NBAR, тогда нам остаётся только явно описать порты для RTP

ip access-list extended RTP

permit udp 172.16.1.0 0.0.0.255 range 16384 32768 10.0.0.0 0.255.255.255 range 16384 32768

class-map RTP

match access-list RTP

policy-map QoS

class RTP

priority percent 25

Далее, на СО надо сэмулировать медленный интерфейс, применить вложенную политику для приоритезации голосовых пакетов

policy-map QoS

class CO_REMOTE

shape average 1000000

service-policy RTP

и применить политику на интерфейсе

int g0/0

service-policy output QoS

На Remote установим параметр bandwidth (в кбит/сек) в соответствие со скоростью интерфейса. Напомню, что именно от этого параметра будет считаться 25%. И применим политику.

int s0/0

bandwidth 1000

service-policy output QoS

Повествование было бы не полным, если не охватить возможности коммутаторов. Понятно, что чисто L2 коммутаторы не способны так глубоко заглядывать в пакеты и делить их на классы по тем же критериям.

На более умных L2/3 коммутаторах на маршрутизируемых интерфейсах (т.е. либо на interface vlan, либо если порт выведен со второго уровня командой no switchport) применяется та же конструкция, что работает и на маршрутизаторах, а если порт или весь коммутатор работает в режиме L2 (верно для моделей 2950/60), то там для класса трафика можно использовать только указание police, а priority или bandwidth не доступны.

С сугубо защитной точки зрения, знание основ QoS позволит оперативно предотвращать бутылочные горла, вызванные работой червей. Как известно, червь сам по себе довольно агрессивен на фазе распространения и создаёт много паразитного трафика, т.е. по сути атаку отказа в обслуживании (Denial of Service, DoS).

Причем часто червь распространяется по нужным для работы портам (ТСР/135,445,80 и др.) Просто закрыть на маршрутизаторе эти порты было бы опрометчиво, поэтому гуманнее поступать так:

1. Собираем статистику по сетевому трафику. Либо по NetFlow, либо NBARом, либо по SNMP.

2. Выявляем профиль нормального трафика, т.е. по статистике, в среднем, протокол HTTP занимает не больше 70%, ICMP — не больше 5% и т.д. Такой профиль можно либо создать вручную, либо применив накопленную NBARом статистику. Мало того, можно даже автоматически создать классы, политику и применить на интерфейсе

командой autoqos 🙂

3. Далее, можно ограничить для нетипичного сетевого трафика полосу. Если вдруг и подцепим заразу по нестандартному порту, большой беды для шлюза не будет: на загруженном интерфейсе зараза займет не более выделенной части.

4. Создав конструкцию (class-map — policy-map — service-policy) можно оперативно реагировать на появление нетипичного всплеска трафика, создавая вручную для него класс и сильно ограничивая полосу для этого класса.